Downcodes小編獲悉,DeepMind最新研究利用超大規模Transformer模型在西洋棋領域取得突破性進展。研究人員建構了包含千萬級人類對弈棋譜的ChessBench資料集,並訓練了高達2.7億參數的Transformer模型,旨在探索其在複雜規劃問題上的能力。這項研究成果引發了AI社群的廣泛關注,為AI規劃能力的研究提供了新的方向和基準。

最近,DeepMind一篇關於超大規模Transformer 在國際象棋領域應用的論文,引發了AI 社群的廣泛討論。研究人員利用名為ChessBench 的全新資料集,訓練了多達2.7億參數的Transformer 模型,探索其在棋類這種複雜規劃問題上的能力。

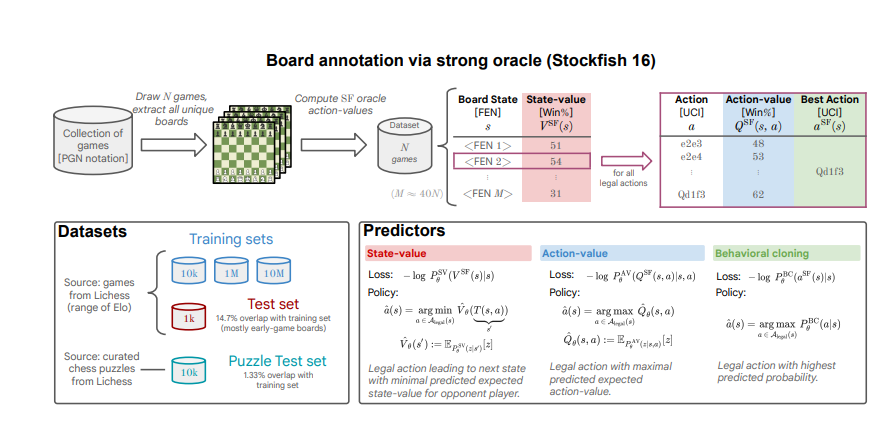

ChessBench 資料集包含從Lichess 平台收集的1000萬局人類對弈棋譜,並使用頂級象棋引擎Stockfish16對棋局進行了標註,提供了多達150億個數據點,包括每個棋局狀態的勝率、最佳走法以及所有合法走法的價值評估。

研究人員使用監督學習方法,訓練Transformer 模型預測給定棋局狀態下每個合法走法的價值。實驗結果表明,即使沒有使用任何明確搜尋演算法,最大規模的模型也能在全新的棋局狀態下做出相當準確的預測,展現出強大的泛化能力。

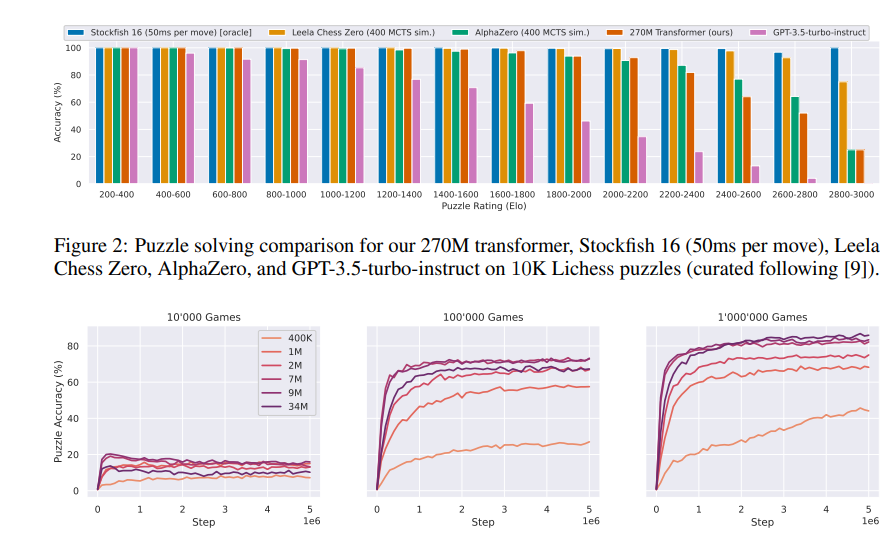

令人驚訝的是,該模型在Lichess 平台上與人類玩家進行快棋對弈時,取得了高達2895的Elo 等級分,達到了國際象棋大師級別。

研究人員也將該模型與Leela Chess Zero 和AlphaZero 等基於強化學習和自我博弈訓練的棋類引擎進行了比較。結果表明,儘管透過監督學習可以將Stockfish 搜尋演算法的近似版本提煉到Transformer 模型中,但要實現完美的提煉仍然存在挑戰。

這項研究表明,超大規模Transformer 模型在解決複雜規劃問題方面具有巨大潛力,也為未來AI 演算法的開發提供了新的想法。 ChessBench 資料集的發布,也將為研究人員探索AI 規劃能力提供一個新的基準平台。

DeepMind的研究成果不僅展現了Transformer模型在西洋棋領域的強大實力,也為未來AI在更複雜領域應用提供了重要的參考價值。 這標誌著AI在複雜策略遊戲領域又向前邁進了一大步,值得持續關注。