日本東京新創公司Rhymes AI發布了其首款人工智慧模型Aria,這是一個開源的多模態混合專家(MoE)模型。 Downcodes小編獲悉,Aria在處理文字、程式碼、圖像和影片等多種輸入方面表現出色,其能力甚至超越了一些知名的商業模式。 Aria採用獨特的MoE架構,透過多個專業專家提高運算效率,並擁有高達249億個參數和64,000個令牌的多模態上下文窗口,使其能夠處理更長的輸入資料。 Rhymes AI也與AMD合作,優化模型效能,並推出了基於AMD硬體的BeaGo搜尋應用程式。

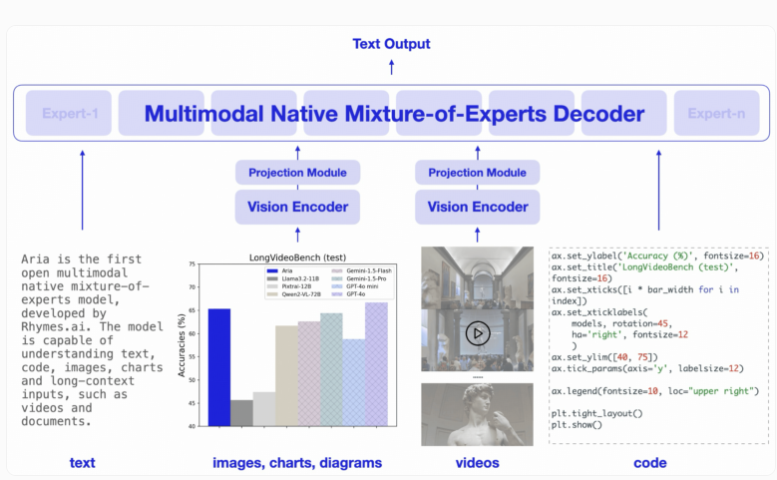

Aria 的設計理念是希望能夠在文字、程式碼、圖像和影片等多種輸入形式上,提供卓越的理解和處理能力。與傳統的Transformer 模式不同,MoE 模式透過多個專業的專家來取代其前饋層。當處理每個輸入令牌時,一個路由模組會選擇一部分專家進行激活,從而提高計算效率,減少每個令牌的激活參數數量。

Aria 的解碼器每個文字令牌可以啟動35億個參數,整個模型擁有249億個參數。為了處理視覺輸入,Aria 還設計了一款輕量級的視覺編碼器,擁有4.38億個參數,可以將各種長度、大小和縱橫比的視覺輸入轉換為視覺令牌。此外,Aria 的多模態上下文視窗達到64,000個令牌,意味著它能處理更長的輸入資料。

在訓練方面,Rhymes AI 共分為四個階段,先用文字資料進行預訓練,再引入多模態數據,接著是長序列的訓練,最後進行微調。

在此過程中,Aria 總共使用了6.4兆個文字代幣和4000億個多模態代幣進行預訓練,資料來自Common Crawl 和LAION 等知名資料集,並進行了部分合成增強。

根據相關基準測試,Aria 在多個多模態、語言和程式設計任務中表現優於Pixtral-12B 和Llama-3.2-11B 等模型,並且因激活參數較少,推理成本也較低。

此外,Aria 在處理帶有字幕的視訊或多頁文件時表現良好,其理解長視訊和文件的能力超過了GPT-4o mini 和Gemini1.5Flash等其他開源模型。

為方便使用,Rhymes AI 將Aria 的原始碼以Apache2.0授權形式發佈在GitHub 上,支援學術和商業使用。同時,他們也提供了一個訓練框架,可以在單一GPU 上對Aria 進行多種資料來源和格式的微調。值得一提的是,Rhymes AI 與AMD 達成了合作,以優化模型性能,展示了一款名為BeaGo 的搜索應用,該應用能夠在AMD 硬體上運行,為用戶提供更全面的文本和圖像AI 搜索結果。

劃重點:

Aria 是全球首個開源的多模態混合專家AI 模型。

Aria 在處理文字、圖像和影片等多種輸入時,表現出色,超越了許多同儕模型。

? Rhymes AI 與AMD 合作,優化模型效能,並推出支援多種功能的BeaGo 搜尋應用程式。

總而言之,Aria 模型的開源和高效能,為人工智慧領域帶來了新的突破,也為開發者和研究者提供了強大的工具。其多模態能力和高效的運算效率,使其在未來應用中擁有巨大的潛力。 Downcodes小編期待Aria在更多領域的應用與發展。