大型語言模型(LLMs)的推理能力是人工智慧領域的研究熱點。蘋果公司AI研究團隊近期發表論文,揭示了LLMs在數學推理上的限制。 Downcodes小編將對論文的主要內容進行解讀,並分析其對AI技術發展的影響。

在人工智慧的世界裡,機器學習模型尤其是大型語言模型(LLMs)的推理能力一直是科學家關注的焦點。

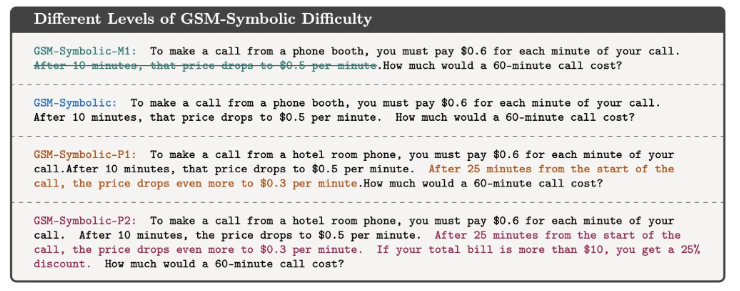

最近,蘋果公司的AI研究團隊發表了一篇論文,題為《理解大型語言模型在數學推理上的限制》,為我們揭示了這些模型在處理邏輯問題時的限制。

論文中,研究者透過一個簡單的數學問題來展示這一點。他們首先提出了一個關於奧利佛摘獼猴桃的問題:

如下圖所示:

奧利佛星期五摘了44顆獼猴桃。星期六他又摘了58顆奇異果。星期天他摘的獼猴桃數量是星期五的兩倍。奧利佛一共有多少顆獼猴桃?

顯然,答案是44+58+ (44*2) =190。雖然大型語言模型在算術方面實際上並不完善,但它們可以相當可靠地解決這樣的問題。

但如果你加入一些無關的訊息,來觀察模型的反應,例如:

奧利佛星期五摘了44顆獼猴桃。星期六他又摘了58顆。星期天他摘的獼猴桃數量是星期五的兩倍,但其中5顆比平均尺寸小一點。奧利佛有多少顆獼猴桃?

儘管這並沒有改變問題的數學本質,但即使是最先進的LLMs也在這個小小的干擾下給出了錯誤的答案。例如,GPT-o1-mini錯誤地從星期日摘的獼猴桃總數中減去了5個小獼猴桃。

這個實驗表明,儘管LLMs在某些情況下能夠給出正確答案,但它們並不真正理解問題的本質。

研究者認為,這些模型的失敗模式表明,它們並沒有進行真正的邏輯推理,而是在複製它們在訓練資料中觀察到的推理步驟。這就像是LLM能夠統計出“我愛你”後面通常會跟著“我也愛你”,但這並不意味著它真正理解了愛的含義。

這篇論文的合著者之一Mehrdad Farajtabar在社群媒體上進一步解釋了這項發現。他指出,儘管透過更好的提示工程可能在一些簡單的情況下提高模型的表現,但對於複雜的干擾,模型可能需要更多的上下文資料來正確處理,而這些幹擾對於一個小孩來說可能根本不是問題。

這項研究提醒我們,儘管LLMs在語言處理方面表現出色,但它們在邏輯推理方面的能力仍然有限。這不僅是一個學術問題,隨著AI技術日益成為我們日常生活的一部分,這些問題的答案變得愈發重要。

我們不能簡單地假設AI能夠理解並執行複雜的任務,而應該更深入地了解它們的工作原理和限制。這項研究為我們提供了對AI技術更深層的理解,同時也為我們如何使用和發展這些技術提供了寶貴的見解。

參考資料:https://techcrunch.com/2024/10/11/researchers-question-ais-reasoning-ability-as-models-stumble-on-math-problems-with-trivial-changes/

總而言之,蘋果團隊的研究強調了大型語言模型在邏輯推理上的局限性,提醒我們需謹慎看待AI的能力,並持續關注其發展方向,避免對其能力的過度依賴。 未來,我們需要更深入地研究如何提升LLMs的推理能力,使其真正理解問題的本質,而非僅僅模仿現有的模式。