OpenAI的研究人員發布了令人矚目的連續時間一致性模型(sCM),該模型在生成多媒體內容的速度方面取得了突破性進展,生成圖像速度比傳統擴散模型快50倍,只需不到0.1秒即可生成一幅影像。這項研究由Lu Cheng和Yang Song共同完成,論文已發表在arXiv.org上,雖然尚未經過同行評審,但其潛在影響巨大,預示著實時生成式AI應用的重大飛躍。 Downcodes小編帶您深入了解sCM模式的創新與未來應用前景。

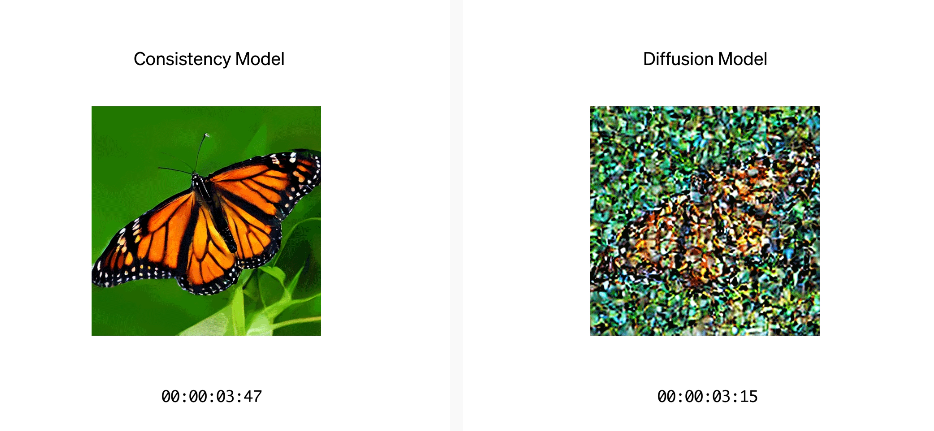

近日,OpenAI 的研究人員發布了一項令人振奮的研究成果,介紹了一種全新的連續時間一致性模型(sCM)。這項模型在產生多媒體內容(如影像、視訊和音訊)的速度上實現了飛躍,相較於傳統的擴散模型,速度提高了整整50倍。具體來說,sCM 能夠在不到0.1秒的時間內產生一幅影像,而傳統擴散模型則往往需要超過5秒。

研究團隊透過這項技術,成功地在僅需兩次採樣步驟的情況下,產生出高品質的樣本。這項創新使得生成過程更有效率,而不會犧牲樣本的品質。文章由OpenAI 的兩位研究人員—Lu Cheng 和Yang Song 共同撰寫,並已在arXiv.org 上發表,雖然尚未經過同行評審,但其潛在影響不容小覷。

Yang Song 在2023年的一篇論文中首次提出了「一致性模型」 的概念,這為sCM 的發展奠定了基礎。儘管擴散模型在產生真實感影像、3D 模型、音訊和視訊方面表現出色,但其取樣效率不高,通常需要數十到數百個步驟,這讓其在即時應用中顯得捉襟見肘。

採樣速度更快

sCM 模型的最大亮點是,它能在不增加計算負擔的情況下,實現更快的採樣速度。 OpenAI 的最大sCM 模型擁有15億個參數,在一塊A100GPU 上,產生樣本的時間僅為0.11秒。與擴散模型相比,這導致掛鐘時間加快了50倍,使即時生成式AI 應用更加可行。

需要更少的運算資源

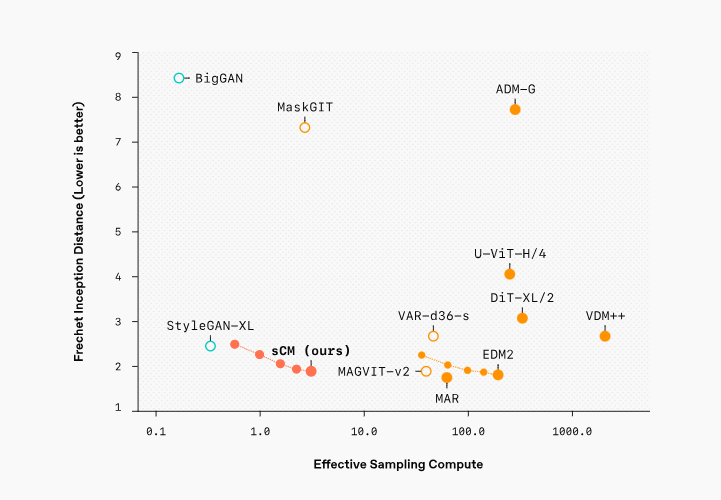

在樣本品質方面,sCM 在ImageNet512×512資料集上經過訓練,達到了1.88的Fréchet Inception Distance(FID)分數,這與頂級擴散模型相差不到10%。透過與其他先進生成模型進行廣泛基準測試,研究團隊證明了sCM 在提供頂尖結果的同時,計算開銷也顯著減少。

未來,sCM 模型的快速取樣和可擴展性將為多個領域的即時生成AI 應用開啟新的可能性。從影像生成到音訊和視訊合成,sCM 都提供了一個實用的解決方案,滿足了對快速、高品質輸出的需求。同時,OpenAI 的研究也暗示了進一步優化系統的潛力,可能會根據不同產業的需求來加速模型的性能。

官方部落格:https://openai.com/index/simplifying-stabilizing-and-scaling-continuous-time-consistency-models/

論文:https://arxiv.org/html/2410.11081v1

sCM模型的出現,標誌著AI影像生成領域取得了重大突破。其高效的採樣速度和高品質的輸出,為即時應用開啟了新的篇章,未來發展潛力無限,值得期待!