香港和中國多所大學與騰訊合作,研發出一款名為GameGen-O的AI模型,用於模擬開放世界電玩遊戲的生成。該模型不僅能夠產生高品質的遊戲內容,還模擬了多種遊戲引擎特性,創造出豐富的遊戲元素,例如動態環境、複雜動作和各種事件,並支援多模態互動控制,提升玩家遊戲體驗。 GameGen-O並非一個完整可玩遊戲,而是為開發者提供一個快速製作原型和測試遊戲元素的工具,大大減少開發時間和成本。本文將詳細介紹GameGen-O的開發流程、功能特性以及未來應用前景。

最近,香港和中國的幾所大學與騰訊聯合研發了一個名為GameGen-O 的AI 模型,專門用於創建開放世界視頻遊戲的模擬。

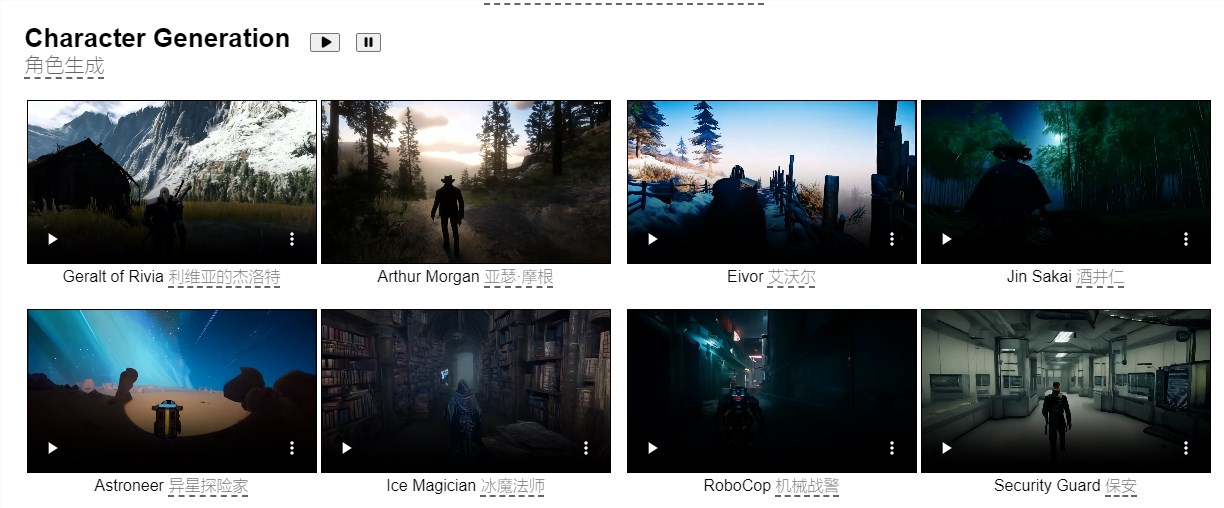

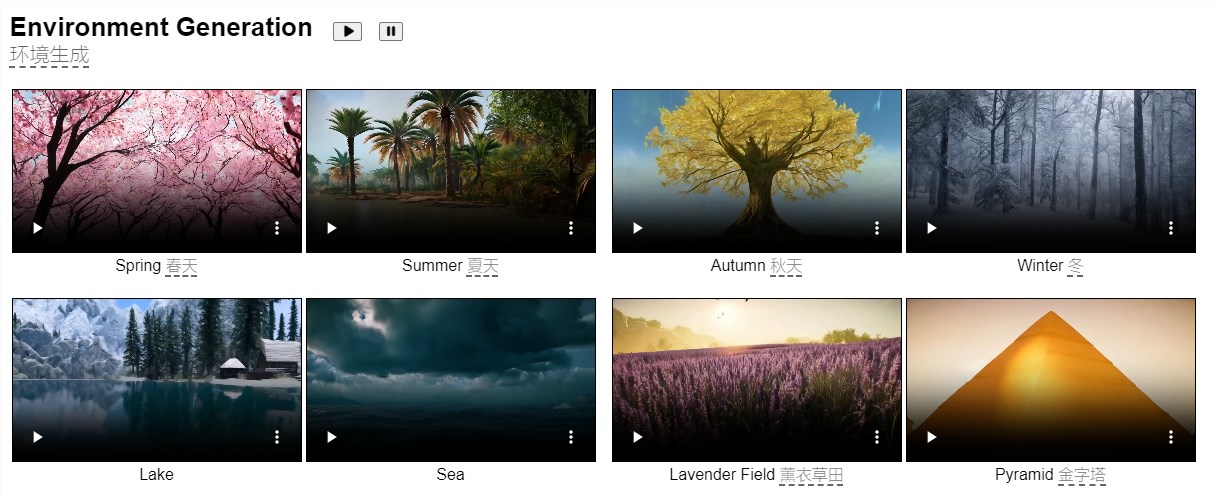

GameGen-O 的功能不僅限於產生高品質的遊戲內容,它還模擬了多種遊戲引擎的特性,能夠創造出豐富多樣的遊戲元素,例如角色動態環境、複雜的動作以及各種事件。

專案入口:https://gamegen-o.github.io/

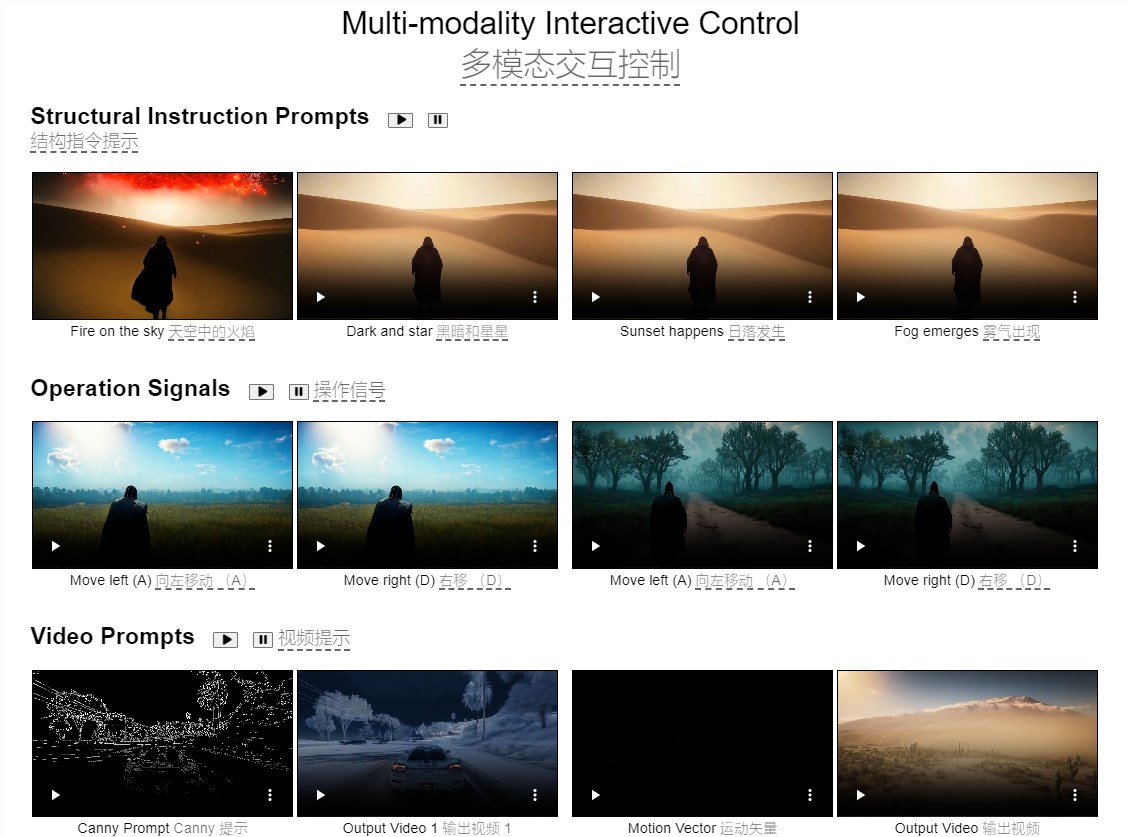

這款模型也提供了多模態互動控制的能力,讓玩家在遊戲過程中能自由地進行操控,帶來前所未有的遊戲體驗。

研究團隊表示,雖然GameGen-O 並不是一個完全可玩遊戲,但它為開發者提供了一個極好的工具,讓他們可以快速製作原型,並測試不同的遊戲元素,省去了從零開始構建的麻煩。

在展示的演示影片中,模型生成的場景中出現了許多著名遊戲的畫面,這可能會引發關於版權的進一步討論。

GameGen-O 的開發是一個從零開始的龐大工程。團隊透過建立一個名為OGameData 的開放世界電玩資料集,這個資料集包含了超過100款現代開放世界遊戲的處理資料。

為了這一目標,他們從網路上收集了32,000個原始視頻,經過專業人士的篩選和處理,最終形成了15,000個可用視頻。影片經過場景偵測後被切分成片段,隨後又經過嚴格的篩選和排序,確保它們在美學、光流和語義內容等方面的高品質。這些片段經過結構化的註釋處理,形成了更為精細且適合訓練的資料集。

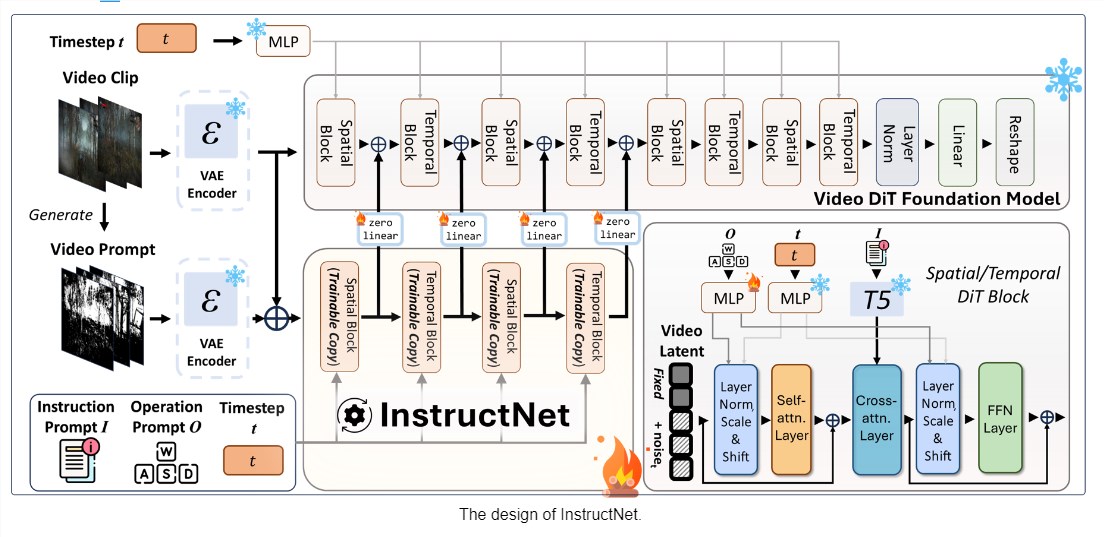

接下來,他們透過兩個階段來訓練這個模型。第一階段,模型學習根據OGameData 產生各種遊戲內容;第二階段,他們增加了一個名為「InstructNet」 的元件,使得使用者可以對生成的內容進行互動控制。

在實際的遊戲生成過程中,GameGen-O 不僅支援角色和環境的生成,還能設計各種動作和事件,讓玩家體驗到生動的遊戲場景。此外,這個模型還能夠根據玩家的輸入和指令靈活調整生成的內容,帶來更個人化的遊戲體驗。

研究人員認為,GameGen-O 在使用AI 生成開放世界視訊遊戲方面邁出了重要的一步,它結合了創意生成和互動能力,並有望成為傳統渲染技術的替代方案。

他們表示,這個模型對於研究者和開發者而言將是一個寶貴的資源,可以探索諸如視頻遊戲AI 開發、互動控制和沈浸式虛擬環境等多種應用。

此外,最近也有其他研究團隊展示了類似的AI 系統,例如Google研究、GoogleDeepMind 和特拉維夫大學共同開發的GameNGen,這個系統能夠即時模擬並播放經典遊戲《DOOM》,並且幀率超過20幀每秒。

劃重點:

GameGen-O 是一個新開發的AI 模型,能夠產生開放世界視訊遊戲的各種元素。

該模型旨在幫助開發者快速製作原型,測試遊戲概念,而不是創建完全可玩的遊戲。

研究團隊透過建立資料集和兩階段訓練,增強了模型的互動控制能力,為遊戲開發帶來新的可能性。

GameGen-O的出現標誌著AI在遊戲開發領域取得了顯著進展,其高效的原型製作能力和互動控制功能,將極大地促進遊戲產業的發展。未來,隨著技術的不斷成熟,GameGen-O及其類似技術有望徹底改變遊戲開發流程,帶來更豐富多彩的遊戲世界。