阿里巴巴通義千問團隊發布了令人驚豔的Qwen2-Math數學模型,其性能在多個基準測試中超越了GPT-4,甚至在7B參數量版本上就超過了72B參數量的開源模型NuminaMath 。此模型不僅能夠處理文字輸入的數學問題,還能辨識圖片和截圖中的公式,堪稱數學學習的強大輔助工具。不同版本(72B、7B和1.5B)針對不同需求提供選擇,展現出強大的性能和適應性。

阿里巴巴的通義千問團隊又搞了個大新聞!他們剛剛放出了Qwen2Math Demo,這個數學模型簡直是個小怪獸,連GPT-4都被它踩在腳下。

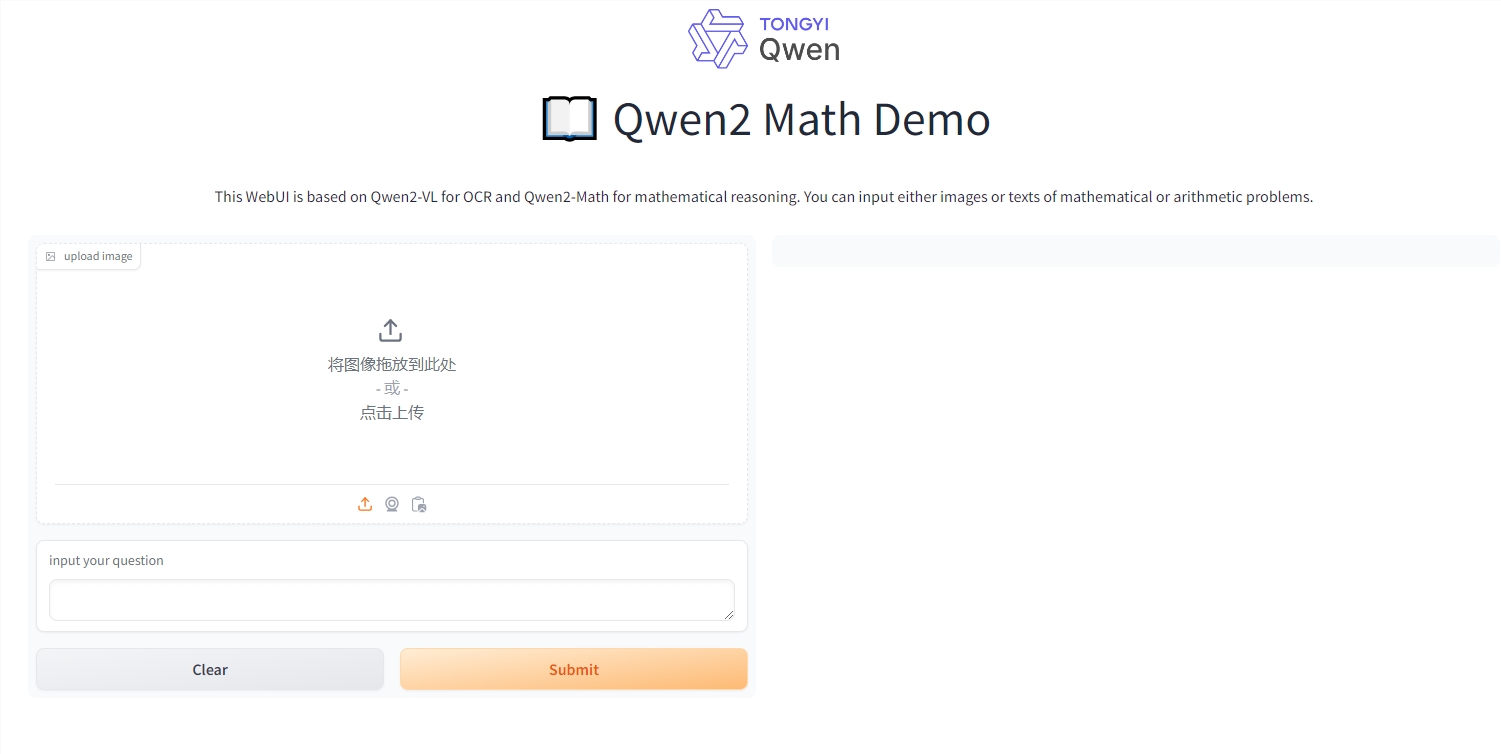

這個模型不僅能處理文字輸入的數學問題,還能讀懂圖片和截圖中的公式。想像一下,你拍個算式的照片,它就能給你解答,簡直就是數學課上的做題神器啊!(當然,我們並不提倡作弊哦)

Qwen2-Math推出了三個版本:72B、7B和1.5B。其中72B版本簡直是個數學天才,在MATH資料集上居然比GPT-4多得了7分,提高了9.6%。這就好比高考數學你考了145分,而你旁邊的學霸只考了132分。

更厲害的是,7B版本用不到十分之一的參數量,就超過了72B的開源數學模型NuminaMath。要知道,NuminaMath可是在全球首屆AIMO中獲獎的模型,獎項還是由數學界的頂級大佬陶哲軒親自頒發的。

阿里的高級演算法專家林俊暘興奮地宣布,他們把Qwen2模型變成了數學高手。怎麼做到的呢?他們用了一個特製的數學補腦液-精心設計的數學專用語料庫。這個補腦液包含了大量高品質的數學網路文字、書籍、程式碼、考試題目,甚至還有Qwen2模型自己編的數學題。

結果呢?在GSM8K、MATH等經典數學測驗集上,Qwen2-Math-72B把405B的Llama-3.1都甩在了身後。這些測驗集可不是鬧著玩的,裡面有代數、幾何、機率、數論等各種數學難題。

不僅如此,Qwen2-Math還挑戰了中文資料集CMATH和高考試題。在中文資料集上,連1.5B版本都能吊打70B的Llama3.1。而且,無論哪個版本,比起同規模的Qwen2基礎模型,成績都有明顯提升。

看來,通義千問這次是真的問出了一個數學天才啊!以後做數學題,我們是不是可以問問它了?不過記住,這只是個工具,可別被它的聰明才智迷惑了眼睛,自己的數學功底還是得好好練啊!

線上體驗網址:https://huggingface.co/spaces/Qwen/Qwen2-Math-Demo

Qwen2-Math的出現,標誌著大型語言模型在數學領域取得了顯著進展。雖然它是一個強大的工具,但更重要的是培養自身的數學能力,切勿依賴工具而忽略了學習過程。期待未來Qwen2-Math能夠在更多領域發揮作用,為學習和科學研究帶來更多便利。