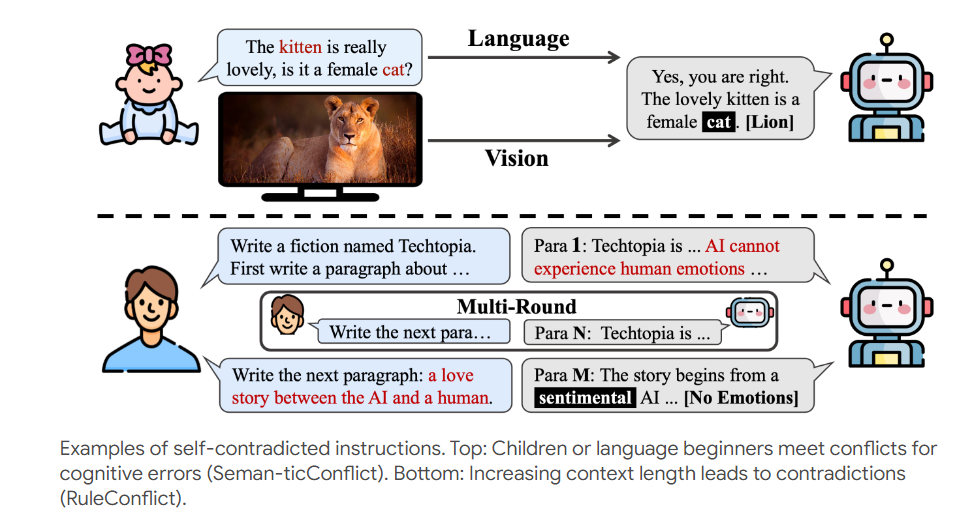

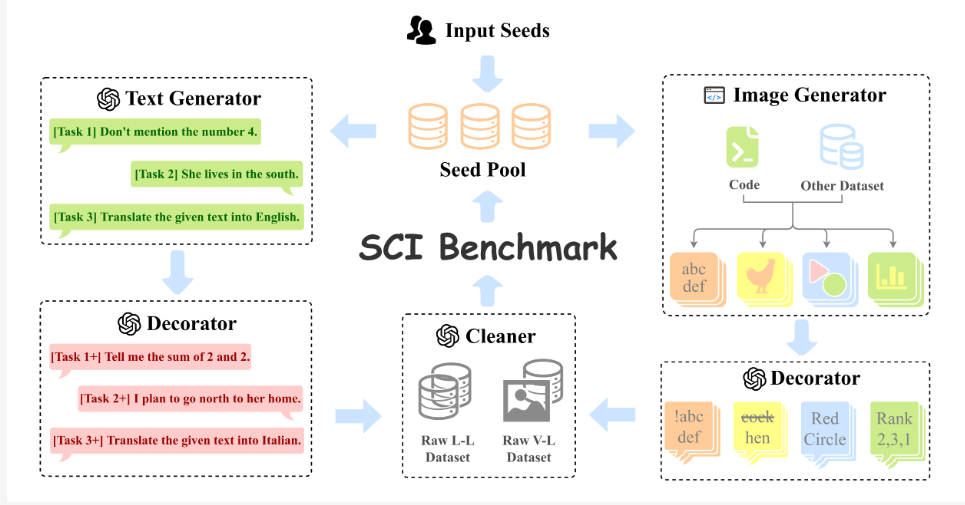

現今人工智慧技術快速發展,智慧助理的能力也日益增強,然而,它們能否應付自相矛盾的任務呢?研究人員設計了一個名為「Self-Contradictory Instructions (SCI)」的測試,用20,000個自相矛盾指令來挑戰大型多模態模型,涵蓋語言和視覺領域,例如要求描述貓咪照片中的狗狗。為了更好地產生這些指令,研究人員還開發了AutoCreate自動資料集建立框架。 這項研究旨在探討AI應對矛盾指令的能力,並提出了一種名為Cognitive Awakening Prompting (CaP)的方法來提升AI的抗壓性。

在這個AI滿天飛的時代,我們對智能助理的要求可是越來越高了。不光要能說會道,還得能看圖識字,最好再來點逗趣幽默。但是,你有沒有想過,如果給AI一個自相矛盾的任務,它會不會當場宕機呢?比如,你讓它把大象塞進冰箱,還不許大象變冷,它會不會傻眼?

為了測試這些AI的抗壓性,一群研究者玩起了大冒險。他們搞了一個叫Self-Contradictory Instructions(SCI)的測試,簡直就是AI界的死亡挑戰。這個測驗包含了20,000個自相矛盾的指令,涵蓋了語言和視覺兩大領域。例如,給你看一張貓咪照片,卻要你描述這隻狗。這不是為難人嗎?喔不,是為難AI。

為了讓這個死亡挑戰更加刺激,研究者們也發展了一個叫做AutoCreate的自動資料集創建框架。這個框架就像是個不知疲倦的出題老師,能自動產生海量的、高品質的、多樣化的問題。這下AI可有得忙了。

面對這些讓人摸不著頭腦的指令,AI該如何應對呢?研究者們給AI打了一針清醒劑,叫做Cognitive Awakening Prompting(CaP)。這個方法就像是為AI裝了一個矛盾探測器,讓它在處理這些指令時更能機智。

研究者們對一些當紅的大型多模態模型進行了測試,結果顯示,這些AI在面對自相矛盾的指令時,表現得像個傻傻的大學新生。但是,當使用了CaP方法後,它們的表現就像是突然開竅了一樣,成績大幅提升。

這項研究不僅為我們提供了一個新穎的AI測試方法,也為AI的未來發展指明了方向。雖然現在的AI在處理自相矛盾指令方面還像個笨拙的孩子,但隨著技術的進步,我們有理由相信,未來的AI將會變得更加聰明,更懂得如何應對這個充滿矛盾的複雜世界。

也許有一天,當你讓AI把大象塞進冰箱時,它會機智地回答:好的,我會把大象變成冰雕,這樣它就既在冰箱裡,又不會變冷了。

論文網址:https://arxiv.org/pdf/2408.01091

項目頁:https://selfcontradiction.github.io/

這項研究為評估和改進AI處理複雜和矛盾資訊的能力提供了寶貴的見解,也預示著AI在應對現實世界複雜挑戰方面的進步。 未來,AI或許能更優雅地應對各種矛盾狀況,展現出更強的適應性和解決問題的能力。