Meta執行長馬克·祖克柏在SIGGRAPH大會上發布了Segment Anything 2 (SA2),這是其影像分割模型的重大升級,將AI驅動的分割技術拓展至視訊領域。 SA2的開源策略,正如祖克柏所言,旨在建立一個圍繞該技術的強大生態系統,從而提升模型本身以及Meta其他產品的品質。這體現了Meta在開放AI領域的持續投入和對產業發展的貢獻。

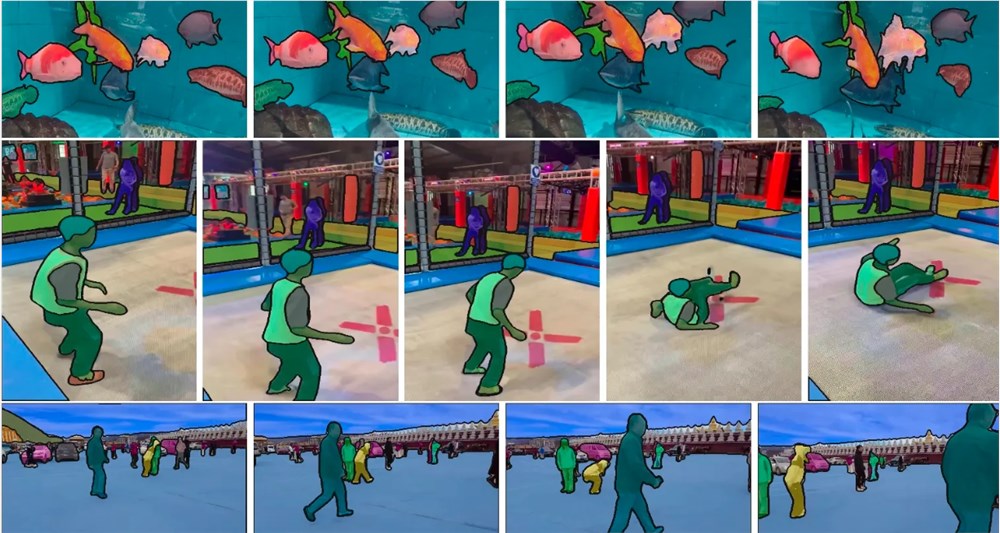

在本週舉行的SIGGRAPH大會上,Meta執行長馬克·祖克柏首次展示了Segment Anything2(SA2),這是該公司去年推出的突破性圖像分割模型的升級版本。新模型將AI驅動的分割技術擴展到了視訊領域,展示了該技術在過去一年中取得的驚人進展。

祖克柏在談話中解釋了Meta堅持開源策略的原因:這不僅僅是一個你可以建立的軟體——你需要一個圍繞它的生態系統。如果我們不開源它,它幾乎就不會那麼好用。他坦言,這項策略不僅有利於整個生態系統,也有助於提升Meta自身產品的品質。

SA2的發布再次彰顯了Meta在開放AI領域的領導地位。儘管其開放性程度仍有爭議,但像LLaMa、Segment Anything等模型已成為AI性能的重要參考標準。

隨著SA2的推出,AI視訊分析技術將在科學研究、環境監測等許多領域發揮更大作用。這項進展不僅展示了AI技術的快速發展,也為未來的應用開啟了新的可能性。

SA2的發布標誌著AI視訊分析技術的新里程碑,其開源策略也為AI社群的共同發展提供了有力支持。未來,我們可以期待SA2在更多領域展現其強大的應用潛力,推動人工智慧技術的持續進步。