Meta科學家Thomas Scialom在Latent Space播客中詳細解讀了Llama 3.1的研發過程,並預告了Llama 4的研發方向。 Llama 3.1並非簡單的參數堆砌,而是參數規模、訓練時間和硬體限制的權衡結果,其405B參數規模是對GPT-4o的回應。雖然龐大的模型體積使其難以在普通電腦上運行,但開源的特性使得更多人能夠參與其中,推動技術發展。

Llama3.1的誕生,是參數規模、訓練時間與硬體限制的完美平衡。 405B的龐大身軀,不是隨意的選擇,而是Meta向GPT-4o發起的挑戰書。儘管硬體的限制讓Llama3.1無法在每個家庭的電腦上起舞,但開源社群的力量讓一切變得可能。

在Llama3.1的研發過程中,Scialom和他的團隊重新審視了Scaling Law。他們發現,模型規模的確是關鍵,但更重要的是訓練資料的總量。 Llama3.1選擇了增加訓練的token數,即使這意味著要付出更多的算力。

Llama3.1在架構上並沒有翻天覆地的變化,但在資料的規模和品質上,Meta下足了功夫。 15T的token海洋,讓Llama3.1在知識的深度與廣度上都有了質的飛躍。

在數據的選擇上,Scialom堅信公開網路上的文字垃圾太多,真正的黃金是合成數據。 Llama3.1的後訓練過程中,完全沒有使用人工書寫的答案,而是完全依賴Llama2產生的合成資料。

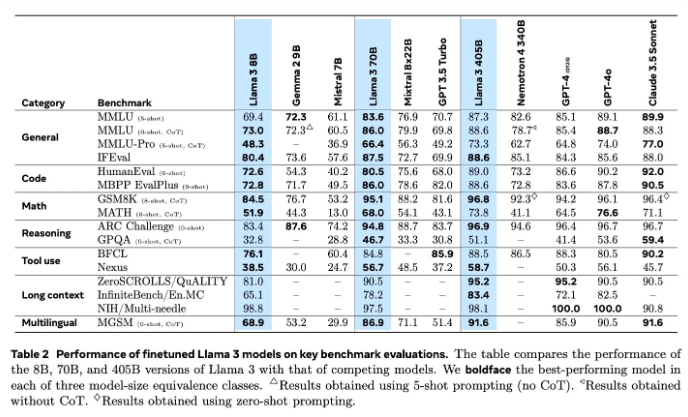

模型評估一直是AI領域的難題。 Llama3.1在評估與改進上,嘗試了多種方法,包括獎勵模型和多樣化的基準測試。但真正的挑戰在於,如何找到能夠擊敗強大模型的合適prompt。

Meta已經在6月開啟了Llama4的訓練,而這次,他們將重點放在了agent技術上。 Toolformer等agent工具的開發,預示著Meta在AI領域的新探索。

Llama3.1的開源,不僅是Meta的一次大膽嘗試,更是對AI未來的一次深刻思考。隨著Llama4的啟動,我們有理由相信,Meta將在AI的道路上,繼續領先。讓我們一起期待,Llama4和agent技術將如何重新定義AI的未來。

透過對Llama 3.1研發過程的深入了解,我們可以看到Meta在大型語言模式領域的持續創新與努力,以及對開源社群的重視。 Llama 4的研發方向也預示著未來AI技術發展的趨勢,值得我們拭目以待。未來AI技術將如何發展,讓我們共同期待。