如果讓AI用自己生成的圖像進行再訓練,結果會怎樣?最近,史丹佛大學和加州大學柏克萊分校的研究人員們就做了這樣一個實驗,結果讓人大跌眼鏡。

研究人員發現,當AI圖像生成模型被重新訓練,使用它們自己生成的圖像時,這些模型會產生高度扭曲的圖像。更糟糕的是,這種扭曲不僅限於用於再訓練的文本提示,一旦模型被“污染”,即使之後只用真實圖像進行再訓練,模型也很難完全恢復。

實驗的起點是一個名為Stable Diffusion(SD)的開源模型。研究人員首先從FFHQ人臉資料集中選取了70,000張高品質的人臉影像,並自動分類。然後,他們使用這些真實圖像作為輸入,透過Stable Diffusion模型生成了900張與特定人群特徵一致的圖像。

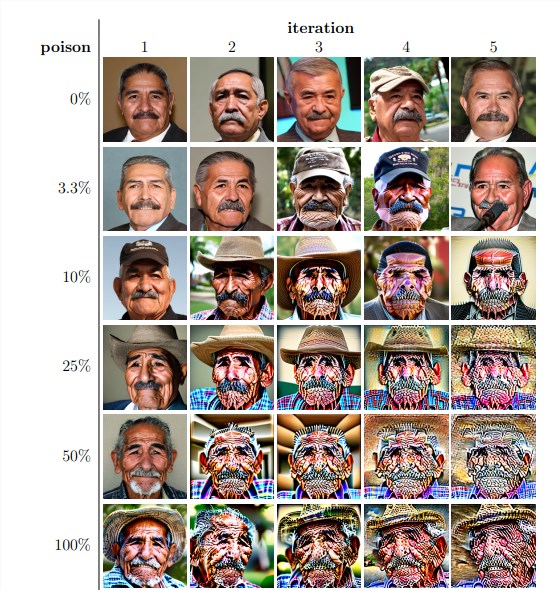

接下來,研究人員將這些生成的圖像用於模型的迭代再訓練。他們發現,不管再訓練資料集中自生成影像的比例如何,模型最終都會崩潰,生成的影像品質急劇下降。即使在再訓練資料中只包含3%自生成影像的情況下,模型崩潰的現象依然存在。

實驗結果顯示,基線版本的Stable Diffusion模型產生的影像與文字提示一致,且視覺品質高。但當模型經過迭代再訓練後,生成的影像開始出現語意上的不一致和視覺扭曲。研究人員還發現,模型崩潰不僅影響影像質量,還導致生成的影像缺乏多樣性。

為了驗證這一點,研究人員還進行了控制實驗,嘗試透過調整生成影像的顏色直方圖和移除低品質影像來減輕模型崩潰的影響。但結果表明,這些措施並不能有效阻止模型崩潰。

研究人員們也探討了模型在被「污染」後是否有可能透過再訓練恢復。他們發現,儘管在某些情況下,經過多次迭代再訓練後,生成的影像品質有所恢復,但模型崩潰的跡象仍然存在。這表明,一旦模型被“污染”,其影響可能是長期的,甚至是不可逆的。

這項研究揭示了一個重要的問題:當前流行的基於擴散的文本到圖像生成AI系統對數據「污染」非常敏感。這種「污染」可能無意中發生,例如透過不加選擇地從線上資源抓取圖像。也可能是有針對性的攻擊,例如故意在網站上放置被「污染」的資料。

面對這些挑戰,研究人員提出了一些可能的解決方案,例如使用影像真實性偵測器來排除AI生成的影像,或在生成的影像中加入浮水印。這些方法雖然不完美,但結合起來可能會顯著降低資料「污染」的風險。

這項研究提醒我們,AI技術的發展並非沒有風險。我們需要更加謹慎地處理AI產生的內容,確保它們不會對我們的模型和資料集造成長期的負面影響。未來的研究需要進一步探索如何使AI系統對這種類型的數據「污染」更具韌性,或者開發出能夠加速模型「治癒」的技術。