艾倫人工智慧研究所(AI2)最新發布的Tülu3系列模型,為開源語言模型領域帶來了令人矚目的突破。 Tülu3不僅在性能上與GPT-4o-mini等閉源模型不相上下,更重要的是,它完全開源,並提供了全面的訓練數據、程式碼、訓練配方和評估框架,這對於推動開源模型後訓練技術的發展具有里程碑式的意義。它解決了傳統預訓練模型在實際應用中存在的許多問題,如產生有害資訊、難以遵循指令等,為人工智慧領域的研究和應用帶來了新的可能性。

在人工智慧領域,後訓練技術正逐漸成為提升模型效能的重要手段。近日,艾倫人工智慧研究所(AI2)發布了Tülu3系列模型,這是一套完全開源的先進語言模型,性能與GPT-4o-mini 等閉源相媲美。 Tülu3不僅包含了模型資料、程式碼、訓練配方,還提供了評估框架,旨在推動開源模型後訓練技術的發展。

傳統上,僅經過預先訓練的模型往往無法有效滿足實際應用需求,可能會產生有毒或危險的訊息,且難以遵循人類指令。因此,後訓練階段如指令微調和人類回饋學習顯得格外重要。然而,如何優化後訓練過程仍然是一個技術難題,尤其是在提升模型某一能力的同時,可能會影響其他能力。

為了攻克這個難題,各大公司紛紛提升了後訓練方法的複雜性,嘗試多輪訓練和結合人工與合成數據,但大部分方法仍為閉源。與之形成對比的是,Tülu3系列的發布,突破了開源模型和閉源模型之間的性能差距,帶來了全新的訓練思維。

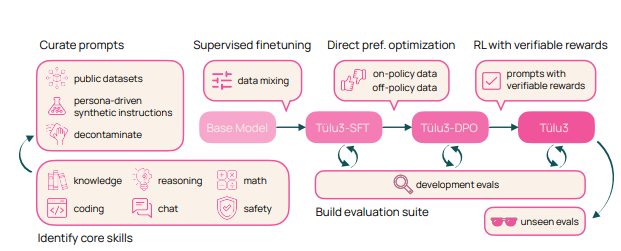

Tülu3的訓練過程分為四個階段:資料建構、監督微調、偏好調整、可驗證獎勵的強化學習。

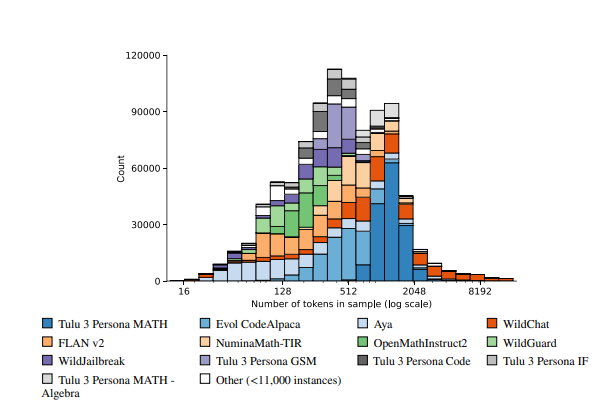

首先,研究者聚焦於模型的核心技能,透過人工資料與合成資料的結合來建構訓練資料。

其次,進行監督式微調,以確保模型在特定技能上的表現不遜於其他先進模型。

第三,採用直接偏好最佳化的方法來進一步提升模型的整體表現。最後,創新引入可驗證獎勵強化學習的方法,幫助模型更好地完成可驗證結果的任務。

Tülu3模型基於Llama3.1的基礎上進行構建,在推理、數學、編程和指令遵循等領域表現優異。與其他開源和閉源模型相比,Tülu3的綜合能力在多個基準測試中表現出色,標誌著開源後訓練技術的重大進步。

論文連結:https://allenai.org/papers/tulu-3-report.pdf

Demo:https://playground.allenai.org/

劃重點:

? Tülu3是AI2推出的開源語言模型,與閉源模型如GPT-4o-mini 效能相當。

? 後訓練技術至關重要,能夠有效提升模型在實際應用中的表現。

? Tülu3的訓練過程創新,分為資料建構、監督微調、偏好調整、可驗證獎勵強化學習四個階段。

Tülu3的開源特性使得研究者可以深入研究其訓練方法,並在此基礎上進行改進和創新,這將極大地推動開源語言模型的發展。其在多個領域的優異表現也預示著開源模型在未來將扮演更重要的角色。 期待Tülu3能進一步促進人工智慧技術的普及與應用。