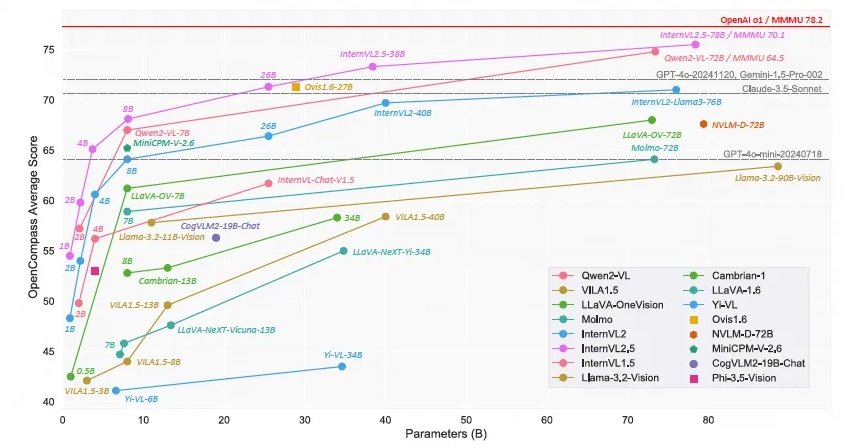

上海AI 實驗室重磅推出開源多模態大型語言模型-書生·萬象InternVL2.5,其效能在多模態理解基準(MMMU)上達到70%以上的準確率,與GPT-4o和Claude- 3.5-Sonnet等商業模型表現相當。 InternVL2.5模型透過鍊式思考推理技術,在多項基準測試中展現出強大的性能,尤其在多學科推理、文檔理解和多模態幻覺檢測等方面表現出色。此模型的開源性質將極大推動多模態AI技術的發展與創新。

近日,上海AI 實驗室宣布推出書生·萬象InternVL2.5模型。這款開源多模態大型語言模型以其卓越的效能,成為首個在多模態理解基準(MMMU)上超過70%準確率的開源模型,與商業模型如GPT-4o和Claude-3.5-Sonnet等的性能相媲美。

InternVL2.5模型透過鍊式思考(CoT)推理技術實現了3.7個百分點的提升,展現了強大的測試時間可擴展性潛力。該模型基於InternVL2.0進一步發展,透過增強訓練和測試策略以及提高資料品質來進一步提升效能。在視覺編碼器、語言模型、資料集大小和測試時間配置等方面進行了深入研究,以探索模型規模與表現之間的關係。

InternVL2.5在多項基準測試中展現了競爭性的性能,特別是在多學科推理、文檔理解、多圖像/視頻理解、現實世界理解、多模態幻覺檢測、視覺地面化、多語言能力以及純語言處理等領域。這項成果不僅為開放原始碼社群提供了一個新標準,用於開發和應用多模態AI系統,也為人工智慧領域的研究和應用開闢了新的可能性。

InternVL2.5保留了其前身InternVL1.5和InternVL2.0的相同模型架構,遵循「ViT-MLP-LLM」範式,並實現了將新的增量預訓練的InternViT-6B或InternViT-300M與各種不同大小和類型的預先訓練的LLMs整合在一起,使用隨機初始化的兩層MLP投影機。為了增強高解析度處理的可擴展性,研究團隊應用了一個像素無序操作,將視覺代幣的數量減少到原始數量的一半。

模型的開源性質意味著研究人員和開發者可以自由存取和使用InternVL2.5,這將極大促進多模態AI技術的發展和創新。

模型連結:

https://www.modelscope.cn/collections/InternVL-25-fbde6e47302942

InternVL2.5的開源發布,為多模態AI研究提供了寶貴資源,其優異性能和可擴展性有望推動該領域取得進一步突破,促進更多創新應用的誕生。 期待未來看到基於InternVL2.5的更多令人驚喜的成果。