近日,Google深度學習團隊聯合多所大學的研究人員發布了名為「MegaSaM」的新系統,該系統能夠有效地從動態視訊中估計相機參數和深度圖。這標誌著電腦視覺領域的一項重大突破,有望革新視訊處理技術,並在許多領域帶來廣泛應用。傳統方法在處理動態場景時存在許多局限性,而MegaSaM的出現有效解決了這些問題,為動態視訊分析提供了全新的解決方案。

近日,Google深度學習團隊和多所大學的研究人員聯合發布了一項名為「MegaSaM」 的新系統,該系統能夠從普通的動態影片中快速、準確地估計相機參數和深度圖。這項技術的問世,將為我們在日常生活中錄製的影片帶來更多的可能性,特別是在動態場景的捕捉與分析方面。

傳統的運動結構重建(Structure from Motion,SfM)和單目同步定位與地圖構建(SLAM)技術,通常需要輸入靜態場景的視頻,並且對視差的要求較高。面對動態場景,這些方法的表現往往不盡人意,因為在缺乏靜態背景的情況下,演算法容易出現錯誤。儘管近年來一些基於神經網路的方法試圖解決這一問題,但這些方法往往計算開銷巨大,且在動態視訊中,尤其是當攝影機運動不受控製或視野未知時,穩定性欠佳。

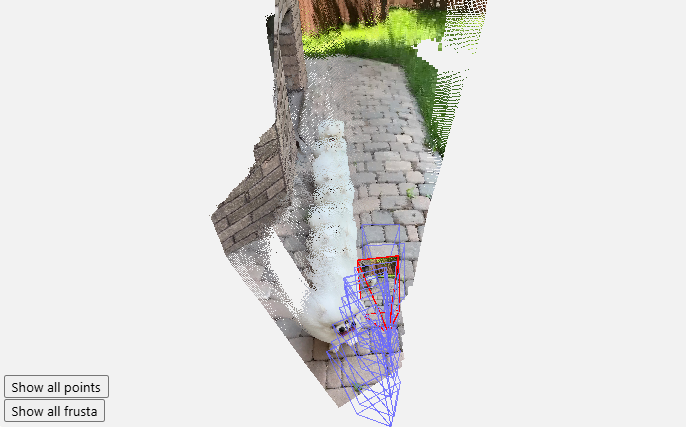

MegaSaM 的出現,改變了這個局面。研究團隊透過對深度視覺SLAM 框架進行精心的修改,使其能夠適應複雜的動態場景,尤其是在攝影機路徑不受限制的情況下。經過一系列的實驗,研究人員發現MegaSaM 在相機姿態和深度估計方面,顯著優於以往的相關技術,並且在運行時間上也表現出色,甚至可以與某些方法相媲美。

該系統的強大功能,使其能夠處理幾乎任何視頻,包括那些在拍攝過程中可能存在劇烈運動或場景動態的隨意錄像。 MegaSaM 在約0.7幀每秒的速度下,處理來源視訊的結果,展現出其卓越的效能。研究團隊還在他們的畫廊中展示了更多處理結果,以證明其在實際應用中的有效性。

這項研究成果不僅為電腦視覺領域帶來了新鮮血液,也為廣大用戶在日常生活中的視訊處理提供了新的可能性,期待未來能夠在更多場景中看到MegaSaM 的身影。

專案入口:https://mega-sam.github.io/#demo

劃重點:

MegaSaM 系統能夠從普通動態影片中快速、準確地估計相機參數和深度圖。

該技術克服了傳統方法在動態場景中的不足,並適應複雜環境的即時處理。

實驗結果顯示,MegaSaM 在準確度和運作效率上均優於以往技術。

MegaSaM系統的出現,為動態視訊處理帶來了革命性的變化,其高效精準的性能為未來更多應用場景提供了可能性。相信隨著科技的不斷發展和完善,MegaSaM將在更多領域發揮重要作用,為人們的生活帶來更多便利。