哈佛大學、史丹佛大學等頂尖機構聯合研究顯示,OpenAI的o1-preview模型在醫學推理任務中展現出驚人的能力,甚至超越了人類醫師。該研究對o1-preview模型進行了全面評估,涵蓋鑑別診斷生成、診斷推理過程展示、分流鑑別診斷、機率推理和管理推理等多個方面,並與人類醫生和早期大型語言模型進行了對比。研究結果令人矚目,為人工智慧在醫療領域的應用帶來了新的突破,同時也為未來醫學人工智慧的發展方向指明了道路。

人工智慧在醫療領域的應用再次迎來重大突破!一項由哈佛大學、史丹佛大學等多所頂尖機構聯合開展的研究顯示,OpenAI 的o1-preview 模型在多項醫學推理任務中表現出驚人的能力,甚至超越了人類醫生。這項研究不僅評估了該模型在醫學多項選擇題基準測試中的表現,更著重考察了其在模擬真實臨床場景下的診斷和管理能力,結果令人矚目。

研究人員透過五個實驗,對o1-preview 模型進行了全面評估,包括鑑別診斷生成、展示診斷推理過程、分診鑑別診斷、機率推理和管理推理。這些實驗均由醫學專家使用已驗證的心理測量方法進行評估,旨在將o1-preview 的表現與先前人類對照組和早期大型語言模型基準進行對比。結果顯示,o1-preview 在鑑別診斷產生以及診斷和管理推理的品質方面取得了顯著進步。

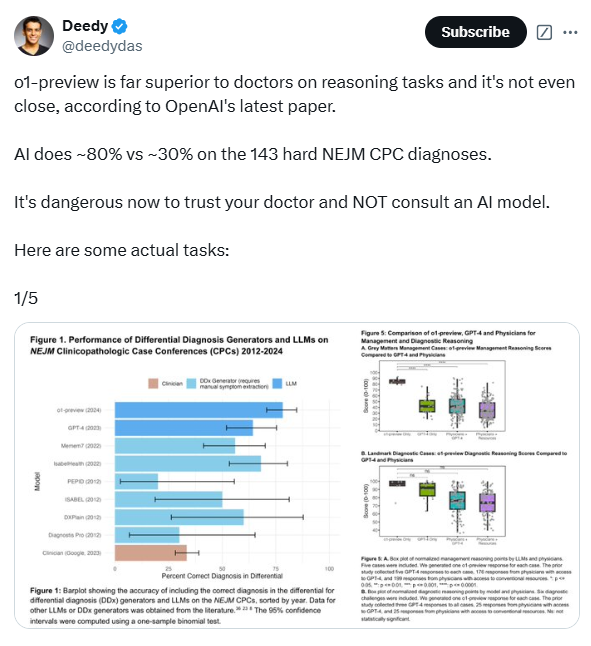

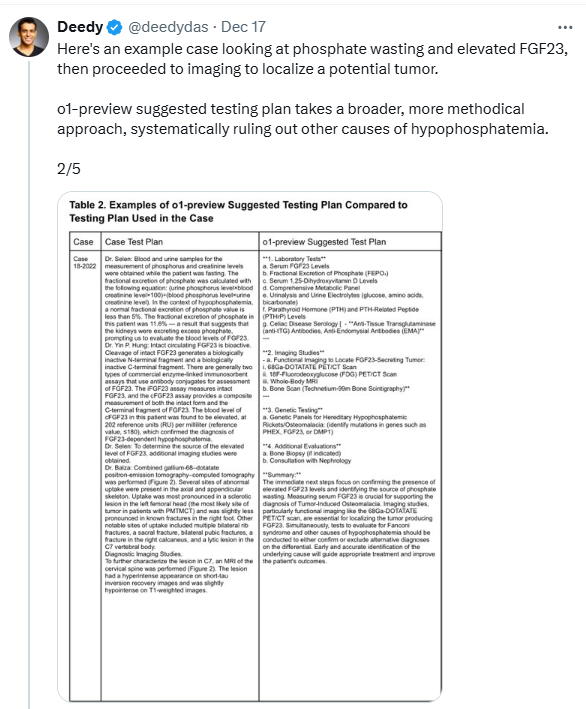

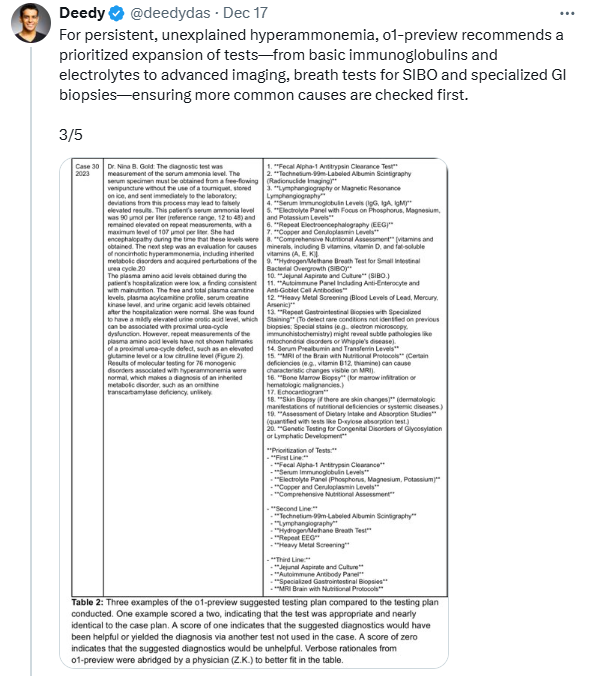

在評估o1-preview 產生鑑別診斷的能力時,研究人員使用了《新英格蘭醫學雜誌》(NEJM)發布的臨床病理討論會(CPC)病例。結果顯示,該模型在78.3% 的病例中給出的鑑別診斷包含了正確診斷,在52% 的病例中,首個診斷即為正確診斷。更驚人的是,o1-preview 在88.6% 的病例中給出了準確或非常接近的診斷,而先前的GPT-4模型在相同病例中的比例為72.9%。此外,o1-preview 在選擇下一步診斷測試方面也表現出色,在87.5% 的病例中選擇了正確的測試,11% 的病例中選擇的測試方案被認為是有幫助的。

為了進一步評估o1-preview 的臨床推理能力,研究人員使用了NEJM Healer 課程中的20個臨床案例。結果顯示,o1-preview 在這些病例中的表現明顯優於GPT-4、主治醫師和住院醫師,在78/80的案例中獲得了完美的R-IDEA 評分。 R-IDEA 評分是用來評估臨床推理記錄品質的10分量表。此外,研究人員還透過「Grey Matters」 管理案例和「Landmark」 診斷案例評估了o1-preview 的管理和診斷推理能力。在「Grey Matters」 案例中,o1-preview 的得分顯著高於GPT-4、使用GPT-4的醫生和使用傳統資源的醫生。在「Landmark」 案例中,o1-preview 的表現與GPT-4相當,但優於使用GPT-4或傳統資源的醫師。

然而,研究也發現o1-preview 在機率推理方面的表現與先前的模型相似,並未有明顯改進。在某些情況下,該模型在預測疾病機率時不如人類。研究人員還指出,o1-preview 的一個限制是傾向於冗長,這可能在一定程度上提高了其在某些實驗中的得分。此外,該研究主要關注模型性能,而未涉及人機交互,因此未來需要進一步研究o1-preview 如何增強人機交互,以開發更有效的臨床決策支援工具。

儘管如此,這項研究仍表明,o1-preview 在需要複雜批判性思維的任務(如診斷和管理)中表現出色。研究人員強調,醫學領域的診斷推理基準正在迅速飽和,因此需要開發更具挑戰性和現實性的評估方法。他們呼籲在真實臨床環境中對這些技術進行試驗,並為臨床醫生與人工智慧的協作創新做好準備。此外,還需建立健全的監督框架,以監控人工智慧臨床決策支援系統的廣泛實施。

論文網址:https://www.arxiv.org/pdf/2412.10849

總而言之,這項研究為人工智慧在醫療領域的應用提供了強而有力的證據,也指出了未來研究的方向。 o1-preview 模型的出色表現令人振奮,但同時也需要謹慎地考慮其局限性,並確保其在臨床應用中的安全性和可靠性。 未來,人機協作將成為醫療領域的重要趨勢。