VideoLLaMA2是一個先進的多模態語言模型,專注於提升視訊理解能力,特別是時空建模和音訊理解。它能夠快速識別視頻內容並產生字幕,例如,對一段31秒的視頻,僅需19秒即可完成識別並生成字幕。該計畫旨在推動視訊大語言模型技術發展,為用戶提供更便利、更深入的視訊內容理解體驗。本文將詳細介紹VideoLLaMA2的功能、應用場景以及試玩入口。

隨著人工智慧技術的發展,視訊理解變得越來越重要。在這個背景下,VideoLLaMA2計畫應運生,旨在推進視訊大語言模型時空建模和音訊理解能力。這個項目是一個高級多模態語言模型,可以幫助使用者更好地理解影片內容。在測試中,VideoLLaMA2對影片內容的辨識速度非常快,例如一段31秒的影片只需要19秒就能辨識完,並產生字幕內容。下面的影片中的字幕部分,就是VideoLLaMA2根據指令對影片的理解。

影片字幕中的大意:這段影片捕捉了一個充滿活力和異想天開的場景,微型海盜船在洶湧的咖啡泡沫中航行。這些設計複雜的船隻,揚起的帆和飄揚的旗幟,似乎正在進行一場穿越泡沫海洋的冒險之旅。船上有詳細的索具和桅杆,增加了現場的真實性。整個奇觀是一個有趣的和富有想像力的海上冒險的描繪,一切都在一杯咖啡的範圍內。

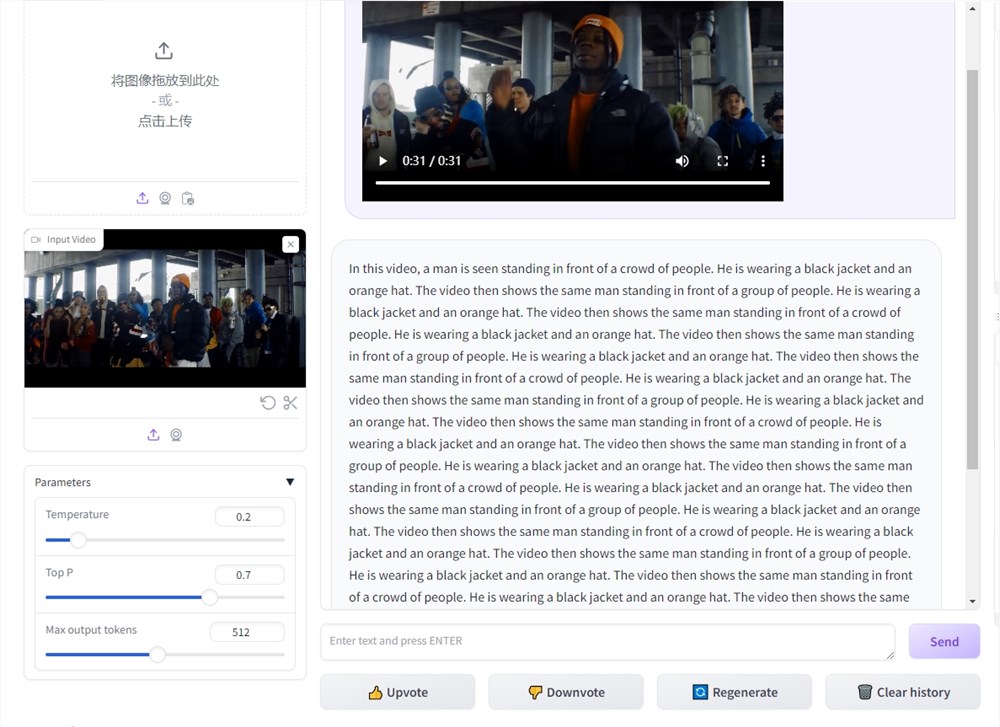

目前,VideoLLaMA2官方已經放出了試玩入口,體驗如下截圖:

VideoLLaMA2計畫入口:https://top.aibase.com/tool/videollama-2

試玩網址:https://huggingface.co/spaces/lixin4ever/VideoLLaMA2

VideoLLaMA2功能:

1. 時空建模: VideoLLaMA2可以進行精確的時空建模,辨識影片中的動作和事件順序。透過對影片內容進行建模,可以更深入地理解影片故事。

時空建模是指模型可以準確地捕捉影片中的時間和空間訊息,從而推斷影片中發生的事件和動作的先後順序。這種功能使得影片內容的理解更加精準細緻。

2. 音訊理解: VideoLLaMA2也具備出色的音訊理解能力,可以辨識和分析視訊中的聲音內容。這使得用戶可以更全面地理解影片內容,不僅限於視覺訊息。

音訊理解是指模型可以辨識和分析影片中的聲音,包括語音對話、音樂等內容。透過音訊理解,使用者可以更了解視訊背景音樂、對話內容等,從而更全面地理解影片。

VideoLLaMA2應用場景:

基於上面的能力,VideoLLaMA2應用場景,例如可以用於即時的高光時刻生成、即時的直播內容理解和總結等等。可總結如下:

視訊理解研究:在學術領域,VideoLLaMA2可以用於視訊理解研究,幫助研究人員分析視訊內容、探索視訊故事背後的資訊。

媒體內容分析:媒體產業可以利用VideoLLaMA2進行影片內容分析,以便更了解使用者需求、優化內容推薦等。

教育與訓練:在教育領域,VideoLLaMA2可以用來製作教學影片、輔助教學內容理解,提升學習效果。

總而言之,VideoLLaMA2憑藉其強大的時空建模和音訊理解能力,在視訊內容理解領域展現出巨大的潛力,未來應用前景廣闊,值得期待其進一步發展和應用。