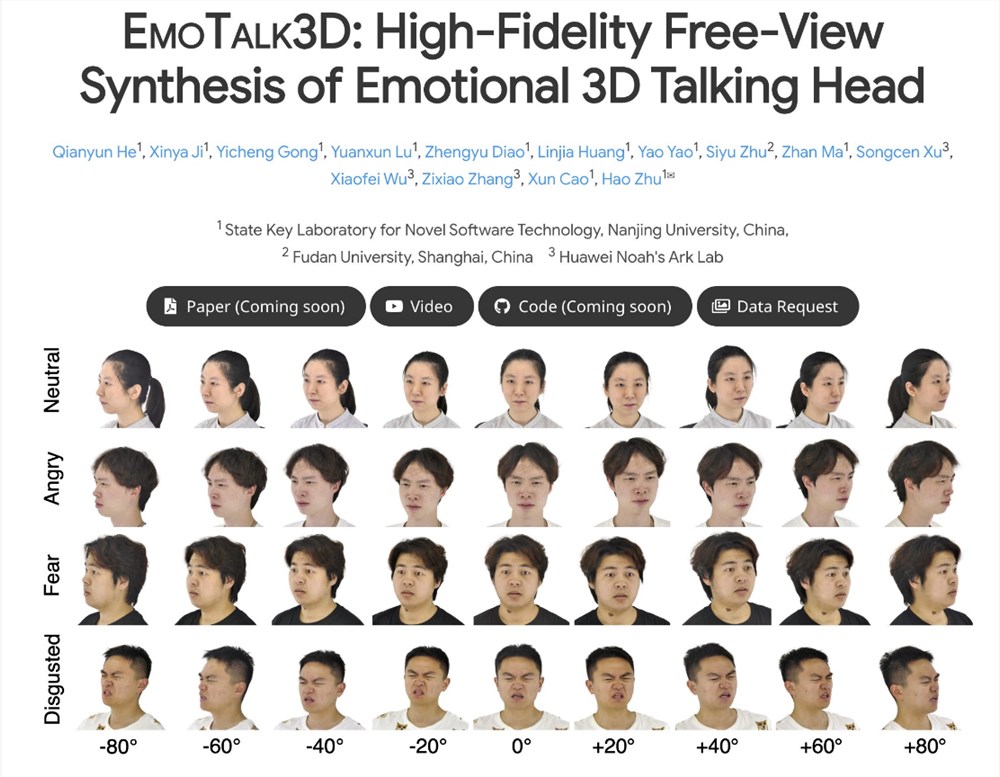

EmoTalk3D計畫在人工智慧領域取得了突破性進展,其核心在於成功合成高保真度、情緒豐富的3D說話頭像。該專案透過建構一個包含多視圖視訊、情緒標註和3D幾何圖形的全新資料集EmoTalk3D,並研發了一種創新的「語音到幾何到外觀」映射框架,解決了現有技術在多視圖一致性和情感表達方面的不足。該框架能夠精準預測3D幾何序列,並基於4D高斯表示合成3D頭像外觀,最終實現自由視圖的說話頭像動畫,甚至連細微表情和皺紋都能夠逼真地呈現。

據了解,EmoTalk3D計畫的研究團隊針對目前3D說話頭像技術在多元觀點一致性與情緒表達方面的不足,提出了一種全新的合成方法。此方法不僅具有增強的唇部同步和渲染質量,還能在生成的說話頭像中實現可控的情緒表達。

研究團隊設計了一個「語音到幾何到外觀」的映射框架。該框架首先從音訊特徵預測忠實的3D幾何序列,然後基於這些幾何圖形合成由4D高斯表示的3D說話頭像的外觀。這過程中,外觀進一步分解為規範和動態高斯分量,透過從多視圖影片中的學習,二者得以融合,從而渲染出自由視圖的說話頭像動畫。

值得一提的是,EmoTalk3D計畫的研究團隊也成功解決了先前方法在捕捉動態臉部細節方面的難題,如皺紋和細微表情的呈現。實驗結果表明,該方法在產生高保真度和情緒可控的3D說話頭像方面具有顯著優勢,同時在唇部運動生成中展現了更好的渲染品質和穩定性。

目前,EmoTalk3D計畫的程式碼和資料集已在指定的HTTPS URL上發布,供全球的研究人員和開發者參考和使用。這項創新性的技術突破無疑將為3D說話頭像領域的發展注入新的活力,並有望在未來應用於虛擬實境、擴增實境、影視製作等多個領域。

EmoTalk3D計畫的成功,為3D數位人物的製作帶來了新的可能性,其高保真、情感化的3D頭像技術,將為虛擬實境、擴增實境以及影視製作等領域帶來革命性的變革。未來,我們可以期待更多基於EmoTalk3D技術的產品和應用出現,為人們帶來更沉浸式的體驗。