香港中文大學和中國科學院等機構的研究團隊近日推出名為MiCo的全模態預訓練範式,在多模態學習領域取得突破性進展,刷新了37項最先進性能(SOTA)記錄。 MiCo旨在建立能夠理解任何模態並學習通用表示的全模態智能,透過引入更多模態、資料量和模型參數,模擬人腦的多模態認知過程。其核心在於將不同模態分為“知識模態”和“接口模態”,並設計了相應的全模態學習架構,利用多模態上下文強化模態間的相互增強,構建跨模態的上下文關係。這項研究成果為人工智慧領域的發展提供了新的方向和思路。

站長之家(ChinaZ.com)6月17日消息:由香港中文大學和中國科學院等機構的研究團隊提出了一種名為MiCo(Multimodal Context)的全模態預訓練範式,這一方法在多模態學習領域取得了顯著成果,刷新了37項最先進性能(SOTA)記錄。

核心特點:

全模態理解:MiCo旨在建構能夠理解任何模態並學習通用表示的全模態智能。

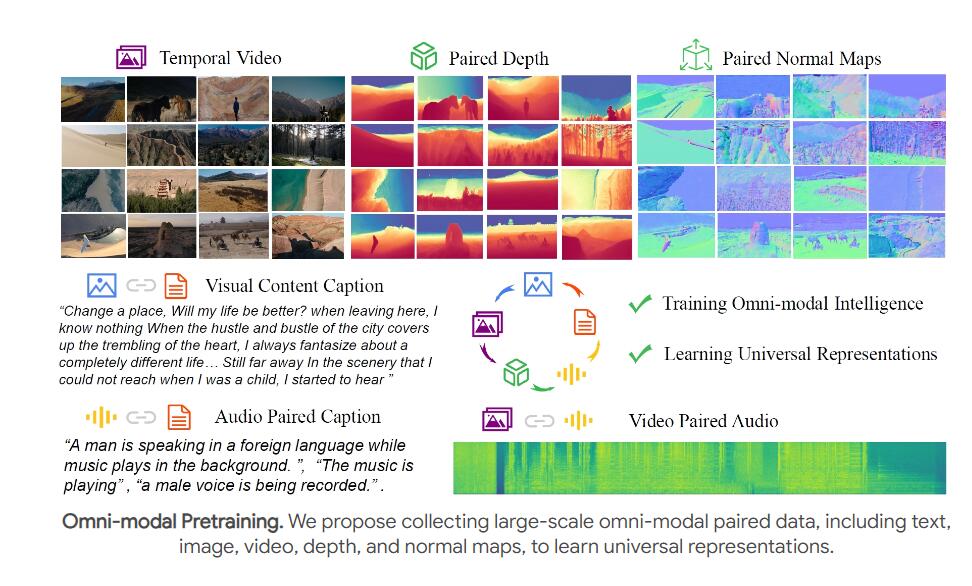

大規模預訓練:透過引入更多模態、資料量和模型參數,MiCo在預訓練過程中模擬了人腦的多模態認知過程。

神經網路結構設計:MiCo將不同模態分為“知識模態”和“介面模態”,並設計了相應的全模態學習架構,透過產生推理方法進行對齊。

多模態上下文與尺度定律:MiCo利用多模態上下文來強化模態間的相互增強,建構了跨模態的脈絡關係。

實驗結果顯示:

在10種不同模態的單模態感知基準測試中,MiCo取得了7項SOTA成績。

在25種跨模態理解任務中,包括檢索、問答、描述等,MiCo獲得了20項SOTA成績。

在18種多模態大型語言模型基準測試中,MiCo共取得了10項SOTA成績。

MiCo的預訓練方法:

團隊採用了視訊與配對的音訊、文字描述、深度和法線進行聯合預訓練,模擬人腦的視覺、聽覺和時空感知能力。

透過全模態編碼器(如ViT)提取多模態特徵,並使用文字編碼器提取文字特徵,建構了多模態上下文關係。

結論與未來工作:

MiCo計畫是人工智慧模擬人腦多模態認知的重要嘗試,團隊期待它能啟發未來的研究,開發更強大的全模態基礎模型。

未來的工作計畫包括結合更多模態,如光流、IMU資料和事件檔案等,以持續增強全模態聯合預訓練。

MiCo的出色表現為多模態學習領域樹立了新的標桿,其未來發展潛力巨大,值得持續關注。團隊未來的研究方向也值得期待,相信MiCo將持續推動人工智慧技術進步。