生成式語言模型的實際應用效果往往受限於推理階段的解碼策略。現有方法如RLHF主要關注模型勝率,忽略了解碼策略對模型表現的影響,導致效率低且輸出品質難以保證。為了解決這個問題,GoogleDeepMind和Google研究團隊提出了InfAlign框架,旨在將推理策略與模型對齊過程結合,提升模型的推理效能和可靠性。

生成式語言模型在從訓練到實際應用的過程中面臨許多挑戰。其中一個主要問題是如何在推理階段使模型達到最佳表現。

目前的對策,如透過人類回饋的強化學習(RLHF),主要集中在提高模型的勝率上,但往往忽略了推理時的解碼策略,例如Best-of-N 取樣和控制解碼。這種訓練目標與實際使用之間的差距,可能導致效率低下,影響輸出的品質和可靠性。

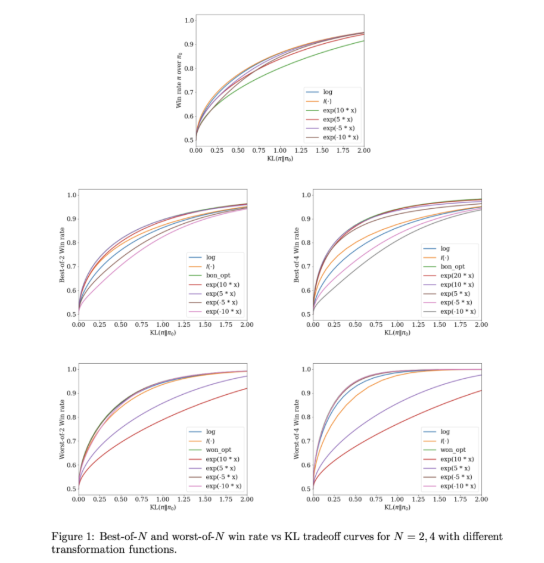

為了解決這些問題,GoogleDeepMind 和Google研究團隊開發了InfAlign,這是一個旨在與推理策略結合的機器學習框架。 InfAlign 將推理時的方法納入對齊過程,力求彌補訓練與應用之間的鴻溝。它透過一種校準的強化學習方法來調整基於特定推理策略的獎勵函數。 InfAlign 對Best-of-N 採樣(產生多個響應並選擇最佳者)和Worst-of-N(常用於安全評估)等技術特別有效,確保對齊的模型在控制環境和現實場景中都能表現良好。

InfAlign 的核心是校準與變換強化學習(CTRL)演算法,該演算法遵循三個步驟:校準獎勵分數、根據推理策略變換這些分數、解決一個KL 正則化的最佳化問題。透過將獎勵變換客製化到特定場景,InfAlign 將訓練目標與推理需求對齊。這種方法不僅提升了推理時的勝率,也維持了計算效率。此外,InfAlign 增強了模型的穩健性,使其能夠有效應對各種解碼策略,並產生一致的高品質輸出。

在使用Anthropic 的有用性和無害性資料集進行的實驗中,InfAlign 的有效性得到了驗證。與現有方法相比,InfAlign 在Best-of-N 取樣的推理勝率上提高了8%-12%,在Worst-of-N 安全評估中則提高了4%-9%。這些改進得益於其校準的獎勵變換,有效解決了獎勵模型的誤校準問題,確保了在不同推理場景下的一致表現。

InfAlign 在產生語言模型的對齊方面代表了一項重要的進展。透過結合推理感知的策略,InfAlign 解決了訓練與部署之間的關鍵差異。它紮實的理論基礎和實證結果凸顯了其在全面改善AI 系統對齊方面的潛力。

連結:https://arxiv.org/abs/2412.19792

劃重點:

InfAlign 是GoogleDeepMind 開發的新框架,旨在提升語言模型在推理階段的表現。

此框架透過校準的強化學習方法,調整推理策略的獎勵函數,實現訓練目標與推理需求的對齊。

實驗結果表明,InfAlign 在多項任務中顯著提高了模型的推理勝率,展現出良好的適應性和可靠性。

InfAlign框架的出現為解決生成式語言模型在推理階段的效率和品質問題提供了新的思路,其在提升模型穩健性和可靠性方面的貢獻值得關注。未來研究可以進一步探討InfAlign在不同模型和任務上的應用,以推動生成式AI技術的持續發展。