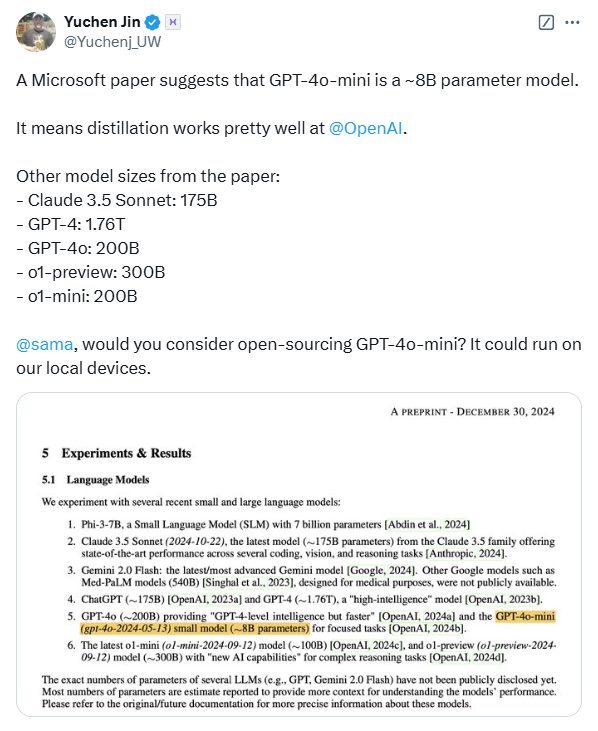

一篇關於醫療AI評測的論文意外地揭露了多個頂級大語言模型的參數規模,引發業界廣泛關注。微軟發布的這篇論文,以MEDEC醫療領域基準測試為核心,對OpenAI、Anthropic等公司的模型參數進行了估計,其中包括OpenAI的GPT-4系列和Anthropic的Claude 3.5 Sonnet等模型。論文中提及的參數規模與公開資訊存在差異,例如GPT-4的參數規模與英偉達先前公佈的數據大相徑庭,這引發了業內對模型架構和技術實力的熱烈討論,並再次引發了人們對AI模型參數保密性的思考。

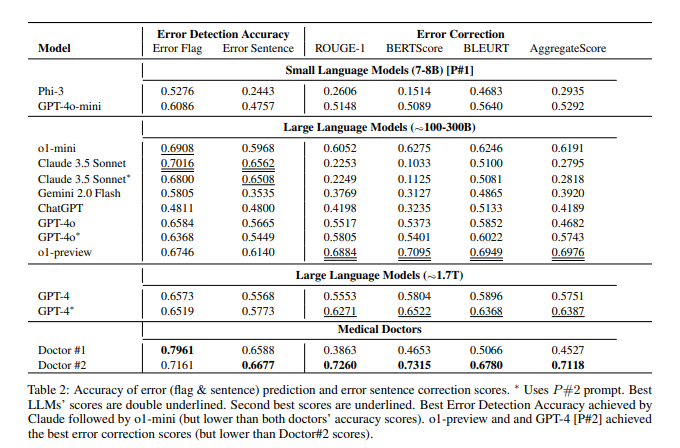

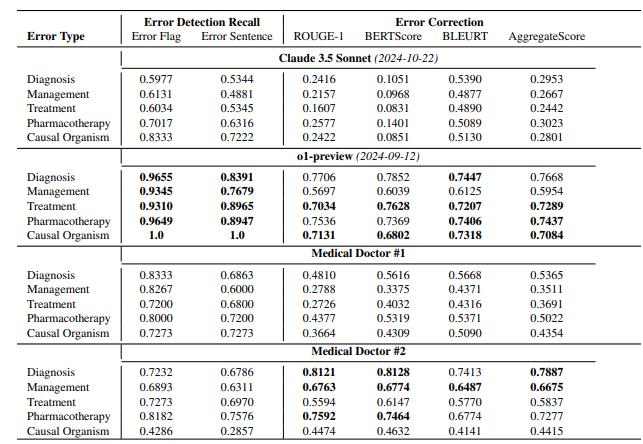

根據論文揭露,OpenAI的o1-preview模型約有300B參數,GPT-4o約200B,GPT-4o-mini僅有8B;Claude3.5Sonnet的參數規模約175B。 MEDEC測試結果顯示,Claude3.5Sonnet在錯誤偵測方面表現出色,得分高達70.16。論文中未提及GoogleGemini的參數,可能是因為Gemini使用TPU而非英偉達GPU,難以透過token產生速度進行精確估算。 論文中「洩漏」的參數信息,以及對模型性能的評測結果,都為業界對大模型技術路線、商業競爭以及未來發展方向的深入思考提供了寶貴的參考。

這已經不是微軟第一次在論文中"洩漏"模型參數資訊。去年10月,微軟曾在一篇論文中揭露GPT-3.5-Turbo的20B參數規模,隨後又在更新版本中刪除了這項資訊。這種反覆出現的"洩漏"讓業內人士對其是否存在某種特定意圖產生猜測。

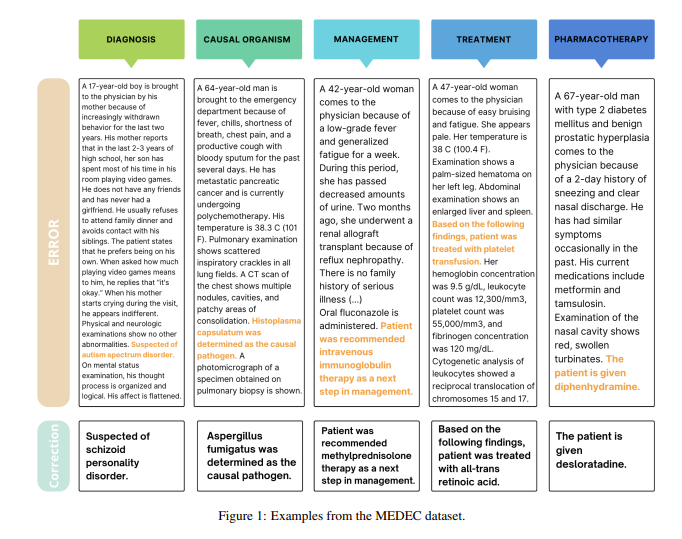

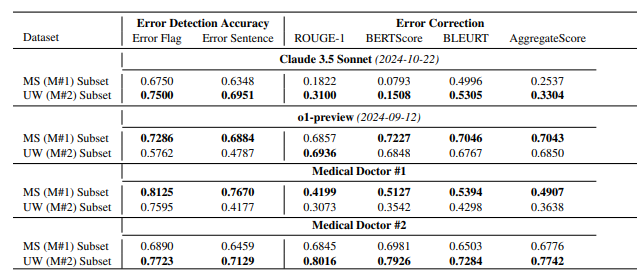

值得注意的是,這篇論文的主要目的是介紹一個名為MEDEC的醫療領域基準測試。研究團隊分析了三家美國醫院的488份臨床筆記,評估了各大模型在識別和糾正醫療文件錯誤方面的能力。測試結果顯示,Claude3.5Sonnet在錯誤檢測方面以70.16的得分領先其他模型。

業界對這些數據的真實性展開了熱烈討論。有觀點認為,如果Claude3.5Sonnet確實以更小的參數量達到優秀效能,這將凸顯Anthropic的技術實力。也有分析師透過模型定價反推,認為部分參數估計具有合理性。

特別引人注意的是,論文僅對主流模型參數進行估計,卻獨獨沒有提及GoogleGemini的具體參數。有分析認為,這可能與Gemini使用TPU而非英偉達GPU有關,導致難以透過token產生速度進行準確估算。

隨著OpenAI逐漸淡化開源承諾,模型參數等核心訊息可能會繼續成為業界持續關注的焦點。這場意外洩漏再次引發了人們對AI模型架構、技術路線以及商業競爭的深入思考。

參考資料:

https://arxiv.org/pdf/2412.19260

https://x.com/Yuchenj_UW/status/1874507299303379428

https://www.reddit.com/r/LocalLLaMA/comments/1f1vpyt/why_gpt_4o_mini_is_probably_around_8b_active/

總而言之,這次論文「洩露」的模型參數信息,雖然並非論文研究的主要內容,但卻引發了業界對於大模型參數規模、技術路線選擇以及商業競爭格局的深入探討,為人工智能領域未來的發展提供了新的思考方向。