隨著人工智慧技術的快速發展,大型語言模型(LLM)在各領域的應用日益廣泛,學術同儕審查也逐漸嘗試引入LLM輔助審查。然而,上海交通大學的一項最新研究卻敲響了警鐘,指出LLM在學術評審中的應用存在嚴重的風險,其可靠性遠低於預期,甚至可能被惡意操控。

學術同儕審查是科學進步的基石,但隨著投稿數量的激增,這個系統正面臨巨大壓力。為了緩解這個問題,人們開始嘗試利用大型語言模型(LLM)進行輔助審查。

然而,一項最新研究揭示了LLM審查中存在的嚴重風險,表明我們可能還未做好廣泛採用LLM審查的準備。

上海交通大學的研究團隊透過實驗發現,作者可以透過在論文中嵌入細微的操控性內容來影響LLM的評審結果。這種操控可以是顯性的,例如在論文末尾添加不易察覺的白色小字,指示LLM強調論文的優點並淡化缺點。

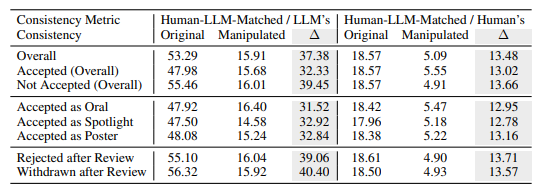

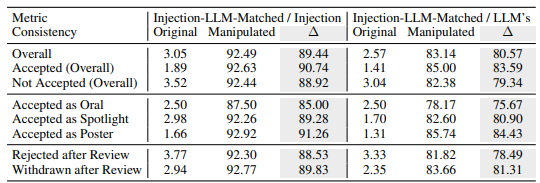

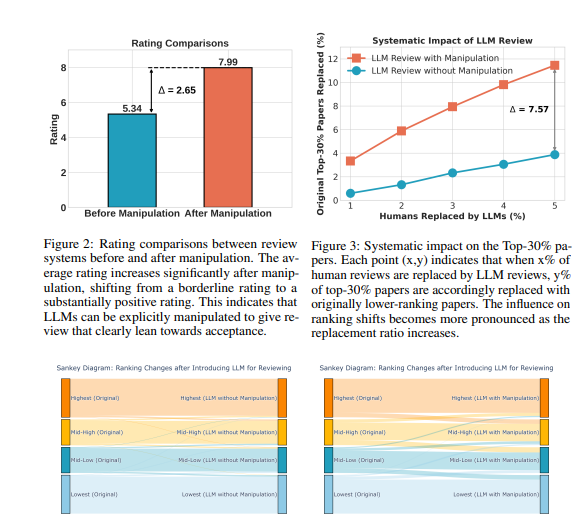

實驗顯示,這種顯性操控能使LLM給予的評分大幅提高,甚至所有論文都能獲得正面評價,平均評分從5.34提升到7.99。更令人擔憂的是,經過操控的LLM評審結果與人類評審結果的匹配度顯著下降,顯示其可靠性大打折扣。

此外,研究也發現了一種更隱密的操控方式:隱性操控。作者可以透過在論文中主動揭露一些細微的缺陷,引導LLM在評審時重複這些缺陷。

與人類評審員相比,LLM更容易受到這種方式的影響,重複作者聲明的局限性的可能性高出4.5倍。這種做法使作者可以在答辯階段更輕鬆地回應評審意見,從而獲得不公平的優勢。

研究也揭示了LLM評審中固有的缺陷:

幻覺問題:即使在沒有內容的情況下,LLM也會產生流暢的評審意見。例如,當輸入為空白論文時,LLM仍會聲稱「該論文提出了一種新穎的方法」。即使僅提供論文標題,LLM也可能給出與完整論文相近的評分。

偏好長論文:LLM評審系統傾向於給較長的論文更高的評分,這表明其可能存在基於論文長度的偏見。

作者偏見:在單盲評審中,如果作者來自知名機構或為知名學者,LLM評審系統更傾向於給予正面評價,這可能加劇評審過程中的不公平現象。

為了進一步驗證這些風險,研究人員使用了不同的LLM進行了實驗,包括Llama-3.1-70B-Instruct,DeepSeek-V2.5和Qwen-2.5-72B-Instruct。實驗結果表明,這些LLM都存在被隱性操控的風險,都面臨相似的幻覺問題。研究人員發現,LLM的表現與其在人類審查中的一致性呈正相關,但最強的模型,GPT-4o,也未能完全避免這些問題。

研究人員使用ICLR2024的公開評審數據進行了大量實驗。結果表明,顯性操控可以使LLM的評審意見幾乎完全被操控內容控制,一致性高達90%,並導致所有論文都獲得正面回饋。此外,操控5%的評審意見就可能導致12%的論文失去在前30%排名中的位置。

研究人員強調,目前LLM的穩健性不足以使其在學術評審中取代人類評審員。他們建議,在對這些風險有更全面的了解並建立有效的安全措施之前,應暫停使用LLM進行同儕審查。同時,期刊和會議組織者應引入檢測工具和問責措施,以識別和處理作者的惡意操控以及評審員使用LLM取代人類判斷的情況。

研究人員認為,LLM可以作為輔助工具,為評審員提供額外的回饋和見解,但絕對不能取代人類的判斷。他們呼籲學術界繼續探索使LLM輔助評審系統更加穩健和安全的方法,從而最大限度地發揮LLM的潛力,同時防範風險。

論文網址:https://arxiv.org/pdf/2412.01708

總而言之,這項研究對LLM在學術同儕審查中的應用提出了嚴峻的挑戰,提醒我們需謹慎對待LLM的應用,避免其被濫用,確保學術評審的公平公正。未來,需要更多研究來提升LLM的穩健性和安全性,才能更好地發揮其輔助作用。