阿里巴巴達摩院發布了基於電商場景的多模態大型語言模型Valley2,該模型結合了Qwen2.5、SigLIP-384視覺編碼器以及創新性的Eagle模組和卷積適配器,旨在提升電器和短視頻領域的應用效能。 Valley2的數據集涵蓋OneVision風格數據、電商和短視頻領域數據以及鍊式思維數據,經過多階段訓練,在多個公開基準測試中取得了優異成績,尤其是在電商相關的評測中表現突出。 其架構設計與訓練策略的最佳化,為多模態大模型的效能提升提供了新的思路。

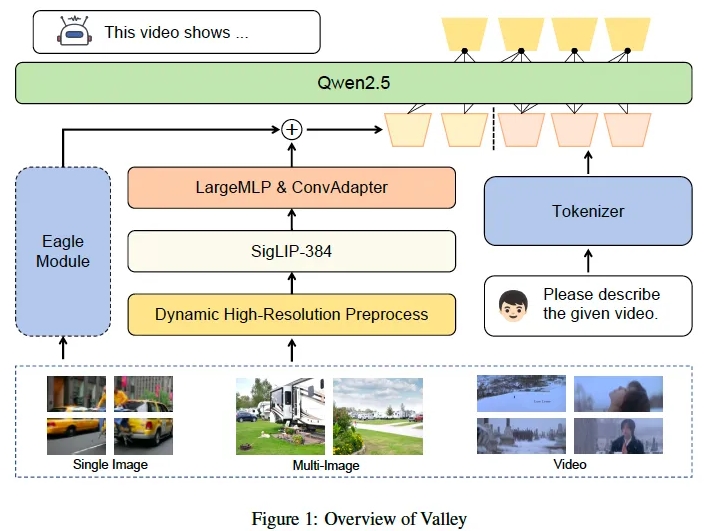

阿里巴巴達摩院近日推出了一款名為Valley2的多模態大型語言模型,該模型基於電商場景設計,旨在透過可擴展的視覺-語言架構,提升各領域性能並拓展電商與短視訊場景的應用邊界。 Valley2採用了Qwen2.5作為LLM主幹,搭配SigLIP-384視覺編碼器,結合MLP層和卷積進行高效特徵轉換。其創新之處在於引入了大視覺詞彙、卷積適配器(ConvAdapter)和Eagle模組,增強了處理多樣化真實世界輸入的靈活性及訓練推理效率。

Valley2的數據由OneVision風格數據、針對電商和短視頻領域的數據以及用於複雜問題解決的鍊式思維(CoT)數據組成。訓練過程分為文字-視覺對齊、高品質知識學習、指令微調和鍊式思維後訓練四個階段。在實驗中,Valley2在多個公開基準測試中表現卓越,尤其在MMBench、MMStar、MathVista等基準上得分頗高,在Ecom-VQA基準測試中也超越了其他同規模模型。

未來,阿里巴巴達摩院計劃發布包含文字、圖像、視訊和音訊模態的全能模型,並引入基於Valley的多模態嵌入訓練方法,以支援下游檢索和探測應用。

Valley2的推出標誌著多模態大型語言模型領域的重要進展,展現了透過結構改進、資料集建構及訓練策略優化來提升模型效能的可能性。

模型連結:

https://www.modelscope.cn/models/bytedance-research/Valley-Eagle-7B

代碼連結:

https://github.com/bytedance/Valley

論文連結:

https://arxiv.org/abs/2501.05901

Valley2的發布不僅展示了阿里巴巴達摩院在多模態大模型領域的先進技術,也預示著未來電商和短視頻領域將迎來更多基於AI的創新應用。 期待未來Valley2能進一步完善並拓展其應用場景,為用戶帶來更便利、更智慧的服務。