降低大模型训练成本是当前人工智能领域的研究热点。腾讯混元团队近期发布的研究,深入探讨了低比特浮点量化训练的规模法则,为高效训练大模型提供了新的思路。该研究通过大量实验,分析了模型大小、训练数据量、量化精度等因素对训练效果的影响,并最终得出在不同精度下如何有效配置训练资源以获得最佳效果的规律。这项研究不仅具有重要的理论意义,也为大模型的实际应用提供了宝贵的指导。

在大模型(Large Language Model,LLM)快速发展的今天,模型的训练和推理成本日益成为研究和应用的关注焦点。最近,腾讯混元团队发布了一项重要研究,深入探讨了低比特浮点量化训练的 “Scaling Laws”,即浮点数量化训练的规模法则。此项研究的核心在于通过降低模型的精度,探索如何在不损失性能的情况下,显著降低计算和存储成本。

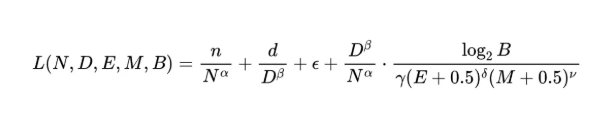

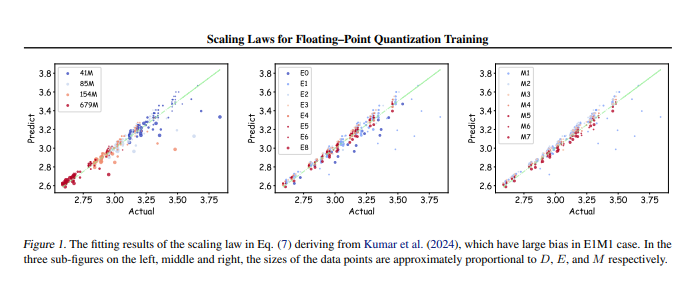

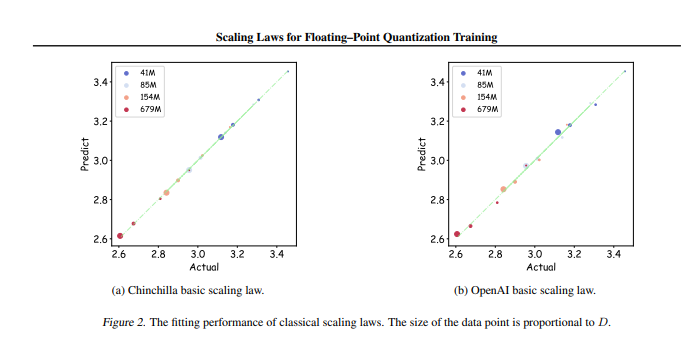

研究团队进行了多达366组不同参数规模和精度的浮点数量化训练,系统分析了影响训练效果的多种因素,包括模型大小(N)、训练数据量(D)、指数位(E)、尾数位(M)以及量化粒度(B)。通过这些实验,研究人员得出了一套统一的 Scaling Law,揭示了在不同精度下,如何有效配置训练数据和模型参数,以获得最佳的训练效果。

最为关键的是,研究指出,在任意低精度的浮点数量化训练中,存在一个 “极限效果”,即在特定的数据量下,模型的性能将达到最优,超过此数据量可能会导致效果下降。此外,研究还发现,理论上最佳性价比的浮点数量化训练精度应在4到8比特之间,这对于开发高效的 LLM 具有重要的指导意义。

该研究不仅填补了浮点数量化训练领域的空白,也为未来硬件制造商提供了参考,帮助他们在不同精度下优化浮点运算能力。最终,这项研究为大模型训练的实践提供了清晰的方向,确保在资源有限的情况下,依然能够实现高效的训练效果。

论文地址:https://arxiv.org/pdf/2501.02423

总之,腾讯混元团队的这项研究为降低大模型训练成本提供了有效的解决方案,其发现的规模法则和最佳精度范围,将对未来大模型的研发和应用产生深远影响。 这项工作为高效能、低成本的大模型训练指明了方向,值得关注和深入研究。