阿里云通义团队重磅推出全新数学推理过程奖励模型Qwen2.5-Math-PRM,该模型提供72B和7B两种尺寸,在性能上显著超越同类开源模型,尤其在识别推理错误方面表现突出。值得关注的是,7B版本甚至超越了广受欢迎的GPT-4o,展现了阿里云在推理模型研发领域的突破性进展。为了更全面地评估模型性能,团队还开源了首个步骤级评估标准ProcessBench,包含3400个涵盖奥数难度的数学问题,并由专家进行详细的推理过程标注,确保评估的科学性和严谨性。

今天,阿里云通义团队正式发布了全新的数学推理过程奖励模型 Qwen2.5-Math-PRM。该模型提供了72B 和7B 两种尺寸,性能表现均显著优于同类的开源过程奖励模型,尤其是在识别推理错误方面表现突出。

Qwen2.5-Math-PRM 的7B 版本令人惊讶地超越了业界广受欢迎的 GPT-4o,这一成就标志着阿里云在推理模型的研发上迈出了重要的一步。为了全面评估模型在数学推理中的表现,通义团队还开源了首个步骤级的评估标准 ——ProcessBench。这个评估标准涵盖了3400个数学问题测试案例,其中还包括国际奥林匹克数学竞赛的难度题目,每个案例均由人类专家标注了详细的推理过程,确保评估的科学性和全面性。

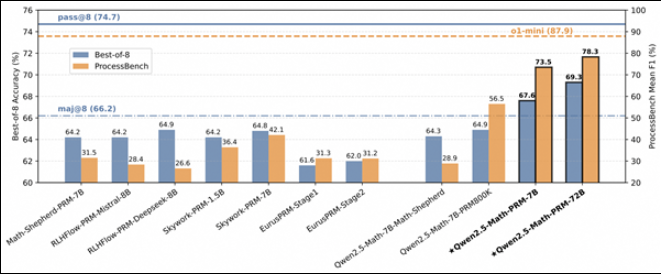

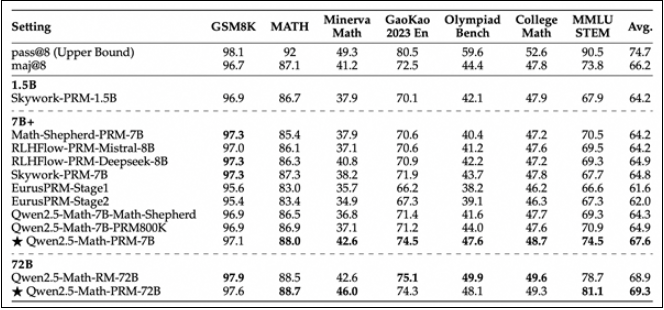

通过对 Qwen2.5-Math-PRM 在 ProcessBench 上的表现评估,研究团队发现,不论是72B 还是7B 尺寸的模型,均表现出色。特别是7B 版本,不仅超越了同尺寸的开源模型,甚至在某些方面还超过了闭源的 GPT-4o-0806。这证明了过程奖励模型(PRM)在提高推理可靠性方面的巨大潜力,并为未来推理过程监督技术的发展提供了新的思路。

阿里云通义团队的这项创新性工作,不仅推动了人工智能推理技术的进步,也为行业内其他开发者提供了宝贵的参考。通过开源的方式,通义团队希望能够与更多研究者共享经验,推动整个行业的技术进步。

Qwen2.5-Math-PRM的发布,标志着大模型在数学推理领域取得了新的突破,其开源的特性也为学术界和产业界的研究和应用提供了极大的便利,值得期待其在未来人工智能发展中的更多可能性。