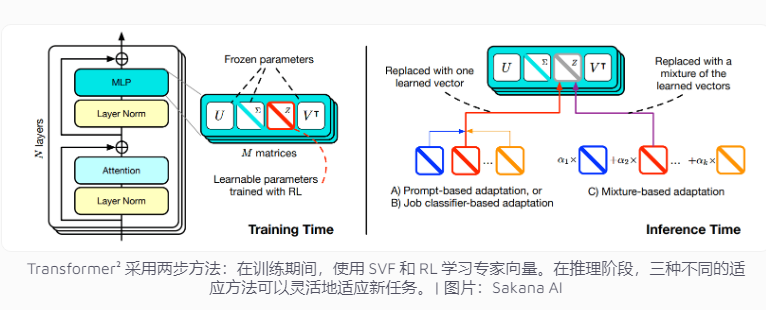

日本Sakana AI公司近期发布了Transformer²,一种旨在提升语言模型任务适应性的创新技术。不同于传统需要一次性处理多个任务的AI系统,Transformer²采用两阶段学习,利用专家向量和奇异值微调(SVF)技术,使其能够在不重新训练整个网络的情况下高效适应新任务,显著降低了资源消耗并提升了模型的灵活性和准确性。该技术通过学习控制网络连接重要性的专家向量,专注于特定任务,例如数学运算、编程和逻辑推理,并结合强化学习进一步优化模型性能。

当前的人工智能系统通常需要在一次训练中处理多个任务,然而它们在面对新任务时容易遭遇意外挑战,导致模型的适应性受到限制。Transformer²的设计理念正是针对这一问题,采用了专家向量和奇异值微调(SVF)技术,使得模型能够在无需重新训练整个网络的情况下,灵活应对新任务。

传统的训练方法需要调整整个神经网络的权重,而这种做法不仅成本高昂,还可能导致模型“遗忘”之前学到的知识。相比之下,SVF技术通过学习控制每个网络连接重要性的专家向量来避免这些问题。专家向量通过调整网络连接的权重矩阵,帮助模型专注于特定任务,比如数学运算、编程和逻辑推理。

这一方法显著减少了模型适应新任务所需的参数量。比如,LoRA方法需要682万个参数,而SVF只需要16万个参数。这不仅减少了内存和处理能力的消耗,还防止了模型在专注某一任务时遗忘其他知识。最重要的是,这些专家向量能够有效地协同工作,提升模型对多样任务的适应能力。

为了进一步提高适应性,Transformer²引入了强化学习。在训练过程中,模型通过提出任务解决方案并获得反馈,不断优化专家向量,从而提高在新任务上的表现。该团队开发了三种策略来运用这些专家知识:适应提示、任务分类器和少样本自适应。特别是少样本自适应策略,通过分析新任务的示例并调整专家向量,进一步提升了模型的灵活性和准确性。

在多个基准测试中,Transformer²的表现超过了传统方法LoRA。在数学任务上,它的表现提升了16%,且所需参数大幅减少。在面对全新任务时,Transformer²的准确率比原始模型高出4%,而LoRA则未能取得预期的效果。

Transformer²不仅能够解决复杂的数学问题,还能结合编程和逻辑推理能力,从而实现跨领域知识的共享。例如,团队发现较小的模型也可以通过转移专家向量,借助较大模型的知识进行性能提升,这为模型间的知识共享提供了新的可能性。

尽管Transformer²在任务适应性上取得了显著进展,但它仍面临一些限制。目前,使用SVF训练的专家向量只能依赖于预训练模型中已有的能力,无法添加全新的技能。真正的持续学习,意味着模型能够自主学习新技能,这一目标仍需要时间来实现。如何在超过700亿参数的大型模型中扩展这一技术,依然是一个悬而未决的问题。

总而言之,Transformer²在持续学习领域展现出巨大的潜力,其高效的资源利用和显著的性能提升为未来语言模型的发展提供了新的方向。 然而,技术仍需不断完善,以克服现有局限性,实现真正的持续学习目标。