在人工智慧領域,高效的模型推理至關重要。開發者不斷探索在不同硬體平台上運行大型語言模型的方法。近日,開發者Andrei David取得一項令人矚目的成就:他成功地將Meta AI的Llama 2模型移植到一台近二十年的Xbox 360遊戲機上,這不僅展現了其精湛的技術,也為人工智慧在邊緣運算領域的應用提供了新的可能性。此舉克服了PowerPC架構、記憶體限制以及endian轉換等諸多挑戰,為在低資源環境下運行大型語言模型提供了寶貴的經驗。

在人工智慧技術快速發展的今天,如何在各種硬體上實現高效的模型推理成為了開發者的重要挑戰。最近,開發者Andrei David 從一台近二十年的Xbox360遊戲機中找到了靈感,他成功地將Meta AI 的Llama LLM 系列中的一款輕量級車型——llama2.c 移植到這台老舊的遊戲機上。

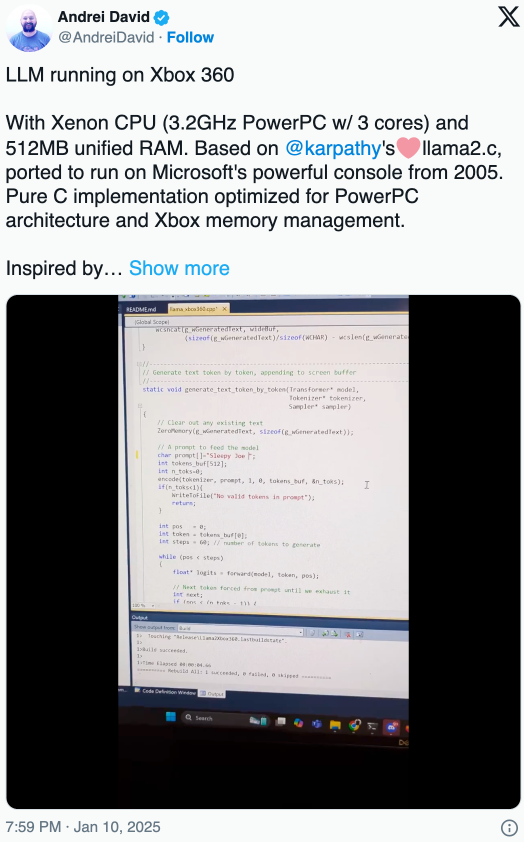

David 在社群媒體平台X 上分享了他的這項成就,並表示他面對的挑戰非常巨大。 Xbox360的PowerPC CPU 採用了big-endian 架構,這意味著在模型的配置和權重載入時,必須進行大量的endian 性轉換。此外,David 還需要對原始程式碼進行深度調整和最佳化,以使其能夠在這樣一台老化的硬體上順利運行。

記憶體管理也是他必須解決的一大難題。 llama2模型的大小達到60MB,而Xbox360的記憶體架構為統一內存,這意味著CPU 和GPU 需要共享同一塊記憶體。這使得David 在設計記憶體使用時必須相當謹慎。他認為,儘管Xbox360的記憶體限制,但在當時其架構卻非常具有前瞻性,預示了現代遊戲機和APU 的標準記憶體管理技術。

經過反覆編碼和優化,David 終於成功地在Xbox360上運行了llama2模型,只需一個簡單的提示:「瞌睡喬說」。值得一提的是,llama2模型僅有700行C 程式碼,且沒有外部依賴,這使得它在特定領域的客製化下可以表現出「令人驚訝」 的強大性能。

對於其他開發者來說,David 的成功給了他們一個新的方向。有用戶提出,Xbox360的512MB 記憶體或許也能支撐其他小型LLM 的實現,例如Hugging Face 公司開發的smolLM。 David 對此表示歡迎,未來我們很可能會看到更多關於LLM 在Xbox360的實驗成果。

David 的成功案例為開發者提供了新的想法和啟發,證明了即使在資源受限的設備上,也能透過巧妙的最佳化和程式碼調整來運行大型語言模型。這不僅推動了人工智慧技術在邊緣運算領域的進一步發展,也為未來更多創新應用提供了無限可能。 未來,我們期待看到更多類似的突破,將人工智慧技術帶入更廣泛的應用場景。