ViTPose是一個基於視覺Transformer的開源人體姿態估計模型,以其簡潔高效的結構和優異的性能而聞名。它摒棄了複雜的捲積神經網絡,僅使用堆疊的Transformer層來提取影像特徵,並能根據需求調整模型大小和輸入分辨率,實現效能與速度的平衡。 該模型在MS COCO資料集上取得了優異的成績,甚至超越了許多更複雜的模型,並支援知識遷移,使得小模型也能具備大模型的能力。其開源的程式碼和模型方便了研究和開發。

ViTPose 的核心是使用純粹的視覺Transformer,這就像一個強大的“骨架”,可以提取圖像中的關鍵特徵。 它不像其他模型需要複雜的捲積神經網路(CNN)來輔助。 它的結構非常簡單,就是把多個Transformer層疊在一起。

ViTPose 模型可以根據需要調整大小。 就像一個可以伸縮的尺子,你可以透過增減Transformer層的數量來控制模型的大小,從而在效能和速度之間找到平衡。 你也可以調整輸入圖的分辨率,模型都能適應。 此外,它還可以同時處理多個資料集,也就是說,你可以用它來識別不同姿勢的資料。

儘管結構簡單,ViTPose在人體姿勢估計方面表現非常出色。 它在MS COCO這個著名的數據集上取得了非常好的成績,甚至超過了許多更複雜的模型。 這表明,簡單的模型也可以非常強大。 ViTPose 還有一個特點就是可以把「知識」從大的模型轉移到小的模型上。 這就像一個經驗豐富的老師可以把知識傳授給學生,讓小模型也能擁有大模型的實力。

ViTPose 的程式碼和模型都是開源的,這意味著任何人都可以免費使用它,並在此基礎上進行研究和開發。

ViTPose就像一個簡單卻強大的工具,它可以幫助電腦理解人類的動作。 它的優點在於簡單、靈活、有效率且易於學習。 這使得它成為人體姿態估計領域的一個非常有前途的基線模型。

該模型使用Transformer層處理影像數據,並使用輕量級的解碼器來預測關鍵點。 解碼器可以使用簡單的反捲積層或雙線性內插法來上取樣特徵圖。 ViTPose 不僅在標準資料集上表現良好,而且在處理遮蔽和不同姿勢的情況下也表現出色。 它可以應用於人體姿態估計,動物姿態估計,以及臉部關鍵點檢測等多種任務。

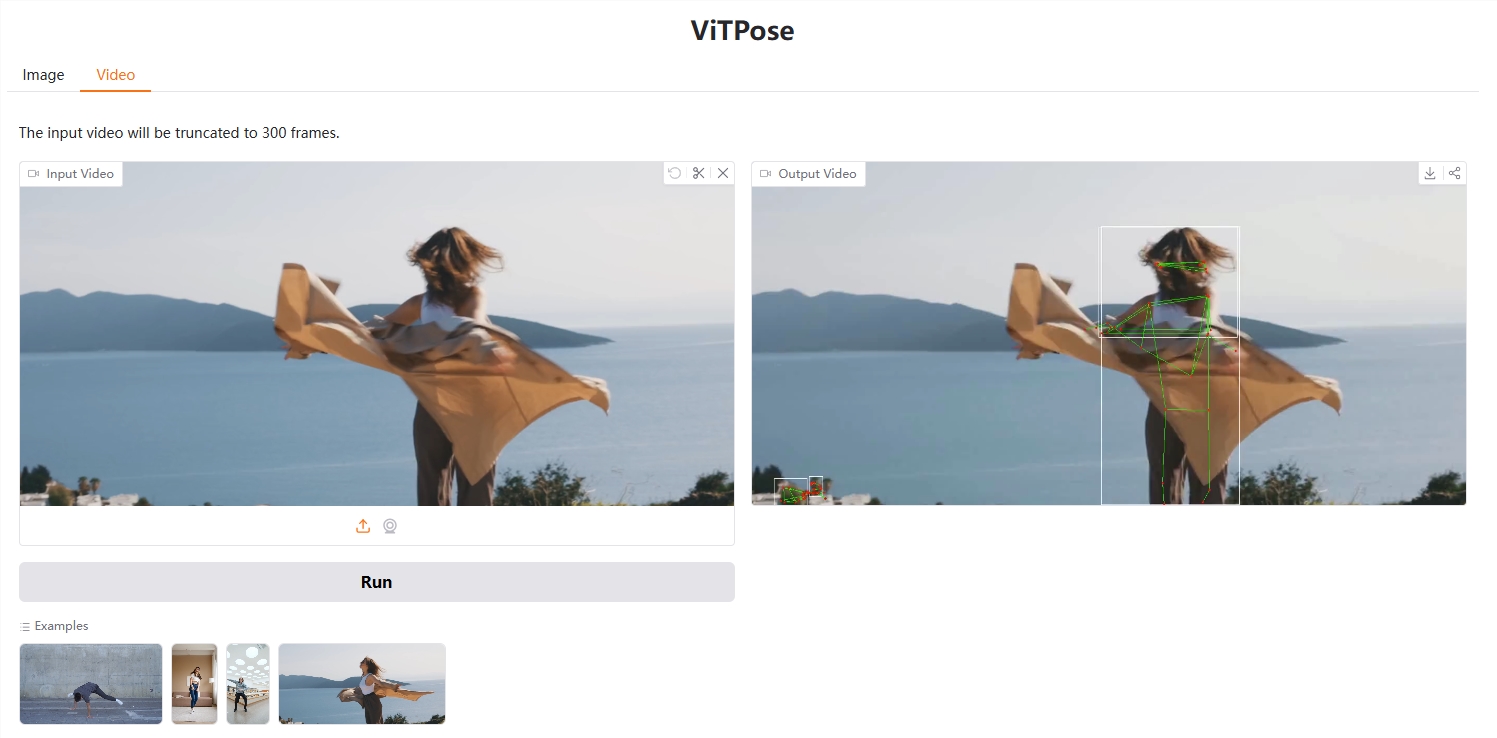

demo:https://huggingface.co/spaces/hysts/ViTPose-transformers

模型:https://huggingface.co/collections/usyd-community/vitpose-677fcfd0a0b2b5c8f79c4335

總而言之,ViTPose憑藉其高效的結構和優秀的性能,為人體姿態估計領域提供了一個強大的基準模型,其開源特性也方便了更多研究者和開發者參與其中,推動該領域的發展。 簡潔、高效、易用是其核心優勢。