學術研究依賴高效的文獻檢索,但現有搜索引擎難以滿足複雜專業查詢的需求。例如,針對特定算法(如UCB方法)的非平穩強化學習研究,需要更強大的搜索和分析能力。研究人員通常耗費大量時間精力手動檢索龐大的學術數據庫。本文介紹了字節跳動研究院和北京大學聯合提出的PaSa,一種基於大型語言模型(LLM)的自主式學術論文搜索代理,旨在解決這一難題。

在學術研究領域,文獻檢索是一項複雜且重要的信息獲取任務。研究人員需要能夠處理複雜的、專業知識領域的檢索能力,以滿足細緻的研究需求。然而,現有的學術搜索平台,如穀歌學術,往往難以應對這些複雜的研究查詢。例如,針對使用UCB 方法的非平穩強化學習的專業查詢,需要更強的計算和分析能力。此外,研究人員在進行文獻綜述時,通常需要耗費大量的時間和精力手動瀏覽龐大的學術數據庫。

儘管已有多項研究探討了大型語言模型(LLMs)在學術論文檢索和科學發現中的應用,但傳統的搜索工具仍然難以滿足複雜的專業研究需求。許多研究集中於通過優化框架和提示工程技術開發LLM 代理,雖然AGILE RL 框架等方法已顯著提升了代理的綜合能力,但仍未找到一種自主且精確的學術論文檢索解決方案,這為研究帶來了較大空白。

近日,字節跳動研究院與北京大學的研究人員聯合提出了PaSa,這是一種創新的基於LLM 的論文搜索代理。 PaSa 能自主執行複雜的搜索策略,包括工具調用、論文閱讀和參考選擇,旨在為複雜的學術查詢生成全面且準確的結果。為了優化PaSa 的性能,研究團隊創建了AutoScholarQuery,一個包含35,000個細粒度學術查詢的合成數據集,並建立了RealScholarQuery 作為評估代理實際性能的基準。該系統利用強化學習技術來增強搜索能力,解決了現有學術搜索方法中的主要局限性。

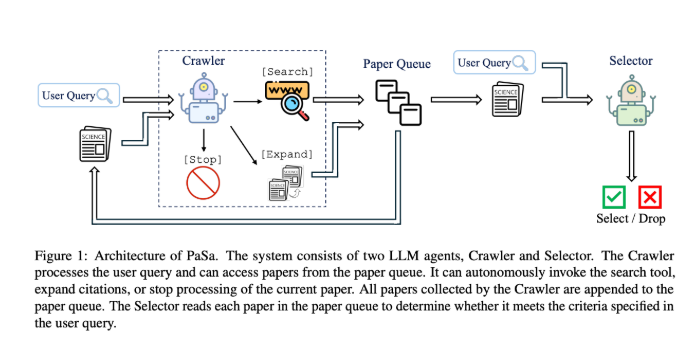

PaSa 系統由兩個LLM 代理組成:爬蟲(Crawler)和選擇器(Selector),它們協同工作以執行全面的學術論文搜索。爬蟲首先分析用戶的查詢,以生成多個精細的搜索查詢來獲取相關論文,並將這些論文添加到專用的論文隊列中。爬蟲會對每篇排隊的論文進行處理,識別和探索可能拓展研究範圍的關鍵引用,並動態地將新發現的相關論文添加到列表中。然後,選擇器將評估每篇論文是否符合原始查詢要求。

實驗結果顯示,PaSa-7b 在多個基準測試中表現優越。在AutoScholarQuery 測試集上,PaSa-7b 相比PaSa-GPT-4o 在召回率上提高了9.64%。而在面對基於谷歌的基準時,PaSa-7b 的召回率提升幅度在33.80% 到42.64% 之間。在更具挑戰性的RealScholarQuery 場景中,PaSa-7b 更是展現出30.36% 的召回率提升和4.25% 的精確度提升。

總的來說,PaSa 的推出標誌著學術論文搜索技術的一次重要進步,為學術研究的信息檢索提供了有效的解決方案。通過結合大型語言模型和強化學習技術,PaSa 極大地減少了研究人員在文獻綜述中花費的時間和精力,同時也為他們提供了一種高效的工具,以應對日益龐大和復雜的學術文獻環境。

代碼:https://github.com/bytedance/pasa

論文:https://arxiv.org/abs/2501.10120

劃重點:

**PaSa 是字節跳動與北京大學研究人員聯合推出的一款智能學術論文搜索代理。 **

** 該系統由爬蟲和選擇器兩個LLM 代理組成,能夠自主執行複雜的搜索策略。 **

** 實驗結果表明,PaSa-7b 在多個基準測試中均表現優於現有的搜索方法,顯著提高了論文檢索的效率和準確性。 **

PaSa的出現為學術研究帶來了革命性的變化,它顯著提升了學術論文檢索的效率和準確性,為研究人員節省了大量時間和精力,從而能夠專注於更重要的研究工作。未來,PaSa的進一步發展和應用值得期待。