DeepSeek 近期發布的DeepSeek-V3和DeepSeek-R1模型在人工智能領域引發巨大反響,其低成本高性能以及強大的推理能力,使其在多項評測中與頂尖閉源模型比肩甚至超越。尤其DeepSeek-R1開源了模型權重,並公開全部訓練技術,這在業界引發廣泛關注,也給Meta等公司帶來了巨大壓力。 Meta工程師甚至公開表示團隊處於恐慌狀態,並試圖複製DeepSeek的技術。

DeepSeek 近日推出的系列模型在全球AI 圈引發震動。 DeepSeek-V3 以低成本實現高性能,在多項評測中與頂尖閉源模型相當;DeepSeek-R1 則通過創新的訓練方式,讓模型展現出強大推理能力,性能對標OpenAI o1 正式版,還開源了模型權重,為AI 領域帶來新的突破和思考。

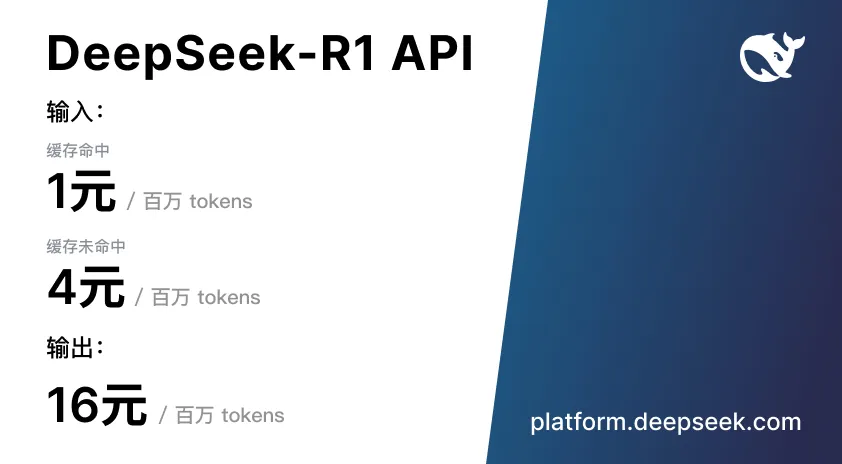

DeepSeek 還公開全部訓練技術。 R1 對標OpenAI 的o1 模型,後訓練階段大量用強化學習技術。 DeepSeek 稱,R1 在數學、代碼、自然語言推理等任務上與o1 相當,且API 價格不到o1 的4% 。

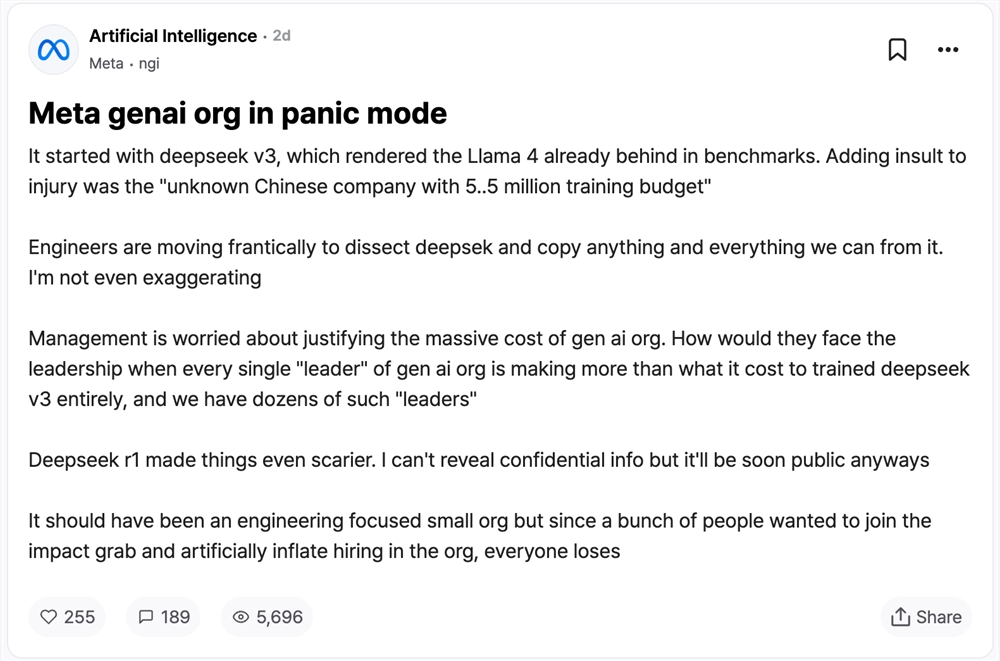

日前國外匿名職場社區teamblind 上一個Meta 員工匿名帖《Meta genai org in panic mode》特別火。 DeepSeek V3 推出使Llama 4 在基準測試中全面落後,Meta 生成式AI 團隊陷入恐慌。一家「不知名的中國公司」550 萬美元預算完成訓練打臉現有大模型。

Meta 工程師瘋狂拆解DeepSeek 試圖複製,而管理層焦慮如何向高層交代高昂成本,其團隊「領導者」薪水超DeepSeek V3 訓練成本就有數十人。 DeepSeek R1 的出現讓情況更糟,雖然有些信息還不能透露,但很快就會公開,到時候情況可能更加不利。

Meta 員工匿名帖譯文如下(由DeepSeek R1 翻譯):

Meta 生成式AI 部門進入緊急狀態

這一切始於DeepSeek V3——它讓Llama 4 的基準測試成績瞬間顯得過時。更令人難堪的是,「一家不知名的中國公司僅用500 萬美元訓練預算」就實現瞭如此突破。

工程師團隊正瘋狂拆解DeepSeek架構,試圖複製其所有技術細節。這絕非誇張,我們的代碼庫正在經歷地毯式搜查。

管理層正為部門巨額開支的合理性焦頭爛額。當每位生成式AI部門的「領導者」年薪都超過DeepSeek V3 整個訓練成本,而這樣的「領導者」我們養著幾十個時,他們該如何向高層交代?

DeepSeek R1 讓局勢更加嚴峻。雖不能透露機密信息,但相關數據即將公之於眾。

本應是精幹的技術導向型團隊,卻因大量人員湧入爭奪影響力,導致組織架構被刻意膨脹。這場權力遊戲的結果?最終所有人都成了輸家。

DeepSeek 系列模型簡介DeepSeek-V3:是一個參數量為671B 的混合專家(MoE)語言模型,每個token 激活37B。它採用Multi-head Latent Attention(MLA)和DeepSeekMoE 架構,在14.8 萬億高質量token 上進行預訓練,經過監督微調與強化學習,在多項測評中超越部分開源模型,與GPT-4o、Claude 3.5 Sonnet 等頂尖閉源模型性能相當。訓練成本低,僅需278.8 萬H800 GPU 小時,約557.6 萬美元,且訓練過程穩定。

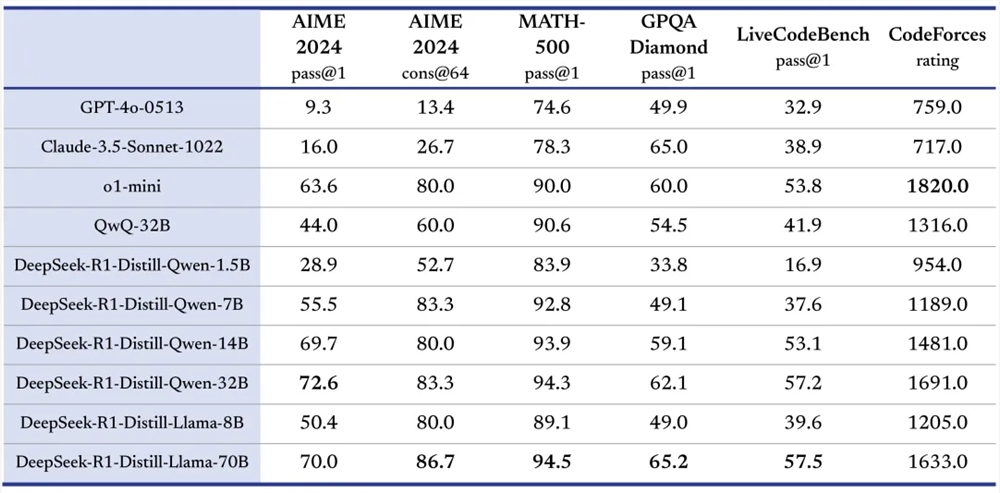

DeepSeek-R1:包括DeepSeek-R1-Zero 和DeepSeek-R1。 DeepSeek-R1-Zero 通過大規模強化學習訓練,不依賴監督微調(SFT),展現出自我驗證、反思等能力,但存在可讀性差和語言混雜問題。 DeepSeek-R1 在DeepSeek-R1-Zero 基礎上,引入多階段訓練和冷啟動數據,解決了部分問題,在數學、代碼、自然語言推理等任務上性能比肩OpenAI o1 正式版。同時,還開源了多個不同參數規模的模型,推動開源社區發展。

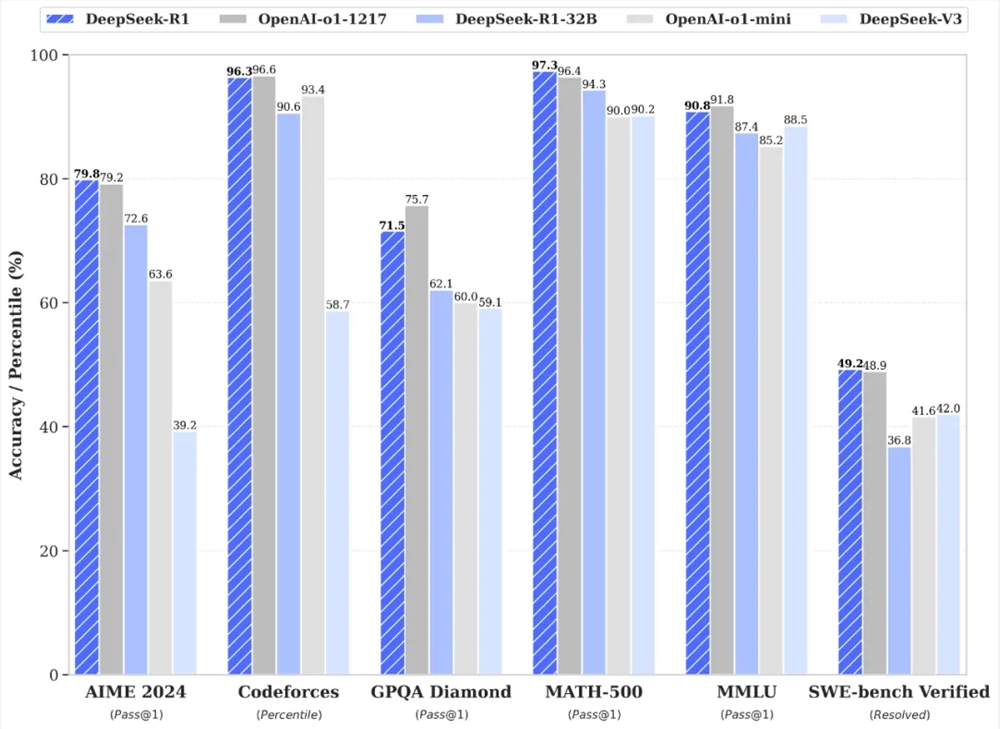

性能卓越:在多項基準測試中,DeepSeek-V3 和DeepSeek-R1 表現出色。如DeepSeek-V3 在MMLU、DROP 等評測中取得優異成績;DeepSeek-R1 在AIME 2024、MATH-500 等測試裡,準確率高,與OpenAI o1 正式版相當甚至在某些方面超越。

訓練創新:

DeepSeek-V3 採用無輔助損失的負載均衡策略和多Token 預測目標(MTP),減少性能下降,提高模型性能;使用FP8 訓練,驗證了其在大規模模型上的可行性。

DeepSeek-R1-Zero 通過純粹強化學習訓練,僅依靠簡單獎懲信號優化模型,證明了強化學習可提升模型推理能力;DeepSeek-R1 在此基礎上,利用冷啟動數據微調,提升模型穩定性和可讀性。

開源共享:DeepSeek 系列模型秉持開源理念,開源了模型權重,如DeepSeek-V3 和DeepSeek-R1 及其蒸餾的小模型,允許用戶通過蒸餾技術借助R1 訓練其他模型,推動AI 技術的交流與創新。

多領域優勢:DeepSeek-R1 在多個領域展現強大能力,在代碼領域,於Codeforces 平台評級高,超越多數人類參賽者;在自然語言處理任務中,處理各類文本理解和生成任務表現優秀。

性價比高:DeepSeek 系列模型API 價格親民。如DeepSeek-V3 API 輸入輸出價格遠低於同類模型;DeepSeek-R1 API 服務定價也具有競爭力,降低了開發者使用成本。

自然語言處理任務:包括文本生成、問答系統、機器翻譯、文本摘要等。例如在問答系統中,DeepSeek-R1 能理解問題,運用推理能力給出準確答案;在文本生成任務裡,可根據給定主題生成高質量文本。

代碼開發:幫助開發者編寫代碼、調試程序、理解代碼邏輯。比如開發者遇到代碼問題時,DeepSeek-R1 可分析代碼並提供解決方案;還能根據功能描述生成代碼框架或具體代碼片段。

數學問題求解:在數學教育、科研等場景,解決複雜數學問題。像DeepSeek-R1 在AIME 競賽相關題目中表現出色,可用於輔助學生學習數學、科研人員處理數學難題。

模型研究與開發:為AI 研究人員提供參考和工具,用於模型蒸餾、改進模型結構和訓練方法等研究。研究人員可基於DeepSeek 開源模型進行實驗,探索新的技術方向。

輔助決策:在商業、金融等領域,處理數據和信息,提供決策建議。例如分析市場數據,為企業製定營銷策略提供參考;處理金融數據,輔助投資決策。

訪問平台:用戶可登錄DeepSeek 官網(https://www.deepseek.com/),進入平台。

選擇模型:在官網或App 中,默認對話由DeepSeek-V3 驅動,點擊打開「深度思考」模式則是由DeepSeek-R1 模型驅動。若通過API 調用,根據需求在代碼中設置對應的模型參數,如使用DeepSeek-R1 時設置model='deepseek-reasoner'。

輸入任務:在對話界面輸入自然語言描述的任務,如「寫一篇愛情小說」「解釋這段代碼的功能」「求解數學方程」等;若使用API,按照API 規範構建請求,將任務相關信息作為輸入參數傳遞。

獲取結果:模型處理任務後返回結果,在界面上查看生成的文本、解答的問題等;使用API 時,從API 響應中解析結果數據進行後續處理。

結語DeepSeek 系列模型憑藉其卓越的性能、創新的訓練方式、開源共享的精神以及高性價比的優勢,在AI 領域取得了顯著成果。

如果你對AI 技術感興趣,不妨點贊、評論,分享你對DeepSeek 系列模型的看法。同時,持續關注DeepSeek 的後續發展,期待它為AI 領域帶來更多驚喜和突破,推動AI 技術不斷進步,為各個行業帶來更多變革與機遇。

DeepSeek的出現,為人工智能領域帶來了新的活力和競爭,其開源精神更是值得稱讚。未來,DeepSeek系列模型將在更多領域展現其強大的能力,讓我們拭目以待!