Sakana AI 推出創新型自適應語言模型Transformer²,該模型採用獨特的兩步動態權重調整機制,無需昂貴微調即可在推理過程中動態學習並適應新任務。這標誌著大型語言模型(LLM) 技術的重大突破,有望改變LLM的應用方式,使其更加高效、個性化和實用。與傳統的微調方法相比,Transformer² 通過奇異值分解(SVD) 和奇異值微調(SVF) 技術,有選擇地調整模型權重的關鍵組件,實時優化性能,避免了耗時的重新訓練。測試結果表明,Transformer² 在多個任務中優於LoRA 模型,且參數更少,還展現出強大的知識遷移能力。

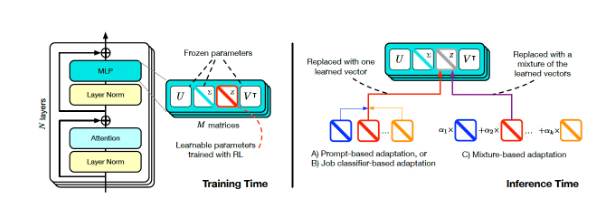

Transformer² 的核心創新在於其獨特的兩步動態權重調整機制。首先,它分析傳入的用戶請求,理解任務需求;然後,通過數學技巧,利用奇異值分解(SVD) 將模型權重與任務需求對齊。通過有選擇地調整模型權重的關鍵組件,Transformer² 能夠實時優化性能,而無需耗時的重新訓練。這與傳統的微調方法形成鮮明對比,後者需要在訓練後保持參數靜態,或者採用低秩自適應(LoRA) 等方法,僅修改一小部分參數。

Transformer 平方訓練和推理(來源:arXiv)

為了實現動態調整,研究人員採用了奇異值微調(SVF) 的方法。在訓練時,SVF 從模型的SVD 組件中學習一組被稱為z 向量的技能表示。在推理時,Transformer² 通過分析提示來確定所需技能,然後配置相應的z 向量,從而實現為每個提示量身定制的響應。

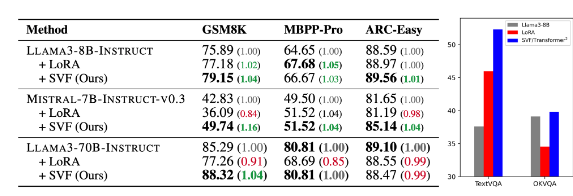

測試結果顯示,Transformer² 在數學、編碼、推理和視覺問答等各種任務中均優於LoRA 模型,且參數更少。更令人矚目的是,該模型還具有知識遷移能力,即從一個模型學習到的z 向量可以應用到另一個模型,從而表明了廣泛應用的潛力。

Transformer-squared(表中的SVF)與基礎模型和LoRA 的比較(來源:arXiv)

Sakana AI 在其GitHub 頁面上發布了Transformer² 組件的訓練代碼,為其他研究人員和開發人員打開了大門。

隨著企業不斷探索LLM 的應用,推理時定制技術正逐漸成為主流趨勢。 Transformer² 與Google 的Titans 等其他技術一道,正在改變LLM 的應用方式,使用戶能夠根據其特定需求動態調整模型,而無需重新訓練。這種技術的進步將使LLM 在更廣泛的領域內更加有用和實用。

Sakana AI 的研究人員表示,Transformer² 代表了靜態人工智能與生命智能之間的橋樑,為高效、個性化和完全集成的人工智能工具奠定了基礎。

Transformer² 的開源發布,將極大推動LLM 技術的發展和應用,為構建更加高效、個性化的人工智能係統提供了新的方向。其動態學習和適應新任務的能力,使其在各種領域都具有巨大的應用潛力,值得期待未來的發展。