艾伦人工智能研究所(AI2)近日开源发布了新型大型语言模型OLMoE,这是一个具有70亿参数的稀疏混合专家(MoE)模型,但每个输入标记仅使用10亿参数,显著降低了推理成本和内存需求。OLMoE拥有两个版本:通用版OLMoE-1B-7B和指令微调版OLMoE-1B-7B-Instruct,其性能在基准测试中与其他大型模型相比毫不逊色,甚至超越了一些更大规模的模型。AI2强调OLMoE的完全开源性,这在MoE模型领域尤为珍贵,为学术研究提供了宝贵资源。

OLMoE 采用了一种稀疏混合专家(MoE)架构,拥有70亿个参数,但每个输入标记仅使用10亿个参数。它有两个版本,分别是更通用的 OLMoE-1B-7B 和经过指令调优的 OLMoE-1B-7B-Instruct。

与其他大多数闭源的混合专家模型不同,AI2特别强调 OLMoE 是完全开源的。他们在论文中提到,“大多数 MoE 模型是闭源的:尽管有些公开了模型权重,但对其训练数据、代码或配方的信息极为有限。” 这使得很多学术研究者无法接触到这些模型。

AI2的研究科学家内森・兰伯特在社交媒体上表示,OLMoE 将有助于政策制定,这可以为学术界的 H100集群的上线提供一个起点。他还提到,OLMoE 模型的发布是 AI2致力于开发开源模型、使其性能与封闭模型相媲美的目标的一部分。

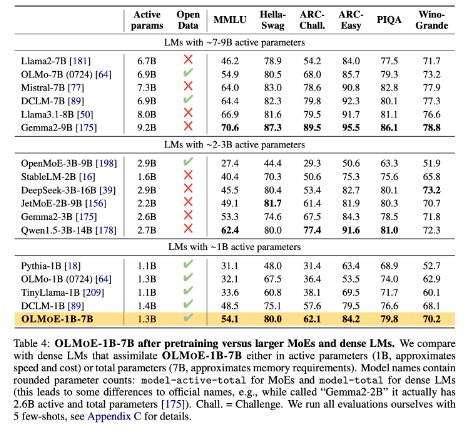

在模型的构建方面,AI2决定使用64个小型专家进行精细路由,并在运行时只激活其中的八个。实验表明,OLMoE 在性能上与其他模型相当,但在推理成本和内存存储上却显著降低。OLMoE 还建立在 AI2之前的开源模型 OLMO1.7-7B 的基础上,支持4096个标记的上下文窗口。OLMoE 的训练数据来自多个来源,包括 Common Crawl、Dolma CC 和维基百科等。

在基准测试中,OLMoE-1B-7B 在与相似参数的模型比较时,表现优于许多现有模型,甚至超越了更大规模的模型,如 Llama2-13B-Chat 和 DeepSeekMoE-16B。

AI2的目标之一是为研究人员提供更多完全开源的 AI 模型,包括混合专家架构。尽管许多开发者都在使用 MoE 架构,但 AI2认为大多数其他 AI 模型在开放性上还远远不够。

huggingface: https://huggingface.co/collections/allenai/olmoe-66cf678c047657a30c8cd3da

论文入口: https://arxiv.org/abs/2409.02060

划重点:

- AI2发布的新开源模型 OLMoE 在性能与成本方面都具备竞争力。

- OLMoE 采用了稀疏混合专家架构,能够有效降低推理成本和内存需求。

- AI2致力于提供全面开源的 AI 模型,促进学术研究和开发。

总而言之,OLMoE 的开源发布是大型语言模型领域的一大进步,其高性能、低成本以及完全开源的特性,将极大地推动学术界和工业界的进一步研究与应用。AI2此举体现了其对开源AI发展的坚定承诺,值得期待未来更多类似的贡献。