微軟近日開源的屏幕內容解析工具OmniParser,憑藉其強大的功能和跨平台兼容性,迅速在HuggingFace平台上成為最受歡迎的模型,引發業界關注。 OmniParser通過整合YOLOv8、BLIP-2等多個模型,實現了對屏幕截圖的全面解析,將圖像信息轉化為結構化數據,方便其他系統理解和處理圖形用戶界面。其開源特性也鼓勵了開發者社區的積極參與和貢獻。

微軟近期推出的屏幕內容解析工具OmniParser,本周躍居人工科技開源平台HuggingFace最受歡迎模型榜首。據HuggingFace聯合創始人兼首席執行官Clem Delangue表示,這是該領域首個獲此殊榮的解析工具。

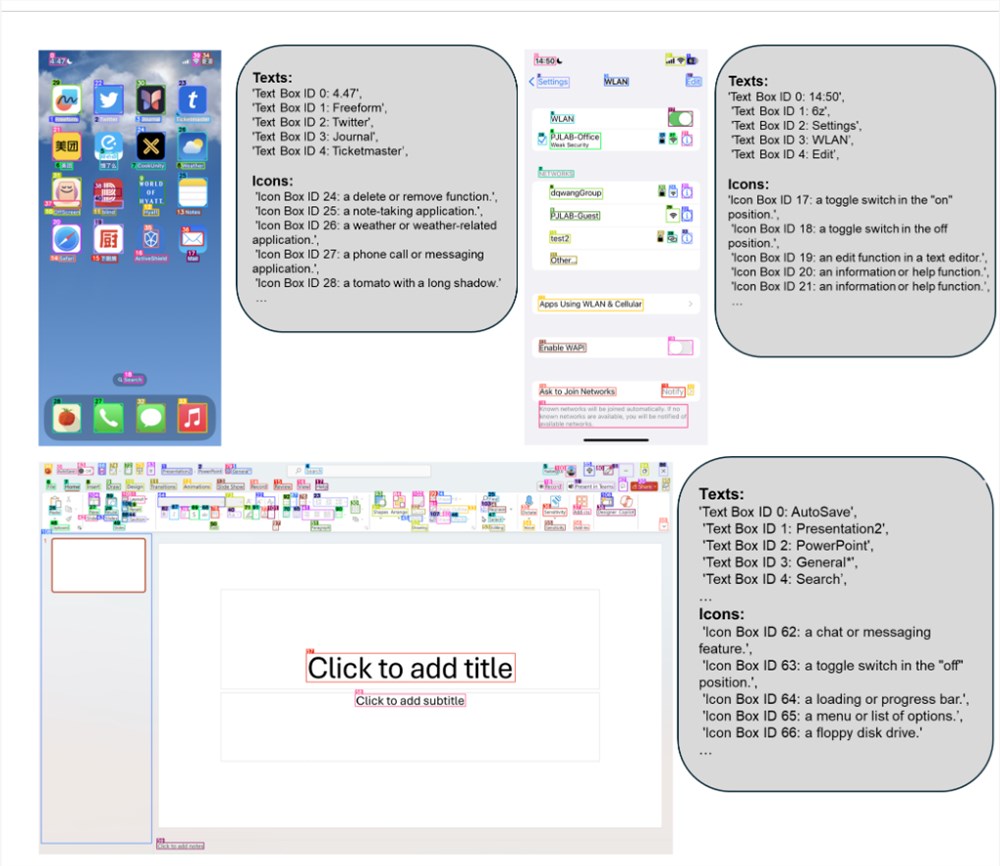

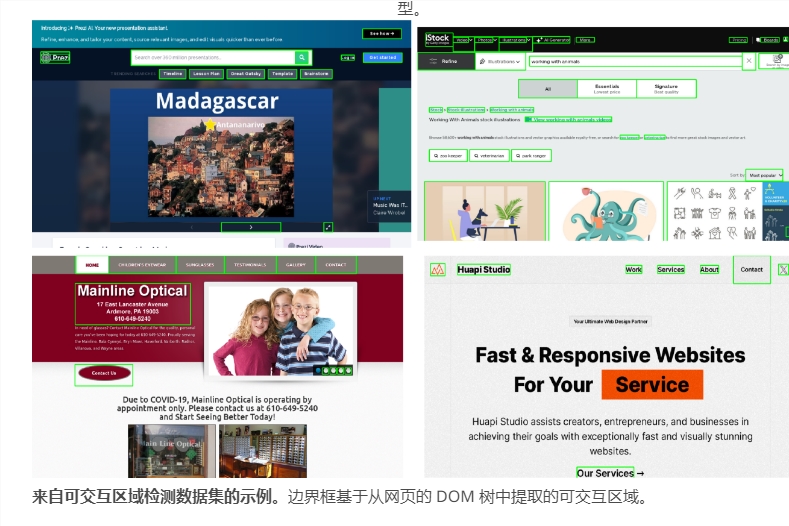

OmniParser主要用於將屏幕截圖轉化為結構化數據,幫助其他系統更好地理解和處理圖形用戶界面。該工具採用多模型協同工作方式:YOLOv8負責檢測可交互元素位置,BLIP-2分析元素用途,同時配備光學字符識別模塊提取文本信息,最終實現對界面的全面解析。

這一開源工具具有廣泛的兼容性,可支持多種主流視覺模型。微軟合作夥伴研究經理Ahmed Awadallah強調,開放合作對推動技術發展至關重要,OmniParser正是踐行這一理念的產物。

目前,科技巨頭紛紛佈局屏幕交互領域。 Anthropic發布了名為"Computer Use"的閉源解決方案,蘋果則推出了針對移動界面的Ferret-UI。相比之下,OmniParser憑藉其跨平台通用性,展現出獨特優勢。

不過,OmniParser仍面臨一些技術挑戰,如重複圖標識別和文本重疊場景下的精確定位等問題。但開源社區普遍認為,隨著更多開發者參與改進,這些問題有望得到解決。

OmniParser的迅速走紅,顯示出開發者對通用型屏幕交互工具的迫切需求,也預示著這一領域可能迎來快速發展。

地址:https://microsoft.github.io/OmniParser/

OmniParser的成功,不僅在於其技術實力,更在於其開源的理念,這為其未來的發展提供了強大的動力和廣闊的應用前景。期待OmniParser在未來能夠更好地解決現有技術難題,為屏幕交互領域帶來更多創新。