OpenAI 發布了新的基準測試SimpleQA,旨在評估大型語言模型生成回答的事實準確性。隨著AI 技術的飛速發展,確保模型輸出的真實可靠性至關重要,而“幻覺”現象——模型生成看似可信實則錯誤的信息——成為了一個日益嚴峻的挑戰。 SimpleQA 的出現,為解決這一問題提供了新的途徑和標準。

最近,OpenAI 發布了一個名為SimpleQA 的新基準測試,旨在評估語言模型生成回答的事實準確性。

隨著大型語言模型的快速發展,確保生成內容的準確性面臨著諸多挑戰,尤其是那些所謂的“幻覺” 現象,即模型生成了聽起來很自信但實際上是錯誤或不可驗證的信息。這種情況在越來越多的人依賴AI 獲取信息的背景下,變得尤為重要。

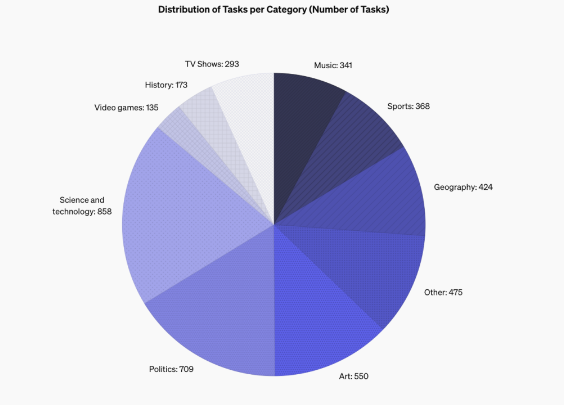

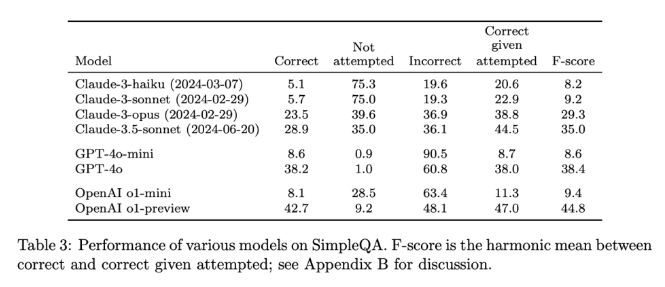

SimpleQA 的設計特色在於它專注於短小、明確的問題,這些問題通常有一個確鑿的答案,這樣就能更容易地評估模型的回答是否正確。與其他基準不同,SimpleQA 的問題是經過精心設計的,旨在讓即便是最先進的模型如GPT-4也會面臨挑戰。這個基準包含了4326個問題,覆蓋歷史、科學、技術、藝術和娛樂等多個領域,特別注重評估模型的精準度和校準能力。

SimpleQA 的設計遵循了一些關鍵原則。首先,每個問題都有一個由兩個獨立的AI 訓練師確定的參考答案,確保了答案的正確性。

其次,問題的設置避免了模糊性,每個問題都能用一個簡單明確的答案來回答,這樣評分就變得相對容易。此外,SimpleQA 還使用了ChatGPT 分類器來進行評分,明確標記回答為“正確”、“錯誤” 或“未嘗試”。

SimpleQA 的另一個優勢是它涵蓋了多樣化的問題,防止模型過度專門化,確保全面評估。這一數據集的使用簡單,因為問題和答案都很簡短,使得測試運行快速且結果變化小。而且,SimpleQA 還考慮了信息的長期相關性,從而避免了因信息變化而導致的影響,使其成為一個“常青” 的基準。

SimpleQA 的發布是推動AI 生成信息可靠性的重要一步。它不僅提供了一個易於使用的基準測試,更為研究人員和開發者設定了一個高標準,鼓勵他們創建不僅能生成語言而且能做到真實準確的模型。通過開放源代碼,SimpleQA 為AI 社區提供了一個寶貴的工具,幫助提升語言模型的事實準確性,以確保未來的AI 系統既能提供信息又值得信賴。

項目入口:https://github.com/openai/simple-evals

詳情頁:https://openai.com/index/introducing-simpleqa/

劃重點:

SimpleQA 是OpenAI 推出的全新基準,專注於評估語言模型的事實準確性。

該基準由4326個短小明確的問題組成,覆蓋多個領域,確保全面評估。

SimpleQA 幫助研究者識別和提升語言模型在生成準確內容方面的能力。

總而言之,SimpleQA 為評估大型語言模型的準確性提供了一個可靠的工具,其開放性和易用性將推動AI領域朝著更加真實可信的方向發展。期待SimpleQA能夠促進更可靠、更值得信賴的AI系統的誕生。