樂天集團發布了其首個日本大語言模型(LLM) Rakuten AI2.0 和小語言模型(SLM) Rakuten AI2.0mini,旨在推動日本人工智能發展。 Rakuten AI2.0 採用混合專家(MoE) 架構,擁有八個70 億參數的專家模型,通過日英雙語數據訓練,提供高效的文本處理能力。 Rakuten AI2.0mini 則是一個15 億參數的緊湊型模型,專為邊緣設備部署設計,兼顧成本效益和應用便捷性。兩款模型均已開源,並提供指令微調和偏好優化版本,支持各種文本生成任務。

樂天集團宣布推出其首個日本大語言模型(LLM)和小語言模型(SLM),命名為Rakuten AI2.0和Rakuten AI2.0mini。

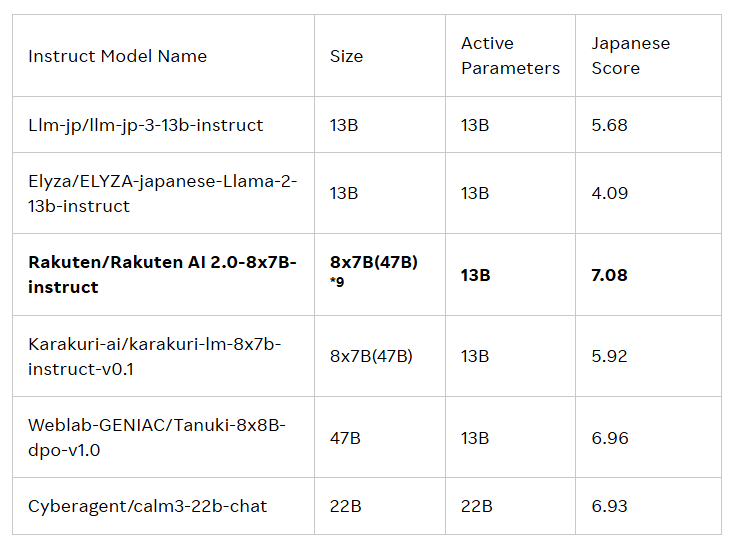

這兩款模型的發布旨在推動日本的人工智能(AI)發展。 Rakuten AI2.0基於混合專家(MoE)架構,是一款8x7B 的模型,由八個各自擁有70億參數的模型組成,每個模型充當一個專家。每當處理輸入的token 時,系統會將其發送給最相關的兩個專家,由路由器負責選擇。這些專家和路由器不斷通過大量的高質量日英雙語數據進行聯合訓練。

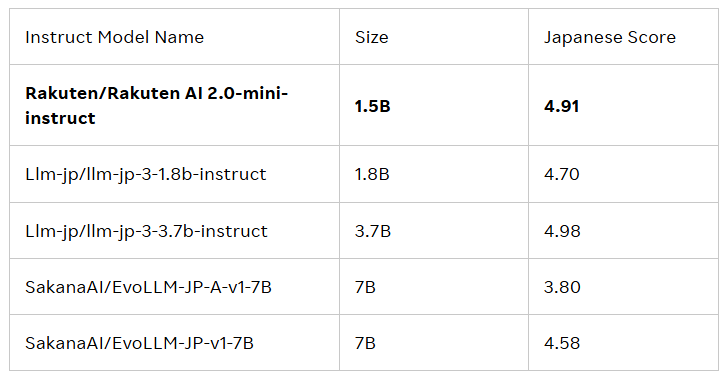

Rakuten AI2.0mini 則是一款全新的、參數量為15億的稠密模型,專為成本效益高的邊緣設備部署而設計,適合特定應用場景。它同樣在日英混合數據上進行訓練,目的是提供便捷的解決方案。兩款模型均經過指令微調和偏好優化,發布了基礎模型和指令模型,以支持企業和專業人士開發AI 應用。

所有模型均採用Apache2.0許可協議,用戶可在樂天集團的Hugging Face 官方庫中獲取,商業用途包括文本生成、內容摘要、問答、文本理解及對話系統構建等。此外,這些模型也可作為其他模型的基礎,便於進一步的開發和應用。

樂天集團的首席AI 與數據官蔡婷表示:“我為我們的團隊如何將數據、工程和科學結合起來,推出Rakuten AI2.0感到無比自豪。我們的新AI 模型提供了強大且具成本效益的解決方案,幫助企業做出智能決策,加快價值實現,並開啟新的可能性。通過開放模型,我們希望加速日本的AI 發展,鼓勵所有日本企業進行構建、實驗和成長,推動一個協作共贏的社區。”

官方博客:https://global.rakuten.com/corp/news/press/2025/0212_02.html

劃重點:

樂天集團推出首個日本大語言模型(LLM)和小語言模型(SLM),名為Rakuten AI2.0和Rakuten AI2.0mini。

Rakuten AI2.0基於混合專家架構,擁有八個70億參數的專家模型,致力於高效處理日英雙語數據。

所有模型均可在樂天Hugging Face 官方庫獲取,適用於多種文本生成任務,並可作為其他模型的基礎。

總之,Rakuten AI2.0 和Rakuten AI2.0mini 的推出標誌著日本在大型語言模型領域的又一重要進展,其開源性質將促進日本AI 生態系統的構建和發展,值得期待其未來的應用和影響。