隨著人工智能技術的快速發展,語言模型在多個領域的應用越來越廣泛。然而,OpenAI 的一項最新研究揭示,這些模型在回答事實問題時的表現遠未達到預期,引發了人們對AI 知識獲取能力的重新思考。

最近,一項由OpenAI 進行的研究顯示,儘管人工智能技術飛速發展,當前最先進的語言模型在回答事實問題時的成功率卻遠低於預期。

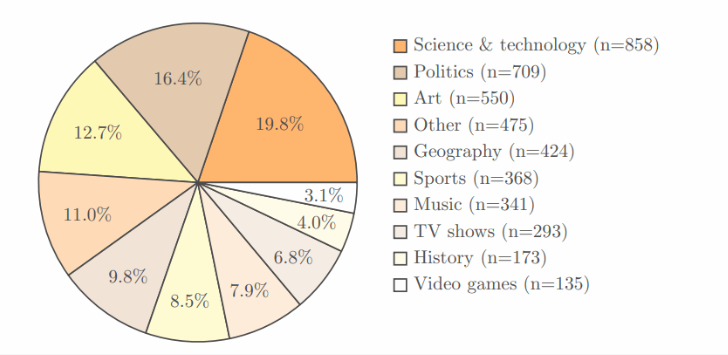

研究採用了OpenAI 自家的SimpleQA 基準測試,這個測試包含了4,326個,涵蓋了科學、政治和藝術等多個領域,每個問題都有一個明確的正確答案。

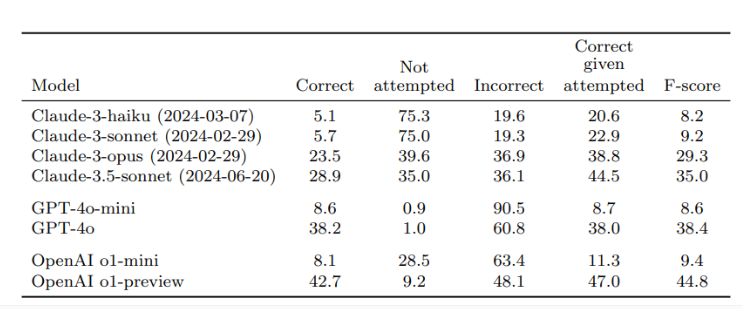

經過兩名獨立評審員的驗證,結果顯示,OpenAI 最好的模型o1-preview 的準確率僅為42.7%,而GPT-4o 則略低,只有38.2%。至於更小的GPT-4o-mini,準確率甚至只有8.6%。相比之下,Anthropic 的Claude 模型表現得更差,Claude-3.5-sonnet 的正確率僅為28.9%。

這項研究的關鍵在於測試的設計,不僅僅是為了測試AI 的表現,還為了讓大家認識到AI 模型在知識獲取方面的局限性。研究者強調,用戶在使用這些模型時,應該將其視為信息處理工具,而不是完全依賴的知識來源。為了獲得更準確的回答,最好能為AI 提供可靠的數據,而不是單純依賴其內置的知識。

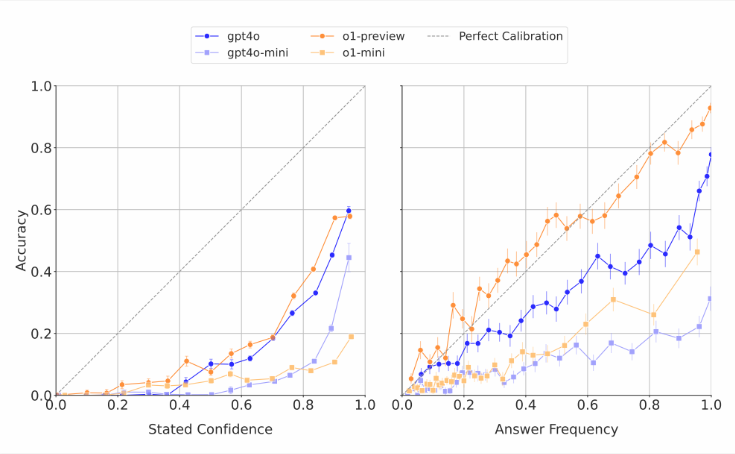

值得注意的是,AI 模型對自身能力的估計往往過於樂觀。研究人員發現,當這些模型被要求對自己的回答進行信心評分時,它們通常會給出誇大的準確性評分。在重複回答相同問題的測試中,即使模型多次給出相同答案,它們的實際成功率也仍低於其自我評估的準確性。這與外界對語言模型常常產生荒謬回答卻顯得信心滿滿的批評一致。

研究者認為,當前的AI 系統在事實準確性上存在明顯的缺口,亟需改進。同時,他們也提出了一個開放性問題:AI 在回答簡短事實問題的表現是否能預測其在處理更長、更複雜回答時的表現。為了支持更可靠的語言模型的開發,OpenAI 已經將SimpleQA 基準測試的資料公開發佈到Github 上。

劃重點:

OpenAI 的研究顯示,最先進的語言模型在回答事實問題時的成功率低,最高僅為42.7%。

這些AI 模型常常高估自己的能力,信心評分普遍誇大。

OpenAI 已將SimpleQA 基準公開,以幫助研究更可靠的語言模型。

這項研究提醒我們,儘管AI 技術取得了顯著進展,但在實際應用中仍需謹慎對待其局限性,並持續推動技術改進。