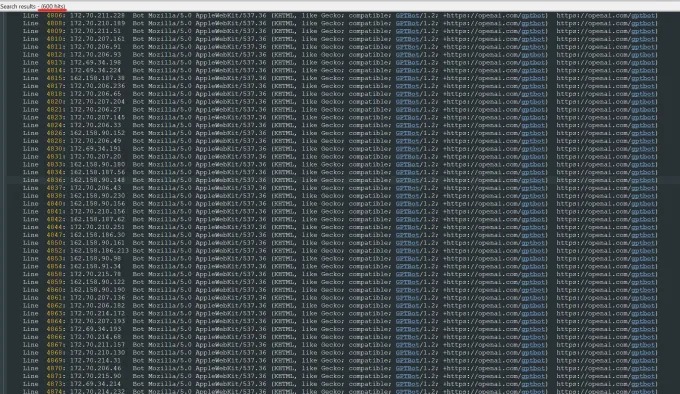

最近,Trilegangers 的首席執行官Oleksandr Tomchuk 收到了一條緊急警報,稱其公司的電子商務網站突然癱瘓。經過深入調查,他發現問題的根源在於OpenAI 的一個機器人,該機器人正在不懈地抓取其整個網站的內容。 Trilegangers 的網站擁有超過65,000 種產品,每種產品都配有詳細的頁面和至少三張圖片。 OpenAI 的機器人發送了數万個服務器請求,試圖下載所有內容,包括數十萬張圖片及其描述。

Tomchuk 指出,OpenAI 的爬蟲程序對網站造成了嚴重的影響,幾乎等同於一次分佈式拒絕服務(DDoS)攻擊。 Trilegangers 的主要業務是向3D 藝術家、視頻遊戲開發者以及其他需要數字重現真實人類特徵的用戶提供3D 對象文件和圖片。這些文件包括從手部到頭髮、皮膚乃至全身的詳細掃描數據。

Trilegangers 的網站是其業務的核心。該公司花費了十多年的時間,建立了網絡上最大的“人體數字替身”數據庫,這些數據均來自真實人體的3D 掃描。 Tomchuk 的團隊總部位於烏克蘭,但也在美國佛羅里達州的坦帕市獲得了許可。儘管網站上有一個明確禁止未經授權的機器人抓取的服務條款頁面,但這並未能有效阻止OpenAI 的機器人。

為了有效阻止機器人抓取,網站必須正確配置robot.txt 文件,該文件中的標籤可以明確告訴OpenAI 的GPTBot 不要訪問網站。 Robot.txt,也稱為機器人排除協議,旨在告知搜索引擎哪些內容不應被索引。 OpenAI 在其官方頁面上表示,當網站配置了禁止抓取的標籤時,它會尊重這些文件,但也警告說,其機器人可能需要長達24 小時才能識別更新後的robot.txt 文件。

Tomchuk 強調,如果網站沒有正確使用robot.txt,OpenAI 和其他公司可能會認為他們可以隨意抓取數據。這並不是一個可選的系統,而是保護網站內容的必要措施。更糟糕的是,Trilegangers 不僅在美國工作時間內被OpenAI 的機器人強制下線,Tomchuk 還預計,由於機器人的大量CPU 和下載活動,AWS 賬單將大幅增加。

然而,robot.txt 也並非萬全之策。 AI 公司是否遵守這一協議完全取決於它們的自願。去年夏天,另一家AI 初創公司Perplexity 因被指控未遵守robot.txt 協議而受到《Wired》的調查,這一事件引起了廣泛關注。

Tomchuk 表示,他無法找到聯繫OpenAI 並詢問此事的方式。 OpenAI 也未對TechCrunch 的置評請求作出回應。此外,OpenAI 至今未能提供其長期承諾的選擇退出工具,這使得問題更加複雜。

對於Trilegangers 來說,這是一個特別棘手的問題。 Tomchuk 指出,他們從事的業務涉及嚴重的權利問題,因為他們掃描的是真人。根據歐洲的GDPR 等法律,未經許可在網上使用真人照片是違法的。

諷刺的是,OpenAI 機器人的貪婪行為讓Trilegangers 意識到了其網站的脆弱性。 Tomchuk 表示,如果機器人以更溫和的方式抓取數據,他可能永遠不會察覺到這一問題。

“這很可怕,因為這些公司似乎利用了一個漏洞來抓取數據,他們說'如果你用我們的標籤更新你的robot.txt,你可以選擇退出',”Tomchuk 說道。然而,這實際上將責任推給了企業主,要求他們了解如何阻止這些機器人。

Tomchuk 希望其他小型在線企業能夠意識到,發現AI 機器人是否在竊取網站的版權資產的唯一方法就是主動尋找。他並不是唯一一個被AI 機器人困擾的人。其他網站的所有者也向《商業內幕》透露,OpenAI 的機器人如何破壞他們的網站並增加他們的AWS 費用。

到2024 年,這一問題預計將進一步惡化。數字廣告公司DoubleVerify 的最新研究發現,AI 爬蟲和抓取工具導致“一般無效流量”增加了86%,這些流量並非來自真實用戶,而是來自機器人的活動。