香港中文大學(深圳)與深圳大數據研究院的研究團隊近日推出了一款名為HuatuoGPT-o1的醫療大型語言模型(LLM),這一創新成果標誌著醫療AI領域在復雜推理方面邁出了重要一步。該模型專為醫療領域的複雜推理而設計,旨在提升醫療診斷和決策的準確性和可靠性。與以往側重於數學推理的LLM不同,HuatuoGPT-o1專注於醫療這一特殊領域,通過模擬醫生在實際工作中的嚴謹思考過程,為醫療AI的發展開闢了新的道路。

研究團隊在開發過程中面臨的主要挑戰是醫療領域的推理過程往往缺乏明確的步驟,難以驗證。為了解決這一難題,他們從醫療考試題庫中精選出4萬道具有唯一、客觀正確答案的難題,並將其轉化為開放式問題,構建了一個可驗證的醫療問題集。這些問題不僅需要模型進行深入的推理,還能通過答案的對錯來驗證推理過程的正確性,從而為模型的訓練提供了可靠的數據支持。

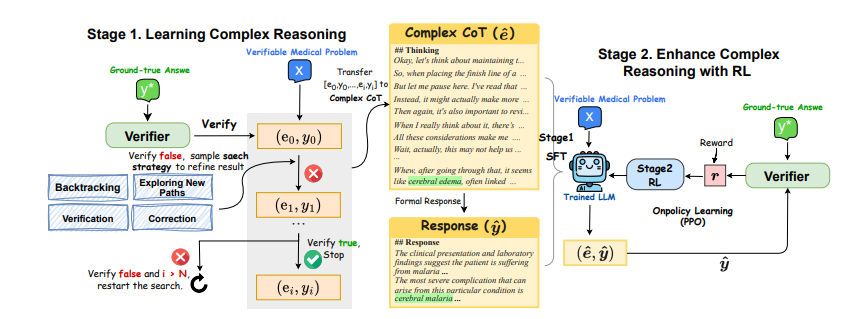

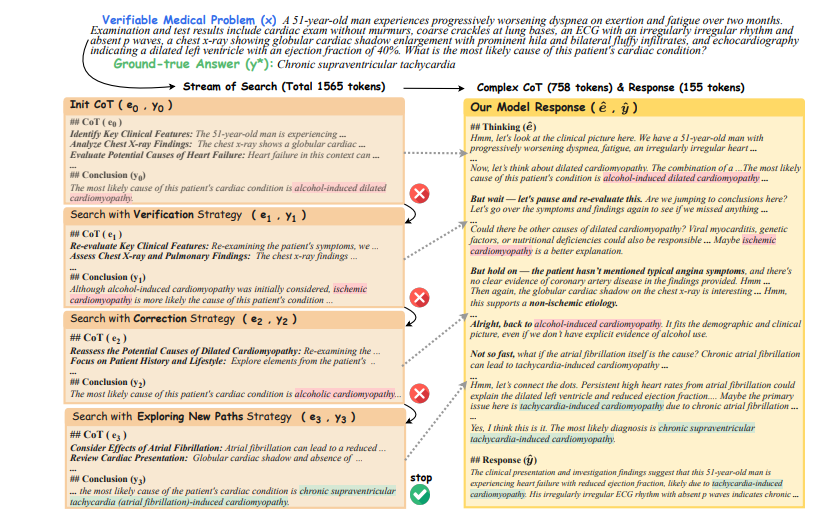

為了提升模型的推理能力,研究團隊採用了一種兩階段訓練方法。在第一階段,他們利用驗證器的反饋(正確或錯誤)來引導模型進行基於策略的搜索,生成複雜的推理軌跡。模型首先初始化一個思維鏈(CoT),如果驗證器認為當前的CoT不正確,模型會嘗試回溯、探索新路徑、驗證或糾正等策略,直到找到正確的答案。這些成功的推理軌跡隨後被用來微調LLM,使其具備迭代反思的複雜推理能力。在第二階段,研究團隊利用驗證器提供的稀疏獎勵,通過強化學習(RL)算法進一步提升模型的複雜推理能力。

實驗結果表明,這種兩階段訓練方法取得了顯著的效果。僅使用4萬個可驗證的問題,一個80億參數的模型在醫療基準測試中取得了8.5分的提升。而一個700億參數的模型在多個醫療基準測試中,也超越了其他開源的通用和醫療專用LLM。這些結果不僅證實了複雜推理對解決醫療問題的有效性,也展示了強化學習在提升模型性能方面的顯著作用。

HuatuoGPT-o1的創新之處在於它首次使用可驗證的醫療問題和醫療驗證器來提升LLM的醫療複雜推理能力。通過這種方法,模型能夠像醫生一樣進行深入思考,並在給出答案前進行自我檢查和修正。這不僅提高了模型在醫療領域的應用潛力,也為其他專業領域的推理能力提升提供了借鑒。

為了進一步驗證模型的可靠性,研究人員使用GPT-4o作為驗證器,結果顯示其在第一階段的準確率達到96.5%,在第二階段的準確率達到94.5%。同時,他們也證實了基於LLM的驗證器比傳統的精確匹配方法更可靠。此外,研究人員還將該方法應用到中文醫療領域,同樣取得了顯著的成果,證明了該方法在不同領域和語言環境下的適應性。

總體而言,HuatuoGPT-o1的出現標誌著醫療AI在復雜推理方面取得了重大進展。它不僅為醫療診斷和決策提供了更可靠的工具,也為未來AI在其他專業領域的應用提供了新的思路。儘管該模型目前仍處於研究階段,不能直接應用於臨床,但其巨大的潛力已引起了廣泛關注,未來有望在醫療領域發揮更大的作用。

論文地址:https://arxiv.org/pdf/2412.18925