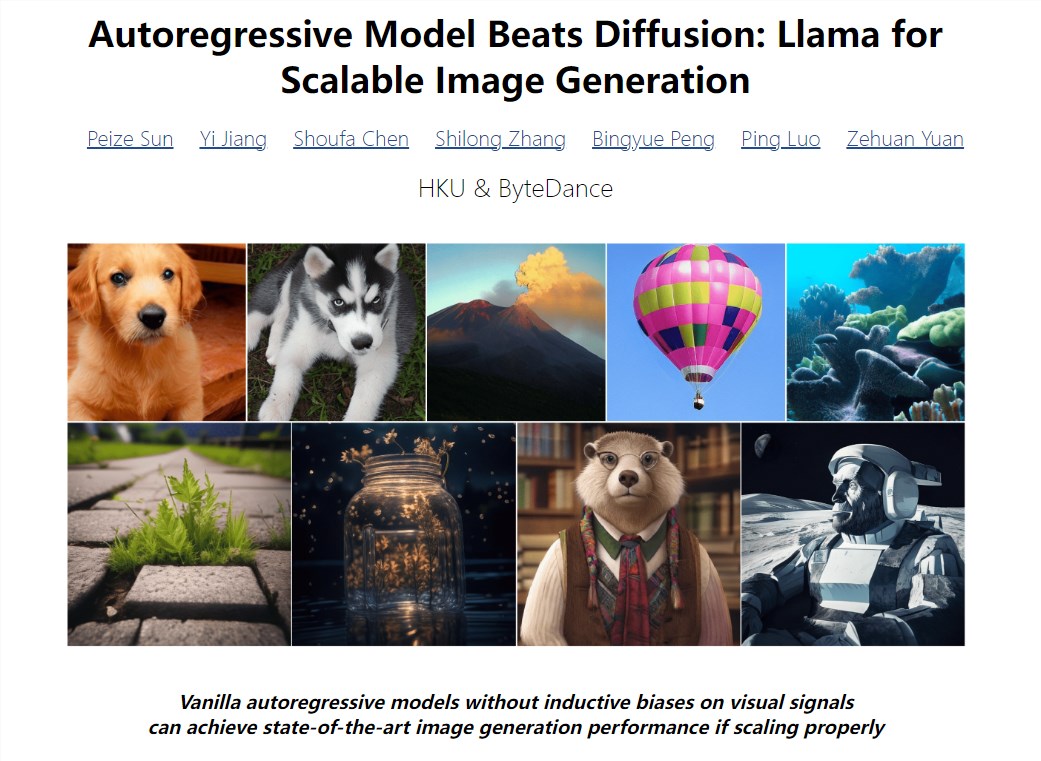

LlamaGen,这款由港大与字节跳动联合研发的自回归图像生成模型,正在掀起一场图像生成领域的革命。作为基于Llama架构的创新之作,它不仅在技术上突破了传统扩散模型的局限,更在开源社区引发了热烈反响,GitHub上的近900颗星标就是最好的证明。

在ImageNet测试基准上,LlamaGen以卓越的性能超越了LDM、DiT等主流扩散模型,这一突破性成果源自研究团队对自回归模型架构的深度优化。通过重新训练Image Tokenizer,LlamaGen在ImageNet和COCO数据集上取得了显著优势,其表现甚至超越了VQGAN、ViT-VQGAN和MaskGI等知名模型。

LlamaGen的成功建立在三大核心技术支柱之上:先进的图像压缩/量化器、可扩展的图像生成模型,以及精心筛选的高质量训练数据。研究团队采用了与VQ-GAN相似的CNN架构,将连续图像转化为离散Token,通过两阶段训练策略,显著提升了图像的视觉质量和分辨率。

在第一阶段训练中,LlamaGen在LAION-COCO的50M子集上进行训练,图像分辨率为256×256。研究团队通过严格的筛选标准,包括有效图像URL、美学分数、水印分数等,确保了训练数据的质量。第二阶段则在1千万规模的内部高美学质量图像上进行微调,将图像分辨率提升至512×512,进一步优化了生成效果。

LlamaGen的核心优势在于其卓越的Image Tokenizer和Llama架构的扩展性。在实际生成测试中,LlamaGen在FID、IS、Precision和Recall等关键指标上展现出了强劲的竞争力。与之前的自回归模型相比,LlamaGen在各个参数量级上都表现优异,为图像生成领域树立了新的标杆。

尽管LlamaGen已经取得了显著成果,但研究团队表示,这仅仅是Stable Diffusion v1阶段的开始。未来的发展方向将包括支持更高分辨率、更多长宽比、更强的可控性,以及视频生成等新领域。这些规划预示着LlamaGen将在更广阔的领域继续引领图像生成技术的创新。

目前,LlamaGen已经开放在线体验,用户可以通过Hugging Face上的LlamaGen空间亲自感受这一革命性技术。同时,LlamaGen的开源发布也为全球开发者和研究者提供了参与和贡献的平台,共同推动图像生成技术的进步。项目地址和在线体验地址分别为:https://top.aibase.com/tool/llamagen 和 https://huggingface.co/spaces/FoundationVision/LlamaGen。