خريطة الطريق / حالة المشروع / البيان / ggml

استنتاج نموذج LLaMA الخاص بـ Meta (وغيره) بلغة C/C++ النقية

سجل التغيير لواجهة برمجة تطبيقات libllama

سجل التغيير لواجهة برمجة تطبيقات REST llama-server

نقدم لكم GGUF-my-LoRA #10123

تدعم نقاط نهاية استدلال الوجه المعانقة الآن GGUF خارج الصندوق! #9669

معانقة محرر GGUF الوجه: مناقشة | أداة

الهدف الرئيسي من llama.cpp هو تمكين استدلال LLM مع الحد الأدنى من الإعداد والأداء المتطور على مجموعة واسعة من الأجهزة - محليًا وفي السحابة.

تنفيذ C/C++ عادي دون أي تبعيات

تُعد Apple silicon مواطنًا من الدرجة الأولى - تم تحسينها عبر أطر ARM NEON وAccelerate وMetal

دعم AVX وAVX2 وAVX512 وAMX لبنيات x86

تقدير عدد صحيح 1.5 بت، 2 بت، 3 بت، 4 بت، 5 بت، 6 بت، و8 بت لاستدلال أسرع وتقليل استخدام الذاكرة

نواة CUDA مخصصة لتشغيل LLMs على وحدات معالجة الرسومات NVIDIA (دعم وحدات معالجة الرسومات AMD عبر وحدات معالجة الرسوميات HIP وMoore Threads MTT عبر MUSA)

دعم الواجهة الخلفية Vulkan وSYCL

الاستدلال المختلط لوحدة المعالجة المركزية + وحدة معالجة الرسومات لتسريع النماذج الأكبر من إجمالي سعة VRAM جزئيًا

منذ بدايته، تحسن المشروع بشكل ملحوظ بفضل المساهمات العديدة. إنه الملعب الرئيسي لتطوير ميزات جديدة لمكتبة ggml.

النماذج المدعومة:

عادةً ما يتم دعم الإعدادات الدقيقة للنماذج الأساسية أدناه أيضًا.

لاما ؟

لاما 2؟؟

لاما 3 ؟؟؟

ميسترال 7 ب

ميكسترال مو

دي بي آر إكس

فالكون

اللاما الصيني/ الألبكة و اللاما الصيني-2/ الألبكة-2

فيجوني (الفرنسية)

بيرت

كوالا

بايتشوان 1 و 2 + الاشتقاقات

أكويلا 1 و 2

نماذج ستاركودر

ريفيكت

MPT

يزدهر

نماذج يي

نماذج مستقرةLM

نماذج ديب سيك

نماذج كوين

بي لامو-13ب

نماذج فاي

جي بي تي-2

أوريون 14 ب

إنترلم2

كودشيل

جيما

مامبا

جروك-1

اكسفيرس

نماذج الأوامر-R

أسد البحر

حصىLM-7B + حصىLM-8x7B

أولمو

أولموي

نماذج الجرانيت

جي بي تي-نيوكس + بيثيا

ندفة الثلج-القطب الشمالي وزارة البيئة

سموغ

بورو 34 ب

نماذج بيت نت b1.58

فلان T5

نماذج مفتوحة الدردار

الدردشةGLM3-6b + الدردشةGLM4-9b

سموللم

EXAONE-3.0-7.8B-إرشاد

نماذج فالكون مامبا

جيس

بيليك-11B-v2.3

آر دبليو كيه في-6

(تعليمات لدعم المزيد من النماذج: HOWTO-add-model.md)

نماذج متعددة الوسائط:

نماذج LLaVA 1.5، نماذج LLaVA 1.6

باكلافا

سبج

مشاركةGPT4V

نماذج MobileVLM 1.7B/3B

يي-VL

التكلفة البسيطة لكل ألف ظهور

حلم القمر

الأرنب

الارتباطات:

بايثون: abetlen/llama-cpp-python

اذهب: go-skynet/go-llama.cpp

Node.js: withcatai/node-llama-cpp

JS/TS (عميل خادم llama.cpp): lgrammel/modelfusion

JS/TS (محرك سطر الأوامر للمحرك السريع القابل للبرمجة): غير متصل بالإنترنت-ai/cli

JavaScript/Wasm (يعمل في المتصفح): tangledgroup/llama-cpp-wasm

Typescript/Wasm (واجهة برمجة تطبيقات أجمل، متاحة على npm): ngxson/wllama

روبي: yoshoku/llama_cpp.rb

الصدأ (مزيد من الميزات): edgenai/llama_cpp-rs

الصدأ (واجهة برمجة التطبيقات الأجمل): mdrokz/rust-llama.cpp

الصدأ (المزيد من الارتباطات المباشرة): Utilityai/llama-cpp-rs

C#/.NET: SciSharp/LLamaSharp

C#/VB.NET (مزيد من الميزات - ترخيص المجتمع): LM-Kit.NET

سكالا 3: دونديروم/llm4s

Clojure: phronmophobic/llama.clj

الرد الأصلي: mybigday/llama.rn

جافا: kherud/java-llama.cpp

منعرج: deins/llama.cpp.zig

الرفرفة/السهم: netdur/llama_cpp_dart

PHP (روابط API والميزات المبنية على أعلى llama.cpp): distancemagic/resonance (مزيد من المعلومات)

مخطط المكر: guile_llama_cpp

سويفت srgtuszy/llama-cpp-swift

سويفت شينغهاي وانغ / سويفت لاما

واجهة المستخدم:

ما لم يُذكر خلاف ذلك، فإن هذه المشاريع مفتوحة المصدر بترخيص متساهل:

MindWorkAI/AI-Studio (FSL-1.1-MIT)

iohub/colama

جانهق/جان (AGPL)

نات/openplayground

فاراداي (ملكية)

LMStudio (ملكية خاصة)

ليلى (ملكية)

رامالاما (MIT)

الذكاء الاصطناعي المحلي (MIT)

لوست روينز/كوبولدكب (AGPL)

موزيلا-أوتشو/llamafile

nom-ai/gpt4all

أولاما / أولاما

oobabooga/text-generation-webui (AGPL)

psugihara/FreeChat

كزتومسيك/آفا (MIT)

ptsochantaris/emeltal

بيثوب/تينيري (AGPL)

سطح المكتب RAGNA (ملكية خاصة)

RecurseChat (ملكية)

semperai/أميكا

مع كاتاي/كاتاي

الذكاء الاصطناعي المتنقل/الخادمة (MIT)

مستي (ملكية)

إل إم فارم (MIT)

KanTV (Apachev2.0 أو الأحدث)

نقطة (جي بي إل)

مايند ماك (الملكية)

كودي بوت (GPL)

إيفا (معهد ماساتشوستس للتكنولوجيا)

البرنامج المساعد AI Sublime Text (MIT)

أيكيت (معهد ماساتشوستس للتكنولوجيا)

LARS - ماجستير إدارة الأعمال والحلول المرجعية المتقدمة (AGPL)

LLMUnity (MIT)

مساعد اللاما (GPL)

PocketPal AI - تطبيق iOS وAndroid (MIT)

(لكي يكون المشروع مدرجًا هنا، يجب أن يذكر بوضوح أنه يعتمد على llama.cpp )

أدوات:

akx/ggify – تنزيل نماذج PyTorch من HuggingFace Hub وتحويلها إلى GGML

akx/ollama-dl – تنزيل النماذج من مكتبة Ollama لاستخدامها مباشرة مع llama.cpp

Crashr/gppm – تشغيل مثيلات llama.cpp باستخدام وحدات معالجة الرسوميات NVIDIA Tesla P40 أو P100 مع انخفاض استهلاك الطاقة الخاملة

gpustack/gguf-parser - قم بمراجعة/فحص ملف GGUF وتقدير استخدام الذاكرة

Styled Lines (جزء الاستدلال المرخَّص وغير المتزامن لتطوير اللعبة في Unity3d مع أغلفة النظام الأساسي للجوال والويب التي تم إنشاؤها مسبقًا ومثال نموذجي)

بنية تحتية:

Paddler - موازن تحميل مميز مصمم خصيصًا لـ llama.cpp

GPUStack - إدارة مجموعات GPU لتشغيل LLMs

llama_cpp_canister - llama.cpp كعقد ذكي على الكمبيوتر عبر الإنترنت باستخدام WebAssembly

ألعاب:

Lucy's Labyrinth - لعبة متاهة بسيطة حيث سيحاول العملاء الذين يتحكم بهم نموذج الذكاء الاصطناعي خداعك.

$ make -j && ./llama-cli -m models/llama-13b-v2/ggml-model-q4_0.gguf -p "Building a website can be done in 10 simple steps:nStep 1:" -n 400 -e I llama.cpp build info: I UNAME_S: Darwin I UNAME_P: arm I UNAME_M: arm64 I CFLAGS: -I. -O3 -std=c11 -fPIC -DNDEBUG -Wall -Wextra -Wpedantic -Wcast-qual -Wdouble-promotion -Wshadow -Wstrict-prototypes -Wpointer-arith -Wmissing-prototypes -pthread -DGGML_USE_K_QUANTS -DGGML_USE_ACCELERATE I CXXFLAGS: -I. -I./common -O3 -std=c++11 -fPIC -DNDEBUG -Wall -Wextra -Wpedantic -Wcast-qual -Wno-unused-function -Wno-multichar -pthread -DGGML_USE_K_QUANTS I LDFLAGS: -framework Accelerate I CC: Apple clang version 14.0.3 (clang-1403.0.22.14.1) I CXX: Apple clang version 14.0.3 (clang-1403.0.22.14.1) make: Nothing to be done for `default'. main: build = 1041 (cf658ad) main: seed = 1692823051 llama_model_loader: loaded meta data with 16 key-value pairs and 363 tensors from models/llama-13b-v2/ggml-model-q4_0.gguf (version GGUF V1 (latest)) llama_model_loader: - type f32: 81 tensors llama_model_loader: - type q4_0: 281 tensors llama_model_loader: - type q6_K: 1 tensors llm_load_print_meta: format = GGUF V1 (latest) llm_load_print_meta: arch = llama llm_load_print_meta: vocab type = SPM llm_load_print_meta: n_vocab = 32000 llm_load_print_meta: n_merges = 0 llm_load_print_meta: n_ctx_train = 4096 llm_load_print_meta: n_ctx = 512 llm_load_print_meta: n_embd = 5120 llm_load_print_meta: n_head = 40 llm_load_print_meta: n_head_kv = 40 llm_load_print_meta: n_layer = 40 llm_load_print_meta: n_rot = 128 llm_load_print_meta: n_gqa = 1 llm_load_print_meta: f_norm_eps = 1.0e-05 llm_load_print_meta: f_norm_rms_eps = 1.0e-05 llm_load_print_meta: n_ff = 13824 llm_load_print_meta: freq_base = 10000.0 llm_load_print_meta: freq_scale = 1 llm_load_print_meta: model type = 13B llm_load_print_meta: model ftype = mostly Q4_0 llm_load_print_meta: model size = 13.02 B llm_load_print_meta: general.name = LLaMA v2 llm_load_print_meta: BOS token = 1 '<s>' llm_load_print_meta: EOS token = 2 '</s>' llm_load_print_meta: UNK token = 0 '<unk>' llm_load_print_meta: LF token = 13 '<0x0A>' llm_load_tensors: ggml ctx size = 0.11 MB llm_load_tensors: mem required = 7024.01 MB (+ 400.00 MB per state) ................................................................................................... llama_new_context_with_model: kv self size = 400.00 MB llama_new_context_with_model: compute buffer total size = 75.41 MB system_info: n_threads = 16 / 24 | AVX = 0 | AVX2 = 0 | AVX512 = 0 | AVX512_VBMI = 0 | AVX512_VNNI = 0 | FMA = 0 | NEON = 1 | ARM_FMA = 1 | F16C = 0 | FP16_VA = 1 | WASM_SIMD = 0 | BLAS = 1 | SSE3 = 0 | VSX = 0 | sampling: repeat_last_n = 64, repeat_penalty = 1.100000, presence_penalty = 0.000000, frequency_penalty = 0.000000, top_k = 40, tfs_z = 1.000000, top_p = 0.950000, typical_p = 1.000000, temp = 0.800000, mirostat = 0, mirostat_lr = 0.100000, mirostat_ent = 5.000000 generate: n_ctx = 512, n_batch = 512, n_predict = 400, n_keep = 0 Building a website can be done in 10 simple steps: Step 1: Find the right website platform. Step 2: Choose your domain name and hosting plan. Step 3: Design your website layout. Step 4: Write your website content and add images. Step 5: Install security features to protect your site from hackers or spammers Step 6: Test your website on multiple browsers, mobile devices, operating systems etc… Step 7: Test it again with people who are not related to you personally – friends or family members will work just fine! Step 8: Start marketing and promoting the website via social media channels or paid ads Step 9: Analyze how many visitors have come to your site so far, what type of people visit more often than others (e.g., men vs women) etc… Step 10: Continue to improve upon all aspects mentioned above by following trends in web design and staying up-to-date on new technologies that can enhance user experience even further! How does a Website Work? A website works by having pages, which are made of HTML code. This code tells your computer how to display the content on each page you visit – whether it’s an image or text file (like PDFs). In order for someone else’s browser not only be able but also want those same results when accessing any given URL; some additional steps need taken by way of programming scripts that will add functionality such as making links clickable! The most common type is called static HTML pages because they remain unchanged over time unless modified manually (either through editing files directly or using an interface such as WordPress). They are usually served up via HTTP protocols – this means anyone can access them without having any special privileges like being part of a group who is allowed into restricted areas online; however, there may still exist some limitations depending upon where one lives geographically speaking. How to llama_print_timings: load time = 576.45 ms llama_print_timings: sample time = 283.10 ms / 400 runs ( 0.71 ms per token, 1412.91 tokens per second) llama_print_timings: prompt eval time = 599.83 ms / 19 tokens ( 31.57 ms per token, 31.68 tokens per second) llama_print_timings: eval time = 24513.59 ms / 399 runs ( 61.44 ms per token, 16.28 tokens per second) llama_print_timings: total time = 25431.49 ms

وإليك عرض توضيحي آخر لتشغيل كل من LLaMA-7B وwhisper.cpp على جهاز M1 Pro MacBook واحد:

فيما يلي خطوات البناء الثنائي الشامل وتحويل النماذج لمعظم النماذج المدعومة.

أولا، تحتاج إلى الحصول على الثنائي. هناك طرق مختلفة يمكنك اتباعها:

الطريقة الأولى: استنساخ هذا المستودع والبناء محليًا، راجع كيفية الإنشاء

الطريقة الثانية: إذا كنت تستخدم MacOS أو Linux، فيمكنك تثبيت llama.cpp عبر Brew أو Flox أو Nix

الطريقة الثالثة: استخدام صورة Docker، راجع الوثائق الخاصة بـ Docker

الطريقة الرابعة: تنزيل الملفات الثنائية المعدة مسبقًا من الإصدارات

يمكنك تشغيل الإكمال الأساسي باستخدام هذا الأمر:

llama-cli -m your_model.gguf -p "أعتقد أن معنى الحياة هو" -n 128# الإخراج:# أعتقد أن معنى الحياة هو العثور على الحقيقة الخاصة بك والعيش وفقًا لها. بالنسبة لي، هذا يعني أن أكون صادقًا مع نفسي وأن أتبع عواطفي، حتى لو كانت لا تتوافق مع التوقعات المجتمعية. أعتقد أن هذا ما أحبه في اليوغا، فهي ليست مجرد ممارسة بدنية، ولكنها ممارسة روحية أيضًا. يتعلق الأمر بالتواصل مع نفسك، والاستماع إلى صوتك الداخلي، وتكريم رحلتك الفريدة.

راجع هذه الصفحة للحصول على قائمة كاملة بالمعلمات.

إذا كنت تريد تجربة أكثر شبهاً بـ ChatGPT، فيمكنك التشغيل في وضع المحادثة عن طريق تمرير -cnv كمعلمة:

llama-cli -m your_model.gguf -p "أنت مساعد مفيد" -cnv# الإخراج:# > مرحبًا، من أنت؟# مرحبًا هناك! أنا مساعدك المفيد! أنا روبوت دردشة مدعوم بالذكاء الاصطناعي مصمم لمساعدة المستخدمين مثلك وتوفير المعلومات لهم. أنا هنا للمساعدة في الإجابة على أسئلتك وتقديم التوجيه والدعم في مجموعة واسعة من المواضيع. أنا ذكاء اصطناعي ودود وواسع المعرفة، ويسعدني دائمًا تقديم المساعدة في أي شيء تحتاجه. ما الذي يدور في ذهنك، وكيف يمكنني مساعدتك اليوم؟## > ما هو 1+1؟# سهل للغاية! اجابة 1+1 هي...2!

افتراضيًا، سيتم أخذ قالب الدردشة من نموذج الإدخال. إذا كنت تريد استخدام قالب دردشة آخر، فقم بتمرير --chat-template NAME كمعلمة. راجع قائمة القوالب المدعومة

./llama-cli -m your_model.gguf -p "أنت مساعد مفيد" -cnv --chat-template chatml

يمكنك أيضًا استخدام القالب الخاص بك عبر معلمات البادئة واللاحقة والموجه العكسي:

./llama-cli -m your_model.gguf -p "أنت مساعد مفيد" -cnv --in-prefix 'User: ' --reverse-prompt 'User:'

خادم الويب llama.cpp هو خادم HTTP خفيف الوزن ومتوافق مع OpenAI API ويمكن استخدامه لخدمة النماذج المحلية وتوصيلها بسهولة بالعملاء الحاليين.

مثال على الاستخدام:

./llama-server -m your_model.gguf --port 8080# يمكن الوصول إلى واجهة مستخدم الويب الأساسية عبر المتصفح: http://localhost:8080# نقطة نهاية إكمال الدردشة: http://localhost:8080/v1/chat/completions

ملحوظة

إذا كنت تفضل الاستخدام الأساسي، فيرجى التفكير في استخدام وضع المحادثة بدلاً من الوضع التفاعلي

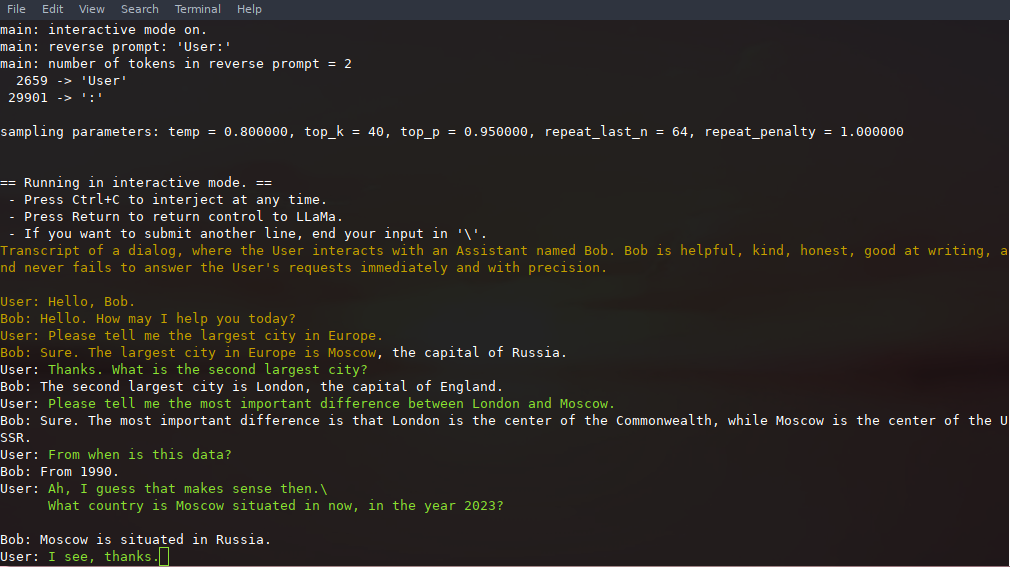

في هذا الوضع، يمكنك دائمًا مقاطعة عملية الإنشاء بالضغط على Ctrl+C وإدخال سطر واحد أو أكثر من النص، والذي سيتم تحويله إلى رموز مميزة وإلحاقه بالسياق الحالي. يمكنك أيضًا تحديد موجه عكسي باستخدام المعلمة -r "reverse prompt string" . سيؤدي هذا إلى مطالبة المستخدم بإدخال الرموز المميزة الدقيقة لسلسلة المطالبة العكسية أثناء عملية الإنشاء. الاستخدام النموذجي هو استخدام موجه يجعل LLaMA يحاكي محادثة بين عدة مستخدمين، مثل Alice وBob، وتمرير -r "Alice:" .

فيما يلي مثال على تفاعل بضع طلقات، تم استدعاؤه باستخدام الأمر

# الوسائط الافتراضية باستخدام نموذج 7B./examples/chat.sh# الدردشة المتقدمة مع نموذج 13B./examples/chat-13B.sh# الوسائط المخصصة باستخدام نموذج 13B./llama-cli -m ./models/13B/ ggml-model-q4_0.gguf -n 256 --repeat_penalty 1.0 --color -i -r "المستخدم:" -f المطالبات/الدردشة مع bob.txt

لاحظ استخدام --color للتمييز بين إدخال المستخدم والنص الذي تم إنشاؤه. يتم شرح المعلمات الأخرى بمزيد من التفصيل في الملف التمهيدي لبرنامج مثال llama-cli .

يمكن حفظ الموجه ومدخلات المستخدم وأجيال النماذج واستئنافها عبر الاستدعاءات إلى ./llama-cli من خلال الاستفادة من --prompt-cache و --prompt-cache-all . يوضح البرنامج النصي ./examples/chat-persistent.sh ذلك من خلال دعم جلسات الدردشة الطويلة الأمد والقابلة للاستئناف. لاستخدام هذا المثال، يجب عليك توفير ملف للتخزين المؤقت لموجه الدردشة الأولي ودليل لحفظ جلسة الدردشة، ويمكنك اختياريًا توفير نفس المتغيرات مثل chat-13B.sh . يمكن إعادة استخدام نفس ذاكرة التخزين المؤقت السريعة لجلسات الدردشة الجديدة. لاحظ أن كلا من ذاكرة التخزين المؤقت ودليل الدردشة مرتبطان بالموجه الأولي ( PROMPT_TEMPLATE ) وملف النموذج.

# ابدأ دردشة جديدةPROMPT_CACHE_FILE=chat.prompt.bin CHAT_SAVE_DIR=./chat/default ./examples/chat-persistent.sh# استأنف chatPROMPT_CACHE_FILE=chat.prompt.bin CHAT_SAVE_DIR=./chat/default ./examples/chat- استمرار.sh# ابدأ محادثة مختلفة معه نفس المطالبة/modelPROMPT_CACHE_FILE=chat.prompt.bin CHAT_SAVE_DIR=./chat/another ./examples/chat-persistent.sh# ذاكرة تخزين مؤقت مختلفة للمطالبة/modelPROMPT_TEMPLATE=./prompts/chat-with-bob.txt PROMPT_CACHE_FILE= بوب.مطالبة.بن

CHAT_SAVE_DIR=./chat/bob ./examples/chat-persistent.sh يدعم llama.cpp القواعد النحوية لتقييد مخرجات النموذج. على سبيل المثال، يمكنك إجبار النموذج على إخراج JSON فقط:

./llama-cli -m ./models/13B/ggml-model-q4_0.gguf -n 256 --grammar-file grammars/json.gbnf -p 'الطلب: جدولة مكالمة في الساعة 8 مساءً؛ يأمر:'

يحتوي المجلد grammars/ على عدد قليل من نماذج القواعد النحوية. لكتابة كتابك الخاص، راجع دليل GBNF.

لتأليف قواعد نحوية أكثر تعقيدًا لـ JSON، يمكنك أيضًا الاطلاع على https://grammar.intrinsiclabs.ai/، وهو تطبيق متصفح يتيح لك كتابة واجهات TypeScript التي يجمعها إلى قواعد نحوية GBNF والتي يمكنك حفظها للاستخدام المحلي. لاحظ أن التطبيق تم إنشاؤه وصيانته من قبل أعضاء المجتمع، يرجى تقديم أي مشكلات أو تقارير مالية في الريبو الخاص به وليس هذه.

يرجى الرجوع إلى إنشاء llama.cpp محليًا

| الخلفية | الأجهزة المستهدفة |

|---|---|

| معدن | أبل السيليكون |

| بلاس | الجميع |

| بليس | الجميع |

| سيكل | إنتل ونفيديا GPU |

| موسى | مور المواضيع MTT GPU |

| كودا | نفيديا GPU |

| hipBLAS | معالج رسوميات AMD |

| فولكان | GPU |

| القنا | يصعد NPU |

ملحوظة

يمكنك استخدام مساحة GGUF-my-repo على Hugging Face لتحديد أوزان النموذج الخاص بك دون أي إعداد أيضًا. تتم مزامنته من llama.cpp main كل 6 ساعات.

للحصول على أوزان LLaMA 2 الرسمية، يرجى مراجعة قسم الحصول على نموذج LLaMA 2 واستخدامه على Facebook. هناك أيضًا مجموعة كبيرة من نماذج gguf المحددة مسبقًا والمتوفرة على Hugging Face.

ملاحظة: تم نقل convert.py إلى examples/convert_legacy_llama.py ولا ينبغي استخدامه لأي شيء آخر غير نماذج Llama/Llama2/Mistral ومشتقاتها. إنه لا يدعم LLaMA 3، يمكنك استخدام convert_hf_to_gguf.py مع LLaMA 3 الذي تم تنزيله من Hugging Face.

لمعرفة المزيد حول نموذج القياس الكمي، اقرأ هذه الوثائق

يمكنك استخدام مثال perplexity لقياس الحيرة على موجه معين (الحيرة الأقل أفضل). لمزيد من المعلومات، راجع https://huggingface.co/docs/transformers/perplexity.

لمعرفة المزيد عن كيفية قياس الحيرة باستخدام llama.cpp، اقرأ هذه الوثائق

يمكن للمساهمين فتح العلاقات العامة

يمكن للمتعاونين الدفع إلى الفروع في llama.cpp repo ودمج العلاقات العامة في الفرع master

سيتم دعوة المتعاونين على أساس المساهمات

أي مساعدة في إدارة القضايا والعلاقات العامة والمشاريع موضع تقدير كبير!

راجع الإصدارات الأولى الجيدة للمهام المناسبة للمساهمات الأولى

اقرأ CONTRIBUTING.md لمزيد من المعلومات

تأكد من قراءة هذا: الاستدلال على الحافة

القليل من الخلفية الدرامية لأولئك المهتمين: Changelog podcast

الرئيسي (كلي)

الخادم

خطر

قواعد GBNF

وثائق التطوير

كيفية البناء

يعمل على دوكر

البناء على أندرويد

استكشاف أخطاء الأداء وإصلاحها

نصائح وحيل GGML

أوراق أساسية وخلفية عن النماذج

إذا كانت مشكلتك تتعلق بجودة إنشاء النموذج، فيرجى على الأقل مسح الروابط والأوراق التالية لفهم القيود المفروضة على نماذج LLaMA. وهذا مهم بشكل خاص عند اختيار حجم النموذج المناسب وتقدير الاختلافات الكبيرة والدقيقة بين نماذج LLaMA وChatGPT:

لاما:

تقديم LLaMA: نموذج لغة أساسي كبير يضم 65 مليار معلمة

LLaMA: نماذج لغة أساسية مفتوحة وفعالة

جي بي تي-3

نماذج اللغة هي عدد قليل من المتعلمين

GPT-3.5 / InstructGPT / ChatGPT:

محاذاة نماذج اللغة لاتباع التعليمات

تدريب النماذج اللغوية على اتباع التعليمات مع ردود الفعل البشرية