انضم إلى مجموعة مستخدمي WeChat أو NPU الخاصة بنا.

[ إنجليزي | 中文]

يمكن أن يكون الضبط الدقيق لنموذج لغة كبير أمرًا سهلاً كما...

اختر طريقك:

كولاب : https://colab.research.google.com/drive/1eRTPn37ltBbYsISy9Aw2NuI2Aq5CQrD9?usp=sharing

PAI-DSW : مثال Llama3 | مثال Qwen2-VL

الجهاز المحلي : يرجى الرجوع إلى الاستخدام

التوثيق (WIP) : https://llamafactory.readthedocs.io/zh-cn/latest/

الأنشطة الأخيرة:

2024/10/18-2024/11/30 : قم ببناء روبوت مرشد سياحي شخصي باستخدام PAI+LLaMA Factory. [موقع إلكتروني]

ملحوظة

باستثناء الروابط المذكورة أعلاه، فإن جميع مواقع الويب الأخرى هي مواقع ويب غير مصرح بها لأطراف ثالثة. يرجى استخدامها بعناية.

سمات

المعيار

سجل التغيير

النماذج المدعومة

مناهج التدريب المدعومة

مجموعات البيانات المقدمة

متطلبات

ابدء

المشاريع باستخدام مصنع LLaMA

رخصة

الاقتباس

شكر وتقدير

نماذج مختلفة : LLaMA، LLaVA، Mistral، Mixtral-MoE، Qwen، Qwen2-VL، Yi، Gemma، Baichuan، ChatGLM، Phi، إلخ.

الأساليب المتكاملة : التدريب المسبق (المستمر)، والضبط الدقيق (متعدد الوسائط)، ونمذجة المكافآت، وPPO، وDPO، وKTO، وORPO، وما إلى ذلك.

موارد قابلة للتطوير : ضبط كامل 16 بت، وضبط التجميد، وLoRA و2/3/4/5/6/8 بت QLoRA عبر AQLM/AWQ/GPTQ/LLM.int8/HQQ/EETQ.

الخوارزميات المتقدمة : GaLore، وBAdam، وAdam-mini، وDoRA، وLongLoRA، وLLaMA Pro، وMixture-of-Depths، وLoRA+، وLoftQ، وPiSSA، وAgent tuning.

الحيل العملية : FlashAttention-2، وUnsloth، وLiger Kernel، وRoPE Scaling، وNEFTune، وrsLoRA.

مراقبي التجارب : LlamaBoard، TensorBoard، Wandb، MLflow، إلخ.

استنتاج أسرع : واجهة برمجة التطبيقات (API) بنمط OpenAI وGradio UI وCLI مع عامل vLLM.

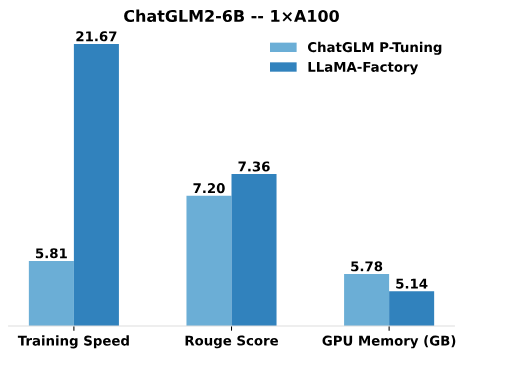

بالمقارنة مع P-Tuning الخاص بـ ChatGLM، يوفر ضبط LoRA الخاص بـ LLaMA Factory سرعة تدريب أسرع بما يصل إلى 3.7 مرات مع درجة Rouge أفضل في مهمة إنشاء النص الإعلاني. من خلال الاستفادة من تقنية التكميم 4 بت، تعمل تقنية QLoRA الخاصة بمصنع LLaMA على تحسين الكفاءة فيما يتعلق بذاكرة وحدة معالجة الرسومات.

سرعة التدريب : عدد عينات التدريب التي تتم معالجتها في الثانية أثناء التدريب. (بكالوريوس = 4، قطع_لين = 1024)

Rouge Score : يسجل Rouge-2 في مجموعة تطوير مهمة إنشاء النص الإعلاني. (بكالوريوس = 4، قطع_لين = 1024)

ذاكرة GPU : ذروة استخدام ذاكرة GPU في التدريب الكمي 4 بت. (بكالوريوس=1، قطع_لين=1024)

نحن نعتمد pre_seq_len=128 لـ ChatGLM's P-Tuning و lora_rank=32 لضبط LoRA الخاص بـ LLaMA Factory.

[24/10/09] لقد دعمنا تنزيل النماذج ومجموعات البيانات المدربة مسبقًا من Modelers Hub . انظر هذا البرنامج التعليمي للاستخدام.

[24/09/19] نحن ندعم الضبط الدقيق لنماذج Qwen2.5 .

[24/08/30] نحن ندعم الضبط الدقيق لنماذج Qwen2-VL . شكرًا للعلاقات العامة لـ @simonJJJ.

[24/08/27] نحن ندعم Liger Kernel . جرب enable_liger_kernel: true للتدريب الفعال.

[24/08/09] نحن ندعم مُحسِّن Adam-mini . انظر أمثلة للاستخدام. شكرًا للعلاقات العامة لـ @relic-yuexi.

[24/07/04] نحن ندعم التدريب المعبأ الخالي من التلوث. استخدم neat_packing: true لتنشيطه. أشكر @ chuan298 للعلاقات العامة.

[24/06/16] نحن ندعم خوارزمية PiSSA . انظر أمثلة للاستخدام.

[24/06/07] لقد دعمنا الضبط الدقيق لطرازي Qwen2 و GLM-4 .

[24/05/26] لقد دعمنا خوارزمية SimPO لتعلم التفضيلات. انظر أمثلة للاستخدام.

[24/05/20] لقد دعمنا الضبط الدقيق لنماذج سلسلة PaliGemma . لاحظ أن نماذج PaliGemma هي نماذج مدربة مسبقًا، وتحتاج إلى ضبطها باستخدام قالب paligemma لإكمال الدردشة.

[24/05/18] لقد دعمنا خوارزمية KTO لتعلم التفضيلات. انظر أمثلة للاستخدام.

[24/05/14] دعمنا التدريب والاستدلال على أجهزة Ascend NPU. تحقق من قسم التثبيت للحصول على التفاصيل.

[24/04/26] لقد دعمنا تحسين LLaVA-1.5 LLM متعدد الوسائط. انظر أمثلة للاستخدام.

[24/04/22] لقد قدمنا دفتر ملاحظات Colab لضبط نموذج Llama-3 على وحدة معالجة الرسوميات T4 المجانية. يتوفر نموذجان مشتقان من Llama-3 تم ضبطهما بدقة باستخدام LLaMA Factory في Hugging Face، راجع Llama3-8B-Chinese-Chat وLlama3-Chinese للحصول على التفاصيل.

[24/04/21] لقد دعمنا مزيج العمق وفقًا لتطبيق AstraMindAI. انظر أمثلة للاستخدام.

[24/04/16] قمنا بدعم محسن BAdam . انظر أمثلة للاستخدام.

[24/04/16] لقد دعمنا تدريب unsloth طويل التسلسل (Llama-2-7B-56k في حدود 24 جيجابايت). إنه يحقق سرعة 117% وذاكرة 50% مقارنة بـ FlashAttention-2، ويمكن العثور على المزيد من المعايير في هذه الصفحة.

[24/03/31] لقد دعمنا ORPO . انظر أمثلة للاستخدام.

[24/03/21] ورقتنا البحثية "LlamaFactory: الضبط الدقيق الفعال الموحد لأكثر من 100 نموذج لغة" متاحة على arXiv!

[24/03/20] لقد دعمنا FSDP+QLoRA الذي يقوم بضبط نموذج 70B على وحدات معالجة الرسومات 2x24 جيجابايت. انظر أمثلة للاستخدام.

[24/03/13] لقد دعمنا LoRA+ . انظر أمثلة للاستخدام.

[24/03/07] لقد دعمنا مُحسِّن GaLore . انظر أمثلة للاستخدام.

[24/03/07] قمنا بدمج vLLM للاستدلال الأسرع والمتزامن. جرب infer_backend: vllm لتستمتع بسرعة استدلال تصل إلى 270% .

[24/02/28] لقد دعمنا LoRA المتحللة بالوزن ( DoRA ). جرب use_dora: true لتنشيط تدريب DoRA.

[24/02/15] لقد دعمنا توسيع الكتلة الذي اقترحته LLaMA Pro. انظر أمثلة للاستخدام.

[24/02/05] نماذج سلسلة Qwen1.5 (الإصدار التجريبي من Qwen2) مدعومة في LLaMA-Factory. تحقق من منشور المدونة هذا للحصول على التفاصيل.

[24/01/18] لقد دعمنا ضبط الوكيل لمعظم النماذج، وتزويد النموذج بأداة تستخدم القدرات من خلال الضبط الدقيق باستخدام dataset: glaive_toolcall_en .

[23/12/23] لقد دعمنا تنفيذ unsloth لتعزيز ضبط LoRA لنماذج LLaMA وMistral وYi. جرب use_unsloth: true لتنشيط تصحيح unsloth. لقد حقق سرعة تصل إلى 170% في معيارنا، قم بمراجعة هذه الصفحة للحصول على التفاصيل.

[23/12/12] لقد دعمنا الضبط الدقيق لأحدث طراز من طراز وزارة التربية والتعليم Mixtral 8x7B في إطار عملنا. انظر متطلبات الأجهزة هنا.

[23/12/01] لقد دعمنا تنزيل النماذج ومجموعات البيانات المدربة مسبقًا من ModelScope Hub . انظر هذا البرنامج التعليمي للاستخدام.

[23/10/21] لقد دعمنا خدعة NEFTune للضبط الدقيق. جرب وسيطة neftune_noise_alpha: 5 لتنشيط NEFTune.

[23/09/27] دعمنا shift_attn: true لتمكين تحويل الانتباه القصير.

[23/09/23] قمنا بدمج معايير MMLU وC-Eval وCMMLU في هذا الريبو. انظر أمثلة للاستخدام.

[23/09/10] دعمنا FlashAttention-2 . جرب flash_attn: fa2 لتمكين FlashAttention-2 إذا كنت تستخدم وحدات معالجة الرسومات RTX4090 أو A100 أو H100.

[23/08/12] لقد دعمنا تحجيم RoPE لتوسيع طول سياق نماذج LLaMA. جرب rope_scaling: linear في التدريب و rope_scaling: dynamic عند الاستدلال لاستقراء تضمينات الموضع.

[23/08/11] قمنا بدعم تدريب DPO للنماذج المضبوطة للتعليمات. انظر أمثلة للاستخدام.

[23/07/31] لقد دعمنا تدفق مجموعة البيانات . حاول streaming: true و max_steps: 10000 وسيطة لتحميل مجموعة البيانات الخاصة بك في وضع الدفق.

[23/07/29] أصدرنا نموذجين 13B مضبوطين بالتعليمات في Hugging Face. راجع هذه الترتيبات الخاصة بـ Hugging Face Repos (LLaMA-2 / Baichuan) للحصول على التفاصيل.

[23/07/18] قمنا بتطوير واجهة مستخدم ويب شاملة للتدريب والتقييم والاستدلال. حاول train_web.py لضبط النماذج في متصفح الويب الخاص بك. شكرًا @KanadeSiina و@codemayq على جهودهم في التطوير.

[23/07/09] أصدرنا FastEdit ⚡، وهي حزمة سهلة الاستخدام لتحرير المعرفة الواقعية لنماذج اللغات الكبيرة بكفاءة. يرجى اتباع FastEdit إذا كنت مهتمًا.

[23/06/29] قدمنا مثالاً قابلاً للتكرار لتدريب نموذج دردشة باستخدام مجموعات البيانات التي تتبع التعليمات، راجع Baichuan-7B-sft للحصول على التفاصيل.

[23/06/22] لقد قمنا بمحاذاة واجهة برمجة التطبيقات التجريبية مع تنسيق OpenAI حيث يمكنك إدراج النموذج المضبوط بدقة في التطبيقات العشوائية المستندة إلى ChatGPT .

[23/06/03] لقد دعمنا التدريب والاستدلال الكمي (المعروف أيضًا باسم QLoRA ). انظر أمثلة للاستخدام.

| نموذج | حجم النموذج | نموذج |

|---|---|---|

| بايتشوان 2 | 7ب/13ب | baichuan2 |

| بلوم/بلومز | 560 م/1.1 ب/1.7 ب/3 ب/7.1 ب/176 ب | - |

| دردشةGLM3 | 6 ب | chatglm3 |

| الأمر ر | 35 ب/104 ب | التحم |

| DeepSeek (الكود/وزارة التعليم) | 7ب/16ب/67ب/236ب | com.deepseek |

| فالكون | 7ب/11ب/40ب/180ب | الصقر |

| جيما/جيما 2/كود جيما | 2ب/7ب/9ب/27ب | جيما |

| جي إل إم-4 | 9 ب | glm4 |

| إنترلم2/إنترلم2.5 | 7ب/20ب | المتدرب2 |

| اللاما | 7ب/13ب/33ب/65ب | - |

| اللاما 2 | 7ب/13ب/70ب | اللاما2 |

| اللاما 3-3.2 | 1ب/3ب/8ب/70ب | اللاما3 |

| لافا-1.5 | 7ب/13ب | اللافا |

| لافا-نيكست | 7B/8B/13B/34B/72B/110B | llava_next |

| LLaVA-NeXT-فيديو | 7ب/34ب | llava_next_video |

| التكلفة البسيطة لكل ألف ظهور | 1ب/2ب/4ب | التكلفة لكل ألف ظهور/التكلفة لكل ألف ظهور3 |

| ميسترال / ميكسترال | 7ب/8x7ب/8x22ب | ميسترال |

| أولمو | 1ب/7ب | - |

| باليجيما | 3 ب | باليجيما |

| فاي-1.5/فاي-2 | 1.3 ب/2.7 ب | - |

| فاي-3 | 4ب/7ب/14ب | فاي |

| بيكسلال | 12 ب | com.pixtral |

| كوين (1-2.5) (البرمجة/الرياضيات/وزارة التربية والتعليم) | 0.5ب/1.5ب/3ب/7ب/14ب/32ب/72ب/110ب | كوين |

| Qwen2-VL | 2ب/7ب/72ب | qwen2_vl |

| ستاركودر 2 | 3ب/7ب/15ب | - |

| XVERSE | 7ب/13ب/65ب | com.xverse |

| يي/يي-1.5 (الرمز) | 1.5 ب/6 ب/9 ب/34 ب | يي |

| يي-VL | 6ب/34ب | yi_vl |

| يوان 2 | 2ب/51ب/102ب | يوان |

ملحوظة

بالنسبة للنماذج "الأساسية"، يمكن اختيار وسيطة template من default و alpaca و vicuna وما إلى ذلك. ولكن تأكد من استخدام القالب المقابل لنماذج "instruct/chat".

تذكر استخدام قالب SAME في التدريب والاستدلال.

يرجى الرجوع إلى Constants.py للحصول على قائمة كاملة بالنماذج التي ندعمها.

يمكنك أيضًا إضافة قالب دردشة مخصص إلى template.py.

| يقترب | ضبط كامل | ضبط التجميد | لورا | كلورا |

|---|---|---|---|---|

| التدريب المسبق | ✅ | ✅ | ✅ | ✅ |

| الضبط الدقيق تحت الإشراف | ✅ | ✅ | ✅ | ✅ |

| نمذجة المكافأة | ✅ | ✅ | ✅ | ✅ |

| تدريب PPO | ✅ | ✅ | ✅ | ✅ |

| تدريب DPO | ✅ | ✅ | ✅ | ✅ |

| تدريب KTO | ✅ | ✅ | ✅ | ✅ |

| تدريب اوربو | ✅ | ✅ | ✅ | ✅ |

| تدريب سيمبو | ✅ | ✅ | ✅ | ✅ |

نصيحة

يمكن العثور على تفاصيل تنفيذ PPO في هذه المدونة.

عرض ويكي (ar)

ريفايند ويب (ar)

ريد بيجامة V2 (ar)

ويكيبيديا (ar)

ويكيبيديا (زه)

كومة (ar)

سكاي بايل (zh)

فاين ويب (ar)

FineWeb-Edu (ar)

المكدس (ar)

ستاركودر (ar)

الهوية (بالإنكليزية&zh)

ستانفورد ألباكا (ar)

ستانفورد الألبكة (zh)

الألبكة GPT4 (en&zh)

استدعاء الدالة Glaive V2 (en&zh)

ليما (ar)

مجموعة بيانات جواناكو (متعددة اللغات)

حسناء 2M (zh)

حسناء 1M (zh)

حسناء 0.5 م (zh)

حوار بيل 0.4M (zh)

مدرسة بيل للرياضيات 0.25M (zh)

حسناء Multiturn الدردشة 0.8M (zh)

UltraChat (ar)

فتح خلد الماء (ar)

كود ألباكا 20k (ar)

الألبكة CoT (متعدد اللغات)

أوبن أوركا (ar)

سليم أوركا (ar)

MathInstruct (ar)

اليراع 1.1M (zh)

ويكي ضمان الجودة (ar)

ضمان الجودة على الويب (zh)

WebNovel (zh)

رحيق (ar)

ديبكترل (انج&zh)

توليد الإعلانات (zh)

ShareGPT Hyperfiltered (ar)

ShareGPT4 (en&zh)

UltraChat 200k (ar)

AgentInstruct (ar)

LMSYS Chat 1M (ar)

إيفول إنستركت V2 (ar)

كوزموبيديا (ar)

الجذعية (zh)

روزيبا (zh)

نيو-sft (zh)

WebInstructSub (ar)

Magpie-Pro-300K-Filtered (ar)

Magpie-ultra-v0.1 (ar)

LLaVA مختلط (en&zh)

بوكيمون-gpt4o-التسميات التوضيحية (en&zh)

مساعد مفتوح (دي)

دوللي 15 كيلو (دي)

الألبكة GPT4 (دي)

أوبن شنابلتير (دي)

إيفول إنستركت (دي)

دولفين (دي)

مجموع الكتب (دي)

أيروبوروس (دي)

التراتشات (دي)

DPO مختلط (en&zh)

UltraFeedback (ar)

RLHF-V (ar)

VLFeedback (ar)

أزواج Orca DPO (ar)

سمو-RLHF (ar)

رحيق (ar)

أوركا DPO (دي)

KTO مختلط (ar)

تتطلب بعض مجموعات البيانات تأكيدًا قبل استخدامها، لذا نوصي بتسجيل الدخول باستخدام حساب Hugging Face الخاص بك باستخدام هذه الأوامر.

تثبيت النقطة - ترقية Huggingface_hub Huggingface-cli تسجيل الدخول

| إلزامي | الحد الأدنى | يوصي |

|---|---|---|

| بيثون | 3.8 | 3.11 |

| الشعلة | 1.13.1 | 2.4.0 |

| محولات | 4.41.2 | 4.43.4 |

| مجموعات البيانات | 2.16.0 | 2.20.0 |

| تسريع | 0.30.1 | 0.32.0 |

| com.peft | 0.11.1 | 0.12.0 |

| trl | 0.8.6 | 0.9.6 |

| خياري | الحد الأدنى | يوصي |

|---|---|---|

| كودا | 11.6 | 12.2 |

| com.deepspeed | 0.10.0 | 0.14.0 |

| bitsandbytes | 0.39.0 | 0.43.1 |

| vllm | 0.4.3 | 0.5.0 |

| فلاش عناية | 2.3.0 | 2.6.3 |

* مُقدَّر

| طريقة | أجزاء | 7 ب | 13 ب | 30 ب | 70 ب | 110 ب | 8x7 ب | 8x22 ب |

|---|---|---|---|---|---|---|---|---|

| ممتلىء | أمبير | 120 جيجابايت | 240 جيجابايت | 600 جيجابايت | 1200 جيجابايت | 2000 جيجابايت | 900 جيجابايت | 2400 جيجابايت |

| ممتلىء | 16 | 60 جيجابايت | 120 جيجابايت | 300 جيجابايت | 600 جيجابايت | 900 جيجابايت | 400 جيجابايت | 1200 جيجابايت |

| تجميد | 16 | 20 جيجابايت | 40 جيجابايت | 80 جيجابايت | 200 جيجابايت | 360 جيجابايت | 160 جيجابايت | 400 جيجابايت |

| لورا/جالور/بادام | 16 | 16 جيجابايت | 32 جيجابايت | 64 جيجابايت | 160 جيجابايت | 240 جيجابايت | 120 جيجابايت | 320 جيجابايت |

| كلورا | 8 | 10 جيجابايت | 20 جيجابايت | 40 جيجابايت | 80 جيجابايت | 140 جيجابايت | 60 جيجابايت | 160 جيجابايت |

| كلورا | 4 | 6 جيجابايت | 12 جيجابايت | 24 جيجابايت | 48 جيجابايت | 72 جيجابايت | 30 جيجابايت | 96 جيجابايت |

| كلورا | 2 | 4 غيغابايت | 8 جيجابايت | 16 جيجابايت | 24 جيجابايت | 48 جيجابايت | 18 جيجابايت | 48 جيجابايت |

مهم

التثبيت إلزامي.

git clone - العمق 1 https://github.com/hiyouga/LLaMA-Factory.gitcd LLaMA-Factory تثبيت النقطة -e ".[الشعلة، المقاييس]"

التبعيات الإضافية المتاحة: torch، torch-npu، metrics، Deepspeed، liger-kernel، bitsandbytes، hqq، eetq، gptq، awq، aqlm، vllm، galore، badam، adam-mini، qwen، modelscope، openmind،quality

نصيحة

استخدم pip install --no-deps -e . لحل تعارضات الحزمة.

إذا كنت ترغب في تمكين LoRA الكمي (QLoRA) على نظام Windows الأساسي، فأنت بحاجة إلى تثبيت إصدار مُنشأ مسبقًا من مكتبة bitsandbytes ، التي تدعم CUDA 11.1 إلى 12.2، يرجى تحديد إصدار الإصدار المناسب بناءً على إصدار CUDA الخاص بك.

تثبيت النقطة https://github.com/jllllll/bitsandbytes-windows-webui/releases/download/wheels/bitsandbytes-0.41.2.post2-py3-none-win_amd64.whl

لتمكين FlashAttention-2 على نظام التشغيل Windows، تحتاج إلى تثبيت مكتبة flash-attn المترجمة مسبقًا، والتي تدعم CUDA 12.1 إلى 12.2. يرجى تنزيل الإصدار المقابل من flash-attention بناءً على متطلباتك.

لتثبيت LLaMA Factory على أجهزة Ascend NPU، يرجى تحديد التبعيات الإضافية: pip install -e ".[torch-npu,metrics]" . بالإضافة إلى ذلك، تحتاج إلى تثبيت مجموعة أدوات Ascend CANN وKernels . يرجى اتباع البرنامج التعليمي للتثبيت أو استخدام الأوامر التالية:

# استبدل عنوان url وفقًا لإصدار CANN وأجهزتك# قم بتثبيت CANN Toolkitwget https://ascend-repo.obs.cn-east-2.myhuaweicloud.com/Milan-ASL/Milan-ASL%20V100R001C17SPC701/Ascend-cann-toolkit_8 .0.RC1.alpha001_linux-"$(uname -i)".run bash Ascend-cann-toolkit_8.0.RC1.alpha001_linux-"$(uname -i)".run --install# install CANN Kernelswget https://ascend-repo.obs.cn-east-2.myhuaweicloud.com/Milan-ASL/Milan-ASL%20V100R001C17SPC701/Ascend-cann-kernels-910b_8.0.RC1.alpha001_linux.run bash Ascend-cann-kernels-910b_8.0.RC1.alpha001_linux.run --install# set env المتغيراتsource /usr/local/Ascend/ascend-toolkit/set_env.sh

| متطلبات | الحد الأدنى | يوصي |

|---|---|---|

| القنا | 8.0.RC1 | 8.0.RC1 |

| الشعلة | 2.1.0 | 2.1.0 |

| الشعلة-npu | 2.1.0 | 2.1.0.post3 |

| com.deepspeed | 0.13.2 | 0.13.2 |

تذكر استخدام ASCEND_RT_VISIBLE_DEVICES بدلاً من CUDA_VISIBLE_DEVICES لتحديد الجهاز الذي تريد استخدامه.

إذا لم تتمكن من استنتاج النموذج على أجهزة NPU، فحاول تعيين do_sample: false في التكوينات.

قم بتنزيل صور Docker المعدة مسبقًا: 32 جيجابايت | 64 جيجابايت

يرجى الرجوع إلى data/README.md للتحقق من التفاصيل حول تنسيق ملفات مجموعة البيانات. يمكنك إما استخدام مجموعات البيانات على مركز HuggingFace / ModelScope / Modelers أو تحميل مجموعة البيانات في القرص المحلي.

ملحوظة

يرجى تحديث data/dataset_info.json لاستخدام مجموعة البيانات المخصصة الخاصة بك.

استخدم الأوامر الثلاثة التالية لتشغيل ضبط LoRA واستدلاله ودمج نموذج Llama3-8B-Instruct، على التوالي.

أمثلة على قطارات llamafactory-cli/train_lora/llama3_lora_sft.yaml أمثلة الدردشة llamafactory-cli/inference/llama3_lora_sft.yaml أمثلة التصدير llamafactory-cli/merge_lora/llama3_lora_sft.yaml

راجع الأمثلة/README.md للاطلاع على الاستخدام المتقدم (بما في ذلك التدريب الموزع).

نصيحة

استخدم llamafactory-cli help لإظهار معلومات المساعدة.

llamafactory-cli webui

لمستخدمي كودا:

قرص مضغوط عامل ميناء/عامل ميناء كودا/ عامل ميناء يؤلف -d عامل ميناء يؤلف exec llamafactory bash

لمستخدمي وحدة NPU التصاعدية:

القرص المضغوط عامل الإرساء/عامل الإرساء-npu/ عامل ميناء يؤلف -d عامل ميناء يؤلف exec llamafactory bash

لمستخدمي AMD ROCm:

مؤتمر نزع السلاح عامل ميناء/عامل الميناء-rocm/ عامل ميناء يؤلف -d عامل ميناء يؤلف exec llamafactory bash

لمستخدمي كودا:

docker build -f ./docker/docker-cuda/Dockerfile

--build-arg INSTALL_BNB=false

--build-arg INSTALL_VLLM=false

--build-arg INSTALL_DEEPSPEED=false

--build-arg INSTALL_FLASHATTN=false

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory:latest .docker run -dit --gpus=all

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./data:/app/data

-v ./output:/app/output

-ص 7860:7860

-ص 8000:8000

--حجم شم 16 جرام

--اسم لاما فاكتوري

لاما فاكتوري: الأحدث

docker exec -it llamafactory bashلمستخدمي وحدة NPU التصاعدية:

# اختر صورة عامل الإرساء على بيئة docker build -f ./docker/docker-npu/Dockerfile

--build-arg INSTALL_DEEPSPEED=false

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory:latest .# قم بتغيير "الجهاز" عند تشغيل Resourcesdocker -dit

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./data:/app/data

-v ./output:/app/output

-v /usr/local/dcmi:/usr/local/dcmi

-v /usr/local/bin/npu-smi:/usr/local/bin/npu-smi

-v /usr/local/Ascend/driver:/usr/local/Ascend/driver

-v /etc/ascend_install.info:/etc/ascend_install.info

-ص 7860:7860

-ص 8000:8000

--device /dev/davinci0

--device /dev/davinci_manager

--device /dev/devmm_svm

--device /dev/hisi_hdc

--حجم شم 16 جرام

--اسم لاما فاكتوري

لاما فاكتوري: الأحدث

docker exec -it llamafactory bashلمستخدمي AMD ROCm:

docker build -f ./docker/docker-rocm/Dockerfile

--build-arg INSTALL_BNB=false

--build-arg INSTALL_VLLM=false

--build-arg INSTALL_DEEPSPEED=false

--build-arg INSTALL_FLASHATTN=false

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory: أحدث تشغيل .docker -dit

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./data:/app/data

-v ./output:/app/output

-v ./saves:/app/saves

-ص 7860:7860

-ص 8000:8000

--device /dev/kfd

--device /dev/dri

--حجم شم 16 جرام

--اسم لاما فاكتوري

لاما فاكتوري: الأحدث

docker exec -it llamafactory bash hf_cache : استخدم ذاكرة التخزين المؤقت Hugging Face على الجهاز المضيف. يمكن إعادة تعيينه إذا كانت ذاكرة التخزين المؤقت موجودة بالفعل في دليل مختلف.

ms_cache : يشبه ذاكرة التخزين المؤقت Hugging Face ولكن لمستخدمي ModelScope.

om_cache : يشبه ذاكرة التخزين المؤقت Hugging Face ولكن لمستخدمي Modelers.

data : ضع مجموعات البيانات على هذا الدليل الخاص بالجهاز المضيف بحيث يمكن تحديدها على LLaMA Board GUI.

output : قم بتعيين دليل التصدير إلى هذا الموقع بحيث يمكن الوصول إلى النتيجة المدمجة مباشرة على الجهاز المضيف.

API_PORT=8000 أمثلة llamafactory-cli API/inference/llama3_vllm.yaml

نصيحة

تفضل بزيارة هذه الصفحة للحصول على مستند API.

أمثلة: فهم الصورة | استدعاء الوظيفة

إذا كانت لديك مشكلة في تنزيل النماذج ومجموعات البيانات من Hugging Face، فيمكنك استخدام ModelScope.

تصدير USE_MODELSCOPE_HUB=1 # `ضبط USE_MODELSCOPE_HUB=1` لنظام التشغيل Windows

قم بتدريب النموذج عن طريق تحديد معرف النموذج الخاص بـ ModelScope Hub باعتباره model_name_or_path . يمكنك العثور على قائمة كاملة بمعرفات النماذج في ModelScope Hub، على سبيل المثال LLM-Research/Meta-Llama-3-8B-Instruct .

يمكنك أيضًا استخدام Modelers Hub لتنزيل النماذج ومجموعات البيانات.

تصدير USE_OPENMIND_HUB=1 # `ضبط USE_OPENMIND_HUB=1` لنظام التشغيل Windows

قم بتدريب النموذج عن طريق تحديد معرف النموذج الخاص بـ Modelers Hub باعتباره model_name_or_path . يمكنك العثور على قائمة كاملة بمعرفات النماذج في Modelers Hub، على سبيل المثال، TeleAI/TeleChat-7B-pt .

لاستخدام الأوزان والتحيزات لتسجيل النتائج التجريبية، تحتاج إلى إضافة الوسائط التالية إلى ملفات yaml.

report_to: wandbrun_name: test_run # اختياري

قم بتعيين WANDB_API_KEY على مفتاحك عند بدء مهام التدريب لتسجيل الدخول باستخدام حساب W&B الخاص بك.

إذا كان لديك مشروع ينبغي دمجه، يرجى الاتصال عبر البريد الإلكتروني أو إنشاء طلب سحب.

وانغ وآخرون. ESRL: التعلم المعزز الفعال القائم على أخذ العينات لتوليد التسلسل. 2023. [arxiv]

يو وآخرون. نماذج لغة مفتوحة أم مغلقة أم صغيرة لتصنيف النص؟ 2023. [arxiv]

وانغ وآخرون. UbiPhysio: دعم الأداء اليومي واللياقة البدنية وإعادة التأهيل من خلال فهم العمل والتعليقات باللغة الطبيعية. 2023. [arxiv]

لوسيري وآخرون. الاستفادة من نماذج اللغة الكبيرة لاكتشاف حملات التأثير في وسائل التواصل الاجتماعي. 2023. [arxiv]

تشانغ وآخرون. التخفيف من هلوسة النماذج اللغوية الكبيرة من خلال الهلوسة المستحثة. 2023. [arxiv]

وانغ وآخرون. اعرف احتياجاتك بشكل أفضل: نحو فهم منظم لمتطلبات المسوقين من خلال التفكير المنطقي المعزز (LLMs). كي دي دي 2024. [arxiv]

وانغ وآخرون. كاندل: التصور التكراري والتقطير الفوري من نماذج اللغة الكبيرة للاستدلال المنطقي. دوري أبطال آسيا 2024. [arxiv]

تشوي وآخرون. FACT-GPT: تعزيز التحقق من الحقائق من خلال مطابقة المطالبات مع LLMs. 2024. [arxiv]

تشانغ وآخرون. AutoMathText: اختيار البيانات المستقلة مع نماذج اللغة للنصوص الرياضية. 2024. [arxiv]

ليو وآخرون. KnowTuning: الضبط الدقيق المدرك للمعرفة لنماذج اللغات الكبيرة. 2024. [arxiv]

يانغ وآخرون. LaCo: تقليم نموذج اللغة الكبير عبر طي الطبقات. 2024. [arxiv]

بهاردواج وآخرون. نماذج اللغة هي هوميروس سمبسون! إعادة محاذاة السلامة لنماذج اللغة المضبوطة من خلال حساب المهام. 2024. [arxiv]

يانغ وآخرون. تعزيز توليد الاستجابة التعاطفية من خلال زيادة ماجستير إدارة الأعمال بنماذج متعاطفة صغيرة الحجم. 2024. [arxiv]

يي وآخرون. الجيل يلبي التحقق: تسريع استنتاج نماذج اللغة الكبيرة من خلال فك تشفير التصحيح التلقائي الذكي المتوازي. نتائج ACL 2024. [arxiv]

تساو وآخرون. الاهتمام الحكيم بالمشاركة لنماذج اللغات الكبيرة. 2024. [arxiv]

تشانغ وآخرون. تعزيز القدرات المتعددة اللغات لنماذج اللغات الكبيرة من خلال التقطير الذاتي من اللغات الغنية بالموارد. 2024. [arxiv]

كيم وآخرون. توسيع المفردات بكفاءة وفعالية نحو نماذج لغوية كبيرة متعددة اللغات. 2024. [arxiv]

يو وآخرون. KIEval: إطار تقييم تفاعلي قائم على المعرفة لنماذج اللغات الكبيرة. دوري أبطال آسيا 2024. [arxiv]

هوانغ وآخرون. تجميع البيانات المبنية على النقاط الرئيسية مع تعزيزها على التفكير الرياضي. 2024. [arxiv]

دوان وآخرون. سلبيات سلبية: المحاذاة بدون عينات إيجابية بشرية عن طريق تحسين التباين التوزيعي. 2024. [arxiv]

شيه وشويرتفيغر. تمكين الروبوتات باستخدام نماذج لغوية كبيرة: فهم خريطة osmAG مع LLMs. 2024. [arxiv]

وو وآخرون. نماذج اللغات الكبيرة هي متعلمون متعددو اللغات متوازيون. 2024. [arxiv]

تشانغ وآخرون. EDT: تحسين إنشاء نماذج اللغات الكبيرة عن طريق أخذ عينات درجة الحرارة الديناميكية القائمة على الإنتروبيا. 2024. [arxiv]

ويلر وآخرون. FollowIR: تقييم وتعليم نماذج استرجاع المعلومات لاتباع التعليمات. 2024. [arxiv]

هونغبين نا. CBT-LLM: نموذج لغة صينية كبيرة للإجابة على أسئلة الصحة العقلية القائمة على العلاج السلوكي المعرفي. كولينج 2024. [arxiv]

زان وآخرون. CodeS: تحويل اللغة الطبيعية إلى مستودع الأكواد عبر رسم متعدد الطبقات. 2024. [arxiv]

ليو وآخرون. يتيح التباين الذاتي الشامل محاذاة نموذج اللغة بدون تعليقات. 2024. [arxiv]

لوه وآخرون. BAdam: طريقة تدريب المعلمات الكاملة ذات الكفاءة في الذاكرة لنماذج اللغات الكبيرة. 2024. [arxiv]

دو وآخرون. LLM الصينية الصغيرة: التدريب المسبق على نموذج اللغة الكبيرة المرتكز على اللغة الصينية. 2024. [arxiv]

ما وآخرون. المعلمة كفاءة شبه متعامدة الضبط الدقيق عن طريق دوران المعطيات. ICML 2024. [arxiv]

ليو وآخرون. الجيل الديناميكي من الشخصيات بنماذج لغوية كبيرة. 2024. [arxiv]

شانغ وآخرون. إلى أي مدى ذهبنا في فهم الكود الثنائي المجرد باستخدام نماذج اللغة الكبيرة. 2024. [arxiv]

هوانغ وآخرون. LLMTune: تسريع ضبط مقبض قاعدة البيانات باستخدام نماذج اللغات الكبيرة. 2024. [arxiv]

دينغ وآخرون. Text-Tuple-Table: نحو تكامل المعلومات في إنشاء النص إلى جدول عبر استخراج Tuple العالمي. 2024. [arxiv]

أسيكجوز وآخرون. أبقراط: إطار مفتوح المصدر لتطوير نماذج اللغات الكبيرة في الرعاية الصحية. 2024. [arxiv]

تشانغ وآخرون. تحتاج نماذج اللغة الصغيرة إلى أدوات تحقق قوية لتصحيح المنطق ذاتيًا. نتائج ACL 2024. [arxiv]

تشو وآخرون. FREB-TQA: معيار تقييم المتانة الدقيق للإجابة على أسئلة الجدول. NAACL 2024. [arxiv]

شو وآخرون. نماذج لغوية كبيرة للأمن السيبراني: مراجعة منهجية للأدبيات. 2024. [arxiv]

دامو وآخرون. "إنهم غير مثقفين": الكشف عن الأضرار السرية والتهديدات الاجتماعية في المحادثات التي تولدها LLM. 2024. [arxiv]

يي وآخرون. إطار إعادة تنظيم السلامة عبر دمج النماذج الموجهة نحو الفضاء الفرعي لنماذج اللغات الكبيرة. 2024. [arxiv]

لو وآخرون. SPO: محاذاة تسلسلية للتفضيلات متعددة الأبعاد مع نمذجة المكافأة الضمنية. 2024. [arxiv]

تشانغ وآخرون. الحصول على المزيد من القليل: نماذج اللغات الكبيرة هي متعلمون جيدون متعددو اللغات بشكل عفوي. 2024. [arxiv]

تشانغ وآخرون. TS-Align: إطار تعاوني بين المعلم والطالب من أجل الضبط الدقيق التكراري القابل للتطوير لنماذج اللغات الكبيرة. 2024. [arxiv]

زيهونغ تشن. تجزئة الجملة وعلامات الترقيم على أساس XunziALLM. 2024. [ورقة]

جاو وآخرون. أفضل ما في العالمين: نحو نموذج لغة كبير صادق ومفيد. 2024. [arxiv]

وانغ وسونغ. MARS: قياس قدرات التفكير الميتافيزيقي لنماذج اللغة باستخدام مجموعة بيانات تقييم متعددة المهام. 2024. [arxiv]

هو وآخرون. الحدود الحسابية للتكيف منخفض الرتبة (LoRA) للنماذج القائمة على المحولات. 2024. [arxiv]

جي وآخرون. تحرير المعرفة الحساسة للوقت من خلال الضبط الدقيق. دوري أبطال آسيا 2024. [arxiv]

تان وآخرون. مراجعة النظراء باعتبارها حوارًا متعدد المنعطفات وطويل السياق مع التفاعلات القائمة على الأدوار. 2024. [arxiv]

سونغ وآخرون. Turbo Sparse: تحقيق أداء LLM SOTA مع الحد الأدنى من المعلمات المنشطة. 2024. [arxiv]

قو وآخرون. RWKV-CLIP: متعلم قوي لتمثيل الرؤية واللغة. 2024. [arxiv]

تشن وآخرون. نماذج اللغات الكبيرة المعززة بالأدوات: دمج الرؤى من الأخطاء في أشجار الاستدلال. 2024. [arxiv]

تشو وآخرون. هل نماذج اللغات الكبيرة إحصائيون جيدون؟ 2024. [arxiv]

لي وآخرون. تعرف على المجهول: طريقة حساسة لعدم اليقين لضبط تعليمات LLM. 2024. [arxiv]

دينغ وآخرون. IntentionQA: معيار لتقييم قدرات فهم نية الشراء لنماذج اللغة في التجارة الإلكترونية. 2024. [arxiv]

هو وآخرون. تعليمات المجتمع المتقاطع: إنشاء تعليمات غير خاضعة للرقابة لمواءمة نماذج اللغات الكبيرة مع المجتمعات عبر الإنترنت. 2024. [arxiv]

لين وآخرون. FVEL: بيئة تحقق رسمية تفاعلية مع نماذج لغوية كبيرة من خلال إثبات النظرية. 2024. [arxiv]

تريوتلين وآخرون. ربط النقاط: يمكن لطلاب LLM استنتاج البنية الكامنة والتعبير عنها لفظيًا من بيانات التدريب المتباينة. 2024. [arxiv]

فنغ وآخرون. SS-Bench: معيار لتوليد القصص الاجتماعية وتقييمها. 2024. [arxiv]

فنغ وآخرون. تفكيك السياق الذي تم إنشاؤه ذاتيًا مع تحسين المحاذاة الدقيقة. 2024. [arxiv]

ليو وآخرون. نماذج لغوية كبيرة لقياس ضغط الدم بدون أكمام من إشارات حيوية يمكن ارتداؤها. 2024. [arxiv]

آير وآخرون. استكشاف الترجمة ذات الموارد المنخفضة للغاية مع ماجستير إدارة الأعمال: تقديم جامعة إدنبرة لمهمة الترجمة في AmericasNLP 2024. الأمريكتين البرمجة اللغوية العصبية 2024. [ورقة]

لي وآخرون. معايرة LLMs مع تحسين التفضيلات في أشجار الفكر لتوليد الأساس المنطقي في تسجيل أسئلة العلوم. 2024. [arxiv]

يانغ وآخرون. المعرفة المالية نموذج اللغة الكبيرة. 2024. [arxiv]

لين وآخرون. DogeRM: تجهيز نماذج المكافآت بمعرفة المجال من خلال دمج النماذج. 2024. [arxiv]

باكو وآخرون. تقييم قدرات التنميط الدلالي للماجستير في نطق اللغة الطبيعية في تصور البيانات. 2024. [arxiv]

هوانغ وآخرون. RoLoRA: ضبط LLMs المدور الخالي من العناصر الخارجية من أجل تقدير فعال لتنشيط الوزن. 2024. [arxiv]

جيانغ وآخرون. LLM- التعاون في مجال الصحافة العلمية التلقائية للجمهور العام. 2024. [arxiv]

إينوي وآخرون. تم تطبيق الضبط التلقائي على معلمات LoRA الفائقة. 2024. [ورقة]

تشي وآخرون. البحث عن نظام توليد معلومات وجهات نظر السياحة التبتية على أساس LLM. 2024. [arxiv]

شو وآخرون. تصحيح المسار: محاذاة السلامة باستخدام التفضيلات الاصطناعية. 2024. [arxiv]

صن وآخرون. LAMBDA: وكيل بيانات كبير قائم على النماذج. 2024. [arxiv]

تشو وآخرون. CollectiveSFT: توسيع نطاق نماذج اللغات الكبيرة للمعايير الطبية الصينية من خلال تعليمات جماعية في مجال الرعاية الصحية. 2024. [arxiv]

يو وآخرون. تصحيح التحيز السلبي في نماذج اللغة الكبيرة من خلال محاذاة درجات الانتباه السلبي. 2024. [arxiv]

شيه وآخرون. قوة مجموعات البيانات الشخصية: تطوير الكتابة التركيبية الصينية للمدرسة الابتدائية من خلال الضبط الدقيق للنموذج المستهدف. IALP 2024. [ورقة]

ليو وآخرون. Instruct-Code-Llama: تحسين قدرات النموذج اللغوي في إنشاء الكود على مستوى المنافسة من خلال تعليقات القاضي عبر الإنترنت. ICIC 2024. [ورقة]

وانغ وآخرون. الحراس السيبرانيون: الكشف عن تأثير اختيار بيانات السلامة على أمان النموذج في الضبط الدقيق الخاضع للإشراف. ICIC 2024. [ورقة]

شيا وآخرون. فهم الأداء وتقدير تكلفة الضبط الدقيق لماجستير القانون. 2024. [arxiv]

تسنغ وآخرون. الإدراك والتأمل والتخطيط: تصميم وكيل LLM للملاحة في المدينة الموجهة نحو الهدف دون تعليمات. 2024. [arxiv]

شيا وآخرون. استخدام نموذج اللغة المدرب مسبقًا للتنبؤ الدقيق بالبيئة البيئية والاجتماعية والحوكمة. FinNLP 2024. [ورقة]

ليانغ وآخرون. I-SHEEP: التوافق الذاتي للماجستير في القانون من الصفر من خلال نموذج التحسين الذاتي التكراري. 2024. [arxiv]

StarWhisper : نموذج لغة كبير لعلم الفلك، يعتمد على ChatGLM2-6B وQwen-14B.

DISC-LawLLM : نموذج لغوي كبير متخصص في المجال القانوني الصيني، يعتمد على Baichuan-13B، قادر على استرجاع المعرفة القانونية والتفكير فيها.

Sunsimiao : نموذج لغة كبير متخصص في المجال الطبي الصيني، يعتمد على Baichuan-7B وChatGLM-6B.

CareGPT : سلسلة من نماذج اللغات الكبيرة للمجال الطبي الصيني، استنادًا إلى LLaMA2-7B وBaichuan-13B.

MachineMindset : سلسلة من نماذج اللغات الكبيرة للشخصية MBTI، قادرة على إعطاء أي LLM 16 أنواعًا مختلفة من الشخصيات بناءً على مجموعات بيانات وطرق تدريب مختلفة.

Luminia-13B-v3 : نموذج لغة كبير متخصص في إنشاء البيانات الوصفية للانتشار المستقر. [تجريبي]

Chinese-LLaVA-Med : نموذج لغة كبير متعدد الوسائط متخصص في المجال الطبي الصيني، يعتمد على LLaVA-1.5-7B.

AutoRE : نظام استخراج العلاقات على مستوى المستند يعتمد على نماذج لغوية كبيرة.

مجموعة أدوات NVIDIA RTX AI : مجموعات SDK لضبط LLMs على أجهزة الكمبيوتر التي تعمل بنظام Windows لـ NVIDIA RTX.

LazyLLM : طريقة سهلة وبطيئة لبناء تطبيقات LLM متعددة الوكلاء وتدعم الضبط الدقيق للنموذج عبر LLaMA Factory.

RAG-Retrieval : خط أنابيب كامل لضبط نموذج استرجاع RAG والاستدلال والتقطير. [مدونة]

هذا المستودع مرخص بموجب ترخيص Apache-2.0.

يرجى اتباع تراخيص النموذج لاستخدام أوزان الطراز المقابلة: Baichuan 2 / BLOOM / ChatGLM3 / Command R / DeepSeek / Falcon / Gemma / GLM-4 / InternLM2 / Llama / Llama 2 (LLaVA-1.5) / Llama 3 / MiniCPM / Mistral /ميكسترال/بيكسلال/أولمو/فاي-1.5/فاي-2/فاي-3/كوين/ ستاركودر 2 / إكسفيرس / يي / يي-1.5 / يوان 2

إذا كان هذا العمل مفيدا، يرجى التكرم بذكر ما يلي:

@inproceedings{zheng2024llamafactory, title={LlamaFactory: Unified Efficient Fine-Tuning of 100+ Language Models}، المؤلف={Yaowei Zheng وRichong Zhang وJunhao Zhang وYanhan Ye وZheyan Luo وZhangchi Feng وYongqiang Ma}، عنوان الكتاب={ وقائع الاجتماع السنوي الثاني والستين لجمعية الحوسبة اللغويات (المجلد 3: عروض النظام)}، العنوان={بانكوك، تايلاند}، الناشر={جمعية اللغويات الحاسوبية}، السنة={2024}، url={http://arxiv.org/abs/2403.13372}}يستفيد هذا الريبو من PEFT وTRL وQLoRA وFastChat. شكرا لأعمالهم الرائعة.