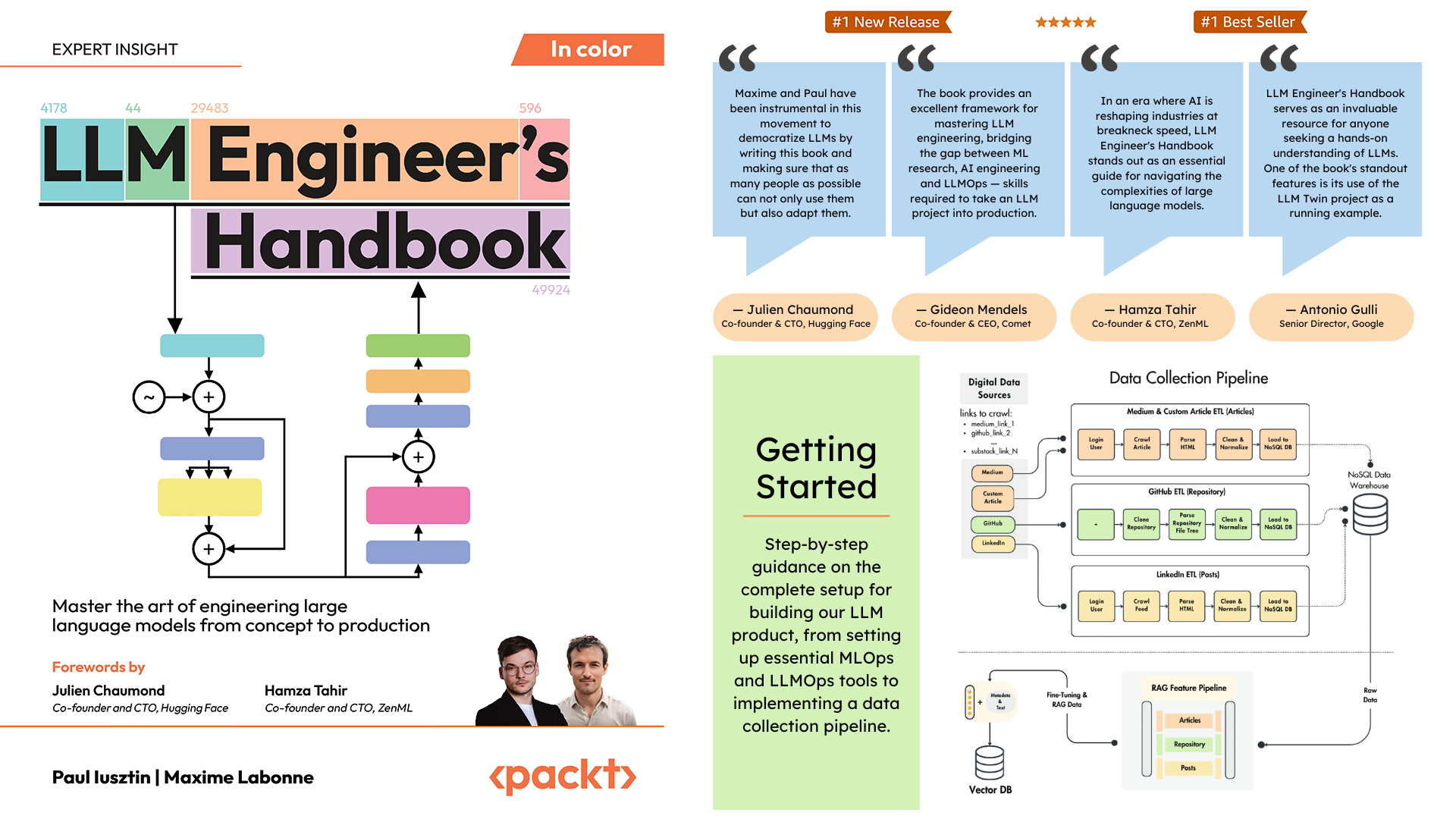

المستودع الرسمي لدليل مهندس LLM من تأليف Paul Iusztin وMaxime Labonne

الهدف من هذا الكتاب هو إنشاء نظامك الشامل القائم على LLM باستخدام أفضل الممارسات:

يمكنك تنزيل واستخدام النموذج المدرب النهائي على Hugging Face.

لتثبيت المشروع وتشغيله محليًا، تحتاج إلى التبعيات التالية.

| أداة | إصدار | غاية | رابط التثبيت |

|---|---|---|---|

| pyenv | ≥2.3.36 | إصدارات بايثون المتعددة (اختياري) | دليل التثبيت |

| بايثون | 3.11 | بيئة وقت التشغيل | تحميل |

| شِعر | ≥1.8.3 | إدارة الحزمة | دليل التثبيت |

| عامل ميناء | ≥27.1.1 | النقل بالحاويات | دليل التثبيت |

| AWS CLI | ≥2.15.42 | إدارة السحابة | دليل التثبيت |

| بوابة | ≥2.44.0 | التحكم في الإصدار | تحميل |

يستخدم الرمز أيضًا ويعتمد على الخدمات السحابية التالية. في الوقت الحالي، ليس عليك أن تفعل أي شيء. سنرشدك في قسمي التثبيت والنشر حول كيفية استخدامها:

| خدمة | غاية |

|---|---|

| HuggingFace | التسجيل النموذجي |

| المذنب مل | تعقب التجربة |

| أوبيك | مراقبة سريعة |

| زينML | طبقة منسقة والتحف |

| أوس | الحساب والتخزين |

| MongoDB | قاعدة بيانات NoSQL |

| قدررانت | قاعدة بيانات المتجهات |

| إجراءات جيثب | خط أنابيب CI/CD |

في دليل مهندس LLM، سيرشدك الفصل الثاني خلال كل أداة. يقدم الفصلان 10 و11 إرشادات خطوة بخطوة حول كيفية إعداد كل ما تحتاجه.

هنا نظرة عامة على الدليل:

.

├── code_snippets/ # Standalone example code

├── configs/ # Pipeline configuration files

├── llm_engineering/ # Core project package

│ ├── application/

│ ├── domain/

│ ├── infrastructure/

│ ├── model/

├── pipelines/ # ML pipeline definitions

├── steps/ # Pipeline components

├── tests/ # Test examples

├── tools/ # Utility scripts

│ ├── run.py

│ ├── ml_service.py

│ ├── rag.py

│ ├── data_warehouse.py llm_engineering/ هي حزمة Python الرئيسية التي تنفذ وظائف LLM وRAG. وهو يتبع مبادئ التصميم المبني على المجال (DDD):

domain/ : كيانات وهياكل الأعمال الأساسيةapplication/ : منطق الأعمال والزواحف وتنفيذ RAGmodel/ : التدريب والاستدلال في ماجستير إدارة الأعمالinfrastructure/ : تكامل الخدمات الخارجية (AWS، Qdrant، MongoDB، FastAPI) يتدفق منطق الكود والواردات على النحو التالي: infrastructure ← model ← application ← domain

pipelines/ : تحتوي على خطوط أنابيب ZenML ML، والتي تعمل كنقطة دخول لجميع خطوط أنابيب ML. ينسق معالجة البيانات ومراحل التدريب النموذجية لدورة حياة تعلم الآلة.

steps/ : تحتوي على خطوات ZenML الفردية، وهي مكونات قابلة لإعادة الاستخدام لبناء خطوط أنابيب ZenML وتخصيصها. تؤدي الخطوات مهام محددة (على سبيل المثال، تحميل البيانات، والمعالجة المسبقة) ويمكن دمجها ضمن مسارات تعلم الآلة.

tests/ : يغطي بعض نماذج الاختبارات المستخدمة كأمثلة ضمن مسار CI.

tools/ : البرامج النصية المساعدة المستخدمة لاستدعاء خطوط أنابيب ZenML ورمز الاستدلال:

run.py : برنامج نصي لنقطة الإدخال لتشغيل خطوط أنابيب ZenML.ml_service.py : يبدأ خادم استدلال REST API.rag.py : يوضح استخدام وحدة استرجاع RAG.data_warehouse.py : يستخدم لتصدير أو استيراد البيانات من مستودع بيانات MongoDB من خلال ملفات JSON. configs/ : ملفات تكوين ZenML YAML للتحكم في تنفيذ خطوط الأنابيب والخطوات.

code_snippets/ : أمثلة التعليمات البرمجية المستقلة التي يمكن تنفيذها بشكل مستقل.

ابدأ باستنساخ المستودع والانتقال إلى دليل المشروع:

git clone https://github.com/PacktPublishing/LLM-Engineers-Handbook.git

cd LLM-Engineers-Handbook بعد ذلك، يتعين علينا إعداد بيئة بايثون الخاصة بك والتبعيات المجاورة لها.

يتطلب المشروع بايثون 3.11. يمكنك إما استخدام تثبيت Python العالمي أو إعداد إصدار خاص بالمشروع باستخدام pyenv.

التحقق من إصدار بايثون الخاص بك:

python --version # Should show Python 3.11.x pyenv --version # Should show pyenv 2.3.36 or laterpyenv install 3.11.8python --version # Should show Python 3.11.8python --version

# Output: Python 3.11.8 ملحوظة

يتضمن المشروع ملف .python-version الذي يقوم تلقائيًا بتعيين إصدار Python الصحيح عندما تكون في دليل المشروع.

يستخدم المشروع الشعر لإدارة التبعية.

poetry --version # Should show Poetry version 1.8.3 or laterpoetry env use 3.11

poetry install --without aws

poetry run pre-commit installهذا سوف:

باعتبارنا مدير المهام لدينا، فإننا نقوم بتشغيل جميع البرامج النصية باستخدام Poe the Poet.

poetry shellpoetry poe ... إذا كنت تواجه مشاكل مع poethepoet ، فلا يزال بإمكانك تشغيل أوامر المشروع مباشرة من خلال الشعر. وإليك الطريقة:

pyproject.tomlpoetry run مع الأمر الأساسي بدلاً من:

poetry poe local-infrastructure-upاستخدم الأمر المباشر من pyproject.toml:

poetry run < actual-command-from-pyproject-toml >ملاحظة: يتم تعريف جميع أوامر المشروع في قسم [tool.poe.tasks] في pyproject.toml

الآن، دعونا نقوم بتكوين مشروعنا المحلي بجميع بيانات الاعتماد والرموز المميزة اللازمة لتشغيل التعليمات البرمجية محليًا.

بعد تثبيت كافة التبعيات، يجب عليك إنشاء ملف .env وملؤه ببيانات الاعتماد الخاصة بك للتفاعل بشكل مناسب مع الخدمات الأخرى وتشغيل المشروع. يعد تعيين بيانات الاعتماد الحساسة الخاصة بك في ملف .env ممارسة أمنية جيدة، حيث لن يتم الالتزام بهذا الملف على GitHub أو مشاركته مع أي شخص آخر.

cp .env.example .env # The file must be at your repository's root!.env للبدء. فيما يلي الإعدادات الإلزامية التي يجب علينا إكمالها عند العمل محليًا: للمصادقة على واجهة برمجة تطبيقات OpenAI، يجب عليك ملء OPENAI_API_KEY env var برمز المصادقة.

OPENAI_API_KEY = your_api_key_here→ راجع هذا البرنامج التعليمي لمعرفة كيفية توفير واحد من OpenAI.

للمصادقة على Hugging Face، يجب عليك ملء HUGGINGFACE_ACCESS_TOKEN env var برمز المصادقة.

HUGGINGFACE_ACCESS_TOKEN = your_token_here→ راجع هذا البرنامج التعليمي لمعرفة كيفية تقديم واحدة من Hugging Face.

للمصادقة على Comet ML (مطلوبة فقط أثناء التدريب) وOpik، يجب عليك ملء COMET_API_KEY env var برمز المصادقة المميز الخاص بك.

COMET_API_KEY = your_api_key_here→ راجع هذا البرنامج التعليمي لمعرفة كيفية الحصول على متغيرات Comet ML من الأعلى. يمكنك أيضًا الوصول إلى لوحة التحكم الخاصة بـ Opik باستخدام هذا الرابط.

عند نشر المشروع على السحابة، يجب علينا تعيين إعدادات إضافية لـ Mongo وQdrant وAWS. إذا كنت تعمل محليًا فقط، فستعمل القيم الافتراضية لمتغيرات env هذه خارج الصندوق. تتوفر تعليمات النشر التفصيلية في الفصل 11 من دليل مهندس LLM.

يجب علينا تغيير DATABASE_HOST env var بعنوان URL الذي يشير إلى مجموعة MongoDB السحابية الخاصة بك.

DATABASE_HOST = your_mongodb_url→ راجع هذا البرنامج التعليمي لمعرفة كيفية إنشاء واستضافة مجموعة MongoDB مجانًا.

قم بتغيير USE_QDRANT_CLOUD إلى true ، QDRANT_CLOUD_URL مع عنوان URL الذي يشير إلى مجموعة Qdrant السحابية، و QDRANT_APIKEY مع مفتاح API الخاص به.

USE_QDRANT_CLOUD = true

QDRANT_CLOUD_URL = your_qdrant_cloud_url

QDRANT_APIKEY = your_qdrant_api_key→ راجع هذا البرنامج التعليمي لمعرفة كيفية إنشاء مجموعة Qdrant مجانًا

لكي يعمل إعداد AWS الخاص بك بشكل صحيح، تحتاج إلى تثبيت AWS CLI على جهازك المحلي وتهيئته بشكل صحيح مع مستخدم مسؤول (أو مستخدم لديه أذونات كافية لإنشاء موارد SageMaker وECR وS3 جديدة؛ سيؤدي استخدام مستخدم مسؤول إلى اجعل كل شيء أكثر وضوحًا).

يوفر الفصل الثاني إرشادات خطوة بخطوة حول كيفية تثبيت AWS CLI، وإنشاء مستخدم إداري على AWS، والحصول على مفتاح وصول لإعداد متغيرات البيئة AWS_ACCESS_KEY و AWS_SECRET_KEY . إذا كان لديك بالفعل مستخدم مسؤول AWS، فيجب عليك تكوين env vars التالي في ملف .env الخاص بك:

AWS_REGION=eu-central-1 # Change it with your AWS region.

AWS_ACCESS_KEY=your_aws_access_key

AWS_SECRET_KEY=your_aws_secret_key عادةً ما يتم تخزين بيانات اعتماد AWS في ~/.aws/credentials . يمكنك عرض هذا الملف مباشرة باستخدام cat أو أوامر مشابهة:

cat ~ /.aws/credentialsمهم

تتوفر خيارات التكوين الإضافية في settings.py. يمكن تكوين أي متغير في فئة Settings من خلال ملف .env .

عند تشغيل المشروع محليًا، نستضيف قاعدة بيانات MongoDB وQdrant باستخدام Docker. كما يتم توفير خادم اختبار ZenML من خلال حزمة Python الخاصة بهم.

تحذير

تحتاج إلى تثبيت Docker (>= v27.1.1)

لسهولة الاستخدام، يمكنك بدء البنية التحتية للتطوير المحلي بالكامل باستخدام الأمر التالي:

poetry poe local-infrastructure-upيمكنك أيضًا إيقاف خادم ZenML وجميع حاويات Docker باستخدام الأمر التالي:

poetry poe local-infrastructure-downتحذير

عند التشغيل على نظام التشغيل MacOS، قبل بدء تشغيل الخادم، قم بتصدير متغير البيئة التالي: export OBJC_DISABLE_INITIALIZE_FORK_SAFETY=YES وإلا، سينقطع الاتصال بين الخادم المحلي وخط الأنابيب. ؟ مزيد من التفاصيل في هذا العدد. يتم ذلك بشكل افتراضي عند استخدام Poe the Poet.

ابدأ RESTful API للاستدلال في الوقت الفعلي:

poetry poe run-inference-ml-serviceمهم

ستعمل خدمة LLM الصغيرة، التي تستدعيها RESTful API، فقط بعد نشر LLM إلى AWS SageMaker.

عنوان URL للوحة المعلومات: localhost:8237

بيانات الاعتماد الافتراضية:

username : الافتراضيpassword :→ اكتشف المزيد حول استخدام وإعداد ZenML.

عنوان URL لواجهة برمجة تطبيقات REST: localhost:6333

عنوان URL للوحة المعلومات: localhost:6333/dashboard

→ اكتشف المزيد حول استخدام Qdrant وإعداده مع Docker.

عنوان URL لقاعدة البيانات: mongodb://llm_engineering:[email protected]:27017

اسم قاعدة البيانات: twin

بيانات الاعتماد الافتراضية:

username : llm_engineeringpassword : llm_engineering→ اكتشف المزيد حول استخدام MongoDB وإعداده باستخدام Docker.

يمكنك البحث في مجموعات MongoDB الخاصة بك باستخدام البرنامج الإضافي MongoDB الخاص بـ IDEs (الذي يتعين عليك تثبيته بشكل منفصل)، حيث يتعين عليك استخدام URI لقاعدة البيانات للاتصال بقاعدة بيانات MongoDB المستضافة داخل حاوية Docker: mongodb://llm_engineering:[email protected]:27017

مهم

لا يمكن تشغيل كل ما يتعلق بالتدريب أو تشغيل LLMs (على سبيل المثال، التدريب والتقييم والاستدلال) إلا إذا قمت بإعداد AWS SageMaker، كما هو موضح في القسم التالي حول البنية التحتية السحابية.

سنقدم هنا بسرعة كيفية نشر المشروع على AWS والخدمات الأخرى التي لا تحتوي على خادم. لن نخوض في التفاصيل (حيث أن كل شيء معروض في الكتاب) ولكننا سنشير فقط إلى الخطوات الرئيسية التي يتعين عليك اتباعها.

أولاً، أعد تثبيت تبعيات Python الخاصة بك مع مجموعة AWS:

poetry install --with awsملحوظة

يقدم الفصل العاشر إرشادات خطوة بخطوة في قسم "تنفيذ خدمة LLM الصغيرة باستخدام AWS SageMaker".

عند هذه النقطة، نتوقع أن يكون لديك AWS CLI مثبتًا وأن AWS CLI الخاص بك وenv vars للمشروع (ضمن ملف .env ) تم تكوينهما بشكل صحيح مع مستخدم مسؤول AWS.

لضمان أفضل الممارسات، يجب علينا إنشاء مستخدم AWS جديد يقتصر على إنشاء وحذف الموارد المتعلقة بـ AWS SageMaker فقط. قم بإنشائه عن طريق تشغيل:

poetry poe create-sagemaker-role سيتم إنشاء ملف sagemaker_user_credentials.json في جذر المستودع الخاص بك باستخدام قيم AWS_ACCESS_KEY و AWS_SECRET_KEY الجديدة. ولكن قبل استبدال بيانات اعتماد AWS الجديدة، قم أيضًا بتشغيل الأمر التالي لإنشاء دور التنفيذ (لإنشائه باستخدام بيانات اعتماد المسؤول الخاصة بك).

لإنشاء دور تنفيذ IAM الذي يستخدمه AWS SageMaker للوصول إلى موارد AWS الأخرى نيابة عنا، قم بتشغيل ما يلي:

poetry poe create-sagemaker-execution-role سيتم إنشاء ملف sagemaker_execution_role.json في جذر المستودع الخاص بك بقيمة AWS_ARN_ROLE الجديدة. أضفه إلى ملف .env الخاص بك.

بمجرد قيامك بتحديث قيم AWS_ACCESS_KEY و AWS_SECRET_KEY و AWS_ARN_ROLE في ملف .env الخاص بك، يمكنك استخدام AWS SageMaker. لاحظ أن هذه الخطوة ضرورية لإكمال إعداد AWS.

نبدأ مسار التدريب من خلال ZenML عن طريق تشغيل ما يلي:

poetry poe run-training-pipeline سيؤدي هذا إلى بدء كود التدريب باستخدام التكوينات من configs/training.yaml مباشرة في SageMaker. يمكنك تصور النتائج في لوحة معلومات Comet ML.

نبدأ مسار التقييم من خلال ZenML عن طريق تشغيل ما يلي:

poetry poe run-evaluation-pipeline سيؤدي هذا إلى بدء تشغيل رمز التقييم باستخدام التكوينات من configs/evaluating.yaml مباشرةً في SageMaker. يمكنك تصور النتائج في مجموعات بيانات *-results المحفوظة في ملف تعريف Hugging Face الخاص بك.

لإنشاء نقطة نهاية AWS SageMaker Inference، قم بتشغيل:

poetry poe deploy-inference-endpointلاختبار ذلك، قم بتشغيل:

poetry poe test-sagemaker-endpointلحذفه، قم بتشغيل:

poetry poe delete-inference-endpointيتم نشر مسارات تعلم الآلة والعناصر والحاويات إلى AWS من خلال الاستفادة من ميزات نشر ZenML. وبالتالي، يجب عليك إنشاء حساب مع ZenML Cloud واتباع الدليل الخاص بهم حول نشر حزمة ZenML إلى AWS. بخلاف ذلك، فإننا نقدم إرشادات خطوة بخطوة في الفصل 11 ، قسم نشر مسارات LLM Twin إلى السحابة حول ما يجب عليك فعله.

نحن نستفيد من خيارات Qdrant's وMongoDB بدون خادم عند نشر المشروع. وبالتالي، يمكنك إما اتباع دروس Qdrant's وMongoDB التعليمية حول كيفية إنشاء مجموعة freemium لكل منهما أو الانتقال إلى الفصل 11 ، قسم نشر مسارات LLM Twin إلى السحابة واتباع تعليماتنا خطوة بخطوة.

نحن نستخدم إجراءات GitHub لتنفيذ خطوط أنابيب CI/CD الخاصة بنا. لتنفيذ المستودع الخاص بك، يجب عليك إنشاء مستودع متشعب وتعيين env vars التالية كأسرار إجراءات في مستودعك المتشعب:

AWS_ACCESS_KEY_IDAWS_SECRET_ACCESS_KEYAWS_ECR_NAMEAWS_REGIONكما نقدم أيضًا تعليمات حول كيفية إعداد كل شيء في الفصل 11 ، قسم إضافة LLMOps إلى LLM Twin .

يمكنك تصور النتائج على لوحات المعلومات المستضافة ذاتيًا إذا قمت بإنشاء حساب Comet وقمت بتعيين COMET_API_KEY env var. نظرًا لأن Opik مدعوم من Comet، فلن يتعين عليك إعداد أي شيء آخر على طول Comet:

سيتم تنسيق جميع خطوط ML خلف الكواليس بواسطة ZenML. توجد بعض الاستثناءات عند تشغيل البرامج النصية المساعدة، مثل التصدير أو الاستيراد من مستودع البيانات.

تعد خطوط أنابيب ZenML نقطة الدخول لمعظم العمليات خلال هذا المشروع. هم تحت pipelines/ المجلد. وبالتالي، عندما تريد فهم سير العمل أو تصحيحه، فإن البدء بمسار ZenML هو أفضل أسلوب.

لرؤية خطوط الأنابيب قيد التشغيل ونتائجها:

Pipelinesfeature_engineering )feature_engineering_run_2024_06_20_18_40_24 )الآن، دعنا نستكشف جميع خطوط الأنابيب التي يمكنك تشغيلها. بدءًا من جمع البيانات وحتى التدريب، سنقدمها بترتيبها الطبيعي لمتابعة مشروع LLM من البداية إلى النهاية.

تشغيل ETL لجمع البيانات:

poetry poe run-digital-data-etlتحذير

يجب أن يكون لديك Chrome (أو متصفح آخر يستند إلى Chromium) مثبتًا على نظامك حتى تعمل برامج الزحف LinkedIn وMedium (التي تستخدم السيلينيوم تحت الغطاء). استنادًا إلى إصدار Chrome لديك، سيتم تثبيت برنامج Chromedriver تلقائيًا لتمكين دعم السيلينيوم. هناك خيار آخر وهو تشغيل كل شيء باستخدام صورة Docker الخاصة بنا إذا كنت لا ترغب في تثبيت Chrome. على سبيل المثال، لتشغيل جميع خطوط الأنابيب مجتمعة، يمكنك تشغيل poetry poe run-docker-end-to-end-data-pipeline . لاحظ أنه يمكن تعديل الأمر لدعم أي مسار آخر.

إذا لم يكن لديك متصفح يستند إلى Chromium مثبتًا، لأي سبب آخر، ولا تريد استخدام Docker، فلديك خياران آخران لتجاوز مشكلة السيلينيوم هذه:

chromedriver_autoinstaller.install() من application.crawlers.base والاستدعاءات الثابتة الأخرى التي تتحقق من وجود برامج تشغيل Chrome والسيلينيوم. لإضافة روابط إضافية للتجميع منها، انتقل إلى configs/digital_data_etl_[author_name].yaml وأضفها إلى حقل links . يمكنك أيضًا إنشاء ملف جديد تمامًا وتحديده في وقت التشغيل، مثل هذا: python -m llm_engineering.interfaces.orchestrator.run --run-etl --etl-config-filename configs/digital_data_etl_[your_name].yaml

قم بتشغيل خط الأنابيب الهندسي المميز:

poetry poe run-feature-engineering-pipelineإنشاء مجموعة بيانات التعليمات:

poetry poe run-generate-instruct-datasets-pipelineإنشاء مجموعة بيانات التفضيل:

poetry poe run-generate-preference-datasets-pipelineقم بتشغيل كل ما سبق مضغوطًا في خط أنابيب واحد:

poetry poe run-end-to-end-data-pipelineتصدير البيانات من مستودع البيانات إلى ملفات JSON:

poetry poe run-export-data-warehouse-to-json استيراد البيانات إلى مستودع البيانات من ملفات JSON (افتراضيًا، يقوم باستيراد البيانات من دليل data/data_warehouse_raw_data ):

poetry poe run-import-data-warehouse-from-jsonتصدير عناصر ZenML إلى JSON:

poetry poe run-export-artifact-to-json-pipeline سيؤدي هذا إلى تصدير عناصر ZenML التالية إلى مجلد output كملفات JSON (سوف يستغرق أحدث إصدار لها):

يمكنك تكوين العناصر المراد تصديرها عن طريق تعديل ملف التكوين configs/export_artifact_to_json.yaml .

تشغيل خط أنابيب التدريب:

poetry poe run-training-pipelineتشغيل مسار التقييم:

poetry poe run-evaluation-pipelineتحذير

لكي يعمل هذا، تأكد من تكوين AWS SageMaker بشكل صحيح كما هو موضح في إعداد البنية التحتية السحابية (للإنتاج).

اتصل بوحدة استرداد RAG باستخدام استعلام اختبار:

poetry poe call-rag-retrieval-moduleابدأ RESTful API للاستدلال في الوقت الفعلي:

poetry poe run-inference-ml-serviceاتصل بواجهة برمجة تطبيقات RESTful للاستدلال في الوقت الفعلي باستخدام استعلام اختبار:

poetry poe call-inference-ml-serviceتذكر أنه يمكنك مراقبة الآثار الفورية على Opik.

تحذير

لكي تعمل خدمة الاستدلال، يجب أن يكون لديك خدمة LLM الصغيرة المنتشرة على AWS SageMaker، كما هو موضح في قسم البنية التحتية السحابية للإعداد.

التحقق من مشاكل البطانة أو إصلاحها:

poetry poe lint-check

poetry poe lint-fixالتحقق من مشكلات التنسيق أو إصلاحها:

poetry poe format-check

poetry poe format-fixتحقق من الكود بحثًا عن بيانات الاعتماد المسربة:

poetry poe gitleaks-checkقم بإجراء كافة الاختبارات باستخدام الأمر التالي:

poetry poe test استنادًا إلى خطوات الإعداد والاستخدام الموضحة أعلاه، وبافتراض أن البنية التحتية المحلية والسحابية تعمل وتم تعبئة .env كما هو متوقع، اتبع الخطوات التالية لتشغيل نظام LLM من البداية إلى النهاية:

جمع البيانات: poetry poe run-digital-data-etl

ميزات الحساب: poetry poe run-feature-engineering-pipeline

حساب مجموعة بيانات التعليمات: poetry poe run-generate-instruct-datasets-pipeline

حساب مجموعة بيانات محاذاة التفضيلات: poetry poe run-generate-preference-datasets-pipeline

مهم

من الآن فصاعدًا، لكي تنجح هذه الخطوات، تحتاج إلى إعداد AWS SageMaker بشكل صحيح، مثل تشغيل poetry install --with aws وملء متغيرات وتكوينات البيئة المرتبطة بـ AWS.

SFT ضبط Llamma 3.1: poetry poe run-training-pipeline

بالنسبة إلى DPO، انتقل إلى configs/training.yaml ، وقم بتغيير finetuning_type إلى dpo ، وقم بتشغيل poetry poe run-training-pipeline مرة أخرى

تقييم النماذج المضبوطة بدقة: poetry poe run-evaluation-pipeline

مهم

من الآن فصاعدًا، لكي تنجح هذه الخطوات، تحتاج إلى إعداد AWS SageMaker بشكل صحيح، مثل تشغيل poetry install --with aws وملء متغيرات وتكوينات البيئة المرتبطة بـ AWS.

اتصل فقط بوحدة استرجاع RAG: poetry poe call-rag-retrieval-module

انشر خدمة LLM Twin الصغيرة إلى SageMaker: poetry poe deploy-inference-endpoint

اختبر الخدمة المصغرة LLM Twin: poetry poe test-sagemaker-endpoint

بدء تشغيل خادم RAG من طرف إلى طرف: poetry poe run-inference-ml-service

اختبار خادم RAG: poetry poe call-inference-ml-service

هذه الدورة عبارة عن مشروع مفتوح المصدر تم إصداره بموجب ترخيص MIT. وبالتالي، طالما قمت بتوزيع ترخيصنا والاعتراف بعملنا، يمكنك استنساخ هذا المشروع أو تفرعه بأمان واستخدامه كمصدر للإلهام لأي شيء تريده (على سبيل المثال، المشاريع الجامعية، ومشاريع الشهادات الجامعية، والمشاريع الشخصية، وما إلى ذلك).