إذا نظرنا إلى الوراء في عملية التعلم الماضية، فقد قدمت لي مقاطع الفيديو الخاصة بالمعلمين Ng Enda وLi Hongyi مساعدة كبيرة في رحلتي للتعلم المتعمق. إن أساليب الشرح الفكاهية والتفسيرات البسيطة والبديهية تجعل التعلم النظري الممل حيويًا ومثيرًا للاهتمام.

ومع ذلك، من الناحية العملية، سيشعر العديد من الطلاب بالقلق في البداية بشأن كيفية الحصول على واجهة برمجة التطبيقات (API) للنماذج الأجنبية الكبيرة. على الرغم من أنه يمكنهم في النهاية إيجاد حل، إلا أن الخوف من الصعوبة لأول مرة سيؤخر دائمًا تقدم التعلم ويتغير تدريجيًا من "مجرد مشاهدة الفيديو". غالبًا ما أرى مناقشات مماثلة في منطقة التعليقات، لذلك قررت استخدام وقت فراغي لمساعدة الطلاب على تجاوز هذه العتبة. وهذا أيضًا هو الهدف الأصلي للمشروع.

لن يقدم هذا المشروع برامج تعليمية حول الوصول العلمي إلى الإنترنت، ولن يعتمد على واجهات مخصصة للنظام الأساسي، وبدلاً من ذلك، سيستخدم OpenAI SDK الأكثر توافقًا لمساعدة الجميع على تعلم المزيد من المعرفة العامة.

سيبدأ المشروع باستدعاءات بسيطة لواجهة برمجة التطبيقات (API) وسيأخذك تدريجيًا إلى عالم النماذج الكبيرة. في هذه العملية، سوف تتقن مهارات مثل تلخيص فيديو الذكاء الاصطناعي ، وضبط LLM ، وتوليد الصور بالذكاء الاصطناعي .

يوصى بشدة بمشاهدة دورة المعلم Li Hongyi "مقدمة في الذكاء الاصطناعي التوليدي" للتعلم المتزامن: الوصول السريع إلى الروابط ذات الصلة بالدورة

الآن، يقدم المشروع أيضًا CodePlayground. يمكنك تكوين البيئة وفقًا للوثائق، وتشغيل البرنامج النصي بسطر واحد من التعليمات البرمجية، وتجربة سحر الذكاء الاصطناعي.

توجد مقالات الأطروحات في PaperNotes، وسيتم تحميل الأوراق الأساسية المتعلقة بالنماذج الكبيرة تدريجيًا.

الصورة الأساسية جاهزة إذا لم تقم بتكوين بيئة التعلم العميق الخاصة بك، فيمكنك أيضًا تجربة Docker.

أتمنى لك رحلة جميلة!

--- : المعرفة الأساسية، شاهدها حسب الحاجة، أو قم بتخطيها مؤقتًا. سيتم عرض نتائج ملف التعليمات البرمجية في المقالة، ولكن لا يزال يوصى بتشغيل التعليمات البرمجية يدويًا. قد تكون هناك متطلبات لذاكرة الفيديو.API : تستخدم المقالة واجهة برمجة التطبيقات للنماذج الكبيرة فقط، ولا تخضع لقيود الجهاز، ويمكن تشغيلها بدون وحدة معالجة الرسومات.LLM : الممارسة المتعلقة بنماذج اللغات الكبيرة، قد تتطلب ملفات التعليمات البرمجية متطلبات ذاكرة الفيديو.SD : الانتشار المستقر، وهو ممارسة تتعلق بالمخططات الفينسنتية، وملفات التعليمات البرمجية لها متطلبات ذاكرة فيديو.File وسيكون تأثير التعلم هو نفسه.Setting -> Accelerator ->选择GPU .代码执行程序->更改运行时类型->选择GPU .| مرشد | علامة | يصف | ملف | متصل |

|---|---|---|---|---|

| 00. خطوات الحصول على API Big Model API | واجهة برمجة التطبيقات | سنأخذك خطوة بخطوة للحصول على واجهة برمجة التطبيقات (API). إذا كانت هذه هي المرة الأولى التي تقوم فيها بالتسجيل، فستحتاج إلى إجراء التحقق من الهوية (التعرف على الوجه). | ||

| 01. المقدمة الأولى لـ LLM API: تكوين البيئة وعرض الحوار متعدد الجولات | واجهة برمجة التطبيقات | هذا تكوين تمهيدي وعرض توضيحي تم تعديل رمز المحادثة من مستندات تطوير Alibaba. | شفرة | كاجل كولاب |

| 02. سهولة البدء: قم ببناء تطبيقات الذكاء الاصطناعي من خلال واجهة برمجة التطبيقات (API) وGradio | واجهة برمجة التطبيقات | قم بتوجيه كيفية استخدام Gradio لإنشاء تطبيق AI بسيط. | شفرة | كولاب |

| 03. الدليل المتقدم: تخصيص المطالبة لتحسين قدرات حل مشكلات النماذج الكبيرة | واجهة برمجة التطبيقات | سوف تتعلم كيفية تخصيص موجه لتحسين قدرة النماذج الكبيرة على حل المشكلات الرياضية، كما سيتم توفير إصدارات Gradio وغير Gradio، وسيتم عرض تفاصيل التعليمات البرمجية. | شفرة | كاجل كولاب |

| 04. فهم LoRA: من الطبقة الخطية إلى آلية الانتباه | --- | قبل الدخول رسميًا في الممارسة، تحتاج إلى معرفة المفاهيم الأساسية لـ LoRA. ستأخذك هذه المقالة من تطبيق LoRA للطبقة الخطية إلى آلية الانتباه. | ||

05. فهم سلسلة AutoModel الخاصة بـ Hugging Face: فئات التحميل التلقائي للنماذج لمهام مختلفة | --- | الوحدة التي نحن على وشك استخدامها هي AutoModel في Hugging Face. هذه المقالة هي أيضًا معرفة أساسية (بالطبع يمكنك تخطيها وقراءتها لاحقًا عندما تكون لديك شكوك). | شفرة | كاجل كولاب |

| 06. ابدأ: انشر نموذج لغتك الأولى | ماجستير | من خلال تنفيذ نشر نموذج لغة أساسي جدًا، لا يحتوي المشروع على متطلبات صعبة لوحدة معالجة الرسومات حتى الآن، ويمكنك الاستمرار في التعلم. | شفرة app_fastapi.py app_flask.py | |

| 07. استكشاف العلاقة بين معلمات النموذج وذاكرة الفيديو وتأثير الدقة المختلفة | --- | إن فهم المراسلات بين معلمات النموذج وذاكرة الفيديو وإتقان طرق الاستيراد ذات الدقة المختلفة سيجعل اختيار النموذج الخاص بك أكثر مهارة. | ||

| 08. حاول ضبط LLM: دعه يكتب شعر تانغ | ماجستير | هذه المقالة هي نفس المقالة 03. الدليل المتقدم: تخصيص المطالبة لتحسين قدرات حل المشكلات للنموذج الكبير، وهو يركز بشكل أساسي على "الاستخدام" بدلاً من "الكتابة". قسم المعلمات الفائقة لمعرفة التأثير على الضبط الدقيق. | شفرة | كاجل كولاب |

| 09. فهم متعمق لـ Beam Search: المبادئ والأمثلة وتنفيذ التعليمات البرمجية | --- | بالانتقال من الأمثلة إلى العروض التوضيحية للكود، وشرح رياضيات Beam Search، يجب أن يزيل هذا بعض الالتباس من القراءة السابقة، وأخيرًا يقدم مثالًا بسيطًا لاستخدام مكتبة Hugging Face Transformers (يمكنك تجربتها إذا تخطيت المقالة السابقة) . | شفرة | كاجل كولاب |

| 10. Top-K vs Top-P: استراتيجية أخذ العينات وتأثير درجة الحرارة في النماذج التوليدية | --- | علاوة على ذلك لتظهر لك استراتيجيات الجيل الأخرى. | شفرة | كاجل كولاب |

| 11. مثال الضبط الدقيق لـ DPO: تحسين نموذج اللغة الكبير LLM وفقًا لتفضيلات الإنسان | ماجستير | مثال على الضبط الدقيق باستخدام DPO. | شفرة | كاجل كولاب |

| 12. إسناد ميزة Inseq: تفسير مخرجات LLM بصريًا | ماجستير | أمثلة مرئية لمهام الترجمة وإنشاء النص (ملء الفراغات). | شفرة | كاجل كولاب |

| 13. فهم التحيزات المحتملة في الذكاء الاصطناعي | ماجستير | ليس هناك حاجة إلى فهم الكود، ويمكن استخدامه كاستكشاف ممتع أثناء وقت الفراغ. | شفرة | كاجل كولاب |

| 14. PEFT: قم بتطبيق LoRA بسرعة على النماذج الكبيرة | --- | تعرف على كيفية إضافة طبقات LoRA بعد استيراد النموذج. | شفرة | كاجل كولاب |

| 15. استخدم واجهة برمجة التطبيقات (API) لتنفيذ ملخص فيديو الذكاء الاصطناعي: اصنع مساعد فيديو الذكاء الاصطناعي الخاص بك | API و LLM | سوف تتعلم المبادئ الكامنة وراء مساعدي ملخص فيديو الذكاء الاصطناعي الشائعين وتبدأ في تنفيذ تلخيص فيديو الذكاء الاصطناعي. | الكود - النسخة الكاملة الكود - الإصدار البسيط ؟النص | كاجل كولاب |

| 16. استخدم LoRA لضبط الانتشار المستقر: قم بتفكيك فرن الكيمياء وتنفيذ أول لوحة للذكاء الاصطناعي | SD | استخدم LoRA لضبط نموذج مخطط Vincent، والآن يمكنك أيضًا تقديم ملفات LoRA الخاصة بك للآخرين. | شفرة الكود - الإصدار البسيط | كاجل كولاب |

| 17. مناقشة مختصرة حول تكميم نموذج RTN: غير المتماثل مقابل المتماثل.md | --- | لفهم سلوك القياس الكمي لنموذج RTN بشكل أكبر، تستخدم هذه المقالة INT8 كمثال للشرح. | شفرة | كاجل كولاب |

| 18. نظرة عامة على تقنية القياس الكمي النموذجي وتحليل تنسيق ملف GGUF/GGML | --- | هذه مقالة عامة قد تحل بعض شكوكك عند استخدام GGUF/GGML. | ||

| 19أ. من التحميل إلى المحادثة: تشغيل نماذج LLM الكبيرة الكمية (GPTQ وAWQ) محليًا باستخدام المحولات 19 ب. من التحميل إلى المحادثة: تشغيل نماذج LLM الكبيرة (GGUF) محليًا باستخدام Llama-cpp-python | ماجستير | ستقوم بنشر نموذج كمي يحتوي على 7 مليارات (7B) من المعلمات على جهاز الكمبيوتر الخاص بك. لاحظ أن هذه المقالة لا تتطلب بطاقة رسومات. 19 أ استخدام المحولات، بما في ذلك تحميل النماذج بتنسيقات GPTQ وAWQ. 19 ب استخدام Llama-cpp-python، بما في ذلك تحميل النموذج بتنسيق GGUF. بالإضافة إلى ذلك، ستكمل أيضًا وظيفة تفاعل حوار النماذج الكبيرة المحلية. | محولات الكود Code-Llama-cpp-python ؟النص | |

| 20. الممارسة التمهيدية لفريق RAG: من تقسيم المستندات إلى قاعدة البيانات المتجهة وبناء الأسئلة والأجوبة | ماجستير | الممارسات ذات الصلة بـ RAG. تعرف على كيفية عمل تقطيع النص العودي. | شفرة | |

| 21. BPE vs WordPiece: فهم مبدأ عمل Tokenizer وطريقة تجزئة الكلمات الفرعية | --- | العمليات الأساسية للTokenizer. تعرف على طرق تجزئة الكلمات الفرعية الشائعة: BPE وWordPiece. فهم قناع الانتباه (قناع الانتباه) ومعرفات نوع الرمز المميز (معرفات نوع الرمز المميز). | شفرة | كاجل كولاب |

| 22. المهمة - بيرت يضبط الإجابة على الأسئلة الاستخراجية | هذه مهمة تستخدم BERT لضبط مهام الأسئلة والأجوبة النهائية. يمكنك تجربتها ومحاولة الانضمام إلى "مسابقة" Kaggle. سيتم تقديم مقال إرشادي يتضمن جميع النصائح بعد أسبوع. يمكنك اختيار الدراسة الآن أو اتركه لوقت لاحق. لن تغطي المقالة التمهيدية وصف المهمة، وسيتم تحميل نسختين من الكود للتعلم، فلا تقلق. لن يكون هناك موعد نهائي هنا. | الكود - المهمة | كاجل كولاب |

نصيحة

إذا كنت تفضل سحب المستودع لقراءة .md محليًا، فعند حدوث خطأ في الصيغة، يرجى استخدام Ctrl+F أو Command+F ، والبحث عن \_ واستبدال الكل بـ _ .

مزيد من القراءة:

| مرشد | يصف |

|---|---|

| أ. استخدم HFD لتسريع تنزيل نماذج Hugging Face ومجموعات البيانات | إذا كنت تشعر أن تنزيل النموذج بطيء جدًا، فيمكنك الرجوع إلى هذه المقالة للتكوين. إذا واجهت أخطاء 443 متعلقة بالخادم الوكيل، فيمكنك أيضًا محاولة مراجعة هذه المقالة. |

| ب. فحص سريع لأوامر سطر الأوامر الأساسية (ينطبق على Linux/Mac) | يحتوي الفحص السريع لأوامر سطر الأوامر بشكل أساسي على جميع الأوامر الموجودة في المستودع الحالي. قم بفحصها عندما تكون في حيرة من أمرك. |

| ج.حلول لبعض المشاكل | وسنقوم هنا بحل بعض المشاكل التي قد تواجهكم أثناء تشغيل المشروع. - كيفية سحب المستودع البعيد لاستبدال كافة التعديلات المحلية؟ - كيفية عرض وحذف الملفات التي تم تنزيلها بواسطة Hugging Face، وكيفية تعديل مسار الحفظ؟ |

| د. كيفية تحميل نموذج GGUF (حل Shared/Shared/Split/00001-of-0000...) | - تعرف على الميزات الجديدة لبرنامج Transformers حول GGUF. - استخدم Transformers/Llama-cpp-python/Ollama لتحميل ملفات النماذج بتنسيق GGUF. - تعلم كيفية دمج ملفات GGUF المجزأة. - حل مشكلة عدم إمكانية إلغاء تحميل LLama-cpp-python. |

| هـ. تحسين البيانات: تحليل الأساليب الشائعة لتحويلات torchvision | - فهم طرق تحسين بيانات الصورة شائعة الاستخدام. كود | |

| f. وظيفة الخسارة عبر الإنتروبيا nn.CrossEntropyLoss() شرح مفصل وتذكير بالنقاط الرئيسية (PyTorch) | - فهم المبادئ الرياضية لخسارة الإنتروبيا المتقاطعة وتنفيذ PyTorch. - تعرف على ما يجب الانتباه إليه عند استخدامه لأول مرة. |

| ز. طبقة التضمين nn.Embedding() شرح مفصل وتذكير بالنقاط الرئيسية (PyTorch) | - التعرف على مفاهيم تضمين الطبقات وتضمين الكلمات. - تصور التضمين باستخدام نماذج مدربة مسبقًا. كود | |

| ح. استخدم Docker لتكوين بيئة التعلم العميق (Linux) بسرعة ح. مقدمة إلى أوامر Docker الأساسية وحل الأخطاء الشائعة | - استخدم سطرين من الأوامر لتكوين بيئة التعلم العميق - مقدمة لأوامر Docker الأساسية - حل ثلاثة أخطاء شائعة أثناء الاستخدام |

شرح المجلد:

العروض التوضيحية

سيتم تخزين كافة ملفات التعليمات البرمجية هناك.

بيانات

ليست هناك حاجة إلى الاهتمام بهذا المجلد لتخزين البيانات الصغيرة التي يمكن استخدامها في الكود.

GenAI_PDF

فيما يلي ملفات PDF الخاصة بمهام الدورة التدريبية [مقدمة إلى الذكاء الاصطناعي التوليدي]. لقد قمت بتحميلها لأنه تم حفظها في الأصل في Google Drive.

مرشد

سيتم وضع جميع وثائق التوجيه هناك.

أصول

فيما يلي الصور المستخدمة في ملف .md، ليست هناك حاجة إلى الاهتمام بهذا المجلد.

ملاحظات ورقية

مقالة الأطروحة.

CodePlayground

بعض أمثلة البرامج النصية المثيرة للاهتمام (إصدار اللعبة).

التمهيدي.md

Summaryr.py ?script

AI الفيديو / الصوت / تلخيص الترجمة.

chat.py ؟ البرنامج النصي

محادثة الذكاء الاصطناعي.

مقدمة إلى مصادر تعلم الذكاء الاصطناعي التوليدي

الصفحة الرئيسية للدورة

الفيديو الرسمي |

تمت الموافقة على إنتاج ومشاركة النسخة المرآة الصينية من قبل المعلم Li Hongyi، شكرًا للمعلم على مشاركتك المتفانية للمعرفة!

ستدرك صورة PS الصينية جميع وظائف رمز الوظيفة (التشغيل المحلي) بشكل كامل. Kaggle عبارة عن منصة عبر الإنترنت يمكن توصيلها مباشرة في الصين. يتوافق محتوى Colab الصيني وKaggle مع الوظيفة الأصلية. ما عليك سوى اختيار واحد منهم لإكمال الدراسة.

وفقًا للاحتياجات الفعلية، حدد طريقة من الأسفل لإعداد بيئة التعلم، وانقر فوق ► أو أرسل نصًا للتوسيع .

Kaggle (اتصال محلي مباشر، موصى به): اقرأ المقالة "Kaggle: دليل استخدام GPU المجاني، بديل مثالي لـ Colab" لمعرفة المزيد.

Colab (يتطلب الوصول إلى الإنترنت العلمي)

تتم مزامنة ملفات التعليمات البرمجية في المشروع على كلا النظامين الأساسيين.

لينكس (أوبونتو) :

sudo apt-get update

sudo apt-get install gitماك :

قم بتثبيت Homebrew أولاً:

/bin/bash -c " $( curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh ) "ثم قم بتشغيل:

brew install gitويندوز :

قم بالتنزيل والتثبيت من Git لنظام التشغيل Windows.

لينكس (أوبونتو) :

sudo apt-get update

sudo apt-get install wget curlماك :

brew install wget curlويندوز :

قم بالتنزيل والتثبيت من مواقع Wget for Windows وCurl الرسمية.

قم بزيارة موقع Anaconda الرسمي، وأدخل عنوان بريدك الإلكتروني وتحقق من بريدك الإلكتروني، ومن المفترض أن تتمكن من رؤية:

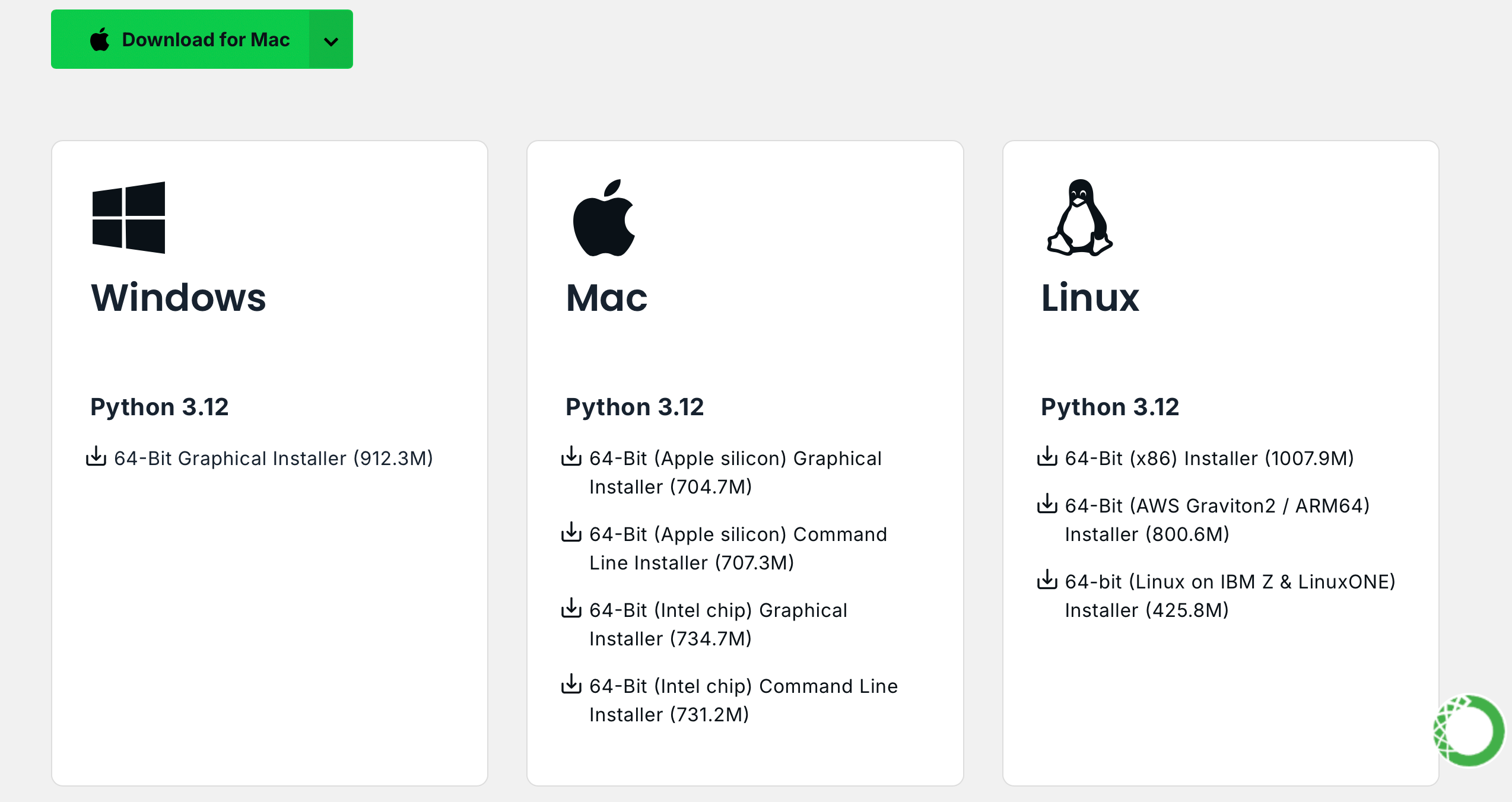

انقر فوق Download Now وحدد الإصدار المناسب وقم بتنزيله (يتوفر كل من Anaconda و Miniconda):

لينكس (أوبونتو) :

تثبيت اناكوندا

تفضل بزيارة repo.anaconda.com لاختيار الإصدار.

# 下载 Anaconda 安装脚本(以最新版本为例)

wget https://repo.anaconda.com/archive/Anaconda3-2024.10-1-Linux-x86_64.sh

# 运行安装脚本

bash Anaconda3-2024.10-1-Linux-x86_64.sh

# 按照提示完成安装(先回车,空格一直翻页,翻到最后输入 yes,回车)

# 安装完成后,刷新环境变量或者重新打开终端

source ~ /.bashrcتثبيت Miniconda (مستحسن)

تفضل بزيارة repo.anaconda.com/miniconda لاختيار الإصدار. Miniconda هي نسخة مبسطة من Anaconda، تحتوي فقط على Conda وPython.

# 下载 Miniconda 安装脚本

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

# 运行安装脚本

bash Miniconda3-latest-Linux-x86_64.sh

# 按照提示完成安装(先回车,空格一直翻页,翻到最后输入 yes,回车)

# 安装完成后,刷新环境变量或者重新打开终端

source ~ /.bashrcماك :

في المقابل، استبدل عنوان URL في أمر Linux.

تثبيت اناكوندا

تفضل بزيارة repo.anaconda.com لاختيار الإصدار.

تثبيت Miniconda (مستحسن)

تفضل بزيارة repo.anaconda.com/miniconda لاختيار الإصدار.

أدخل الأمر التالي في الجهاز إذا تم عرض معلومات الإصدار، فهذا يعني أن التثبيت ناجح.

conda --versioncat << ' EOF ' > ~/.condarc

channels:

- defaults

show_channel_urls: true

default_channels:

- https://mirror.nju.edu.cn/anaconda/pkgs/main

- https://mirror.nju.edu.cn/anaconda/pkgs/r

- https://mirror.nju.edu.cn/anaconda/pkgs/msys2

custom_channels:

conda-forge: https://mirror.nju.edu.cn/anaconda/cloud

pytorch: https://mirror.nju.edu.cn/anaconda/cloud

EOF[!ملحوظة]

العديد من مصادر النسخ المتطابقة التي كانت متوفرة في العام الماضي لم تعد متوفرة للحصول على التكوين الحالي لمواقع النسخ المتطابقة الأخرى، يمكنك الرجوع إلى هذا المستند الجميل جدًا من NTU: تعليمات استخدام المرآة.

ملاحظة : إذا تم تثبيت Anaconda أو Miniconda بالفعل، فسيتم تضمين pip في النظام ولا يلزم أي تثبيت إضافي.

لينكس (أوبونتو) :

sudo apt-get update

sudo apt-get install python3-pipماك :

brew install python3ويندوز :

قم بتنزيل Python وتثبيته، مع التأكد من تحديد خيار "Add Python to PATH".

افتح موجه الأوامر وأدخل:

python -m ensurepip --upgradeأدخل الأمر التالي في الجهاز إذا تم عرض معلومات الإصدار، فهذا يعني أن التثبيت ناجح.

pip --versionpip config set global.index-url https://mirrors.aliyun.com/pypi/simpleاسحب المشروع بالأمر التالي:

git clone https://github.com/Hoper-J/AI-Guide-and-Demos-zh_CN.git

cd AI-Guide-and-Demos-zh_CNلا يوجد حد للإصدار، يمكن أن يكون أعلى:

conda create -n aigc python=3.9 اضغط على y وأدخل للمتابعة. بعد اكتمال الإنشاء، قم بتنشيط البيئة الافتراضية:

conda activate aigcبعد ذلك، تحتاج إلى تثبيت التبعيات الأساسية، راجع موقع PyTorch الرسمي، مع أخذ CUDA 11.8 كمثال (إذا كانت بطاقة الرسومات لا تدعم 11.8، فستحتاج إلى تغيير الأمر)، واختر أحد الاثنين للتثبيت:

# pip

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

# conda

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidiaلقد نجحنا الآن في تكوين جميع البيئات المطلوبة ونحن على استعداد لبدء التعلم :) وسيتم إدراج التبعيات المتبقية بشكل منفصل في كل مقالة.

[!ملحوظة]

تحتوي صور Docker على تبعيات مثبتة مسبقًا، لذلك ليست هناك حاجة لإعادة تثبيتها.

قم أولاً بتثبيت jupyter-lab ، وهو أسهل بكثير في الاستخدام من jupyter notebook .

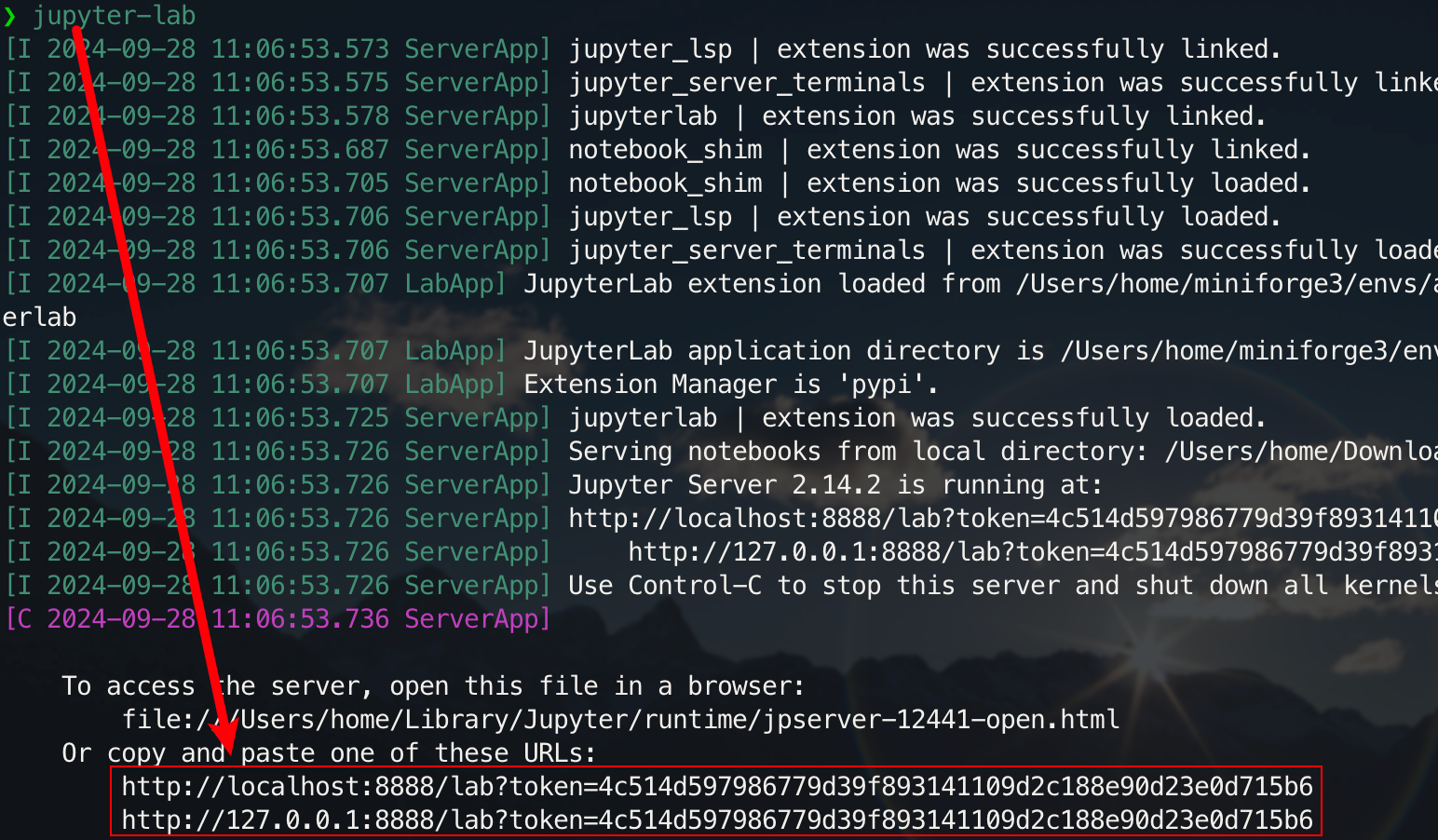

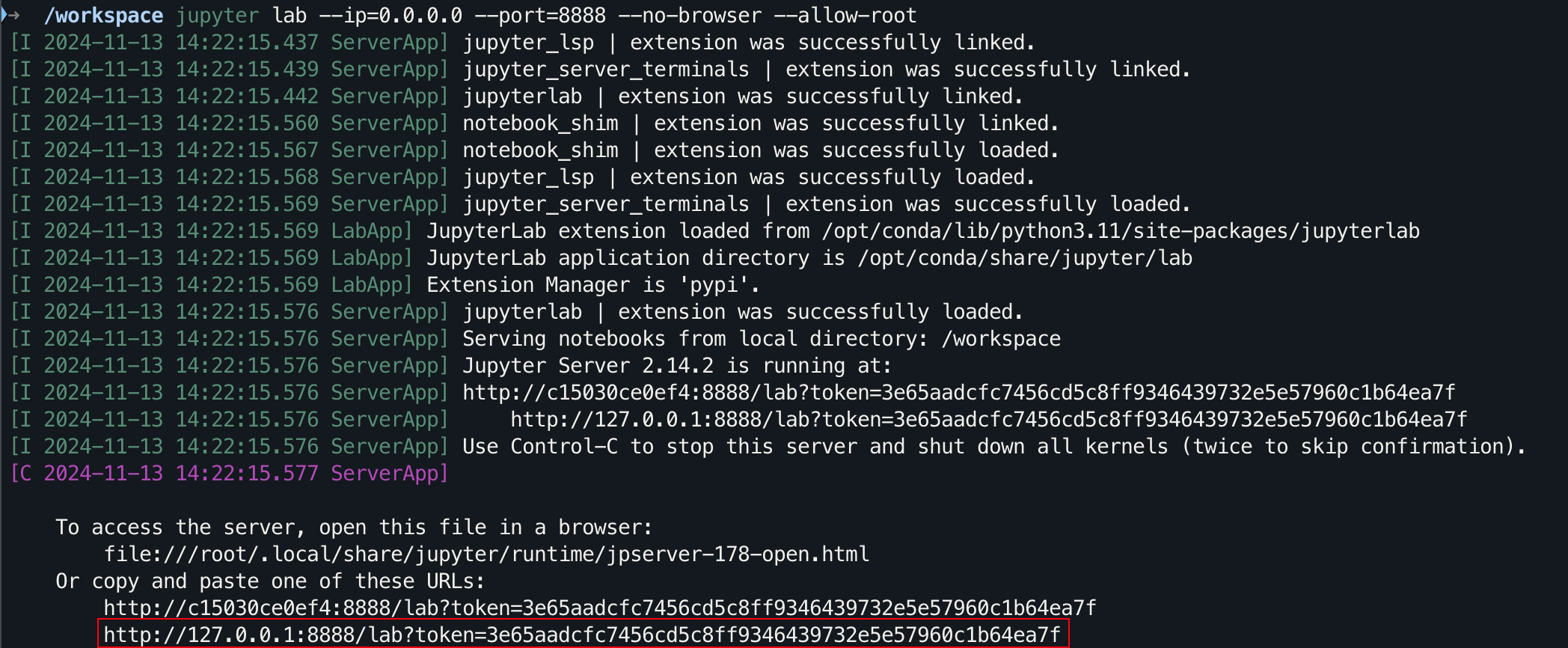

pip install jupyterlabبعد اكتمال التثبيت، قم بتنفيذ الأمر التالي:

jupyter-lab

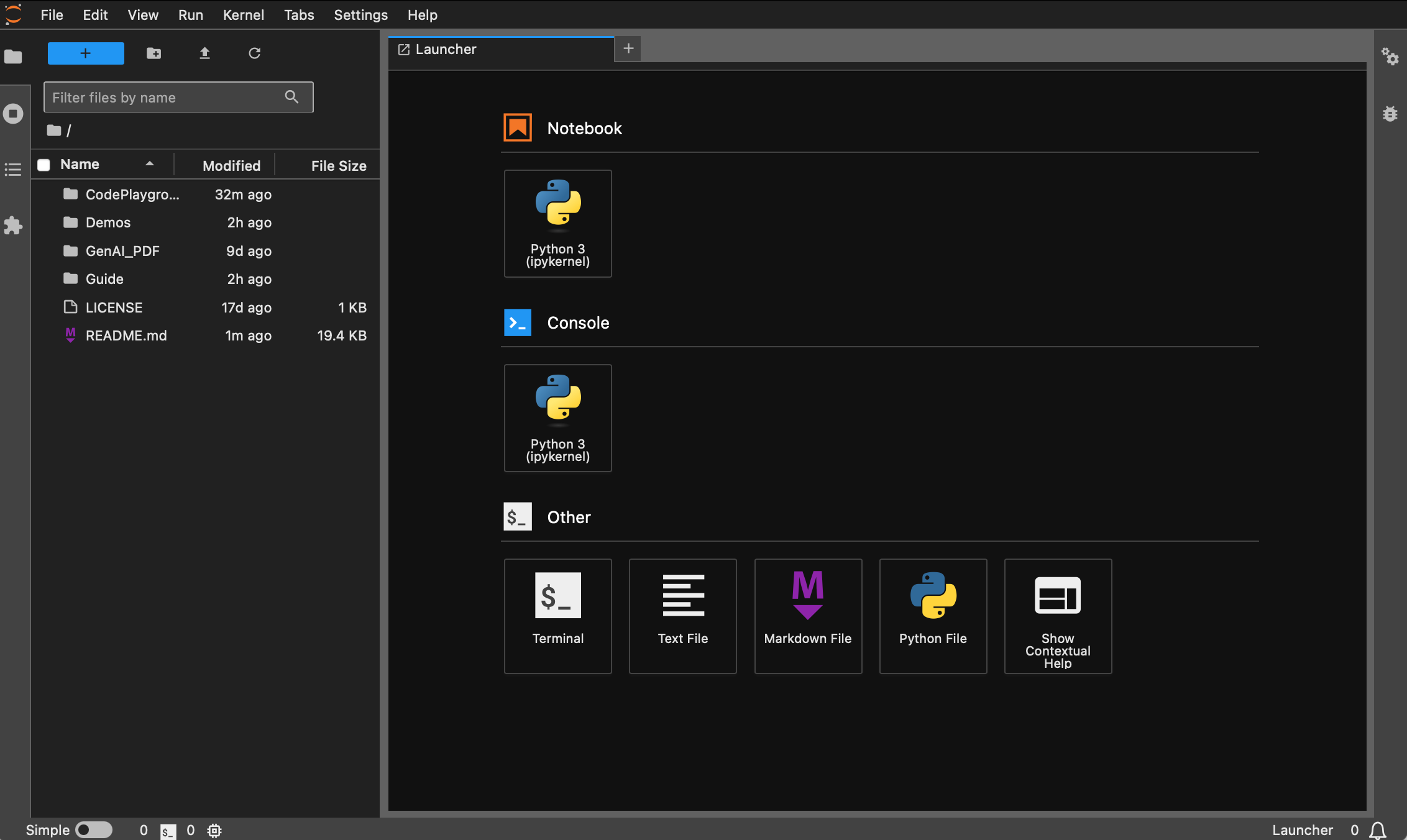

ستتمكن الآن من الوصول إليه من خلال الرابط المنبثق، الموجود عادة على المنفذ 8888. بالنسبة للواجهة الرسومية، اضغط باستمرار على Ctrl على نظامي التشغيل Windows/Linux، واضغط باستمرار على Command على نظام Mac، ثم انقر فوق الرابط للانتقال مباشرة. في هذه المرحلة، سوف تحصل على الصورة الكاملة للمشروع:

يمكن للطلاب الذين لم يقوموا بتثبيت Docker قراءة المقالة "استخدام Docker لتكوين بيئة التعلم العميق بسرعة (Linux)". يُنصح المبتدئون بقراءة "مقدمة لأوامر Docker الأساسية وحل الأخطاء الشائعة".

تم تثبيت جميع الإصدارات مسبقًا بأدوات شائعة مثل sudo و pip و conda و wget و curl و vim ، كما تم تكوين مصادر الصور المحلية لـ pip و conda . وفي الوقت نفسه، فهو يدمج zsh وبعض المكونات الإضافية العملية لسطر الأوامر (الإكمال التلقائي للأوامر، وتمييز بناء الجملة، وأداة الانتقال إلى الدليل z ). بالإضافة إلى ذلك، تم تثبيت jupyter notebook ومختبر jupyter lab مسبقًا، وتم ضبط المحطة الافتراضية على zsh لتسهيل تطوير التعلم العميق. تم تحسين العرض الصيني في الحاوية لتجنب الأحرف المشوهة. تم أيضًا تكوين عنوان المرآة المحلي لـ Hugging Face مسبقًا.

pytorch/pytorch:2.5.1-cuda11.8-cudnn9-devel إصدار python الافتراضي هو 3.11.10، ويمكن تعديل الإصدار مباشرة من خلال conda install python==版本号.التثبيت المناسب :

wget ، curl : أدوات تنزيل سطر الأوامرvim ، nano : محرر النصوصgit : أداة التحكم في الإصدارgit-lfs : Git LFS (مساحة تخزين الملفات الكبيرة)zip ، unzip : أدوات ضغط الملفات وإلغاء الضغطhtop : أداة مراقبة النظامtmux ، screen : أدوات إدارة الجلسةbuild-essential : أدوات الترجمة (مثل gcc و g++ )iputils-ping و iproute2 و net-tools : أدوات الشبكة (توفير أوامر مثل ping و ip و ifconfig و netstat وما إلى ذلك)ssh : أداة الاتصال عن بعدrsync : أداة مزامنة الملفاتtree : عرض أشجار الملفات والدليلlsof : عرض الملفات المفتوحة حاليًا على النظامaria2 : أداة تنزيل متعددة الخيوطlibssl-dev : مكتبة تطوير OpenSSLتركيب النقطة :

jupyter notebook ، jupyter lab : بيئة التطوير التفاعليةvirtualenv : أداة إدارة البيئة الافتراضية لـ Python، يمكنك استخدام conda مباشرةtensorboard : أداة تصور التدريب على التعلم العميقipywidgets : مكتبة أدوات Jupyter لعرض أشرطة التقدم بشكل صحيحالبرنامج المساعد :

zsh-autosuggestions : الإكمال التلقائي للأوامرzsh-syntax-highlighting : تسليط الضوء على بناء الجملةz : انتقل بسرعة إلى الدليليعتمد إصدار dl (التعلم العميق) على القاعدة ويقوم أيضًا بتثبيت الأدوات والمكتبات الأساسية التي يمكن استخدامها في التعلم العميق:

التثبيت المناسب :

ffmpeg : أداة معالجة الصوت والفيديوlibgl1-mesa-glx : تبعية مكتبة الرسومات (حل بعض المشكلات المتعلقة بالرسومات في إطار التعلم العميق)تركيب النقطة :

numpy ، scipy : الحسابات العددية والحسابات العلميةpandas : تحليل البياناتmatplotlib ، seaborn : تصور البياناتscikit-learn : أدوات التعلم الآليtensorflow ، tensorflow-addons : إطار عمل شائع آخر للتعلم العميقtf-keras : تنفيذ TensorFlow لواجهة Kerastransformers datasets : أدوات البرمجة اللغوية العصبية المقدمة من Hugging Facenltk ، spacy : أدوات معالجة اللغة الطبيعيةإذا كانت هناك حاجة إلى مكتبات إضافية، فيمكن تثبيتها يدويًا باستخدام الأمر التالي:

pip install --timeout 120 <替换成库名> هنا --timeout 120 يضبط مهلة قدرها 120 ثانية للتأكد من أنه لا يزال هناك وقت كافٍ للتثبيت حتى لو كانت الشبكة ضعيفة. إذا لم تقم بإعداده، فقد تواجه موقفًا تفشل فيه حزمة التثبيت بسبب انتهاء مهلة التنزيل في بيئة محلية.

لاحظ أن جميع الصور لن تسحب المستودع مقدما.

بافتراض أنك قمت بتثبيت Docker وتكوينه، image_name:tag تحتاج فقط إلى سطرين من الأوامر لإكمال تكوين بيئة التعلم العميق للمشروع الحالي، ويمكنك تحديده بعد عرض وصف الإصدار يلي:

hoperj/quickstart:base-torch2.5.1-cuda11.8-cudnn9-develhoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-develأمر السحب هو:

docker pull < image_name:tag >يستخدم ما يلي إصدار dl كمثال لتوضيح الأمر. اختر إحدى الطرق لإكمالها.

docker pull dockerpull.org/hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-develdocker pull hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-develيمكن تنزيل الملفات من خلال Baidu Cloud Disk (لا يدعم Alibaba Cloud Disk مشاركة الملفات المضغوطة الكبيرة).

الملفات التي تحمل نفس الاسم لها نفس المحتوى.

.tar.gzهو نسخة مضغوطة بعد التنزيل، قم بفك ضغطها باستخدام الأمر التالي:gzip -d dl.tar.gz

بافتراض dl.tar إلى ~/Downloads ، ثم قم بالتبديل إلى الدليل المقابل:

cd ~ /Downloadsثم قم بتحميل الصورة:

docker load -i dl.tarفي هذا الوضع، ستستخدم الحاوية تكوين شبكة المضيف مباشرة، وستكون جميع المنافذ مساوية لمنافذ المضيف دون تعيين منفصل. إذا كنت بحاجة فقط إلى تعيين منفذ معين، فاستبدل

--network hostبـ-p port:port.

docker run --gpus all -it --name ai --network host hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-devel /bin/zsh بالنسبة للطلاب الذين يحتاجون إلى استخدام وكيل، أضف -e لتعيين متغيرات البيئة. يمكنك أيضًا الرجوع إلى المقالة الموسعة أ:

افترض أن رقم منفذ HTTP/HTTPS الخاص بالوكيل هو 7890 وأن SOCKS5 هو 7891:

-e http_proxy=http://127.0.0.1:7890-e https_proxy=http://127.0.0.1:7890-e all_proxy=socks5://127.0.0.1:7891مدمج في الأمر السابق:

docker run --gpus all -it

--name ai

--network host

-e http_proxy=http://127.0.0.1:7890

-e https_proxy=http://127.0.0.1:7890

-e all_proxy=socks5://127.0.0.1:7891

hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-devel

/bin/zsh[!نصيحة]

تحقق من العمليات المشتركة مقدما :

- ابدأ الحاوية :

docker start <容器名>- قم بتشغيل الحاوية :

docker exec -it <容器名> /bin/zsh

- الخروج داخل الحاوية :

Ctrl + Dأوexit.- أوقف الحاوية :

docker stop <容器名>- حذف حاوية :

docker rm <容器名>

git clone https://github.com/Hoper-J/AI-Guide-and-Demos-zh_CN.git

cd AI-Guide-and-Demos-zh_CNjupyter lab --ip=0.0.0.0 --port=8888 --no-browser --allow-root

بالنسبة للواجهة الرسومية، اضغط باستمرار على Ctrl على نظامي التشغيل Windows/Linux، واضغط باستمرار على Command على نظام Mac، ثم انقر فوق الرابط للانتقال مباشرة.

شكرا لنجمك؟، وآمل أن يساعد هذا.