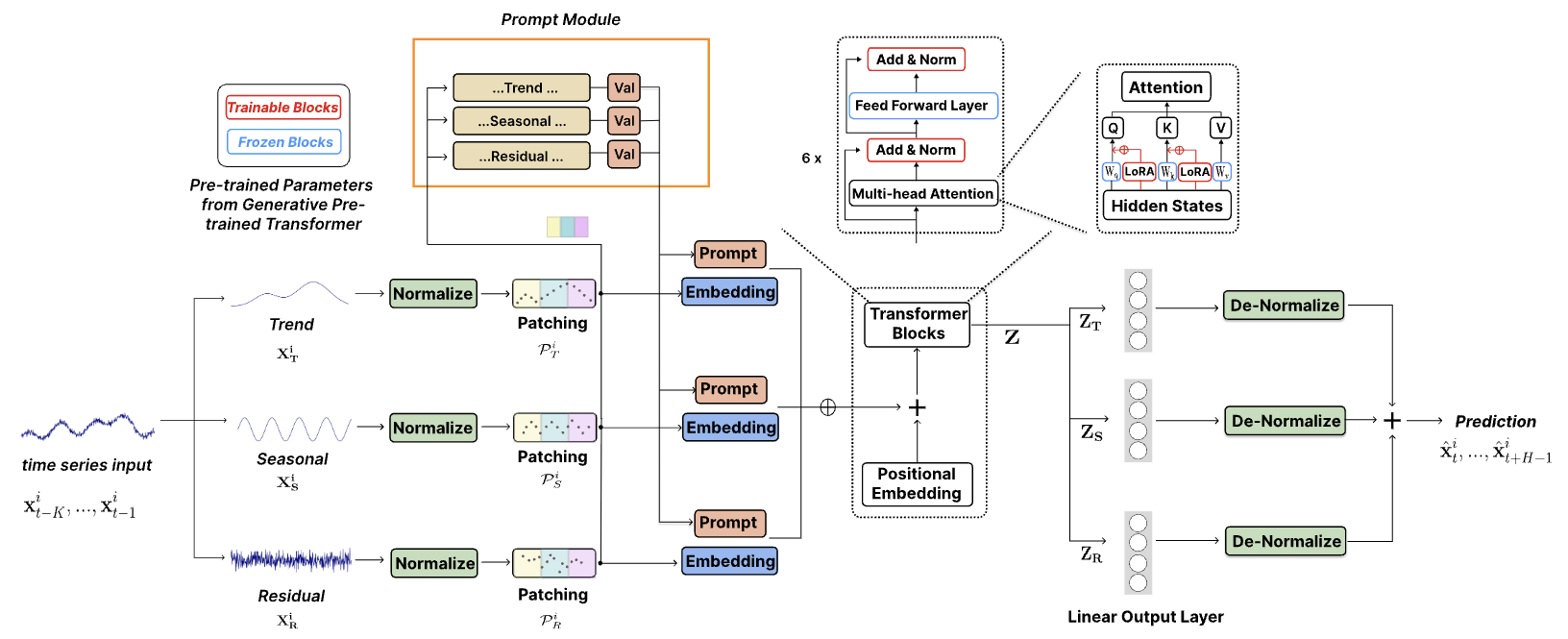

الكود الرسمي لـ ["TEMPO: محول توليدي مُدرب مسبقًا قائم على موجه للتنبؤ بالسلاسل الزمنية (ICLR 2024)"].

يعد TEMPO واحدًا من أول نماذج مؤسسة السلاسل الزمنية المفتوحة المصدر للتنبؤ بالمهمة الإصدار v1.0.

أكتوبر 2024 : لقد قمنا بتبسيط بنية التعليمات البرمجية لدينا، مما يتيح للمستخدمين تنزيل النموذج المُدرب مسبقًا وإجراء الاستدلال الصفري باستخدام سطر واحد من التعليمات البرمجية! تحقق من العرض التوضيحي لدينا لمزيد من التفاصيل. أصبح الآن من الممكن تتبع عدد تنزيلات نموذجنا على HuggingFace!

يونيو 2024 : أضفنا عروضًا توضيحية لإعادة إنتاج تجارب الإطلاق الصفري في Colab. أضفنا أيضًا عرضًا توضيحيًا لبناء مجموعة بيانات العميل ونقوم بالاستدلال مباشرةً عبر نموذجنا الأساسي المُدرب مسبقًا: Colab

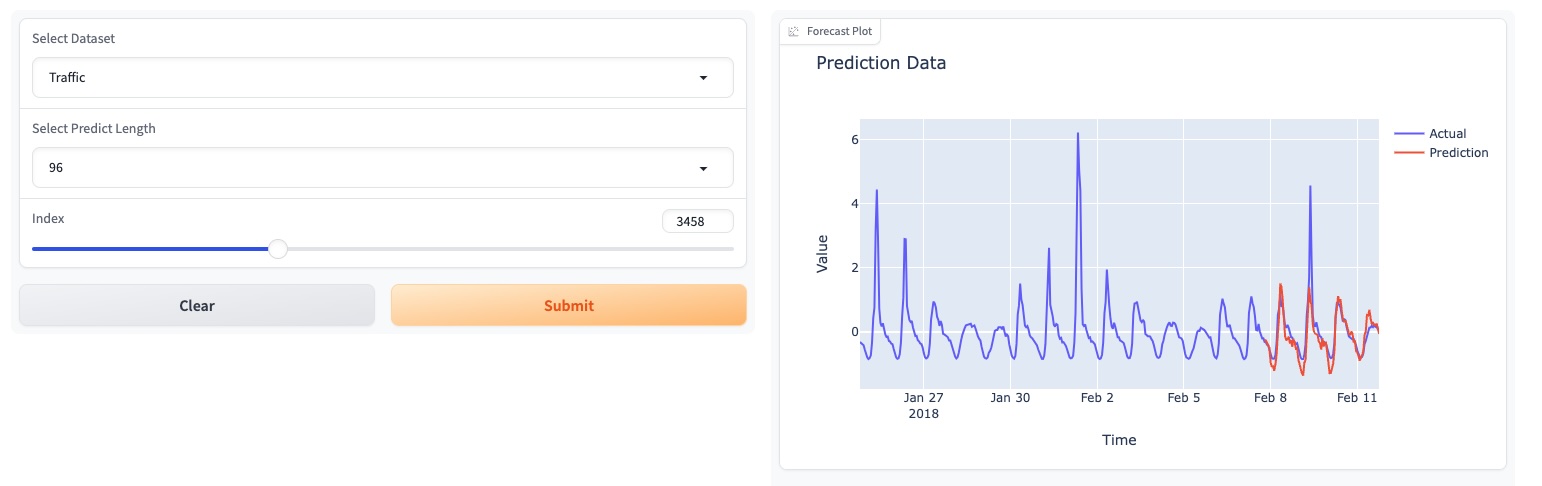

مايو 2024 : أطلقت TEMPO عرضًا توضيحيًا عبر الإنترنت يعتمد على واجهة المستخدم الرسومية، مما يسمح للمستخدمين بالتفاعل مباشرة مع نموذجنا الأساسي!

مايو 2024 : نشرت TEMPO نموذج الأساس المُدرب مسبقًا 80M في HuggingFace!

مايو 2024 : ؟ أضفنا الكود الخاص بنماذج TEMPO للتدريب المسبق والاستدلال. يمكنك العثور على عرض نصي للتدريب المسبق في هذا المجلد. أضفنا أيضًا برنامجًا نصيًا للعرض التوضيحي للاستدلال.

مارس 2024 : ? تم إصدار مجموعة بيانات TETS من S&P 500 المستخدمة في التجارب متعددة الوسائط في TEMPO.

مارس 2024 : ? قامت TEMPO بنشر رمز المشروع ونقطة التفتيش المدربة مسبقًا عبر الإنترنت!

يناير 2024 : قبول ورقة TEMPO من قبل ICLR!

أكتوبر 2023 : تم إصدار ورقة TEMPO على Arxiv!

conda create -n tempo python=3.8

conda activate tempo

pip install -r requirements.txt

مثال مبسط يوضح كيفية إجراء التنبؤ باستخدام TEMPO:

# Third-party library imports

import numpy as np

import torch

from numpy . random import choice

# Local imports

from models . TEMPO import TEMPO

model = TEMPO . load_pretrained_model (

device = torch . device ( 'cuda:0' if torch . cuda . is_available () else 'cpu' ),

repo_id = "Melady/TEMPO" ,

filename = "TEMPO-80M_v1.pth" ,

cache_dir = "./checkpoints/TEMPO_checkpoints"

)

input_data = np . random . rand ( 336 ) # Random input data

with torch . no_grad ():

predicted_values = model . predict ( input_data , pred_length = 96 )

print ( "Predicted values:" )

print ( predicted_values )من فضلك حاول إعادة إنتاج التجارب الصفرية على ETTh2 [هنا على Colab].

نحن نستخدم صفحة Colab التالية لعرض العرض التوضيحي لبناء مجموعة بيانات العميل وإجراء الاستدلال مباشرة عبر نموذجنا الأساسي المُدرب مسبقًا: [Colab]

يرجى تجربة العرض التوضيحي لنموذج الأساس الخاص بنا [هنا].

قمنا أيضًا بتحديث نماذجنا على HuggingFace: [Melady/TEMPO].

قم بتنزيل البيانات من [Google Drive] أو [Baidu Drive]، ثم ضع البيانات التي تم تنزيلها في المجلد ./dataset . يمكنك أيضًا تنزيل نتائج STL من [Google Drive]، ووضع البيانات التي تم تنزيلها في المجلد ./stl .

bash [ecl, etth1, etth2, ettm1, ettm2, traffic, weather].sh

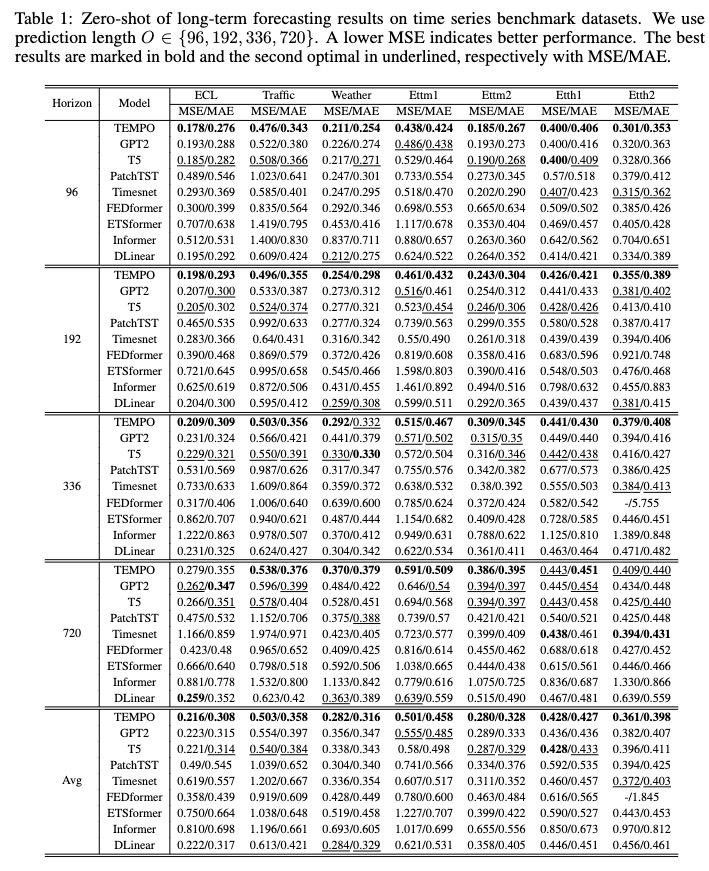

بعد التدريب، يمكننا اختبار نموذج TEMPO ضمن إعداد الصفر:

bash [ecl, etth1, etth2, ettm1, ettm2, traffic, weather]_test.sh

يمكنك تنزيل النموذج المُدرب مسبقًا من [Google Drive] ثم تشغيل البرنامج النصي للاختبار من أجل المتعة.

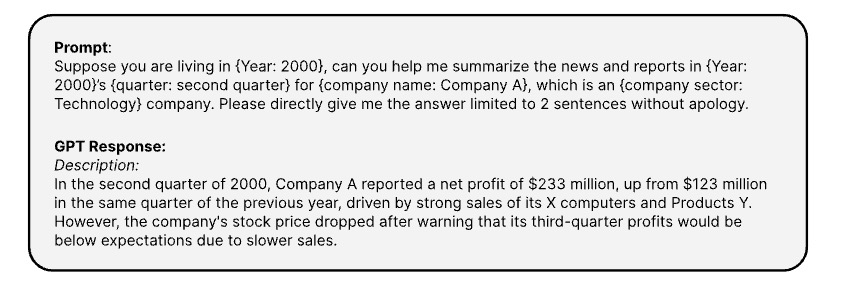

فيما يلي المطالبات المستخدمة لإنشاء المعلومات النصية المقابلة للسلاسل الزمنية عبر [OPENAI ChatGPT-3.5 API]

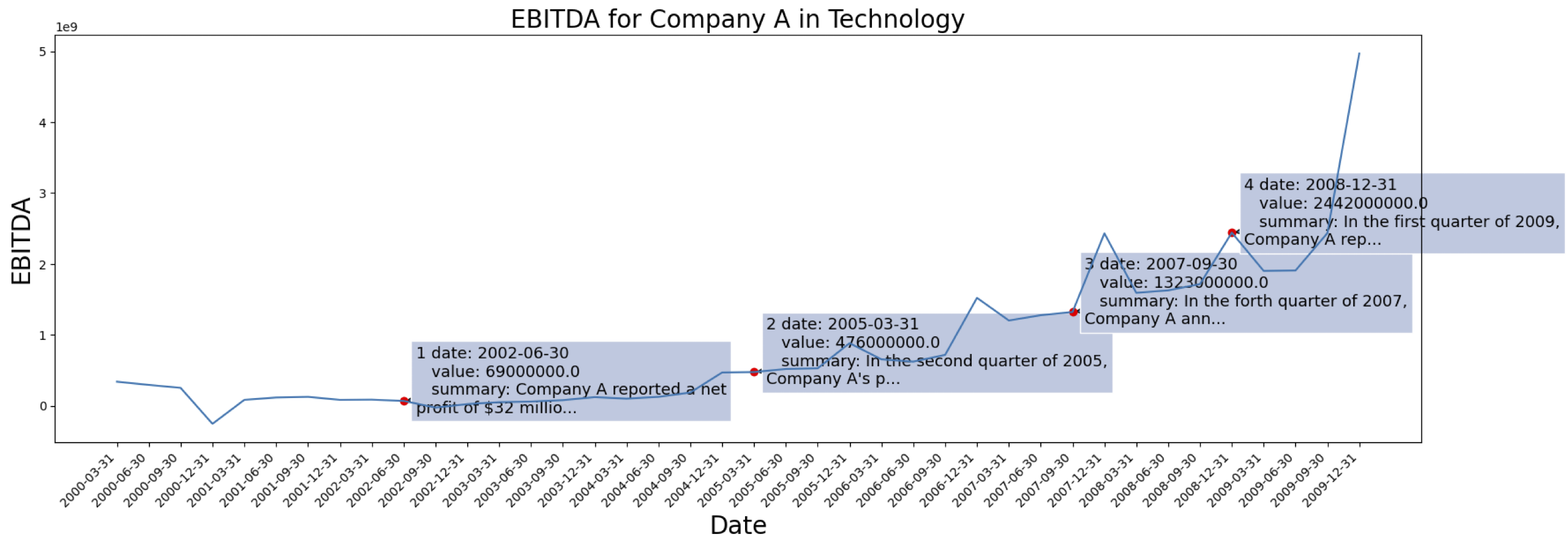

بيانات السلاسل الزمنية تأتي من [S&P 500]. فيما يلي حالة الأرباح قبل الفوائد والضرائب والإهلاك والاستهلاك لشركة واحدة من مجموعة البيانات:

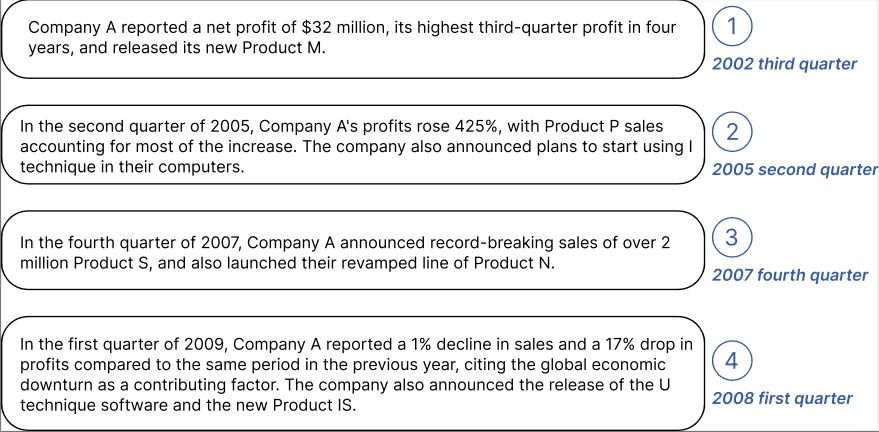

مثال على المعلومات السياقية التي تم إنشاؤها للشركة المذكورة أعلاه:

يمكنك تنزيل البيانات المعالجة مع تضمين النص من GPT2 من: [TETS].

لا تتردد في التواصل مع [email protected] / [email protected] إذا كنت مهتمًا بتطبيق TEMPO على تطبيقك الواقعي.

@inproceedings{

cao2024tempo,

title={{TEMPO}: Prompt-based Generative Pre-trained Transformer for Time Series Forecasting},

author={Defu Cao and Furong Jia and Sercan O Arik and Tomas Pfister and Yixiang Zheng and Wen Ye and Yan Liu},

booktitle={The Twelfth International Conference on Learning Representations},

year={2024},

url={https://openreview.net/forum?id=YH5w12OUuU}

}

@article{

Jia_Wang_Zheng_Cao_Liu_2024,

title={GPT4MTS: Prompt-based Large Language Model for Multimodal Time-series Forecasting},

volume={38},

url={https://ojs.aaai.org/index.php/AAAI/article/view/30383},

DOI={10.1609/aaai.v38i21.30383},

number={21},

journal={Proceedings of the AAAI Conference on Artificial Intelligence},

author={Jia, Furong and Wang, Kevin and Zheng, Yixiang and Cao, Defu and Liu, Yan},

year={2024}, month={Mar.}, pages={23343-23351}

}