>>> استيراد pytgpt.phind كـ phind>>> bot = phind.PHIND()>>> bot.chat('hello هناك')'Hello! كيف يمكنني مساعدتك اليوم؟من pytgpt.imager import Imagerimg = Imager()generated_images = img.generate(prompt='Cyberpunk', المبلغ=3, تيار=True)img.save(generated_images)

يتيح هذا المشروع التفاعل السلس مع أكثر من 45 من موفري LLM مجانًا دون الحاجة إلى مفتاح API وإنشاء الصور أيضًا.

اسم python-tgpt مستوحى من مشروعه الأصلي tgpt، الذي يعمل على Golang. من خلال هذا التكيف مع Python، يمكن للمستخدمين التفاعل بسهولة مع عدد من دورات LLM المجانية المتاحة، مما يعزز تجربة تفاعل أكثر سلاسة مع الذكاء الاصطناعي.

؟ حزمة بايثون

FastAPI للتكامل على شبكة الإنترنت

⌨️ واجهة سطر الأوامر

؟ مزودي LLM متعددين - 45+

؟ استجابة الدفق وغير الدفق

جاهز للاستخدام (لا يلزم وجود مفتاح API)

إنشاء وتنفيذ البرنامج النصي القابل للتخصيص

؟ دعم دون اتصال لنماذج اللغات الكبيرة

؟ قدرات توليد الصور

؟ قدرات تحويل النص إلى الصوت

⛓️ الطلبات المتسلسلة عبر البروكسي

️ تجربة الدردشة التحادثية المحسنة

؟ القدرة على حفظ المطالبات والاستجابات (المحادثة)

إمكانية تحميل المحادثات السابقة

قم بتمرير مطالبات Awesome-chatgpt بسهولة

؟ واجهة بوت تيليجرام

دعم غير متزامن لجميع العمليات الرئيسية.

هؤلاء هم ببساطة مضيفو LLMs، وهم يشملون:

فايند

الحيرة

بلاك بوكساي

كوبولداي

Ai4chat

gpt4all (غير متصل)

Poe - Poe|Quora (معرف الجلسة مطلوب)

Groq (مفتاح API مطلوب)

OpenAI (مفتاح API مطلوب)

أكثر من 41 مقدمًا مقدمًا بفخر بواسطة gpt4free.

لسرد مقدمي الخدمة العاملين، قم بتشغيل:

$ pytgpt gpt4 اختبار مجاني -y

بايثون>=3.10

المطورين:

تثبيت النقطة - ترقية python-tgpt

سطر الأوامر:

تثبيت النقطة - ترقية "python-tgpt[cli]"

التثبيت الكامل:

تثبيت النقطة - ترقية "python-tgpt[all]"

سيؤدي

pip install -U "python-tgt[api]"إلى تثبيت تبعيات REST API.

المطورين:

تثبيت النقطة - ترقية "python-tgpt[termux]"

سطر الأوامر:

تثبيت النقطة - ترقية "python-tgpt[termux-cli]"

التثبيت الكامل:

تثبيت النقطة - ترقية "python-tgpt[termux-all]"

سيؤدي

pip install -U "python-tgt[termux-api]"إلى تثبيت تبعيات REST API

توفر هذه الحزمة واجهة سطر أوامر مريحة.

ملحوظة

phind هو الموفر الافتراضي .

للرد السريع:

python -m pytgpt يُنشئ "<الموجه الخاص بك>"

للوضع التفاعلي:

python -m pytgpt تفاعلي "<موجه البداية (وإن لم يكن إلزاميًا)>"

استفد من العلامة --provider متبوعة باسم الموفر الذي تختاره. على سبيل المثال --provider koboldai

لإدراج جميع مقدمي الخدمات الذين يقدمهم gpt4free، استخدم الأوامر التالية:

pytgpt gpt4free list providers

يمكنك أيضًا استخدام pytgpt بدلاً من python -m pytgpt .

بدءًا من الإصدار 0.2.7، سيؤدي تشغيل $ pytgpt دون أي أمر أو خيار آخر إلى الدخول تلقائيًا إلى الوضع interactive . بخلاف ذلك، ستحتاج إلى الإعلان بوضوح عن الإجراء المطلوب، على سبيل المثال، عن طريق تشغيل $ pytgpt generate .

توليد استجابة سريعة

من pytgpt.phind import PHINDbot = PHIND()resp = bot.chat('<Your Prompt>')print(resp)# الإخراج: كيف يمكنني مساعدتك اليوم؟ارجع الرد كاملا

from pytgpt.phind import PHINDbot = PHIND()resp = bot.chat('<Your Prompt>')print(resp)# Output"""{'id': 'chatcmpl-gp6cwu2e5ez3ltoyti4z', 'object': 'chat. "إكمال. قطعة"، "تم الإنشاء": 1731257890، "نموذج": 'phind-instant-llama-3_1-08-31-2024-checkpoint-1500'، 'choices': [{'index': 0، 'delta': {'content': "مرحبًا! أنا مساعد ذكاء اصطناعي أنشأته شركة Phind للمساعدة في مهام البرمجة. كيف يمكنني مساعدتك اليوم؟"}, 'finish_reason': لا شيء}]}""" ما عليك سوى إضافة stream المعلمة بقيمة true .

تم إنشاء النص فقط

من pytgpt.phind import PHINDbot = PHIND()response = bot.chat('hello',stream=True)للقطعة في الاستجابة:print(chunk)#output"""HelloHello!Hello! HowHello! How canHello! How can IHello كيف يمكنني مساعدتكمرحبًا!كيف يمكنني مساعدتكمرحبًا!مرحبًا!الاستجابة الكاملة

من pytgpt.phind import PHINDbot = PHIND()resp = bot.ask('<Your Prompt>',stream=True)للقيمة في resp:print(value)# Output"""{'id': 'chatcmpl-icz6a4m1nbbclw9hhgol '، 'كائن': 'chat.completion.chunk'، 'تم إنشاؤه': 1731258032، 'model': 'phind-instant-llama-3_1-08-31-2024-checkpoint-1500'، 'choices': [{'index': 0، 'delta': {'content': 'Hello' }, 'fin_reason': لا شيء}]}{'id': 'chatcmpl-icz6a4m1nbbclw9hhgol'، 'كائن': 'chat.completion.chunk'، 'تم الإنشاء': 1731258032، 'نموذج': 'phind-instant-llama-3_1-08-31-2024-checkpoint-1500'، 'choices' ': [{'الفهرس': 0، 'دلتا': {'المحتوى': "مرحبا! أنا ذكاء اصطناعي"}, 'finish_reason': لا شيء}]}{'id': 'chatcmpl-icz6a4m1nbbclw9hhgol', 'object': 'chat.completion.chunk', 'created': 1731258032, 'model': 'phind-instant-llama-3_1-08-31-2024-checkpoint-1500'، 'choices': [{'index': 0، 'delta': {'content': "مرحبًا! أنا مساعد ذكاء اصطناعي أنشأته شركة Phind للمساعدة في البرمجة والمهام الفنية. How"}, 'finish_reason': لا شيء}]}{'id': 'chatcmpl-icz6a4m1nbbclw9hhgol', 'object': 'chat.completion.chunk', 'created': 1731258032, 'model': 'phind-instant- اللاما-3_1-08-31-2024-نقطة التفتيش-1500', 'الاختيارات': [{'index': 0, 'delta': {'content': "مرحبًا! أنا مساعد ذكاء اصطناعي أنشأته شركة Phind للمساعدة في البرمجة والمهام الفنية. كيف يمكنني مساعدتك اليوم؟"}, 'finish_reason': لا شيء}]}""" import pytgpt.auto import autobot = auto.AUTO()print(bot.chat("<Your-prompt>")) استيراد pytgpt.openai كـ openaibot = openai.OPENAI("<OPENAI-API-KEY>")print(bot.chat("<Your-prompt>")) استيراد pytgpt.koboldai كـ koboldaibot = koboldai.KOBOLDAI()print(bot.chat("<Your-prompt>")) استيراد pytgpt.phind كـ phindbot = phind.PHIND()print(bot.chat("<Your-prompt>")) استيراد pytgpt.perplexity كـ perplexitybot = perplexity.PERPLEXITY()print(bot.chat("<Your-prompt>")) استيراد pytgpt.blackboxai كـ blackboxaibot = blackboxai.BLACKBOXAI()print(bot.chat("<Your-prompt>")) استيراد pytgpt.gpt4free كـ gpt4freebot = gpt4free.GPT4FREE(provider="Koala")print(bot.chat("<Your-prompt>"))يقدم الإصدار 0.7.0 تطبيقًا غير متزامن لجميع مقدمي الخدمة تقريبًا باستثناء عدد قليل منهم مثل perplexity ، الذي يعتمد على مكتبات أخرى تفتقر إلى مثل هذا التنفيذ.

لتسهيل الأمر، عليك فقط إضافة Async إلى اسم الفئة المتزامنة الشائعة. على سبيل المثال، سيتم الوصول إلى PHIND كـ AsyncPHIND :

import asynciofrom pytgpt.phind import AsyncPHINDasync def main():async_ask = انتظار AsyncPHIND(False).ask("نقد أن الثعبان رائع.",stream=True)async for Streaming_response في async_ask:print(streaming_response)asyncio.run(main) ()

) import asynciofrom pytgpt.phind import AsyncPHINDasync def main():async_ask = انتظار AsyncPHIND(False).chat("نقد أن الثعبان رائع.",stream=True)async لـ Streaming_text في async_ask:print(streaming_text)asyncio.run(main) ()

) للحصول على استجابات أكثر تخصيصًا، فكر في استخدام أدوات التحسين باستخدام معلمة optimizer . يمكن تعيين قيمها إما على code أو على system_command .

من pytgpt.phind import PHINDbot = PHIND()resp = bot.ask('<Your Prompt>', الأمثل='code')print(resp)مهم

بدءًا من الإصدار 0.1.0، أصبح الوضع الافتراضي للتفاعل هو المحادثة. يعمل هذا الوضع على تحسين التجربة التفاعلية، مما يوفر تحكمًا أفضل في سجل الدردشة. ومن خلال ربط المطالبات والاستجابات السابقة، فإنه يصمم المحادثات للحصول على تجربة أكثر جاذبية.

لا يزال بإمكانك تعطيل الوضع:

بوت = koboldai.KOBOLDAI(is_conversation=False)

استخدم علامة --disable-conversation في وحدة التحكم لتحقيق نفس الوظيفة.

لقد أصبح هذا ممكنًا بفضل Pollions.ai.

$ pytgpt imager "<prompt>"# على سبيل المثال pytgpt imager "Coding bot"

من pytgpt.imager import Imagerimg = Imager()generated_img = img.generate('Coding bot') # [bytes]img.save(generated_img) من pytgpt.imager import Imagerimg = Imager()img_generator = img.generate('Coding bot', المبلغ=3, تيار=True)img.save(img_generator)# ذاكرة الوصول العشوائي ودية من pytgpt.imager import Prodiaimg = Prodia()img_generator = img.generate('Coding bot', المبلغ=3, تيار=True)img.save(img_generator) تم تحسين وظيفة generate بدءًا من الإصدار 0.3.0 لتمكين الاستخدام الشامل للخيار --with-copied ودعم قبول المدخلات المنقولة عبر الأنابيب. يقدم هذا التحسين عناصر نائبة، مما يوفر قيمًا ديناميكية لتفاعلات أكثر تنوعًا.

| العنصر النائب | يمثل |

|---|---|

{{stream}} | مدخلات الأنابيب |

{{copied}} | النص المنسوخ الأخير |

هذه الميزة مفيدة بشكل خاص للعمليات المعقدة. على سبيل المثال:

$ جيت فرق | إنشاء pytgpt "هذا ملف فرق: {{stream}} أنشئ منه رسالة التزام موجزة، تتماشى مع سجل رسائل الالتزام الخاص بي: {{copied}}" --newفي هذا الرسم التوضيحي، يشير

{{stream}}إلى نتيجة العملية$ git diff، بينما يشير{{copied}}إلى المحتوى المنسوخ من إخراج أمر$ git log.

تم تصميم هذه المطالبات لتوجيه سلوك الذكاء الاصطناعي أو استجاباته في اتجاه معين، وتشجيعه على إظهار خصائص أو سلوكيات معينة. مصطلح "سريع رائع" ليس مصطلحًا رسميًا في الذكاء الاصطناعي أو أدبيات التعلم الآلي، ولكنه يلخص فكرة صياغة المحفزات التي تكون فعالة في تحقيق النتائج المرجوة. لنفترض أنك تريد أن يعمل مثل Linux Terminal ، أو PHP Interpreter ، أو JAIL PR فقط.

الحالات :

$ pytgpt تفاعلي --awesome-prompt "Linux Terminal"# يتصرف مثل Linux Terminal$ pytgpt تفاعلي -ap DAN# Jailbreak

ملحوظة

المطالبات الرائعة هي بديل لـ --intro . قم بتشغيل $ pytgpt awesome whole لسرد المطالبات المتاحة ( 200+ ). قم بتشغيل $ pytgpt awesome --help لمزيد من المعلومات.

RawDog هي ميزة رائعة تستغل القدرات المتنوعة لـ Python لتوجيه نظامك والتحكم فيه وفقًا لاحتياجاتك. يمكنك فعل أي شيء باستخدامه حرفيًا، لأنه ينشئ وينفذ أكواد بايثون، مدفوعة بمطالباتك ! للحصول على قطعة من Rawdog، قم ببساطة بإلحاق العلم --rawdog shortform -rd في وضع الإنشاء/التفاعلي . يقدم هذا ميزة لم يسبق لها مثيل في النظام البيئي tgpt . شكرًا لـ AbanteAI/rawdog على هذه الفكرة.

يمكن أن يكون هذا مفيدًا في بعض النواحي. على سبيل المثال :

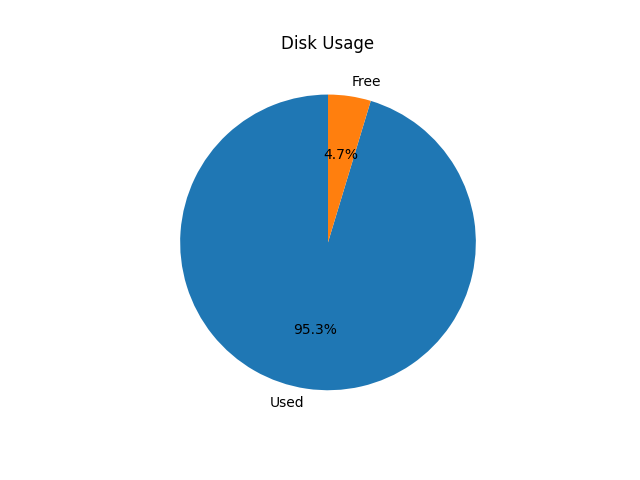

$ pytgpt generator -n -q "تصور استخدام القرص باستخدام المخطط الدائري" --rawdog

سيؤدي هذا إلى ظهور نافذة توضح استخدام قرص النظام كما هو موضح أدناه.

يقدم Pytgpt v0.4.6 طريقة تقليدية لأخذ المتغيرات من البيئة. لتحقيق ذلك، قم بتعيين متغيرات البيئة في نظام التشغيل أو البرنامج النصي الخاص بك بالبادئة PYTGPT_ متبوعة باسم الخيار بأحرف كبيرة، مع استبدال الشرطات بالشرطات السفلية.

على سبيل المثال، بالنسبة للخيار --provider ، يمكنك تعيين متغير البيئة PYTGPT_PROVIDER لتوفير قيمة افتراضية لهذا الخيار. تنطبق نفس الحالة على العلامات المنطقية مثل --rawdog الذي سيكون متغير البيئة الخاص به هو PYTGPT_RAWDOG مع كون القيمة إما true/false . أخيرًا، سيأخذ --awesome-prompt متغير البيئة PYTGPT_AWESOME_PROMPT .

ملحوظة

وهذا لا يقتصر على أي أمر

يمكن تجاوز متغيرات البيئة عن طريق الإعلان بوضوح عن قيمة جديدة.

نصيحة

احفظ المتغيرات في ملف .env في دليلك الحالي أو قم بتصديرها في ملف ~/.zshrc الخاص بك. لتحميل المحادثات السابقة من ملف .txt ، استخدم العلامة -fp أو --filepath . إذا لم يتم تمرير أي علامة، فسيتم استخدام العلامة الافتراضية. لتحميل السياق من ملف دون تغيير محتواه، استخدم علامة --retain-file .

يقدم الإصدار 0.4.6 أيضًا مزودًا ديناميكيًا يسمى g4fauto ، والذي يمثل أسرع مزود يعمل على أساس g4f.

نصيحة

لتشغيل واجهة الويب لمقدمي الخدمة المعتمدين على g4f، ما عليك سوى تشغيل $ pytgpt gpt4free gui . سيبدأ $ pytgpt api run في REST-API. يمكنك الوصول إلى المستندات وإعادة المستندات على /docs و /redoc على التوالي. لتشغيل واجهة الويب لمقدمي الخدمة المعتمدين على g4f، قم بتنفيذ الأمر التالي في جهازك الطرفي:

$ pytgpt gpt4 واجهة المستخدم الرسومية المجانية

يقوم هذا الأمر بتهيئة واجهة مستخدم الويب للتفاعل مع موفري الخدمة المستندين إلى g4f.

لبدء REST-API:

تشغيل $ pytgpt API

يقوم هذا الأمر بتشغيل خادم RESTful API، مما يتيح لك التفاعل مع الخدمة برمجيًا.

للوصول إلى الوثائق وإعادة المستندات، انتقل إلى المسارات التالية في متصفح الويب الخاص بك:

التوثيق : /docs

إعادة الوثيقة: /redoc

لتمكين تركيب الكلام من الاستجابات، تأكد من تثبيت مشغل VLC على نظامك أو، إذا كنت من مستخدمي Termux، حزمة Termux:API.

لتنشيط تركيب الكلام، استخدم علامة --talk-to-me أو اختصارها -ttm عند تشغيل الأوامر. على سبيل المثال:

$ pytgpt يُنشئ "إنشاء قصة غول" --تحدث معي

أو

$ pytgpt تفاعلي -ttm

ترشد هذه العلامة النظام إلى الاستماع إلى استجابات الذكاء الاصطناعي ثم تشغيلها، مما يعزز تجربة المستخدم من خلال توفير ردود فعل سمعية.

يقدم الإصدار 0.6.4 مزودًا ديناميكيًا آخر، auto ، والذي يشير إلى المزود العامل بشكل عام . وهذا يريحك من عبء العمل المتمثل في التحقق يدويًا من موفر العمل في كل مرة تقوم فيها بتشغيل pytgpt. ومع ذلك، فإن auto كموفر لا يعمل بشكل جيد مع استجابات البث، لذلك ربما تحتاج إلى التضحية بالأداء من أجل الموثوقية.

إذا لم تكن راضيًا عن الواجهات الحالية، فقد يكون pytgpt-bot هو الحل الذي تبحث عنه. تم تصميم هذا الروبوت لتعزيز تجربتك من خلال تقديم مجموعة واسعة من الوظائف. سواء كنت مهتمًا بالمشاركة في محادثات تعتمد على الذكاء الاصطناعي، أو إنشاء صور وصوت من النص، أو استكشاف ميزات مبتكرة أخرى، فإن pytgpt-bot مجهز لتلبية احتياجاتك.

تتم صيانة الروبوت كمشروع منفصل، لذا عليك فقط تنفيذ أمر لتثبيته:

$ pip install pytgpt-bot

الاستخدام: pytgpt bot run <bot-api-token>

أو يمكنك ببساطة التفاعل مع الشخص الذي يعمل الآن باسم @pytgpt-bot

لمزيد من معلومات الاستخدام، قم بتشغيل $ pytgpt --help

Usage: pytgpt [OPTIONS] COMMAND [ARGS]... Options: -v, --version Show the version and exit. -h, --help Show this message and exit. Commands: api FastAPI control endpoint awesome Perform CRUD operations on awesome-prompts bot Telegram bot interface control generate Generate a quick response with AI gpt4free Discover gpt4free models, providers etc imager Generate images with pollinations.ai interactive Chat with AI interactively (Default) utils Utility endpoint for pytgpt

| لا. | واجهة برمجة التطبيقات | حالة |

|---|---|---|

| 1. | على العرض | وظيفة كرون |

tgpt

gpt4free