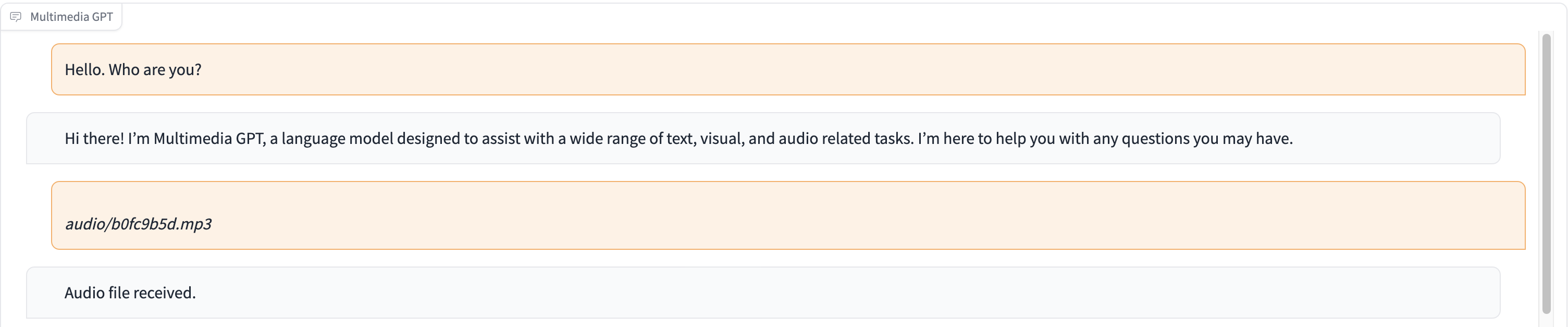

تعمل الوسائط المتعددة GPT على توصيل OpenAI GPT الخاص بك بالرؤية والصوت. يمكنك الآن إرسال الصور والتسجيلات الصوتية ومستندات pdf باستخدام مفتاح OpenAI API الخاص بك، والحصول على رد بتنسيقي النص والصور. نقوم حاليًا بإضافة دعم لمقاطع الفيديو. أصبح كل ذلك ممكنًا بفضل مدير سريع مستوحى ومبني على Microsoft Visual ChatGPT.

بالإضافة إلى جميع نماذج أساس الرؤية المذكورة في Microsoft Visual ChatGPT، يدعم Multimedia GPT OpenAI Whisper وOpenAI DALLE! هذا يعني أنك لم تعد بحاجة إلى وحدات معالجة الرسومات الخاصة بك للتعرف على الصوت وإنشاء الصور (على الرغم من أنه لا يزال بإمكانك ذلك!)

يمكن تكوين نموذج الدردشة الأساسي كأي نموذج OpenAI LLM ، بما في ذلك ChatGPT وGPT-4. نحن الافتراضيون على text-davinci-003 .

نرحب بتقسيم هذا المشروع وإضافة نماذج مناسبة لحالة الاستخدام الخاصة بك. هناك طريقة بسيطة للقيام بذلك وهي من خلال llama_index. سيكون عليك إنشاء فئة جديدة لنموذجك في model.py ، وإضافة طريقة تشغيل run_<model_name> في multimedia_gpt.py . راجع run_pdf للحصول على مثال.

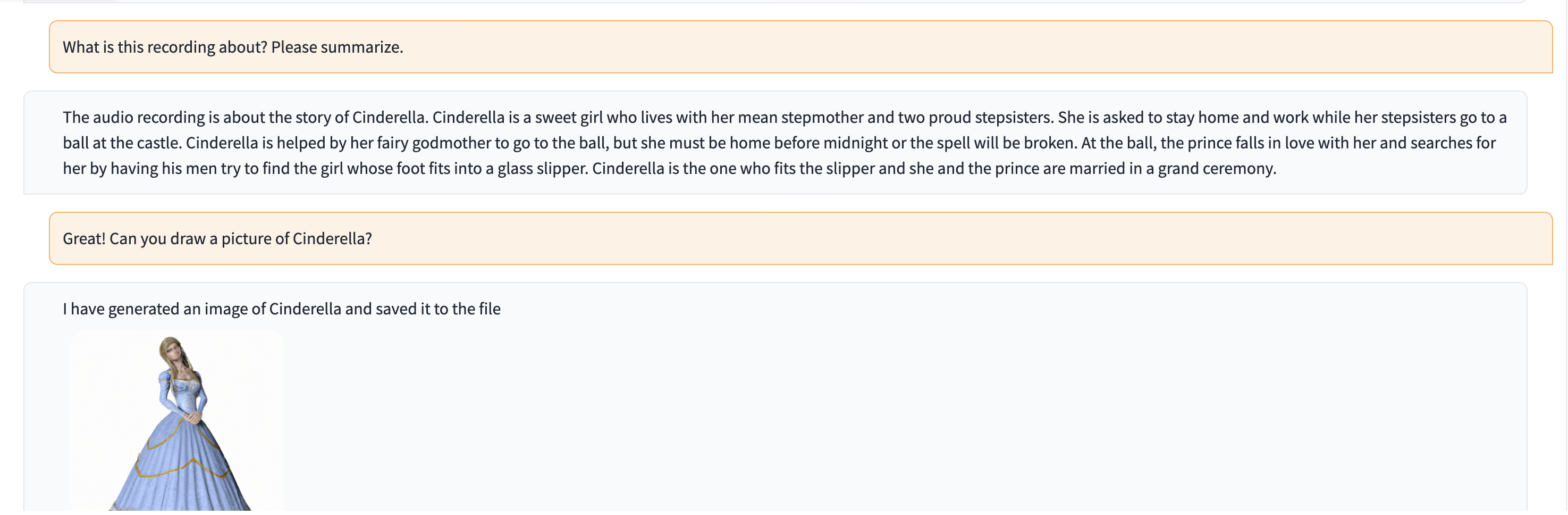

في هذا العرض التوضيحي، يتم تغذية ChatGPT بتسجيل لشخص يروي قصة سندريلا.

# Clone this repository

git clone https://github.com/fengyuli2002/multimedia-gpt

cd multimedia-gpt

# Prepare a conda environment

conda create -n multimedia-gpt python=3.8

conda activate multimedia-gptt

pip install -r requirements.txt

# prepare your private OpenAI key (for Linux / MacOS)

echo " export OPENAI_API_KEY='yourkey' " >> ~ /.zshrc

# prepare your private OpenAI key (for Windows)

setx OPENAI_API_KEY “ < yourkey > ”

# Start Multimedia GPT!

# You can specify the GPU/CPU assignment by "--load", the parameter indicates which foundation models to use and

# where it will be loaded to. The model and device are separated by '_', different models are separated by ','.

# The available Visual Foundation Models can be found in models.py

# For example, if you want to load ImageCaptioning to cuda:0 and whisper to cpu

# (whisper runs remotely, so it doesn't matter where it is loaded to)

# You can use: "ImageCaptioning_cuda:0,Whisper_cpu"

# Don't have GPUs? No worry, you can run DALLE and Whisper on cloud using your API key!

python multimedia_gpt.py --load ImageCaptioning_cpu,DALLE_cpu,Whisper_cpu

# Additionally, you can configure the which OpenAI LLM to use by the "--llm" tag, such as

python multimedia_gpt.py --llm text-davinci-003

# The default is gpt-3.5-turbo (ChatGPT). هذا المشروع هو عمل تجريبي ولن يتم نشره في بيئة الإنتاج. هدفنا هو استكشاف قوة التحفيز.