[؟ معانقة الوجه] [؟ أوبن إكس لاب] [؟ ورقة] [ صفحة المشروع]

حققت نماذج اللغات الكبيرة مفتوحة المصدر (LLMs) نجاحًا كبيرًا في العديد من مهام البرمجة اللغوية العصبية (NLP)، ومع ذلك، فإنها لا تزال أدنى بكثير من النماذج المستندة إلى واجهة برمجة التطبيقات (API) عندما تعمل كوكلاء. تصبح كيفية دمج قدرة الوكيل في LLMs العامة مشكلة حاسمة وعاجلة. تقدم هذه الورقة أولاً ثلاث ملاحظات رئيسية: (1) مجموعة تدريب الوكيل الحالية متشابكة مع كل من التنسيقات التالية ومنطق الوكيل، والذي يتحول بشكل كبير من توزيع بيانات ما قبل التدريب الخاصة به؛ (2) يُظهر حاملو شهادات LLM سرعات تعلم مختلفة فيما يتعلق بالإمكانيات التي تتطلبها مهام الوكيل؛ و (3) الأساليب الحالية لها آثار جانبية عند تحسين قدرات العميل عن طريق إدخال الهلوسة. بناءً على النتائج المذكورة أعلاه، نقترح استخدام Agent-FLAN لضبط نماذج اللغة الخاصة بالوكلاء بشكل فعال. من خلال التحليل الدقيق وإعادة تصميم مجموعة التدريب، يمكّن Agent-FLAN Llama2-7B من التفوق في الأداء على أفضل الأعمال السابقة بنسبة 3.5% عبر مجموعات بيانات تقييم الوكيل المختلفة. من خلال العينات السلبية التي تم إنشاؤها بشكل شامل، يخفف Agent-FLAN بشكل كبير من مشكلات الهلوسة بناءً على معيار التقييم المحدد لدينا. علاوة على ذلك، فهو يعمل باستمرار على تحسين قدرة الوكيل لـ LLMs عند توسيع أحجام النماذج مع تعزيز القدرة العامة لـ LLMs بشكل طفيف.

تم ضبط سلسلة Agent-FLAN على AgentInstruct وToolbench من خلال تطبيق خط أنابيب توليد البيانات المقترح في ورقة Agent-FLAN، والذي يتمتع بقدرات قوية في مختلف مهام الوكيل واستخدام الأدوات ~

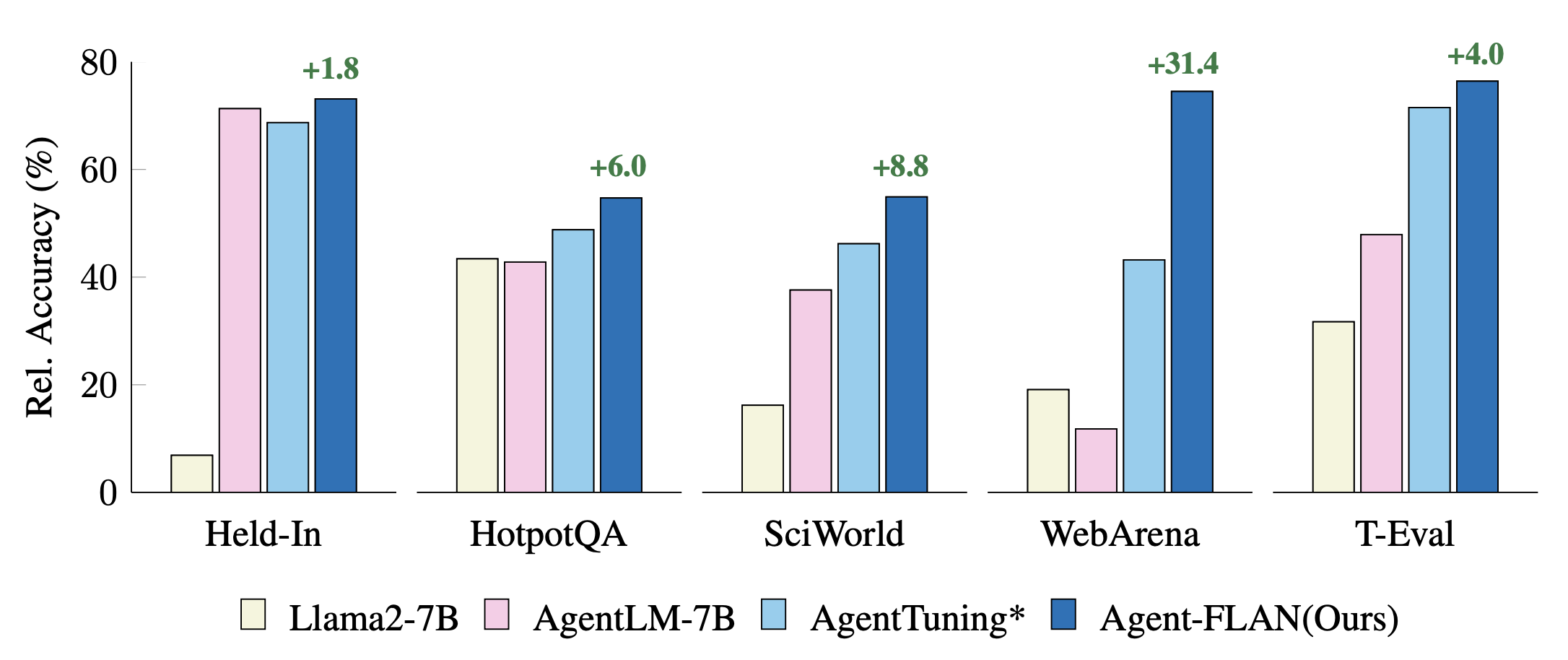

مقارنة أساليب ضبط الوكيل الحديثة في المهام المحتجزة والمتوقفة. يتم تطبيع الأداء باستخدام نتائج GPT-4 للحصول على تصور أفضل. * يدل على إعادة التنفيذ لدينا لإجراء مقارنة عادلة.

يتم إنتاج Agent-FLAN من خلال التدريب المختلط على مجموعات بيانات AgentInstruct وToolBench وShareGPT من سلسلة Llama2-chat.

تتبع النماذج تنسيق المحادثة الخاص بـ Llama-2-chat، مع بروتوكول القالب على النحو التالي:

dict ( role = 'user' , begin = '<|Human|>െ' , end = ' n ' ),

dict ( role = 'system' , begin = '<|Human|>െ' , end = ' n ' ),

dict ( role = 'assistant' , begin = '<|Assistant|>െ' , end = 'ി n ' ),الطراز 7B متاح على مركز نماذج Huggingface وOpenXLab.

| نموذج | تعانق الوجه الريبو | الريبو OpenXLab |

|---|---|---|

| وكيل-FLAN-7B | رابط النموذج | رابط النموذج |

مجموعة بيانات Agent-FLAN متاحة أيضًا على مركز مجموعة بيانات Huggingface.

| مجموعة البيانات | تعانق الوجه الريبو |

|---|---|

| وكيل فلان | رابط مجموعة البيانات |

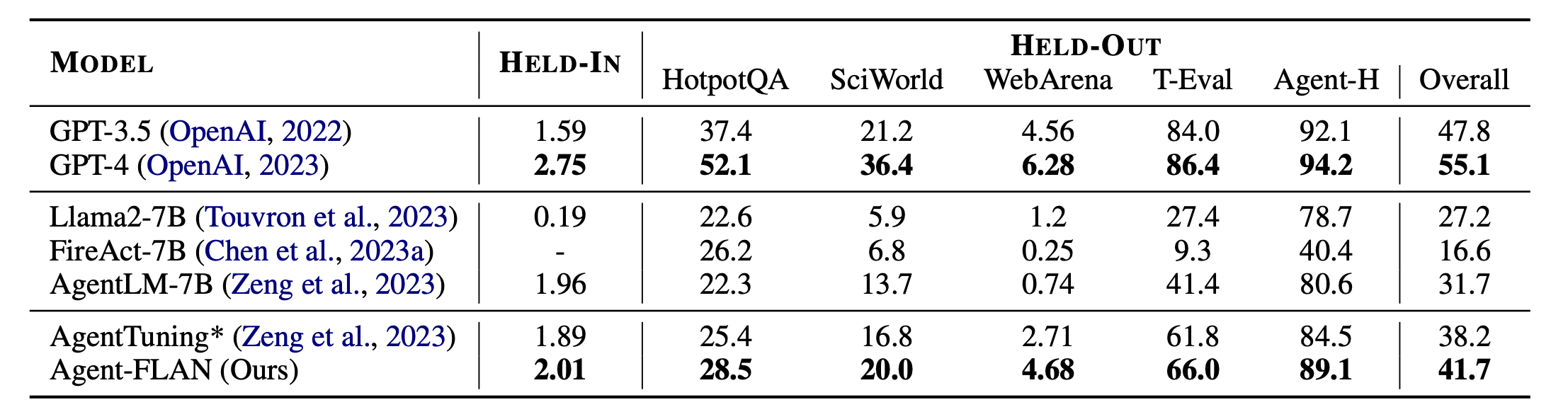

النتائج الرئيسية لوكيل FLAN. يتفوق Agent-FLAN بشكل ملحوظ على أساليب ضبط الوكيل السابقة بهامش كبير في كل من المهام المعلقة والمهمة. * تشير إلى إعادة التنفيذ بنفس القدر من بيانات التدريب لإجراء مقارنة عادلة. نظرًا لأن FireAct لا يتدرب على مجموعة بيانات AgentInstruct، فإننا نحذف أدائه في مجموعة HELD-IN. Bold: الأفضل في النماذج القائمة على واجهة برمجة التطبيقات (API) والمفتوحة المصدر.

تم تصميم Agent-FLAN باستخدام Lagent وT-Eval. شكرا لعملهم الرائع!

إذا وجدت هذا المشروع مفيدًا في بحثك، فيرجى مراعاة الاستشهاد بـ:

@article{chen2024agent,

title={Agent-FLAN: Designing Data and Methods of Effective Agent Tuning for Large Language Models},

author={Chen, Zehui and Liu, Kuikun and Wang, Qiuchen and Zhang, Wenwei and Liu, Jiangning and Lin, Dahua and Chen, Kai and Zhao, Feng},

journal={arXiv preprint arXiv:2403.12881},

year={2024}

}

تم إصدار هذا المشروع بموجب ترخيص Apache 2.0.