21/8/2024: يتوفر برنامج CoPilot الآن في الإصدار 0.9 (الإصدار 0.9.0). يرجى الاطلاع على ملاحظات الإصدار للحصول على التفاصيل. ملاحظة: على TigerGraph Cloud يتوفر برنامج CoPilot v0.5 فقط.

30/04/2024: يتوفر برنامج CoPilot الآن في الإصدار التجريبي (الإصدار 0.5.0). تمت إضافة وظيفة جديدة تمامًا إلى برنامج CoPilot: يمكنك الآن إنشاء روبوتات محادثة باستخدام الذكاء الاصطناعي المعزز بالرسوم البيانية على مستنداتك الخاصة. ينشئ برنامج CoPilot رسمًا بيانيًا معرفيًا من المواد المصدرية ويطبق الرسم البياني المعرفي RAG (الجيل المعزز للاسترجاع) لتحسين الصلة السياقية ودقة الإجابات على أسئلتهم باللغة الطبيعية. نود أن نسمع تعليقاتك لمواصلة تحسينها حتى تتمكن من تحقيق المزيد من القيمة لك. سيكون من المفيد أن تتمكن من ملء هذا الاستبيان القصير بعد اللعب باستخدام برنامج CoPilot. شكرا لاهتمامك ودعمك!

18/03/2024: يتوفر برنامج CoPilot الآن في إصدار Alpha (الإصدار 0.0.1). ويستخدم نموذج لغة كبير (LLM) لتحويل سؤالك إلى استدعاء دالة، والذي يتم تنفيذه بعد ذلك على الرسم البياني في TigerGraph. نود أن نسمع تعليقاتك لمواصلة تحسينها حتى تتمكن من تحقيق المزيد من القيمة لك. إذا كنت تحاول ذلك، سيكون من المفيد أن تقوم بملء نموذج الاشتراك هذا حتى نتمكن من تتبعه (وعدنا بعدم وجود رسائل غير مرغوب فيها). وإذا كنت ترغب فقط في تقديم التعليقات، فلا تتردد في ملء هذا الاستبيان القصير. شكرا لاهتمامك ودعمك!

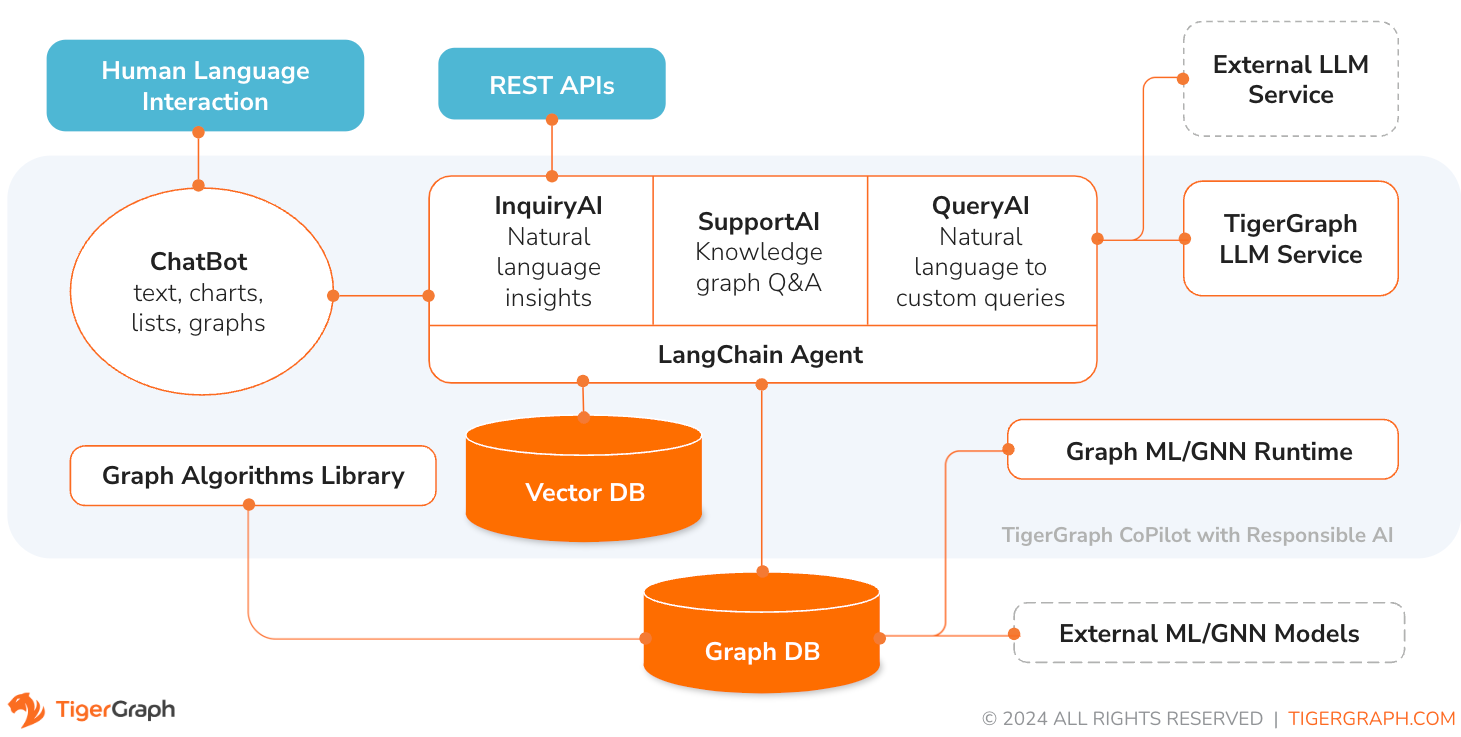

TigerGraph CoPilot هو مساعد الذكاء الاصطناعي الذي تم تصميمه بدقة للجمع بين صلاحيات قواعد بيانات الرسم البياني والذكاء الاصطناعي التوليدي لاستخلاص أكبر قيمة من البيانات وتعزيز الإنتاجية عبر وظائف الأعمال المختلفة، بما في ذلك مهام التحليل والتطوير والإدارة. إنه مساعد AI واحد مع ثلاث خدمات مكونة أساسية:

يمكنك التفاعل مع برنامج CoPilot من خلال واجهة الدردشة على TigerGraph Cloud، وواجهة الدردشة المضمنة وواجهات برمجة التطبيقات. في الوقت الحالي، يلزم استخدام خدمات LLM الخاصة بك (من OpenAI وAzure وGCP وAWS Bedrock وOllama وHugging Face وGroq.) لاستخدام CoPilot، ولكن في الإصدارات المستقبلية يمكنك استخدام TigerGraph's LLMs.

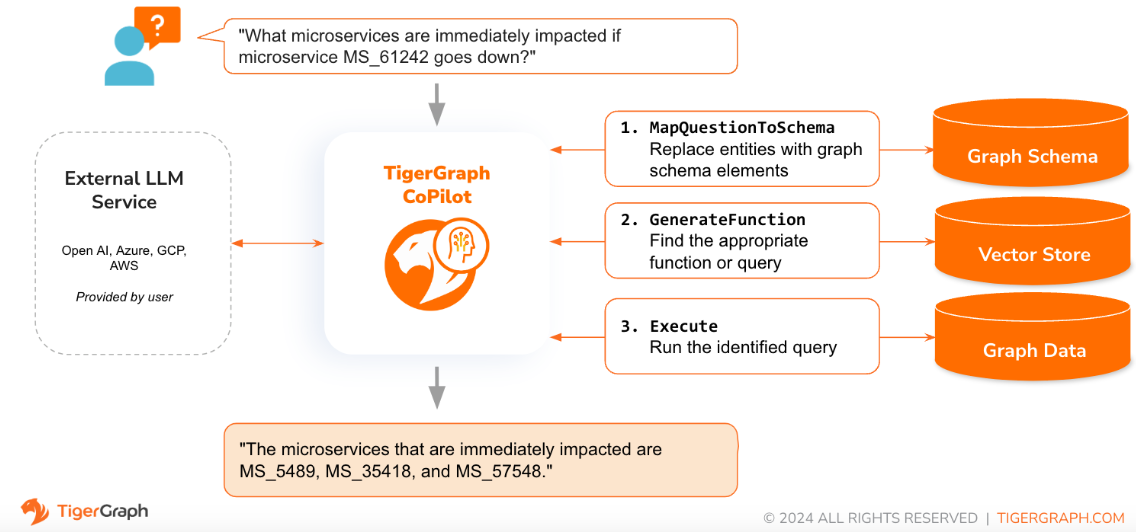

عندما يتم طرح سؤال باللغة الطبيعية، يستخدم برنامج CoPilot (InquiryAI) تفاعلًا جديدًا ثلاثي المراحل مع كل من قاعدة بيانات TigerGraph ودرجة الماجستير في القانون من اختيار المستخدم، للحصول على إجابات دقيقة وذات صلة.

تقوم المرحلة الأولى بمحاذاة السؤال مع البيانات المحددة المتوفرة في قاعدة البيانات. يستخدم برنامج CoPilot LLM لمقارنة السؤال بمخطط الرسم البياني واستبدال الكيانات في السؤال بعناصر الرسم البياني. على سبيل المثال، إذا كان هناك نوع قمة من "BareMetalNode" وسأل المستخدم "كم عدد الخوادم الموجودة؟"، فسيتم ترجمة السؤال إلى "كم عدد رؤوس BareMetalNode الموجودة؟". في المرحلة الثانية، يستخدم برنامج CoPilot LLM لمقارنة السؤال المحول مع مجموعة من استعلامات ووظائف قاعدة البيانات المنسقة من أجل تحديد أفضل تطابق. في المرحلة الثالثة، يقوم برنامج CoPilot بتنفيذ الاستعلام المحدد وإرجاع النتيجة باللغة الطبيعية بالإضافة إلى الأسباب الكامنة وراء الإجراءات.

يوفر استخدام الاستعلامات المعتمدة مسبقًا فوائد متعددة. أولاً وقبل كل شيء، فهو يقلل من احتمالية الإصابة بالهلوسة، لأنه تم التحقق من صحة معنى وسلوك كل استفسار. ثانيًا، يتمتع النظام بإمكانية التنبؤ بموارد التنفيذ اللازمة للإجابة على السؤال.

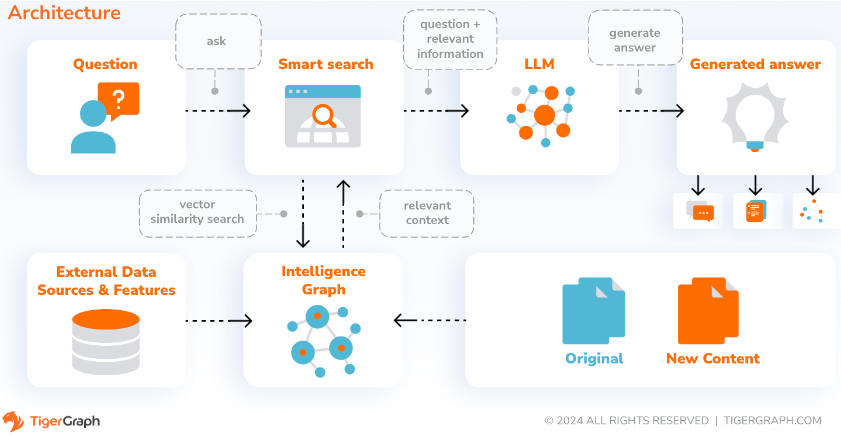

باستخدام SupportAI، يقوم برنامج CoPilot بإنشاء روبوتات دردشة باستخدام الذكاء الاصطناعي المعزز بالرسوم البيانية على المستندات الخاصة بالمستخدم أو البيانات النصية. فهو يبني رسمًا بيانيًا معرفيًا من مادة المصدر ويطبق متغيره الفريد من RAG (الجيل المعزز للاسترجاع) القائم على الرسم البياني المعرفي لتحسين الصلة السياقية ودقة الإجابات على أسئلة اللغة الطبيعية.

سيقوم برنامج CoPilot أيضًا بتحديد المفاهيم وبناء علم الوجود، لإضافة دلالات ومنطق إلى الرسم البياني للمعرفة، أو يمكن للمستخدمين تقديم علم الوجود الخاص بهم. وبعد ذلك، باستخدام هذا الرسم البياني المعرفي الشامل، يقوم برنامج CoPilot بإجراء عمليات استرجاع مختلطة، تجمع بين بحث المتجهات التقليدي وعمليات اجتياز الرسم البياني، لجمع معلومات أكثر صلة وسياق أكثر ثراءً للإجابة على الأسئلة المعرفية للمستخدمين.

يتيح تنظيم البيانات كرسم بياني معرفي لروبوت الدردشة الوصول إلى معلومات دقيقة قائمة على الحقائق بسرعة وكفاءة، وبالتالي تقليل الاعتماد على توليد الاستجابات من الأنماط المستفادة أثناء التدريب، والتي قد تكون في بعض الأحيان غير صحيحة أو قديمة.

QueryAI هو المكون الثالث لبرنامج TigerGraph CoPilot. تم تصميمه ليتم استخدامه كأداة مطور للمساعدة في إنشاء استعلامات رسومية في GSQL من وصف باللغة الإنجليزية. ويمكن استخدامه أيضًا لإنشاء المخطط ورسم خرائط البيانات وحتى لوحات المعلومات. وهذا سيمكن المطورين من كتابة استعلامات GSQL بشكل أسرع وأكثر دقة، وسيكون مفيدًا بشكل خاص لأولئك الجدد في GSQL. حاليًا، يتوفر الجيل التجريبي من openCypher.

يتوفر برنامج CoPilot كخدمة إضافية لمساحة العمل الخاصة بك على TigerGraph Cloud. يتم تعطيله بشكل افتراضي. برجاء الاتصال بـ [email protected] لتمكين TigerGraph CoPilot كخيار في Marketplace.

TigerGraph CoPilot هو مشروع مفتوح المصدر على GitHub ويمكن نشره على البنية التحتية الخاصة بك.

إذا لم تكن بحاجة إلى توسيع التعليمات البرمجية المصدر لبرنامج CoPilot، فإن أسرع طريقة هي نشر صورة عامل الإرساء الخاص به مع ملف إنشاء عامل الإرساء في الريبو. من أجل اتخاذ هذا الطريق، سوف تحتاج إلى المتطلبات الأساسية التالية.

الخطوة 1: الحصول على ملف إنشاء عامل الإرساء

git clone https://github.com/tigergraph/CoPilot يحتوي ملف Docker Compose على جميع التبعيات لبرنامج CoPilot بما في ذلك قاعدة بيانات Milvus. إذا لم تكن بحاجة إلى خدمة معينة، يمكنك تحرير ملف الإنشاء لإزالته أو ضبط مقياسه على 0 عند تشغيل ملف الإنشاء (التفاصيل لاحقًا). علاوة على ذلك، يأتي برنامج CoPilot مزودًا بصفحة وثائق Swagger API عند نشره. إذا كنت ترغب في تعطيله، فيمكنك تعيين متغير بيئة PRODUCTION على القيمة true لخدمة CoPilot في ملف Compose.

الخطوة 2: إعداد التكوينات

بعد ذلك، في نفس الدليل الذي يوجد به ملف Docker Compose، قم بإنشاء وملء ملفات التكوين التالية:

الخطوة 3 (اختياري): تكوين التسجيل

touch configs/log_config.json . تفاصيل التكوين متاحة هنا.

الخطوة 4: ابدأ كافة الخدمات

الآن، ما عليك سوى تشغيل docker compose up -d وانتظر حتى تبدأ جميع الخدمات. إذا كنت لا ترغب في استخدام قاعدة بيانات Milvus المضمنة، فيمكنك ضبط مقياسها على 0 حتى لا تبدأ تشغيلها: docker compose up -d --scale milvus-standalone=0 --scale etcd=0 --scale minio=0 .

الخطوة 5: تثبيت UDFs

هذه الخطوة ليست ضرورية لإصدار قواعد بيانات TigerGraph 4.x. بالنسبة إلى TigerGraph 3.x، نحتاج إلى تثبيت بعض الوظائف المحددة من قبل المستخدم (UDFs) حتى يعمل برنامج CoPilot.

sudo su - tigergraph . إذا كان TigerGraph يعمل على مجموعة، فيمكنك القيام بذلك على أي جهاز من الأجهزة. gadmin config set GSQL.UDF.EnablePutTgExpr true

gadmin config set GSQL.UDF.Policy.Enable false

gadmin config apply

gadmin restart GSQL

PUT tg_ExprFunctions FROM "./tg_ExprFunctions.hpp"

PUT tg_ExprUtil FROM "./tg_ExprUtil.hpp"

gadmin config set GSQL.UDF.EnablePutTgExpr false

gadmin config set GSQL.UDF.Policy.Enable true

gadmin config apply

gadmin restart GSQL

في ملف configs/llm_config.json ، انسخ قالب تكوين JSON من الأسفل لموفر LLM الخاص بك، واملأ الحقول المناسبة. هناك حاجة إلى مزود واحد فقط.

OpenAI

بالإضافة إلى OPENAI_API_KEY ، يمكن تحرير llm_model و model_name لمطابقة تفاصيل التكوين المحددة الخاصة بك.

{

"model_name" : " GPT-4 " ,

"embedding_service" : {

"embedding_model_service" : " openai " ,

"authentication_configuration" : {

"OPENAI_API_KEY" : " YOUR_OPENAI_API_KEY_HERE "

}

},

"completion_service" : {

"llm_service" : " openai " ,

"llm_model" : " gpt-4-0613 " ,

"authentication_configuration" : {

"OPENAI_API_KEY" : " YOUR_OPENAI_API_KEY_HERE "

},

"model_kwargs" : {

"temperature" : 0

},

"prompt_path" : " ./app/prompts/openai_gpt4/ "

}

}Google Cloud Platform

اتبع معلومات مصادقة Google Cloud Platform الموجودة هنا: https://cloud.google.com/docs/authentication/application-default-credentials#GAC وأنشئ حساب خدمة باستخدام بيانات اعتماد VertexAI. ثم أضف ما يلي إلى أمر docker run:

-v $( pwd ) /configs/SERVICE_ACCOUNT_CREDS.json:/SERVICE_ACCOUNT_CREDS.json -e GOOGLE_APPLICATION_CREDENTIALS=/SERVICE_ACCOUNT_CREDS.jsonويجب أن يتبع تكوين JSON الخاص بك على النحو التالي:

{

"model_name" : " GCP-text-bison " ,

"embedding_service" : {

"embedding_model_service" : " vertexai " ,

"authentication_configuration" : {}

},

"completion_service" : {

"llm_service" : " vertexai " ,

"llm_model" : " text-bison " ,

"model_kwargs" : {

"temperature" : 0

},

"prompt_path" : " ./app/prompts/gcp_vertexai_palm/ "

}

}أزور

بالإضافة إلى AZURE_OPENAI_ENDPOINT و AZURE_OPENAI_API_KEY و azure_deployment ، يمكن تحرير llm_model و model_name لمطابقة تفاصيل التكوين المحددة الخاصة بك.

{

"model_name" : " GPT35Turbo " ,

"embedding_service" : {

"embedding_model_service" : " azure " ,

"azure_deployment" : " YOUR_EMBEDDING_DEPLOYMENT_HERE " ,

"authentication_configuration" : {

"OPENAI_API_TYPE" : " azure " ,

"OPENAI_API_VERSION" : " 2022-12-01 " ,

"AZURE_OPENAI_ENDPOINT" : " YOUR_AZURE_ENDPOINT_HERE " ,

"AZURE_OPENAI_API_KEY" : " YOUR_AZURE_API_KEY_HERE "

}

},

"completion_service" : {

"llm_service" : " azure " ,

"azure_deployment" : " YOUR_COMPLETION_DEPLOYMENT_HERE " ,

"openai_api_version" : " 2023-07-01-preview " ,

"llm_model" : " gpt-35-turbo-instruct " ,

"authentication_configuration" : {

"OPENAI_API_TYPE" : " azure " ,

"AZURE_OPENAI_ENDPOINT" : " YOUR_AZURE_ENDPOINT_HERE " ,

"AZURE_OPENAI_API_KEY" : " YOUR_AZURE_API_KEY_HERE "

},

"model_kwargs" : {

"temperature" : 0

},

"prompt_path" : " ./app/prompts/azure_open_ai_gpt35_turbo_instruct/ "

}

}AWS الأساس

{

"model_name" : " Claude-3-haiku " ,

"embedding_service" : {

"embedding_model_service" : " bedrock " ,

"embedding_model" : " amazon.titan-embed-text-v1 " ,

"authentication_configuration" : {

"AWS_ACCESS_KEY_ID" : " ACCESS_KEY " ,

"AWS_SECRET_ACCESS_KEY" : " SECRET "

}

},

"completion_service" : {

"llm_service" : " bedrock " ,

"llm_model" : " anthropic.claude-3-haiku-20240307-v1:0 " ,

"authentication_configuration" : {

"AWS_ACCESS_KEY_ID" : " ACCESS_KEY " ,

"AWS_SECRET_ACCESS_KEY" : " SECRET "

},

"model_kwargs" : {

"temperature" : 0 ,

},

"prompt_path" : " ./app/prompts/aws_bedrock_claude3haiku/ "

}

}أولاما

{

"model_name" : " GPT-4 " ,

"embedding_service" : {

"embedding_model_service" : " openai " ,

"authentication_configuration" : {

"OPENAI_API_KEY" : " "

}

},

"completion_service" : {

"llm_service" : " ollama " ,

"llm_model" : " calebfahlgren/natural-functions " ,

"model_kwargs" : {

"temperature" : 0.0000001

},

"prompt_path" : " ./app/prompts/openai_gpt4/ "

}

}تعانق الوجه

يظهر أدناه تكوين مثال لنموذج على Hugging Face بنقطة نهاية مخصصة. يرجى تحديد تفاصيل التكوين الخاصة بك:

{

"model_name" : " llama3-8b " ,

"embedding_service" : {

"embedding_model_service" : " openai " ,

"authentication_configuration" : {

"OPENAI_API_KEY" : " "

}

},

"completion_service" : {

"llm_service" : " huggingface " ,

"llm_model" : " hermes-2-pro-llama-3-8b-lpt " ,

"endpoint_url" : " https:endpoints.huggingface.cloud " ,

"authentication_configuration" : {

"HUGGINGFACEHUB_API_TOKEN" : " "

},

"model_kwargs" : {

"temperature" : 0.1

},

"prompt_path" : " ./app/prompts/openai_gpt4/ "

}

}يظهر أدناه تكوين مثال لنموذج على Hugging Face بنقطة نهاية بدون خادم. يرجى تحديد تفاصيل التكوين الخاصة بك:

{

"model_name" : " Llama3-70b " ,

"embedding_service" : {

"embedding_model_service" : " openai " ,

"authentication_configuration" : {

"OPENAI_API_KEY" : " "

}

},

"completion_service" : {

"llm_service" : " huggingface " ,

"llm_model" : " meta-llama/Meta-Llama-3-70B-Instruct " ,

"authentication_configuration" : {

"HUGGINGFACEHUB_API_TOKEN" : " "

},

"model_kwargs" : {

"temperature" : 0.1

},

"prompt_path" : " ./app/prompts/llama_70b/ "

}

}جروك

{

"model_name" : " mixtral-8x7b-32768 " ,

"embedding_service" : {

"embedding_model_service" : " openai " ,

"authentication_configuration" : {

"OPENAI_API_KEY" : " "

}

},

"completion_service" : {

"llm_service" : " groq " ,

"llm_model" : " mixtral-8x7b-32768 " ,

"authentication_configuration" : {

"GROQ_API_KEY" : " "

},

"model_kwargs" : {

"temperature" : 0.1

},

"prompt_path" : " ./app/prompts/openai_gpt4/ "

}

} انسخ ما يلي إلى configs/db_config.json وقم بتحرير hostname وحقول getToken لمطابقة تكوين قاعدة البيانات الخاصة بك. إذا تم تمكين مصادقة الرمز المميز في TigerGraph، فاضبط getToken على true . قم بتعيين معلمات المهلة وعتبة الذاكرة وحد مؤشر الترابط حسب الرغبة للتحكم في مقدار موارد قاعدة البيانات التي يتم استهلاكها عند الإجابة على سؤال.

"ecc" و"chat_history_api" هما عنوانان المكونات الداخلية لبرنامج CoPilot. إذا كنت تستخدم ملف Docker Compose كما هو، فلن تحتاج إلى تغييرهما.

{

"hostname" : " http://tigergraph " ,

"restppPort" : " 9000 " ,

"gsPort" : " 14240 " ,

"getToken" : false ,

"default_timeout" : 300 ,

"default_mem_threshold" : 5000 ,

"default_thread_limit" : 8 ,

"ecc" : " http://eventual-consistency-service:8001 " ,

"chat_history_api" : " http://chat-history:8002 "

} انسخ ما يلي إلى configs/milvus_config.json وقم بتحرير حقلي host port لمطابقة تكوين Milvus الخاص بك (مع الأخذ في الاعتبار تكوين عامل الإرساء). يمكن أيضًا تكوين username وكلمة password أدناه إذا كان ذلك مطلوبًا من خلال إعداد Milvus الخاص بك. يجب دائمًا تعيين enabled على "صحيح" في الوقت الحالي نظرًا لأن Milvus هو فقط متجر التضمين المدعوم.

{

"host" : " milvus-standalone " ,

"port" : 19530 ,

"username" : " " ,

"password" : " " ,

"enabled" : " true " ,

"sync_interval_seconds" : 60

} انسخ الكود أدناه إلى configs/chat_config.json . لن تحتاج إلى تغيير أي شيء إلا إذا قمت بتغيير منفذ خدمة سجل الدردشة في ملف Docker Compose.

{

"apiPort" : " 8002 " ,

"dbPath" : " chats.db " ,

"dbLogPath" : " db.log " ,

"logPath" : " requestLogs.jsonl " ,

"conversationAccessRoles": ["superuser", "globaldesigner"]

} إذا كنت ترغب في تمكين إنشاء استعلام openCypher في InquiryAI، فيمكنك تعيين متغير البيئة USE_CYPHER على "true" في خدمة CoPilot في ملف إنشاء عامل الإرساء. افتراضيًا، يتم تعيين هذا على "false" . ملحوظة : لا يزال إنشاء استعلام openCypher في مرحلة تجريبية وقد لا يعمل كما هو متوقع، بالإضافة إلى زيادة احتمالية الحصول على إجابات هلوسة بسبب إنشاء تعليمات برمجية سيئة. استخدم بحذر، وفقط في البيئات غير الإنتاجية.

يعد برنامج CoPilot صديقًا للمستخدمين التقنيين وغير التقنيين. توجد واجهة دردشة رسومية بالإضافة إلى إمكانية الوصول إلى واجهة برمجة التطبيقات (API) لبرنامج CoPilot. من الناحية الوظيفية، يمكن لبرنامج CoPilot الإجابة على أسئلتك عن طريق استدعاء الاستعلامات الموجودة في قاعدة البيانات (InquiryAI)، وإنشاء رسم بياني معرفي من مستنداتك (SupportAI)، والإجابة على أسئلة المعرفة بناءً على مستنداتك (SupportAI).

يرجى الرجوع إلى وثائقنا الرسمية حول كيفية استخدام برنامج CoPilot.

تم تصميم برنامج TigerGraph CoPilot ليكون قابلاً للتوسعة بسهولة. يمكن تكوين الخدمة لاستخدام موفري LLM مختلفين ومخططات رسومية مختلفة وأدوات LangChain مختلفة. يمكن أيضًا توسيع الخدمة لاستخدام خدمات التضمين المختلفة وخدمات إنشاء LLM المختلفة وأدوات LangChain المختلفة. لمزيد من المعلومات حول كيفية توسيع الخدمة، راجع دليل المطور.

يتم تضمين مجموعة من الاختبارات ضمن دليل tests . إذا كنت ترغب في إضافة المزيد من الاختبارات يرجى الرجوع إلى الدليل هنا. يتم أيضًا تضمين برنامج shell النصي run_tests.sh في المجلد الذي يعد برنامج التشغيل لتشغيل الاختبارات. أسهل طريقة لاستخدام هذا البرنامج النصي هي تنفيذه في Docker Container للاختبار.

يمكنك إجراء اختبار لكل خدمة من خلال الانتقال إلى المستوى الأعلى لدليل الخدمة وتشغيل python -m pytest

على سبيل المثال (من المستوى الأعلى)

cd copilot

python -m pytest

cd ..أولاً، تأكد من أن جميع ملفات تكوين مزود خدمة LLM لديك تعمل بشكل صحيح. سيتم تثبيت التكوينات للوصول إلى الحاوية. تأكد أيضًا من أن جميع التبعيات مثل قاعدة البيانات وMilvus جاهزة. إذا لم يكن الأمر كذلك، فيمكنك تشغيل ملف إنشاء عامل الإرساء المضمن لإنشاء هذه الخدمات.

docker compose up -d --buildإذا كنت تريد استخدام الأوزان والتحيزات لتسجيل نتائج الاختبار، فيجب تعيين مفتاح WandB API الخاص بك في متغير بيئة على الجهاز المضيف.

export WANDB_API_KEY=KEY HERE بعد ذلك، يمكنك إنشاء حاوية عامل الإرساء من ملف Dockerfile.tests وتشغيل البرنامج النصي للاختبار في الحاوية.

docker build -f Dockerfile.tests -t copilot-tests:0.1 .

docker run -d -v $( pwd ) /configs/:/ -e GOOGLE_APPLICATION_CREDENTIALS=/GOOGLE_SERVICE_ACCOUNT_CREDS.json -e WANDB_API_KEY= $WANDB_API_KEY -it --name copilot-tests copilot-tests:0.1

docker exec copilot-tests bash -c " conda run --no-capture-output -n py39 ./run_tests.sh all all " لتحرير الاختبارات التي يتم تنفيذها، يمكن تمرير الوسائط إلى البرنامج النصي ./run_tests.sh . حاليًا، يمكن للمرء تكوين خدمة LLM التي سيتم استخدامها (الإعدادات الافتراضية للكل)، وما هي المخططات التي سيتم اختبارها (الإعدادات الافتراضية للكل)، وما إذا كان سيتم استخدام الأوزان والتحيزات للتسجيل أم لا (الإعدادات الافتراضية هي صحيح). تعليمات الخيارات تجدها أدناه:

المعلمة الأولى لـ run_tests.sh هي ما سيتم اختبار LLMs عليه. الافتراضيات all . الخيارات هي:

all - إجراء اختبارات على جميع حاملي شهادات LLMazure_gpt35 - إجراء اختبارات على GPT-3.5 المستضاف على Azureopenai_gpt35 - إجراء اختبارات على GPT-3.5 المستضاف على OpenAIopenai_gpt4 - إجراء الاختبارات على GPT-4 المستضاف على OpenAIgcp_textbison - إجراء الاختبارات على text-bison المستضاف على GCP المعلمة الثانية لـ run_tests.sh هي الرسوم البيانية التي يجب اختبارها. الافتراضيات all . الخيارات هي:

all - إجراء اختبارات على جميع الرسوم البيانية المتاحةOGB_MAG - مجموعة البيانات الورقية الأكاديمية المقدمة من: https://ogb.stanford.edu/docs/nodeprop/#ogbn-mag.DigtialInfra - مجموعة بيانات رقمية مزدوجة للبنية التحتية الرقميةSynthea - مجموعة بيانات الصحة الاصطناعية إذا كنت ترغب في تسجيل نتائج الاختبار إلى الأوزان والتحيزات (ولديك إعداد بيانات الاعتماد الصحيحة أعلاه)، فإن المعلمة النهائية لـ run_tests.sh تكون افتراضيًا بشكل افتراضي على true. إذا كنت ترغب في تعطيل تسجيل الأوزان والتحيزات، فاستخدم false .

إذا كنت ترغب في المساهمة في برنامج TigerGraph CoPilot، يرجى قراءة الوثائق هنا.