ai-fun هي مكتبة وظيفية تجريبية تعمل بنظام LLM. يتيح لك تحديد غرض الوظيفة والمعلمات ومخطط الإخراج وإنشاء التعليمات البرمجية وتنفيذها لك في الخلفية. فكر في Cursor/GitHub Copilot ولكن كمكتبة قابلة للتوصيل.

npm i ai-fun

مثال كامل:

example.ts

import { z } from 'zod'

import AIFunctionBuilder from 'ai-fun'

import NodeExec from 'ai-fun/src/backends/node'

import { anthropic } from '@ai-sdk/anthropic'

// Provide a LLM model

const llm = anthropic . chat ( 'claude-3-5-sonnet-20240620' )

// Create a new AI Function Builder using Node/exec backend

const backend = new NodeExec ( )

const ai = new AIFunctionBuilder ( llm , backend )

// Define the input parameters and output parameters of the function

const parameters = z . object ( { a : z . number ( ) , b : z . number ( ) } )

const output = z . number ( )

// Generate the function

const f = await ai . function ( 'add values provided' , parameters , output )

// Call the function and log the result

const result = await f ( { a : 1 , b : 2 } )

console . log ( result )الإخراج:

> bun example.ts

3تم العثور على المزيد من الأمثلة ضمن الأمثلة/

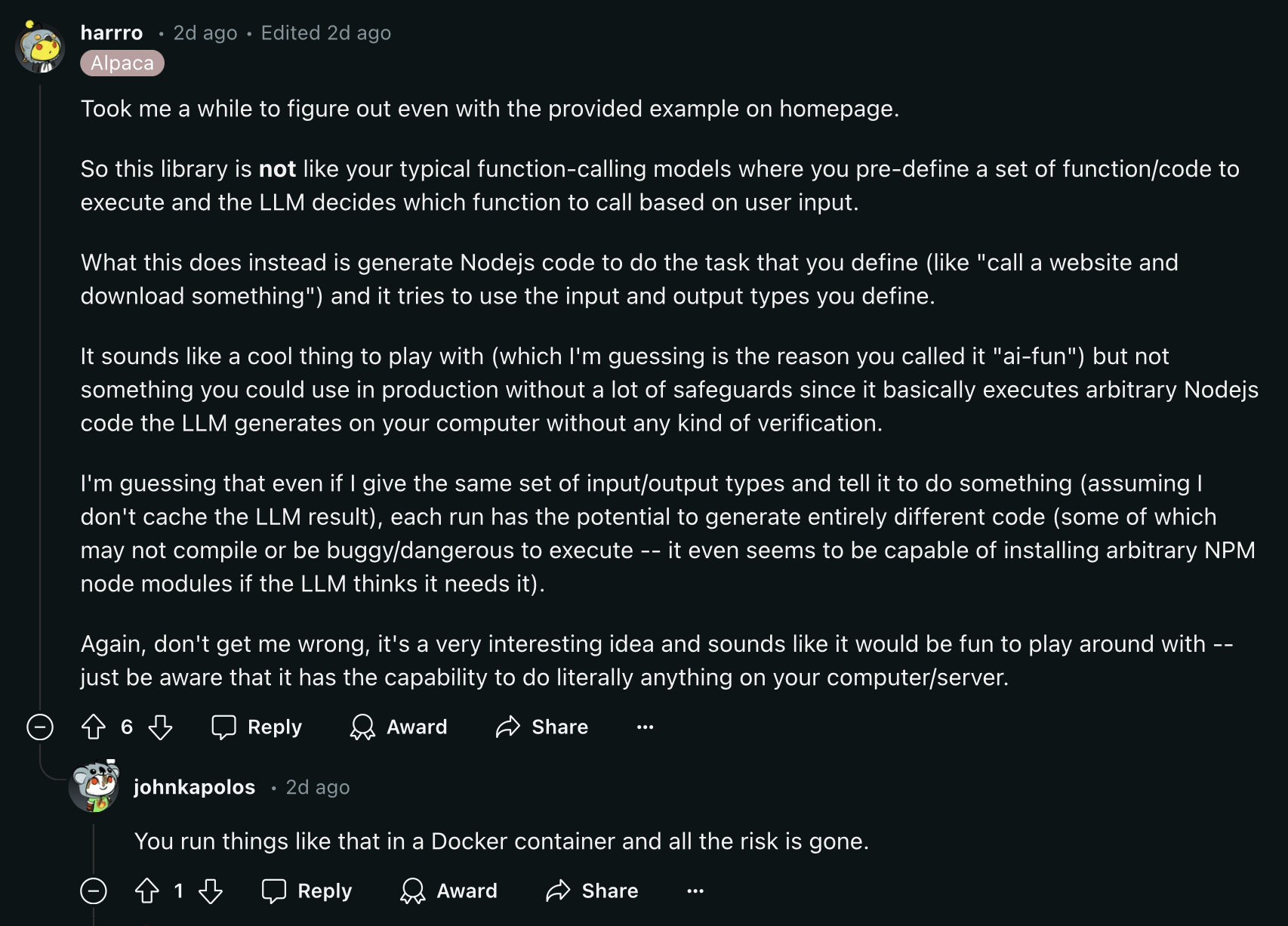

اقرأ تعليق Reddit هذا قبل المتابعة:

يتم تمكين التخزين المؤقت للوظيفة بشكل افتراضي لإجراءات توفير التكلفة. بشكل افتراضي، يتم تخزين الوظائف في ملف يسمى .ai-fun.json .

الخيارات التي يمكنك تقديمها إلى AIFunctionBuilder :

{

debug ?: boolean

esModules?: boolean

cache?: boolean

cacheFile?: string

} يمكنك إنشاء الواجهات الخلفية الخاصة بك عن طريق تطبيق فئة AIFunctionBackend :

export abstract class AIFunctionBackend {

abstract init ( codeContent : CodeContent ) : Promise < void >

abstract exec ( params : any ) : Promise < any >

}راجع src/backends/node على سبيل المثال.

ينفذ الوظائف التي تم إنشاؤها بواسطة الذكاء الاصطناعي باستخدام وظيفة node:vm exec.

خيارات:

{

debug ?: boolean

packageFile?: string

installPackages?: boolean

} كمشروع مفتوح المصدر، نرحب بمساهمات المجتمع. إذا كنت تواجه أي أخطاء أو تريد إضافة بعض التحسينات، فلا تتردد في فتح مشكلة أو سحب الطلب.