؟ أنشئ واجهات برمجة تطبيقات استدلال النموذج وأنظمة تقديم متعددة النماذج باستخدام أي نماذج مفتوحة المصدر أو نماذج ذكاء اصطناعي مخصصة. انضم إلى مجتمع سلاك الخاص بنا!

BentoML هي مكتبة Python لبناء أنظمة تقديم عبر الإنترنت محسنة لتطبيقات الذكاء الاصطناعي واستدلال النماذج.

تثبيت بينتومل:

# Requires Python≥3.9

pip install -U bentoml

تحديد واجهات برمجة التطبيقات في ملف service.py .

from __future__ import annotations

import bentoml

@ bentoml . service (

resources = { "cpu" : "4" }

)

class Summarization :

def __init__ ( self ) -> None :

import torch

from transformers import pipeline

device = "cuda" if torch . cuda . is_available () else "cpu"

self . pipeline = pipeline ( 'summarization' , device = device )

@ bentoml . api ( batchable = True )

def summarize ( self , texts : list [ str ]) -> list [ str ]:

results = self . pipeline ( texts )

return [ item [ 'summary_text' ] for item in results ]قم بتشغيل رمز الخدمة محليًا (يخدم على http://localhost:3000 افتراضيًا):

pip install torch transformers # additional dependencies for local run

bentoml serve service.py:Summarizationيمكنك الآن تشغيل الاستدلال من متصفحك على http://localhost:3000 أو باستخدام برنامج Python النصي:

import bentoml

with bentoml . SyncHTTPClient ( 'http://localhost:3000' ) as client :

summarized_text : str = client . summarize ([ bentoml . __doc__ ])[ 0 ]

print ( f"Result: { summarized_text } " ) لنشر رمز خدمة BentoML الخاص بك، قم أولاً بإنشاء ملف bentofile.yaml لتحديد تبعياته وبيئاته. ابحث عن القائمة الكاملة لخيارات bentofile هنا.

service : ' service:Summarization ' # Entry service import path

include :

- ' *.py ' # Include all .py files in current directory

python :

packages : # Python dependencies to include

- torch

- transformers

docker :

python_version : " 3.11 "ثم اختر إحدى الطرق التالية للنشر:

قم بتشغيل bentoml build لحزم التعليمات البرمجية والنماذج وتكوينات التبعية الضرورية في Bento - الأداة الموحدة القابلة للنشر في BentoML:

bentoml buildتأكد من تشغيل Docker. قم بإنشاء صورة حاوية Docker للنشر:

bentoml containerize summarization:latestقم بتشغيل الصورة التي تم إنشاؤها:

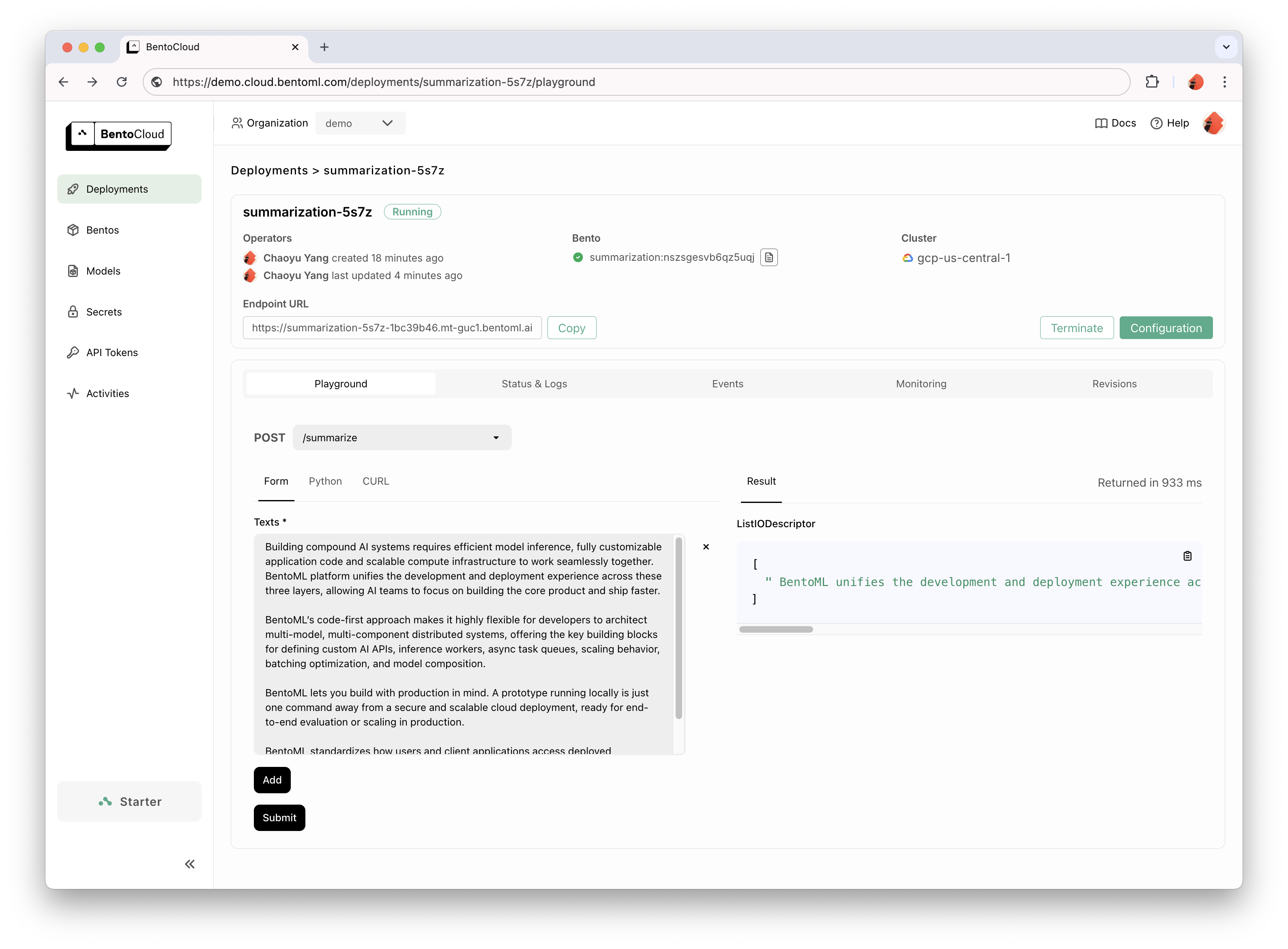

docker run --rm -p 3000:3000 summarization:latestتوفر BentoCloud بنية أساسية للحوسبة لاعتماد GenAI السريع والموثوق. فهو يساعد على تسريع عملية تطوير BentoML لديك من خلال الاستفادة من موارد الحوسبة السحابية، وتبسيط كيفية نشر BentoML وتوسيع نطاقه وتشغيله في الإنتاج.

قم بالتسجيل في BentoCloud للوصول الشخصي؛ بالنسبة لحالات الاستخدام المؤسسي، اتصل بفريقنا.

# After signup, run the following command to create an API token:

bentoml cloud login

# Deploy from current directory:

bentoml deploy .

للحصول على شرح تفصيلي، اقرأ مثال Hello World.

تحقق من القائمة الكاملة لمزيد من نماذج التعليمات البرمجية والاستخدام.

راجع الوثائق لمزيد من البرامج التعليمية والأدلة.

شارك وانضم إلى مجتمعنا Slack، حيث يساعد الآلاف من مهندسي الذكاء الاصطناعي/تعلم الآلة بعضهم البعض، ويساهمون في المشروع، ويتحدثون عن بناء منتجات الذكاء الاصطناعي.

للإبلاغ عن خطأ أو اقتراح طلب ميزة، استخدم مشكلات GitHub.

هناك طرق عديدة للمساهمة في المشروع:

#bentoml-contributors هنا.شكرا لجميع المساهمين المذهلين لدينا!

يقوم إطار عمل BentoML بجمع بيانات الاستخدام المجهولة التي تساعد مجتمعنا على تحسين المنتج. يتم الإبلاغ عن مكالمات واجهة برمجة التطبيقات الداخلية الخاصة بـ BentoML فقط. ويستبعد هذا أي معلومات حساسة، مثل رمز المستخدم أو بيانات النموذج أو أسماء النماذج أو تتبعات المكدس. إليك الرمز المستخدم لتتبع الاستخدام. يمكنك إلغاء الاشتراك في تتبع الاستخدام من خلال خيار --do-not-track CLI:

bentoml [command] --do-not-trackأو عن طريق تحديد متغير البيئة:

export BENTOML_DO_NOT_TRACK=Trueترخيص أباتشي 2.0