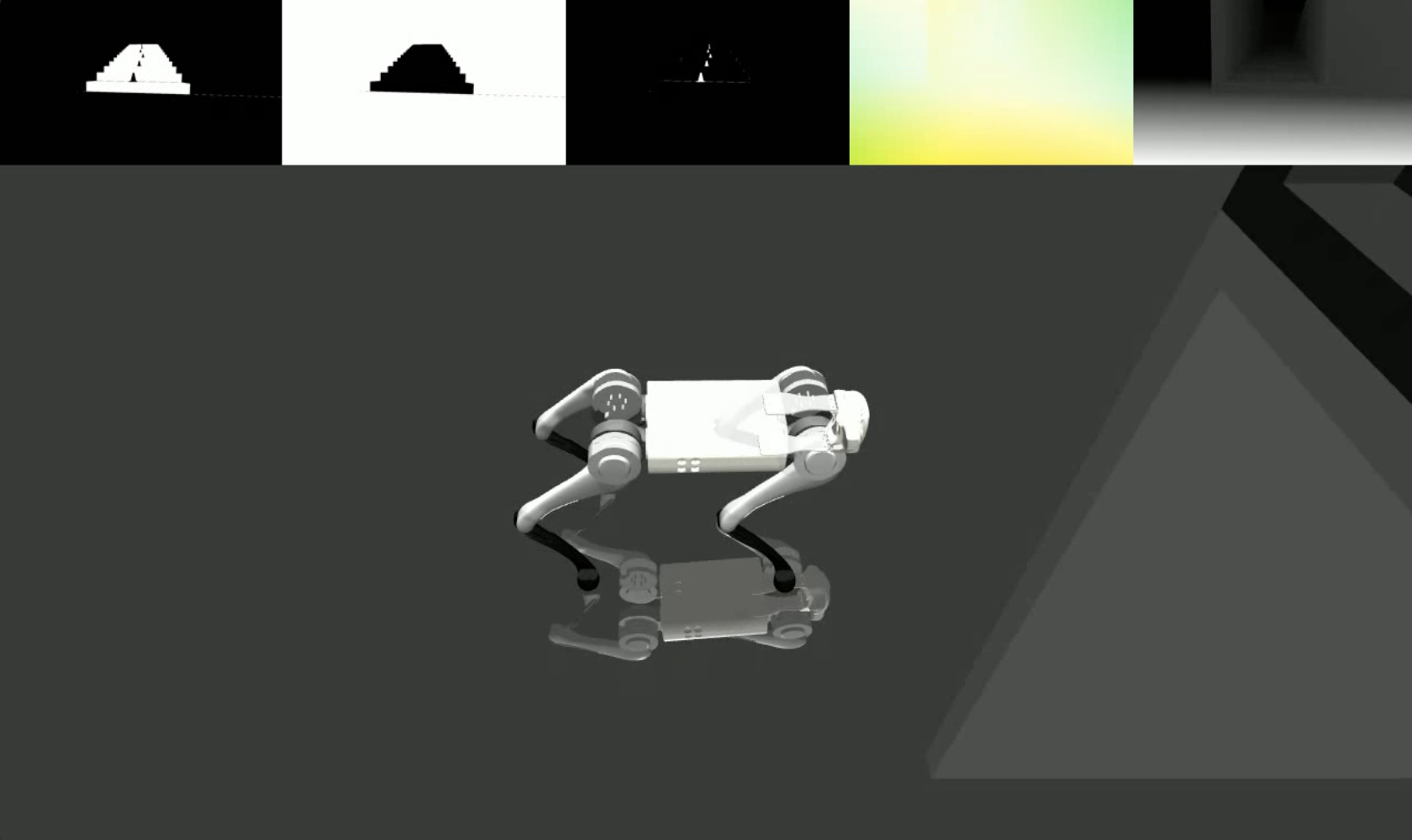

نحن نجلب بيانات مرئية واقعية ومتنوعة من النماذج التوليدية إلى محاكيات الفيزياء الكلاسيكية، مما يمكّن الروبوتات من تعلم مهام ديناميكية للغاية مثل الباركور دون الحاجة إلى العمق.

يحتوي lucidsim على بيئاتنا المحاكاة التي تم إنشاؤها باستخدام MuJoCo. نحن نوفر البيئات والأدوات اللازمة لتشغيل مسار عرض LucidSim لرياضة الباركور الرباعية. لم يتم تضمين رمز التدريب بعد.

إذا كنت تبحث عن كود التعزيز التوليدي (المطلوب لتشغيل مسار العرض الكامل)، فيرجى مراجعة Weaver repo!

آلان يو *1 ، جي يانغ *1،2 ، ران تشوي 1 ، ياجفان رافان 1 ، جون ليونارد 1 ، فيليب إيزولا 1

1 معهد ماساتشوستس للتكنولوجيا CSAIL، 2 معهد الذكاء الاصطناعي والتفاعلات الأساسية (IAIFI)

* يشير إلى مساهمة متساوية

كورل 2024

|  |

جدول المحتويات

إذا اتبعت تعليمات الإعداد من weaver ، فلا تتردد في التثبيت فوق تلك البيئة.

conda create -n lucidsim python=3.10

conda activate lucidsim # Choose the CUDA version that your GPU supports. We will use CUDA 12.1

pip install torch==2.1.2 torchvision==0.16.2 torchaudio==2.1.2 --extra-index-url https://download.pytorch.org/whl/cu121

# Install lucidsim with more dependencies

git clone https://github.com/lucidsim/lucidsim

cd lucidsim

pip install -e . تتطلب التبعيات القليلة الأخيرة أدوات setuptools wheel للتثبيت. للتثبيت، يرجى الرجوع إلى الإصدار السابق والعودة بعد ذلك.

pip install setuptools==65.5.0 wheel==0.38.4 pip==23

pip install gym==0.21.0

pip install gym-dmc==0.2.9

pip install -U setuptools wheel pip ملاحظة: في Linux، تأكد من ضبط متغير البيئة MUJOCO_GL=egl .

تقوم شركة LucidSim بإنشاء صور واقعية باستخدام نموذج توليدي لزيادة عرض المحاكي، وذلك باستخدام الصور المشروطة للحفاظ على التحكم في هندسة المشهد.

لقد قمنا بتوفير نقطة تفتيش سياسة الخبراء ضمن checkpoints/expert.pt . هذه السياسة مستمدة من سياسة Extreme Parkour. يمكنك استخدام هذه السياسة لأخذ عينات من البيئة وتصور الصور المشروطة باستخدام:

# env-name: one of ['parkour', 'hurdle', 'gaps', 'stairs_v1', 'stairs_v2']

python play.py --save-path [--env-name] [--num-steps] [--seed] حيث save_path هو مكان حفظ الفيديو الناتج.

لتشغيل مسار التعزيز التوليدي الكامل، ستحتاج إلى تثبيت حزمة weaver من هنا. عند الانتهاء، يرجى أيضًا التأكد من أن متغيرات البيئة لا تزال مضبوطة بشكل صحيح:

COMFYUI_CONFIG_PATH=/path/to/extra_model_paths.yaml

PYTHONPATH=/path/to/ComfyUI: $PYTHONPATHيمكنك بعد ذلك تشغيل المسار الكامل باستخدام:

python play_three_mask_workflow.py --save-path --prompt-collection [--env-name] [--num-steps] [--seed] حيث يكون save_path و env_name متماثلين كما كانا من قبل. يجب أن يكون prompt_collection مسارًا لملف .jsonl مع موجهات منسقة بشكل صحيح، كما هو الحال في مجلد weaver/examples .

نشكر مؤلفي Extreme Parkour على قاعدة التعليمات البرمجية مفتوحة المصدر الخاصة بهم، والتي استخدمناها كنقطة انطلاق لسياسة الخبراء لدينا ( lucidsim.model ).

إذا وجدت عملنا مفيدًا، فيرجى مراعاة الاستشهاد بما يلي:

@inproceedings{yu2024learning,

title={Learning Visual Parkour from Generated Images},

author={Alan Yu and Ge Yang and Ran Choi and Yajvan Ravan and John Leonard and Phillip Isola},

booktitle={8th Annual Conference on Robot Learning},

year={2024},

}