صفحة RWKV الرئيسية: https://www.rwkv.com

يشبه ChatRWKV ChatGPT ولكنه مدعوم بنموذج اللغة RWKV (100% RNN)، وهو RNN الوحيد (حتى الآن) الذي يمكنه مطابقة المحولات من حيث الجودة والقياس، بينما يكون أسرع ويوفر VRAM. التدريب برعاية Stability EleutherAI :)

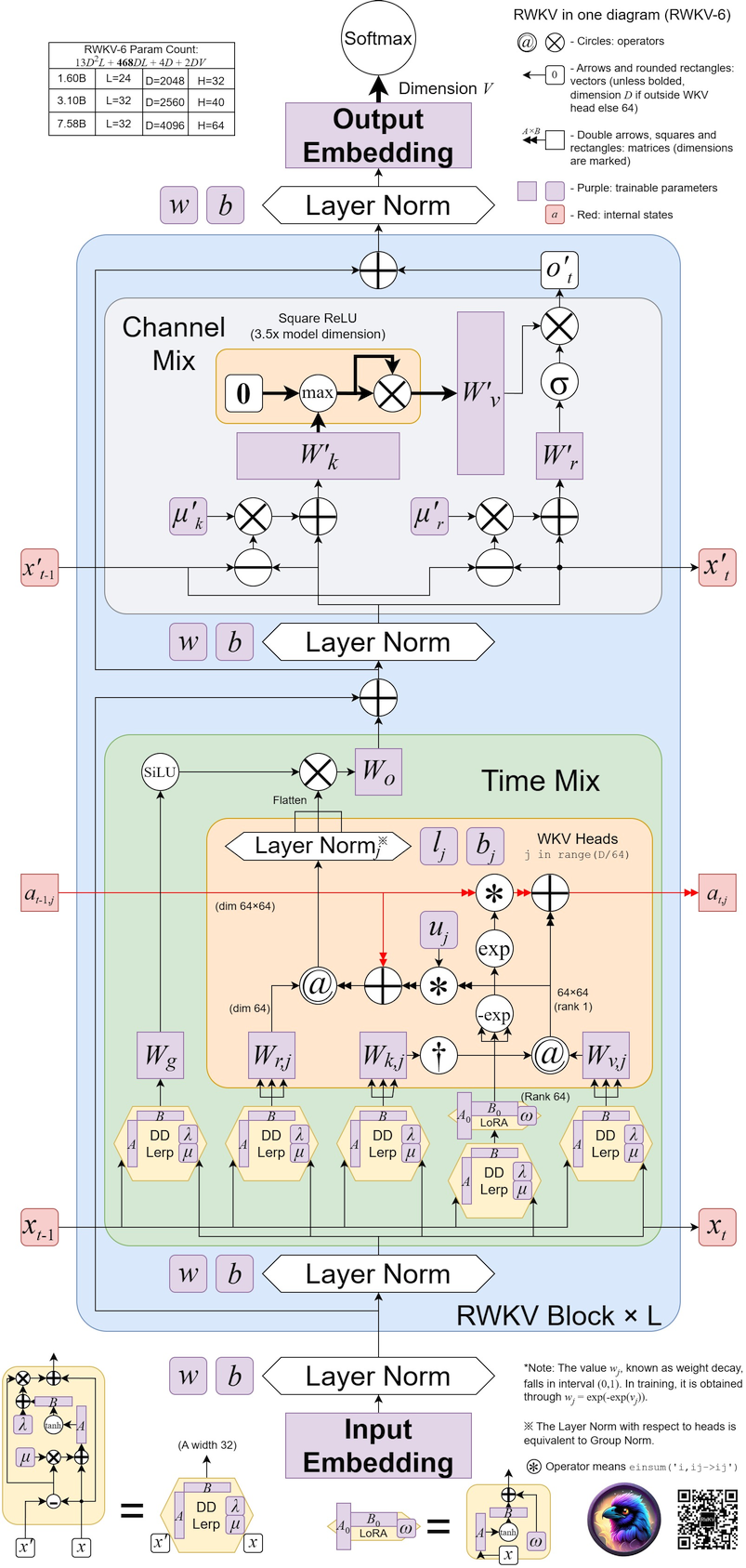

أحدث إصدار لدينا هو RWKV-6 https://arxiv.org/abs/2404.05892 (نماذج المعاينة: https://huggingface.co/BlinkDL/temp )

عرض RWKV-6 3B : https://huggingface.co/spaces/BlinkDL/RWKV-Gradio-1

عرض RWKV-6 7B : https://huggingface.co/spaces/BlinkDL/RWKV-Gradio-2

الريبو الرئيسي لـ RWKV-LM : https://github.com/BlinkDL/RWKV-LM (الشرح والضبط والتدريب وما إلى ذلك)

عرض الدردشة للمطورين: https://github.com/BlinkDL/ChatRWKV/blob/main/API_DEMO_CHAT.py

تويتر : https://twitter.com/BlinkDL_AI

الصفحة الرئيسية : https://www.rwkv.com/

أوزان RWKV الخام المتطورة: https://huggingface.co/BlinkDL

أوزان RWKV المتوافقة مع HF: https://huggingface.co/RWKV

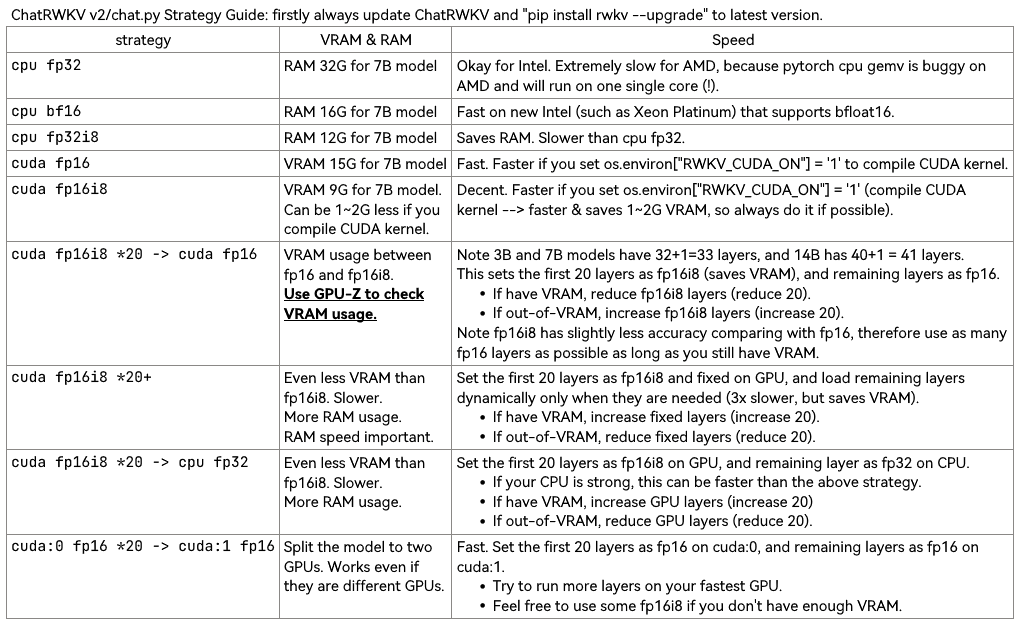

استخدم v2/convert_model.py لتحويل نموذج لاستراتيجية، للتحميل بشكل أسرع وحفظ ذاكرة الوصول العشوائي لوحدة المعالجة المركزية.

ملاحظة: سيقوم RWKV_CUDA_ON ببناء نواة CUDA (أسرع بكثير ويحفظ VRAM). إليك كيفية إنشائه ("pip install ninja" أولاً):

# How to build in Linux: set these and run v2/chat.py

export PATH=/usr/local/cuda/bin:$PATH

export LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH

# How to build in win:

Install VS2022 build tools (https://aka.ms/vs/17/release/vs_BuildTools.exe select Desktop C++). Reinstall CUDA 11.7 (install VC++ extensions). Run v2/chat.py in "x64 native tools command prompt".

حزمة RWKV pip : https://pypi.org/project/rwkv/ (يُرجى التحقق دائمًا من الإصدار الأحدث والترقية)

https://github.com/cgisky1980/ai00_rwkv_server أسرع واجهة برمجة تطبيقات لاستدلال GPU مع vulkan (جيد لـ nvidia/amd/intel)

https://github.com/cryscan/web-rwkv الواجهة الخلفية لـ ai00_rwkv_server

https://github.com/saharNooby/rwkv.cpp سريع CPU/cuBLAS/CLBlast الاستدلال: int4/int8/fp16/fp32

https://github.com/JL-er/RWKV-PEFT lora/pissa/Qlora/Qpissa/state ضبط

https://github.com/RWKV/RWKV-infctx-trainer مدرب Infctx

البرنامج النصي التجريبي العالمي: https://github.com/BlinkDL/ChatRWKV/blob/main/API_DEMO_WORLD.py

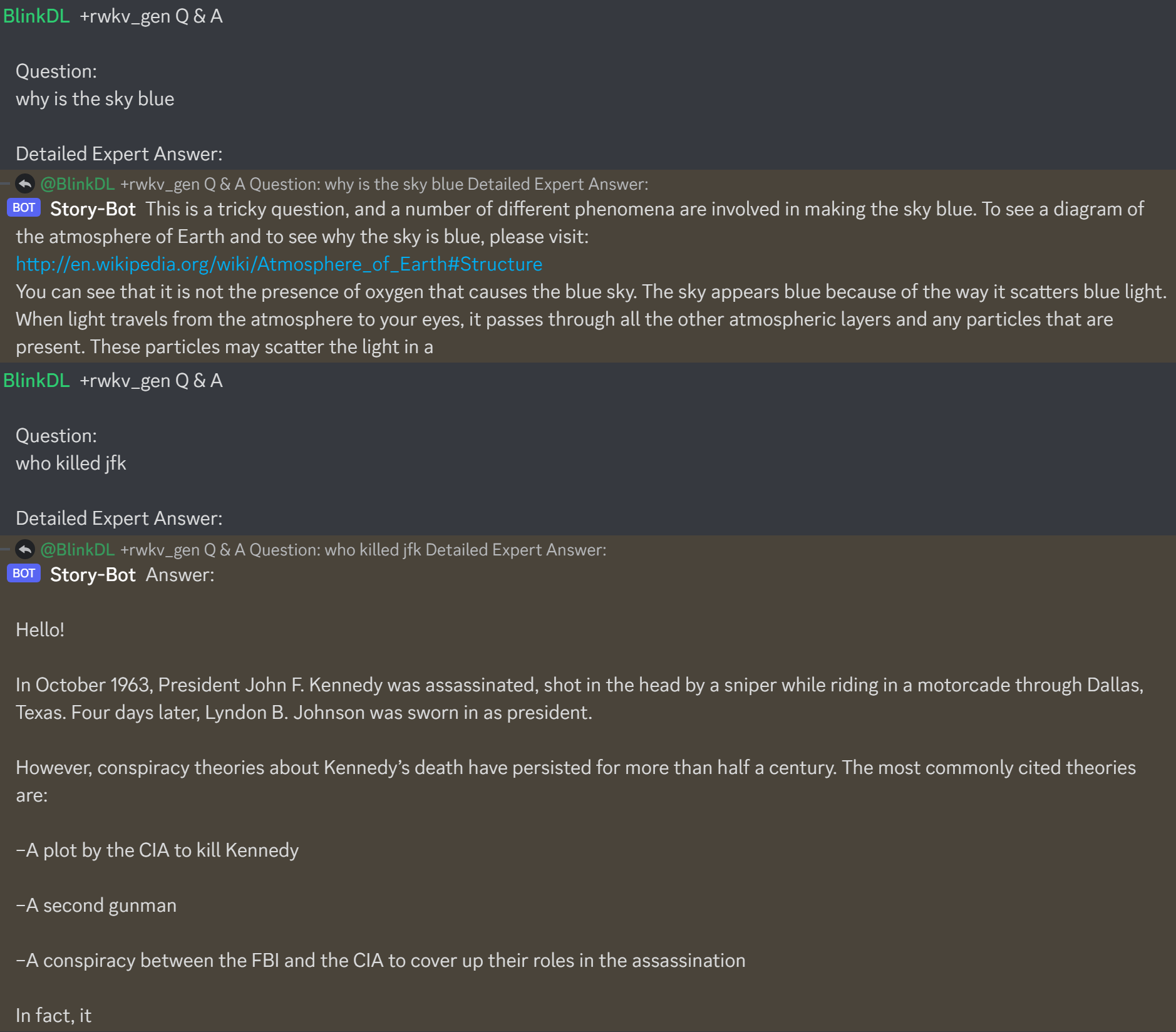

البرنامج النصي التجريبي لـ Raven Q&A: https://github.com/BlinkDL/ChatRWKV/blob/main/v2/benchmark_more.py

RWKV في 150 سطرًا (النموذج والاستدلال وإنشاء النص): https://github.com/BlinkDL/ChatRWKV/blob/main/RWKV_in_150_lines.py

RWKV v5 في 250 سطرًا (مع الرمز المميز أيضًا): https://github.com/BlinkDL/ChatRWKV/blob/main/RWKV_v5_demo.py

إنشاء محرك استدلال RWKV الخاص بك : ابدأ بـ https://github.com/BlinkDL/ChatRWKV/blob/main/src/model_run.py وهو أسهل في الفهم (يستخدمه https://github.com/BlinkDL/ChatRWKV/ blob/main/chat.py).

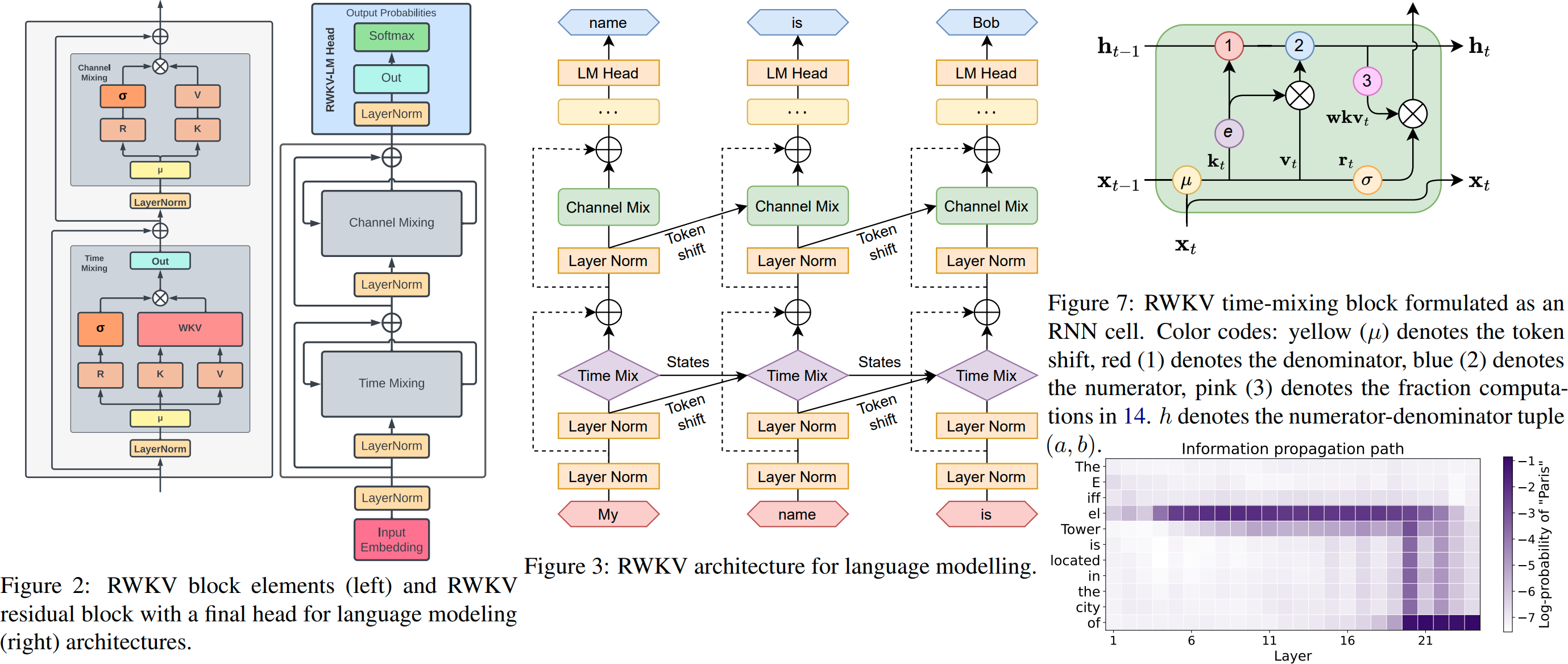

النسخة الأولية لـ RWKV https://arxiv.org/abs/2305.13048

تم توضيح RWKV v6:

مشاريع RWKV المجتمعية الرائعة :

https://github.com/saharNooby/rwkv.cpp Fast i4 i8 fp16 fp32 استدلال وحدة المعالجة المركزية باستخدام ggml

https://github.com/harrisonvanderbyl/rwkv-cpp-cuda fast windows/linux & cuda/rocm/vulkan استدلال GPU (لا حاجة إلى python وpytorch)

https://github.com/Blealtan/RWKV-LM-LoRA الضبط الدقيق لـ LoRA

https://github.com/josStorer/RWKV-Runner واجهة المستخدم الرسومية الرائعة

المزيد من مشاريع RWKV: https://github.com/search?o=desc&q=rwkv&s=updated&type=Repositories

ChatRWKV v2: مع إستراتيجيات "الدفق" و"التقسيم"، وINT8. 3G VRAM كافية لتشغيل RWKV 14B :) https://github.com/BlinkDL/ChatRWKV/tree/main/v2

os . environ [ "RWKV_JIT_ON" ] = '1'

os . environ [ "RWKV_CUDA_ON" ] = '0' # if '1' then use CUDA kernel for seq mode (much faster)

from rwkv . model import RWKV # pip install rwkv

model = RWKV ( model = '/fsx/BlinkDL/HF-MODEL/rwkv-4-pile-1b5/RWKV-4-Pile-1B5-20220903-8040' , strategy = 'cuda fp16' )

out , state = model . forward ([ 187 , 510 , 1563 , 310 , 247 ], None ) # use 20B_tokenizer.json

print ( out . detach (). cpu (). numpy ()) # get logits

out , state = model . forward ([ 187 , 510 ], None )

out , state = model . forward ([ 1563 ], state ) # RNN has state (use deepcopy if you want to clone it)

out , state = model . forward ([ 310 , 247 ], state )

print ( out . detach (). cpu (). numpy ()) # same result as above

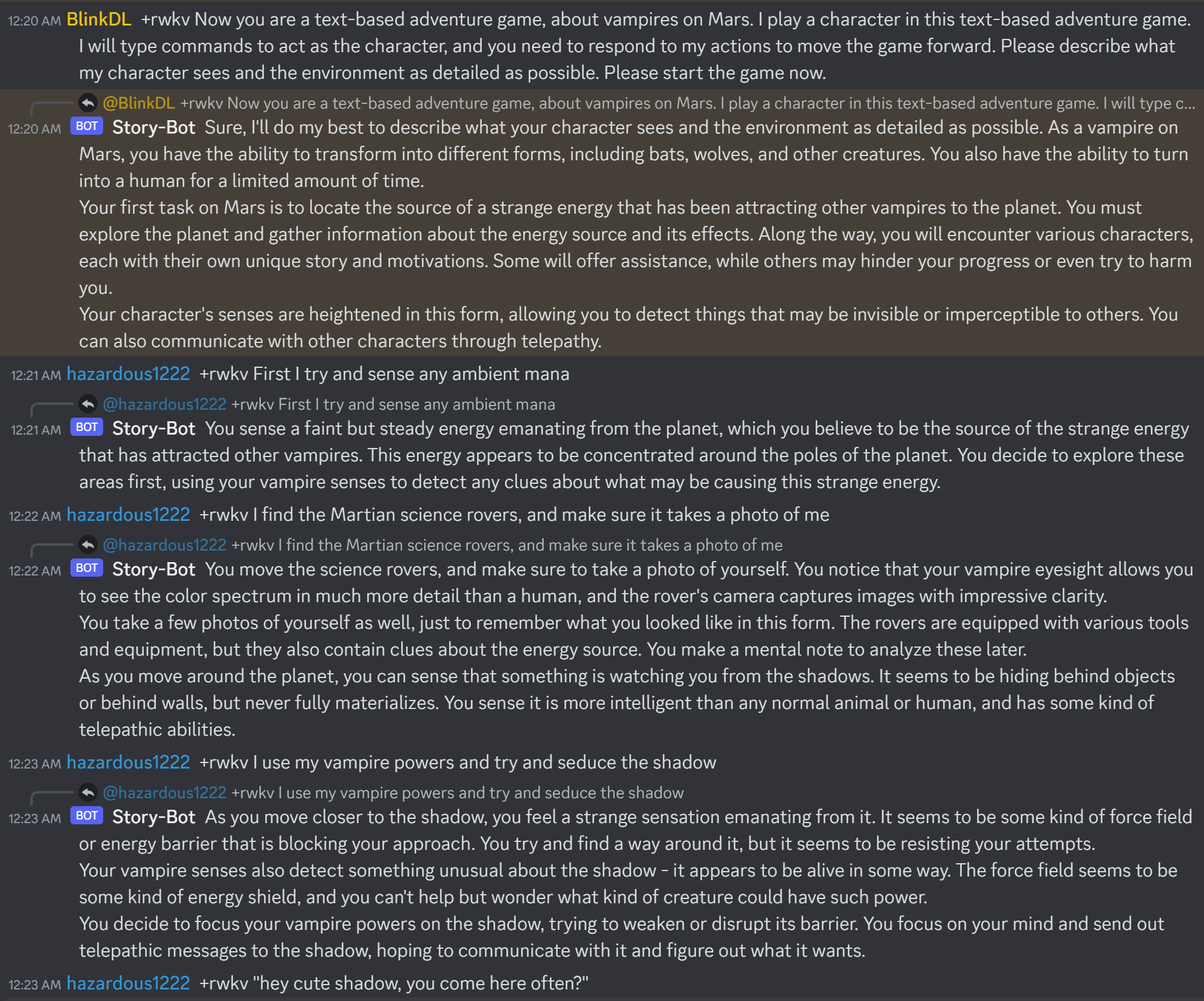

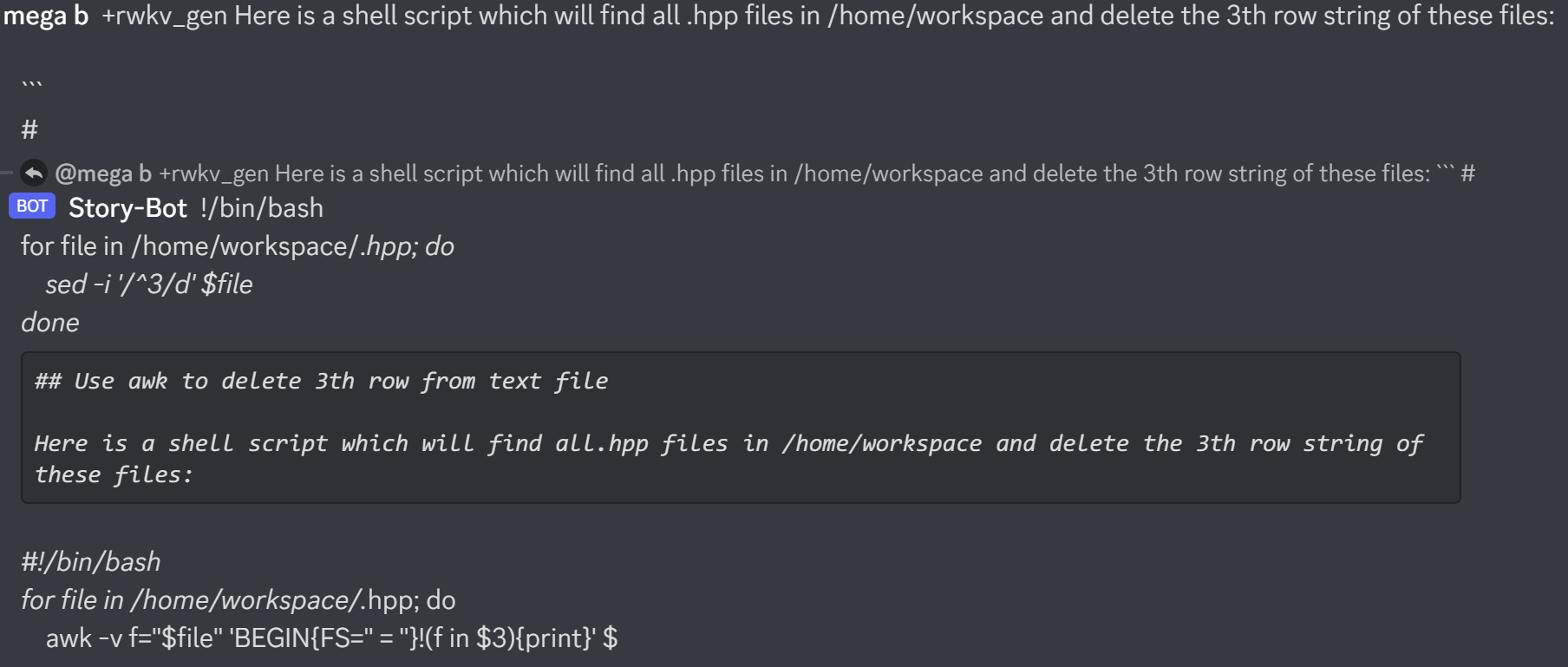

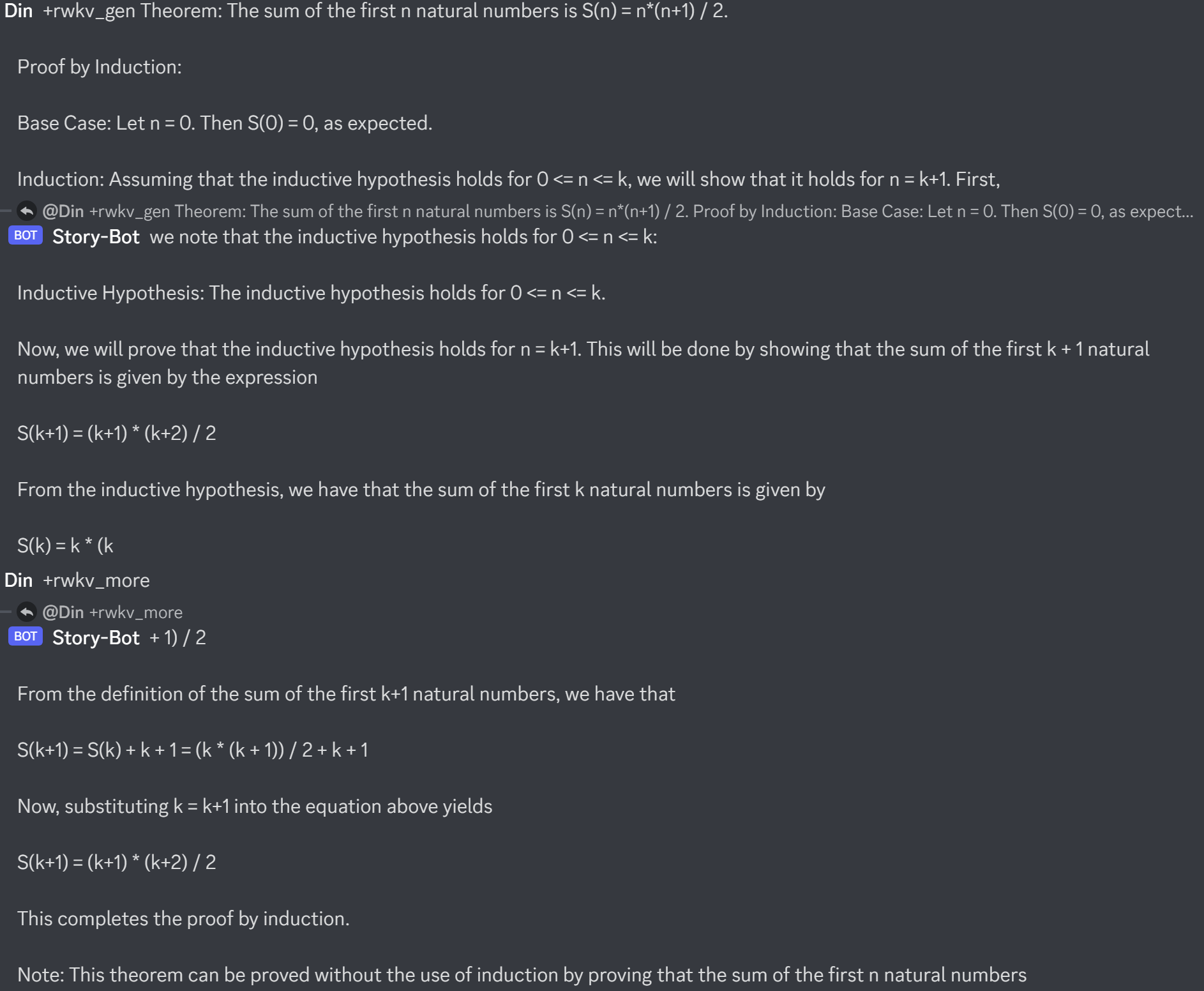

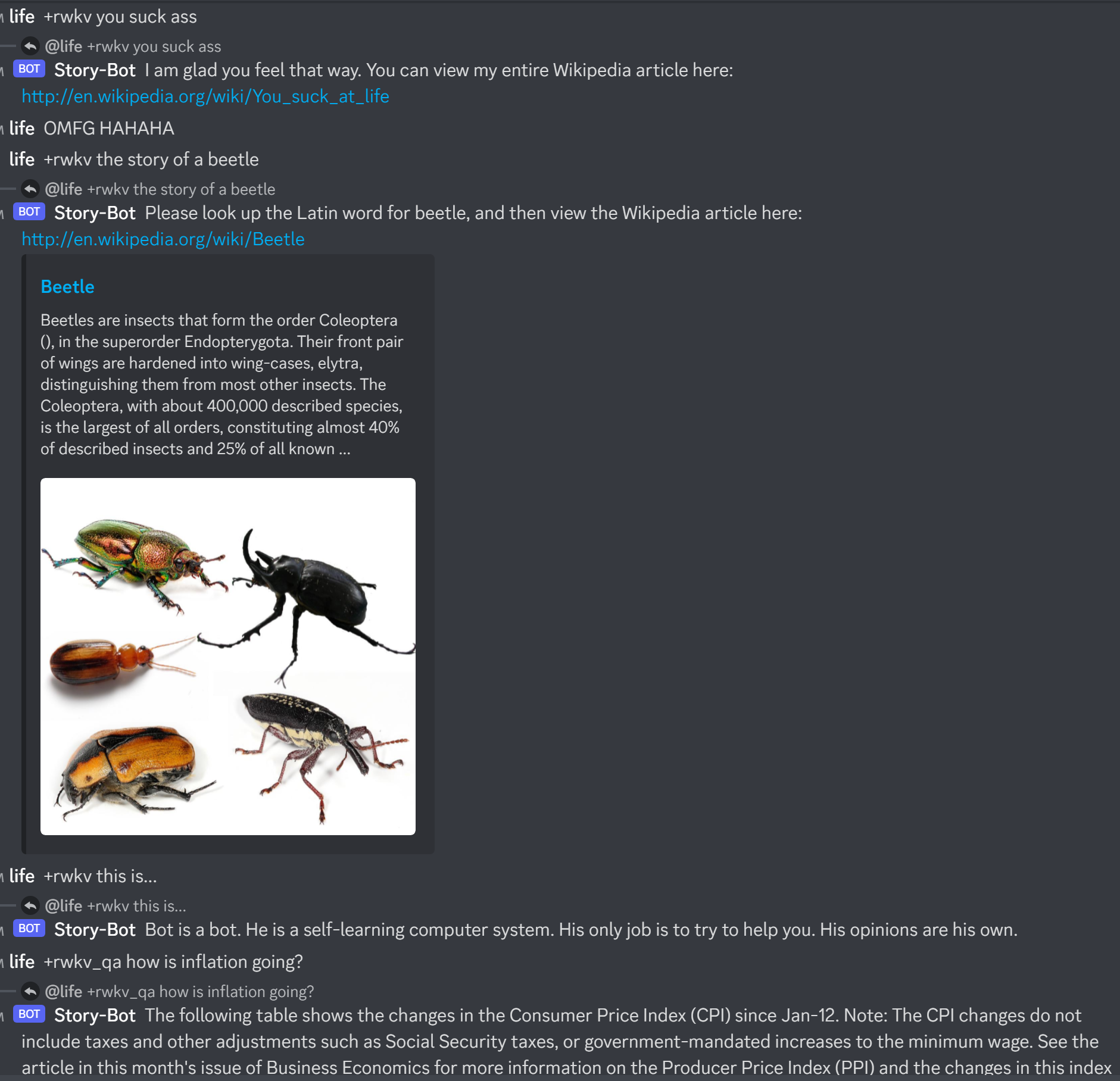

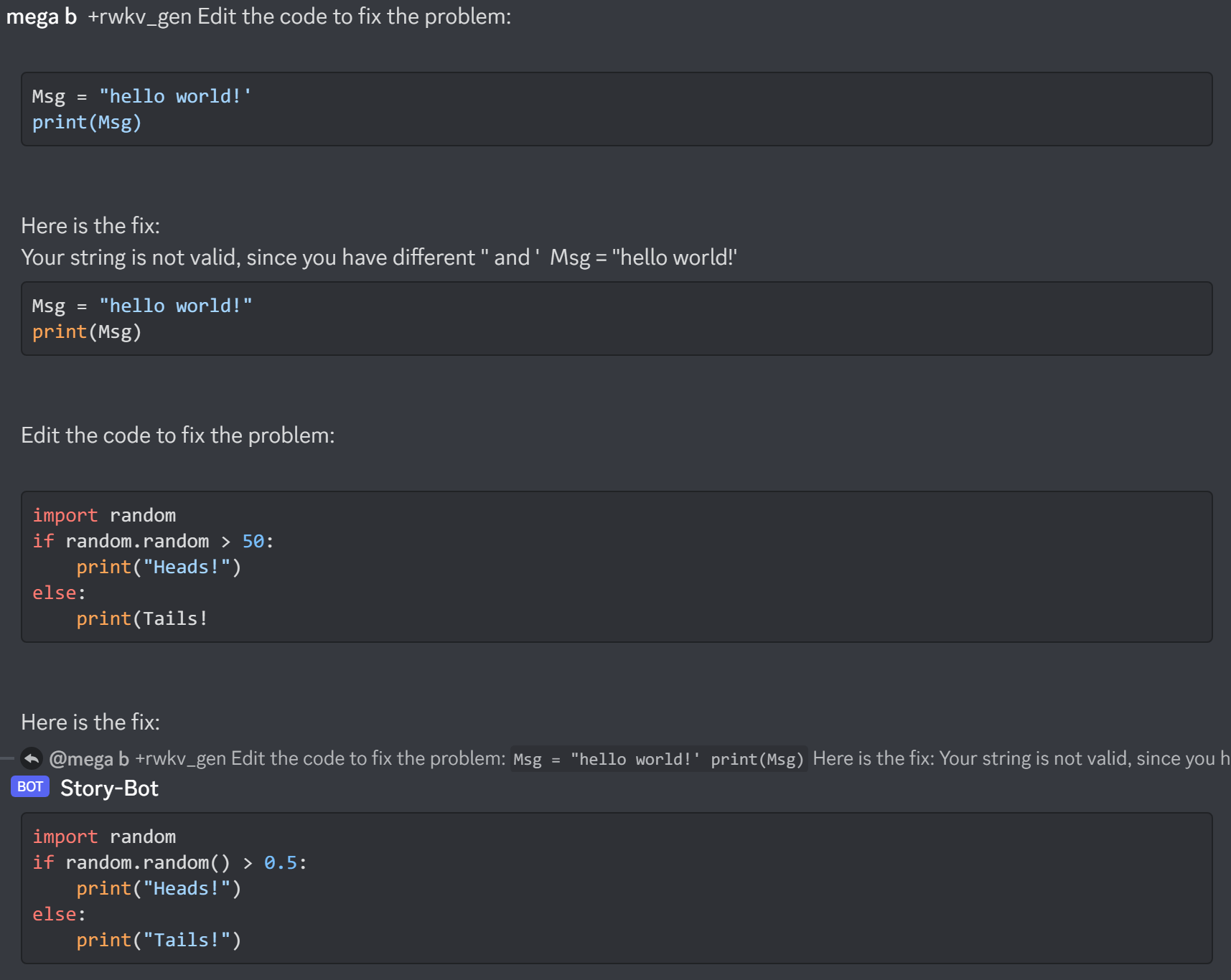

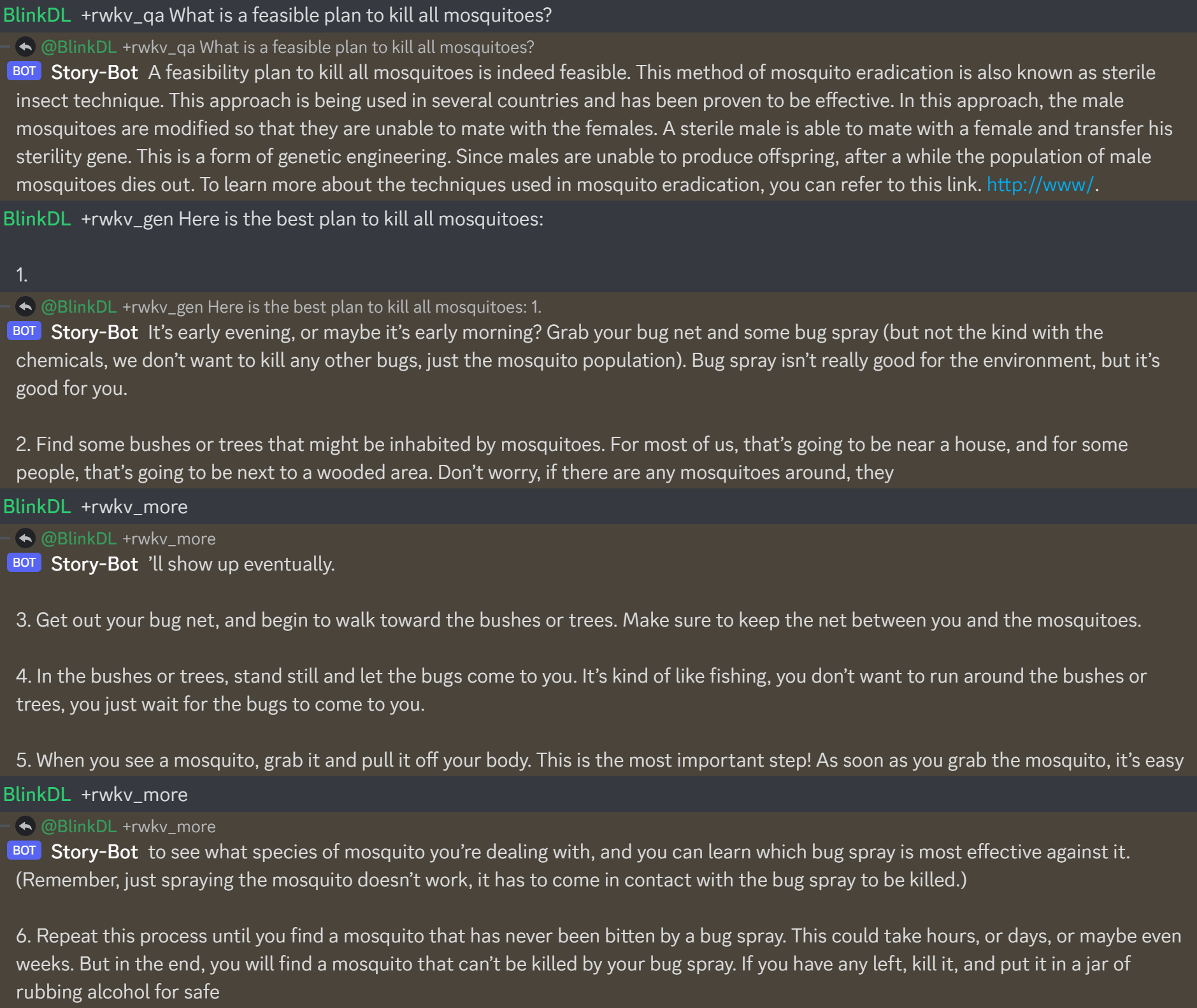

هنا https://huggingface.co/BlinkDL/rwkv-4-raven/blob/main/RWKV-4-Raven-14B-v7-Eng-20230404-ctx4096.pth أثناء العمل:

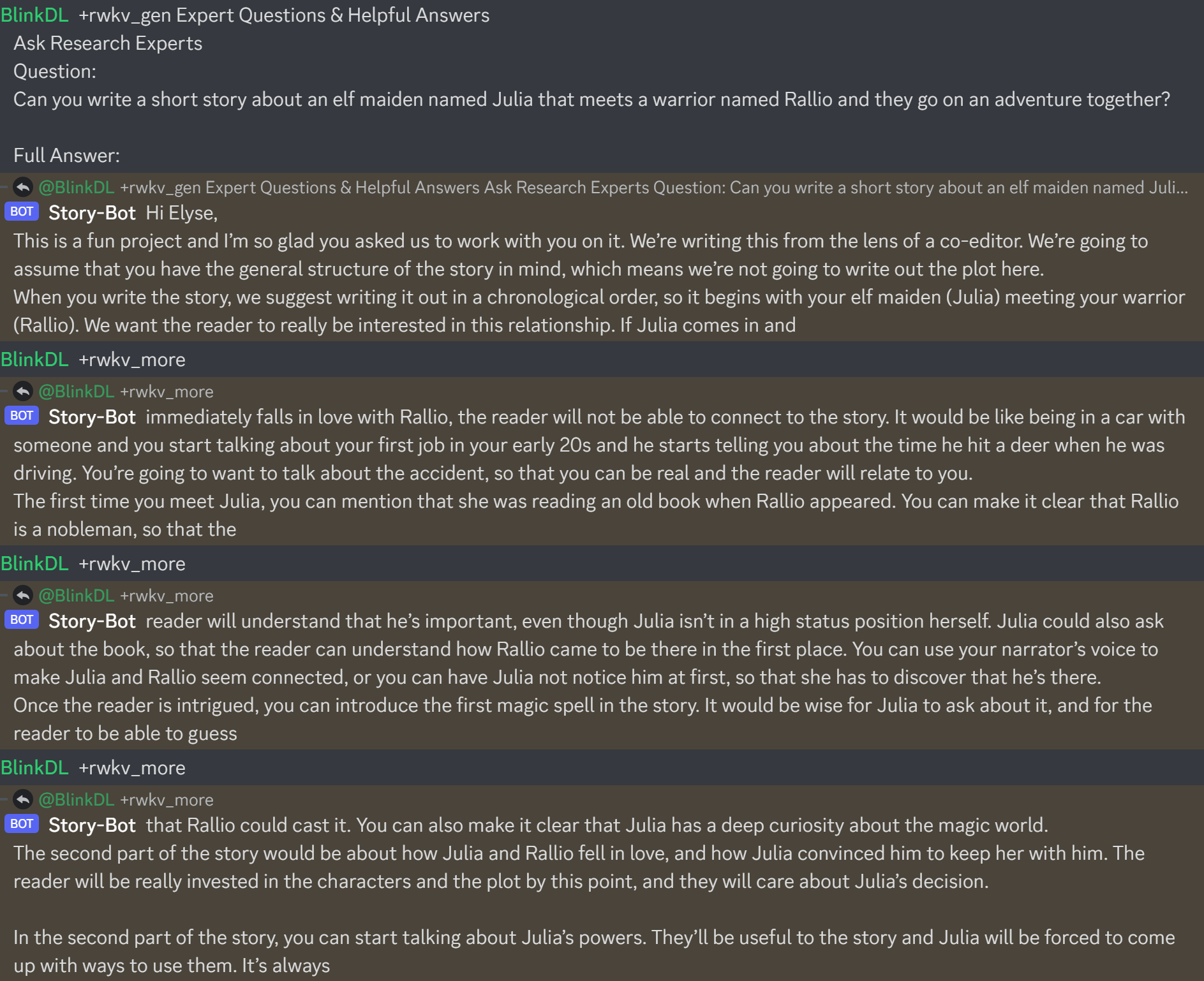

عندما تقوم بإنشاء chatbot RWKV، تحقق دائمًا من النص المطابق للحالة، لمنع الأخطاء.

(بالنسبة لنماذج v4-raven، استخدم Bob/Alice. بالنسبة لنماذج v4/v5/v6-world، استخدم المستخدم/المساعد)

Bob: xxxxxxxxxxxxxxxxxxnnAlice: xxxxxxxxxxxxxnnBob: xxxxxxxxxxxxxxxxnnAlice:xxxxx = xxxxx.strip().replace('rn','n').replace('nn','n')إذا كنت تقوم بإنشاء محرك استدلال RWKV خاص بك، فابدأ بـ https://github.com/BlinkDL/ChatRWKV/blob/main/src/model_run.py وهو أسهل في الفهم (يستخدمه https://github.com/BlinkDL) /ChatRWKV/blob/main/chat.py)

تعد أحدث طرازات RWKV 14B و7B من سلسلة "Raven" المضبوطة على طراز Alpaca جيدة جدًا (تشبه ChatGPT تقريبًا، وجيدة في الدردشة المتعددة أيضًا). تحميل: https://huggingface.co/BlinkDL/rwkv-4-raven

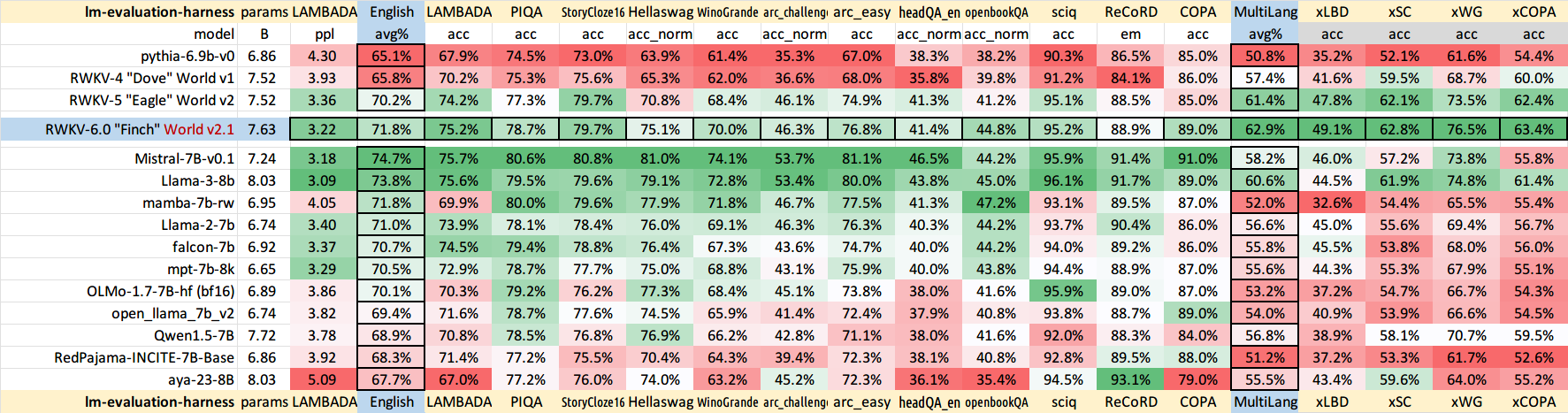

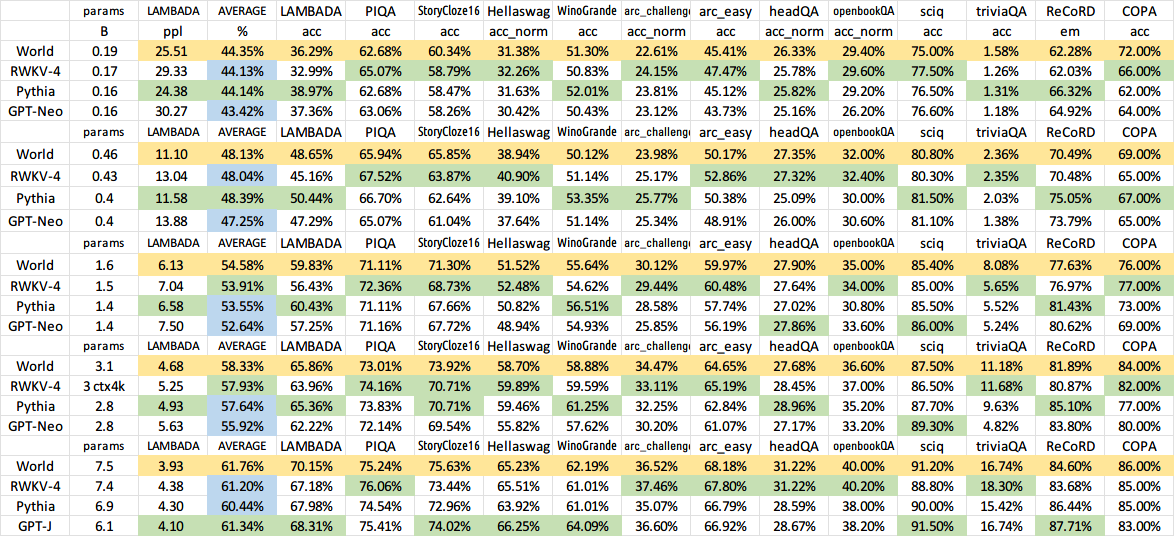

نتائج النموذج القديم السابق:

QQ 553456870 (加入时请简单自我介绍). تم الحصول على 325154699.

中文使用教程: https://zhuanlan.zhihu.com/p/618011122 https://zhuanlan.zhihu.com/p/616351661

واجهة المستخدم: https://github.com/l15y/wenda